OpenAI veröffentlichte einen neuen Benchmark SimpleQa, der darauf abzielt, die sachliche Genauigkeit von großsprachigen Modellen zu bewerten, die Antworten generierten. Mit der raschen Entwicklung der KI -Technologie ist die Gewährleistung der Authentizität der Modellausgabe von entscheidender Bedeutung, und das "Illusion" -Phänomen - die Modellgenerierung scheinbar glaubwürdiger, aber tatsächlich falscher Informationen - werden zu einer zunehmend schwerwiegenderen Herausforderung. Die Entstehung von SimpleQA bietet neue Wege und Standards, um dieses Problem zu lösen.

Kürzlich hat OpenAI einen neuen Benchmark namens SimpleQA veröffentlicht, um die sachliche Genauigkeit von Sprachmodellen zu bewerten, die Antworten generierten.

Mit der schnellen Entwicklung von Großsprachenmodellen ist die Gewährleistung der Genauigkeit generierter Inhalte mit vielen Herausforderungen, insbesondere den sogenannten "Illusions" -Phänomenen, bei denen das Modell Informationen generiert, die selbstbewusst klingen, aber tatsächlich falsch oder nicht überprüfbar sind. Diese Situation ist im Kontext von immer mehr Menschen, die sich auf KI verlassen, besonders wichtig geworden, um Informationen zu erhalten.

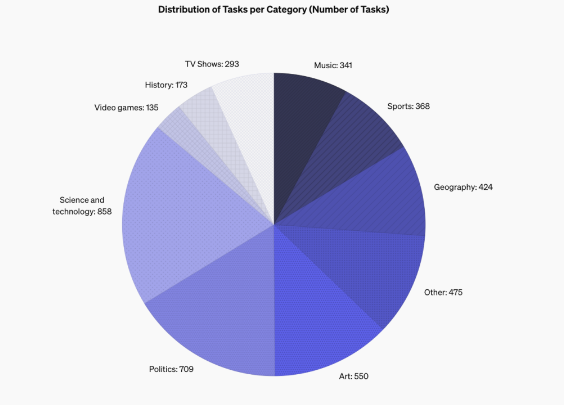

Die Entwurfsfunktionen von SimpleQa sind, dass es sich auf kurze, klare Fragen konzentriert, die häufig eine solide Antwort haben, damit es einfacher ist, zu bewerten, ob die Antwort des Modells korrekt ist. Im Gegensatz zu anderen Benchmarks sind die Probleme von SimpleQa sorgfältig ausgelegt, damit selbst modernste Modelle wie die GPT-4 Herausforderungen gegenüberstehen. Dieser Benchmark enthält 4326 Fragen, die mehrere Bereiche wie Geschichte, Wissenschaft, Technologie, Kunst und Unterhaltung abdecken, wobei der Schwerpunkt auf der Bewertung der Genauigkeit und Kalibrierungsfunktionen des Modells liegt.

Das Design von SimpleQa folgt einigen wichtigen Prinzipien. Erstens hat jede Frage eine Referenzantwort von zwei unabhängigen KI -Trainern, die die Richtigkeit der Antwort sicherstellt.

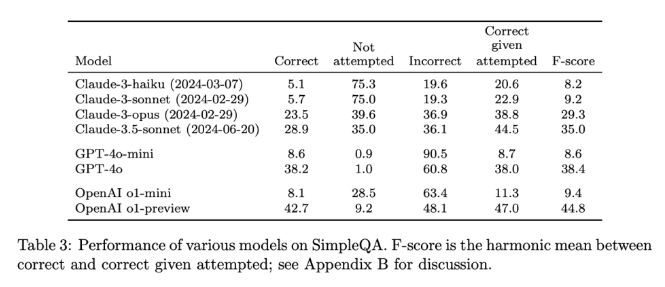

Zweitens vermeidet die Einstellung der Frage Unklarheiten, und jede Frage kann mit einer einfachen und klaren Antwort beantwortet werden, sodass die Bewertungen relativ einfach werden. Darüber hinaus verwendet SimpleQA den Chatgpt -Klassifizierer zur Bewertung und markiert die Antwort explizit als "richtig", "Fehler" oder "nicht versucht".

Ein weiterer Vorteil von SimpleQA besteht darin, dass es verschiedene Themen behandelt, die Überspezialisierung von Modellen verhindert und eine umfassende Bewertung gewährleistet. Dieser Datensatz ist einfach zu bedienen, da die Fragen und Antworten kurz sind, sodass der Test schnell läuft und die Ergebnisse kaum ändern. Darüber hinaus berücksichtigt SimpleQA auch die langfristige Korrelation von Informationen, wodurch die Auswirkungen durch Änderungen der Information vermieden werden, was es zu einer "immergrünen" Benchmark macht.

Die Veröffentlichung von SimpleQA ist ein wichtiger Schritt zur Förderung der Zuverlässigkeit von Informationen zu AI-generierten Informationen. Es bietet nicht nur einen benutzerfreundlichen Benchmark, sondern legt auch einen hohen Standard für Forscher und Entwickler fest und ermutigt sie, Modelle zu erstellen, die nicht nur Sprache erzeugen, sondern auch authentisch und genau sind. Über Open Source bietet SimpleQA der KI -Community ein wertvolles Instrument zur Verbesserung der sachlichen Genauigkeit von Sprachmodellen, um sicherzustellen, dass zukünftige KI -Systeme sowohl informativ als auch vertrauenswürdig sind.

Projekteingang: https://github.com/openai/simple-evals

Details: https://openai.com/index/inTroducing-simpleqa/

Schlüsselpunkte:

SimpleQa ist ein neuer Benchmark, der von OpenAI gestartet wurde und sich auf die Bewertung der sachlichen Genauigkeit von Sprachmodellen konzentriert.

Der Benchmark besteht aus 4326 kurzen und klaren Fragen, die mehrere Bereiche abdecken, um eine umfassende Bewertung zu gewährleisten.

SimpleQA hilft den Forschern dabei, die Fähigkeiten der Sprachmodelle bei der Generierung genauer Inhalte zu identifizieren und zu verbessern.

Zusammenfassend bietet SimpleQA ein zuverlässiges Instrument zur Bewertung der Genauigkeit großer Sprachmodelle, und seine Offenheit und Benutzerfreundlichkeit führt das KI -Feld in Richtung einer authentischeren und vertrauenswürdigeren Richtung. Wir freuen uns auf SimpleQA, um die Geburt von zuverlässigeren und vertrauenswürdigeren KI -Systemen zu fördern.