Die Rakuten Group veröffentlichte ihr erstes japanisches großes Sprachmodell (LLM) Rakuten AI2.0 und das SLM (Small Language Model) Rakuten AI2.0mini, um die Entwicklung künstlicher Intelligenz in Japan zu fördern. Rakuten AI2.0 übernimmt eine Architektur für Hybrid -Experten (MOE) und verfügt über acht Expertenmodelle mit 7 Milliarden Parametern. Rakuten AI2.0mini ist ein kompaktes Modell mit 1,5 Milliarden Parametern, die für die Bereitstellung von Edge-Geräte entwickelt wurden, unter Berücksichtigung der Kosteneffizienz und der Benutzerfreundlichkeit. Beide Modelle sind Open Source und bieten Feinabstimmungs- und Präferenzoptimierungsversionen zur Unterstützung verschiedener Aufgaben zur Textgenerierung.

Die Rakuten Group kündigte die Einführung ihres ersten japanischen Großsprachenmodells (LLM) und des SLM (Small Language Model) mit dem Namen Rakuten AI2.0 und Rakuten AI2.0 Mini an.

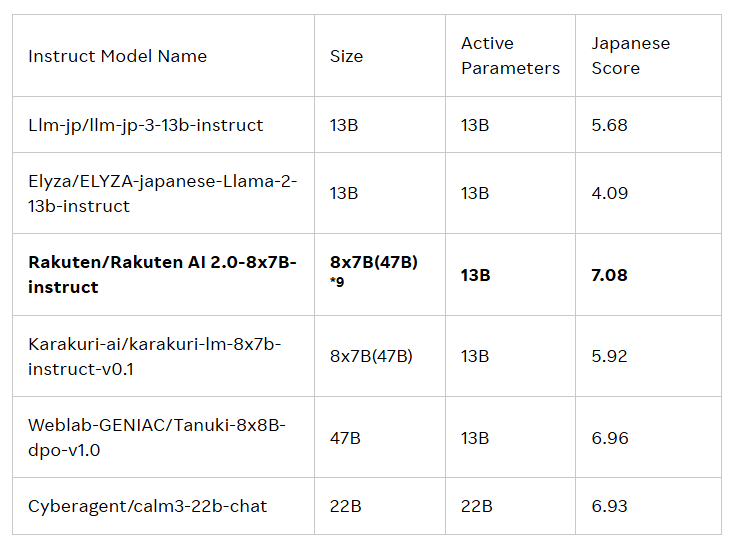

Die Veröffentlichung dieser beiden Modelle soll die Entwicklung der künstlichen Intelligenz (KI) in Japan vorantreiben. Rakuten AI2.0 basiert auf der MOE -Architektur (Hybrid Expert) und ist ein 8x7b -Modell, das aus acht Modellen mit 7 Milliarden Parametern besteht, die jeweils als Experte dienen. Immer wenn der Eingangs -Token verarbeitet wird, sendet das System es an die beiden relevanten Experten, und der Router ist für die Auswahl verantwortlich. Diese Experten und Router trainieren ständig mit einer großen Menge hochwertiger japanischer und englischer zweisprachiger Daten zusammen.

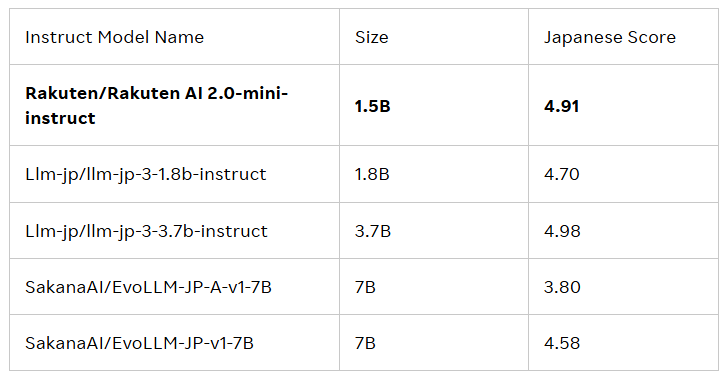

Rakuten AI2.0Mini ist ein neues dichter Modell mit einem Parametervolumen von 1,5 Milliarden, der für die kostengünstige Kantenbereitstellung ausgelegt ist und für bestimmte Anwendungsszenarien geeignet ist. Es wird auch nach gemischten Daten in Japan und Großbritannien geschult, um eine bequeme Lösung zu bieten. Beide Modelle wurden fein abgestimmt und bevorzugt und haben grundlegende Modelle und Anweisungsmodelle veröffentlicht, um Unternehmen und Fachleute bei der Entwicklung von KI-Anwendungen zu unterstützen.

Alle Modelle stehen unter der Lizenzvereinbarung von Apache2.0, die Benutzer in der offiziellen Bibliothek der Umarmung der Rakuten -Gruppe erhalten können. Darüber hinaus können diese Modelle auch als Grundlage für andere Modelle dienen, die die Weiterentwicklung und Anwendung erleichtern.

Cai Ting, Chief AI und Data Officer bei Rakuten Group, sagte: „Ich bin sehr stolz darauf, wie unser Team Daten, Ingenieurwesen und Wissenschaft kombiniert, um Rakuten AI2.0 zu starten. Unternehmen treffen intelligente Entscheidungen, beschleunigen Sie die Wertschöpfung und eröffnen neue Möglichkeiten. . "

Offizieller Blog: https://global.rakuten.com/corp/news/press/2025/0212_02.html

Schlüsselpunkte:

Die Rakuten Group startet ihr erstes japanisches großes Sprachmodell (LLM) und das kleine Sprachmodell (SLM), Rakuten AI2.0 und Rakuten AI2.0 Mini.

Rakuten AI2.0 basiert auf einer hybriden Expertenarchitektur und verfügt über acht Expertenmodelle mit 7 Milliarden Parametern.

Alle Modelle sind in der offiziellen Rakuten -Umarmungs -Face -Bibliothek erhältlich, geeignet für eine Vielzahl von Aufgaben der Textgenerierung und dienen als Grundlage für andere Modelle.

Kurz gesagt, der Start von Rakuten AI2.0 und Rakuten AI2.0mini markieren einen weiteren wichtigen Fortschritt in Japan im Bereich großer Sprache. zu seiner zukünftigen Anwendung und Auswirkungen.