Laut dem offiziellen offiziellen Bericht des Doubao Big Model Teams wurde unter der gemeinsamen Forschung der Peking Jiaotong University und der Universität für Wissenschaft und Technologie Chinas das experimentelle Modell der "Videoworld" -Videogenerierung kürzlich offiziell eröffnet.

Das größte Höhepunkt dieses Modells ist, dass es nicht mehr auf traditionellen Sprachmodellen beruht, sondern die Welt nur auf visuellen Informationen erkennen und verstehen kann. Diese bahnbrechende Forschung wurde von Professor Li Feifeis Konzept inspiriert, dass "kleine Kinder die reale Welt verstehen können, ohne sich auf die Sprache zu verlassen", die in seiner TED -Rede erwähnt wurde.

"Videoworld" realisiert komplexe Inferenz-, Planungs- und Entscheidungsfunktionen, indem große Mengen an Videodaten analysiert und verarbeitet werden. Die Experimente des Forschungsteams zeigten, dass das Modell signifikante Ergebnisse mit nur 300 -m -Parametern erzielte. Im Gegensatz zu vorhandenen Modellen, die auf Sprach- oder Tag -Daten angewiesen sind, kann Videoworld unabhängig voneinander Wissen erlernen, insbesondere in komplexen Aufgaben wie Origami und Fliegen, die eine intuitivere Lernmethode bieten können.

Um die Effektivität dieses Modells zu überprüfen, hat das Forschungsteam zwei experimentelle Umgebungen festgelegt: GO BATT- und ROBOTS -SIMULATION -Kontrolle. Als sehr strategisches Spiel kann Go die Fähigkeit zum Lernen und Argumentationsvermögen des Modells des Modells effektiv bewerten, während Roboteraufgaben die Leistung des Modells in Kontrolle und Planung untersuchen. Während der Trainingsphase legt das Modell allmählich die Fähigkeit fest, zukünftige Bilder vorherzusagen, indem eine große Menge an Videodemendaten angesehen wird.

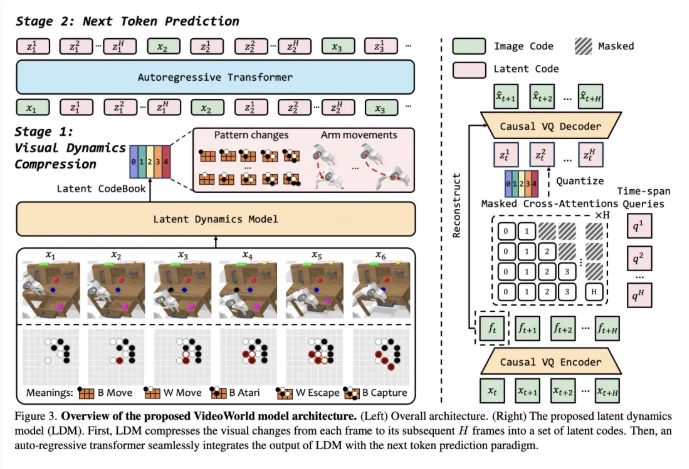

Um die Effizienz des Videolernens zu verbessern, führte das Team ein potenzielles dynamisches Modell (LDM) ein, das visuelle Änderungen zwischen Videorahmen zum Extrahieren kritischer Informationen komprimiert. Diese Methode reduziert nicht nur redundante Informationen, sondern verbessert auch die Lerneffizienz des Modells komplexer Wissen. Durch diese Innovation zeigt Videoworld herausragende Fähigkeiten in Go-Roboter-Aufgaben und erreicht sogar das Niveau des professionellen fünfstufigen GO.

Papierlink: https://arxiv.org/abs/2501.09781

Code -Link: https://github.com/bytedance/videoWorld

Projekt Homepage: https://maverickren.github.io/videoWorld.github.io

Schlüsselpunkte:

Das Modell "VideoOworld" kann das Wissen über das Wissen nur auf visuellen Informationen basierend auf visuellen Informationen realisieren und stützt sich nicht auf Sprachmodelle.

Das Modell zeigt hervorragende Argumentations- und Planungsfunktionen bei Go- und Roboter -Simulationsaufgaben.

Der Projektcode und das Modell wurden offen und Menschen aus allen Lebensbereichen sind herzlich eingeladen, an der Erfahrung und dem Austausch teilzunehmen.