In den letzten Jahren haben Inferenzverstärkungsmodelle mit der raschen Entwicklung großer Sprachmodelle auch umfangreiche Diskussionen über ihre Halluzinationsraten ausgelöst und gleichzeitig die Verarbeitungsfähigkeiten komplexer Aufgaben verbessert. Das maschinelle Lernteam von Vectara hat kürzlich eine eingehende Untersuchung der Modelle der Deepseek-Serie durchgeführt, wodurch signifikante Unterschiede im inferenzverhinderten Modell in Bezug auf die Halluzinationsraten aufgedeckt wurden.

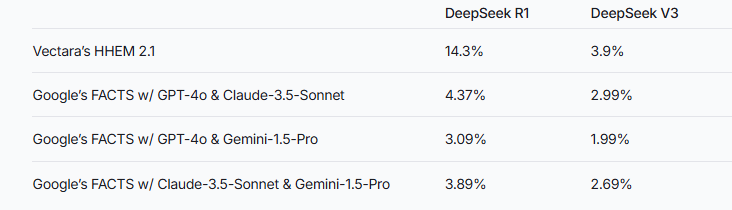

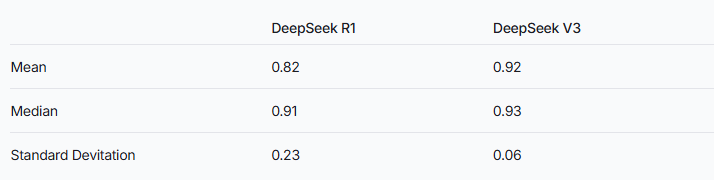

Kürzlich führte das maschinelle Lernteam von Vectara ausführliche Halluzinationstests zu zwei Modellen der Deepseek-Serie durch. V3. Dies deutet darauf hin, dass Deepseek-R1 während des Vergrößerungsprozesses ungenau oder nicht mit den ursprünglichen Informationen übereinstimmt. Dieses Ergebnis löst eine umfassende Diskussion über die Halluzinationsrate des inferenzverstärkten Großsprachenmodells (LLM) aus.

Bildquelle Notizen: Das Bild wird von KI erzeugt, und der im Bild autorisierte Dienstanbieter Midjourney

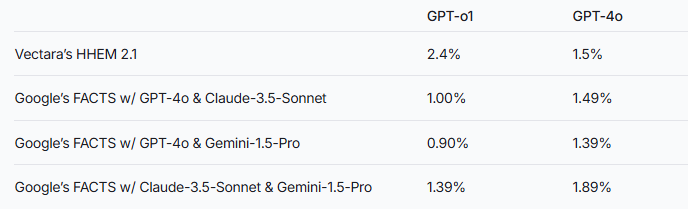

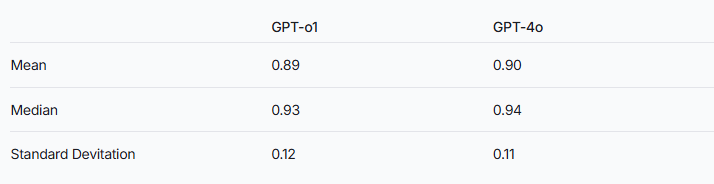

Das Forschungsteam wies darauf hin, dass Inferenzvergrößerungsmodelle möglicherweise anfälliger für Halluzinationen sind als gewöhnliche Großsprachenmodelle. Dieses Phänomen ist besonders im Vergleich der Deepseek -Serie mit anderen Inferenzverstärkungsmodellen erkennbar. Wenn Sie die GPT-Serie als Beispiel nutzen, überprüft der Unterschied in der Halluzinationsrate zwischen der argumentierten GPT-O1 und der normalen Version von GPT-4O diese Spekulation ebenfalls.

Um die Leistung dieser beiden Modelle zu bewerten, verwendeten die Forscher das HHEM -Modell von Vectara und die Facts -Methode von Google, um Urteile zu fällen. Als spezialisiertes Halluzinationserkennungsinstrument weist Hhem eine höhere Empfindlichkeit auf, wenn die Halluzinationsrate von Deepseek-R1 erfasst wird, während das Faktenmodell in dieser Hinsicht relativ schlecht abschneidet. Dies erinnert uns daran, dass HHEM als Standard effektiver als LLM sein kann.

Es ist erwähnenswert, dass Deepseek-R1 trotz seiner hervorragenden Leistung in der Argumentation von einer höheren Halluzinationsrate begleitet wird. Dies kann mit der komplexen Logik zusammenhängen, die für die Verarbeitung von Inferenzverstärkungsmodellen erforderlich ist. Mit zunehmender Komplexität des Modells steigt stattdessen die Genauigkeit des generierten Inhalts. Das Forschungsteam betonte auch, dass es möglich sein kann, ein gutes Gleichgewicht zwischen Argumentationsfähigkeit und Genauigkeit zu erreichen, wenn Deepseek sich mehr auf die Reduzierung der Halluzinationen während der Trainingsphase konzentrieren kann.

Während inferenzverstärkte Modelle im Allgemeinen höhere Halluzinationen aufweisen, bedeutet dies nicht, dass sie in anderer Hinsicht keinen Vorteil haben. Für die Deepseek -Serie ist es immer noch notwendig, Halluzinationen in späteren Forschungen und Optimierung zu lösen, um die Gesamtmodellleistung zu verbessern.

Referenz: https://www.vectara.com/blog/deepseek-r1-halcinates-more-than-peepseek-v3

Mit der kontinuierlichen Entwicklung großer Sprachmodelle wird die Verringerung der Halluzinationsraten und die Verbesserung der Argumentationsfähigkeiten zu einer wichtigen Richtung für die zukünftige Forschung. Die Testergebnisse der Deepseek -Serie bieten uns wertvolle Verweise, um die Branche zu fördern, um die Modellleistung weiter zu optimieren.