Mit der raschen Entwicklung der Technologie für künstliche Intelligenz werden Sprachmodelle in mehreren Bereichen immer größer verwendet. Eine neue OpenAI -Studie ergab jedoch, dass es diesen Modellen bei der Beantwortung von sachlichen Fragen weit über den Erwartungen zurückzuführen war, was das Überdenken der Fähigkeit von AI, Wissen zu erwerben, auslöste.

Eine aktuelle Studie von OpenAI zeigt, dass trotz der raschen Entwicklung der Technologie für künstliche Intelligenz die derzeit fortschrittlichsten Sprachmodelle bei der Beantwortung von sachlichen Fragen weitaus geringere Erfolgsquoten haben.

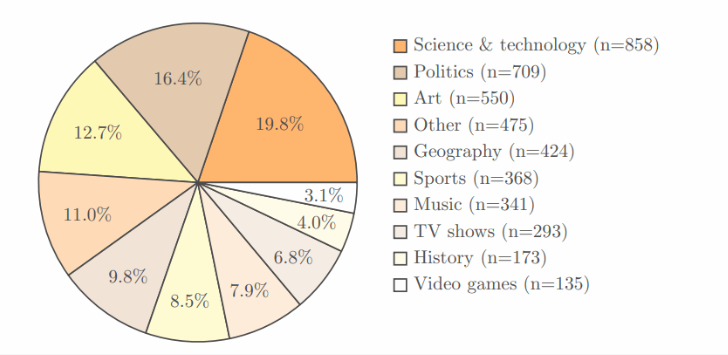

In der Studie wurde OpenAIs eigenes SimpleQA -Benchmark -Test durchgeführt, der 4.326 Bereiche enthält, die mehrere Bereiche wie Wissenschaft, Politik und Kunst abdecken, und jede Frage hat eine klare und korrekte Antwort.

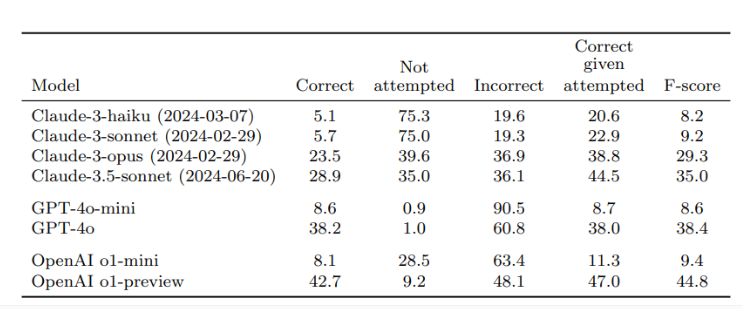

Nach der Überprüfung durch zwei unabhängige Gutachter zeigten die Ergebnisse, dass die Genauigkeitsrate von O1-Präview, das beste Modell von OpenAI, nur 42,7%betrug, während GPT-4O etwas niedriger war, nur 38,2%. Bei den kleineren GPT-4O-Mini beträgt die Genauigkeitsrate nur 8,6%. Im Gegensatz dazu wurde das Claude-Modell von Anthropic schlechter, wobei die Genauigkeitsrate des Claude-3,5-SONNet nur 28,9%betrug.

Der Schlüssel zu dieser Studie ist das Design des Tests, nicht nur, um die Leistung von KI zu testen, sondern auch, dass alle die Grenzen von KI -Modellen in Bezug auf den Wissenserwerb erkennen. Die Forscher betonen, dass Benutzer bei der Verwendung dieser Modelle sie als Informationsverarbeitungswerkzeuge betrachten sollten, anstatt sich vollständig auf Wissensquellen zu verlassen. Um genauere Antworten zu erhalten, ist es am besten, zuverlässige Daten für KI bereitzustellen, anstatt sich ausschließlich auf das integrierte Wissen zu verlassen.

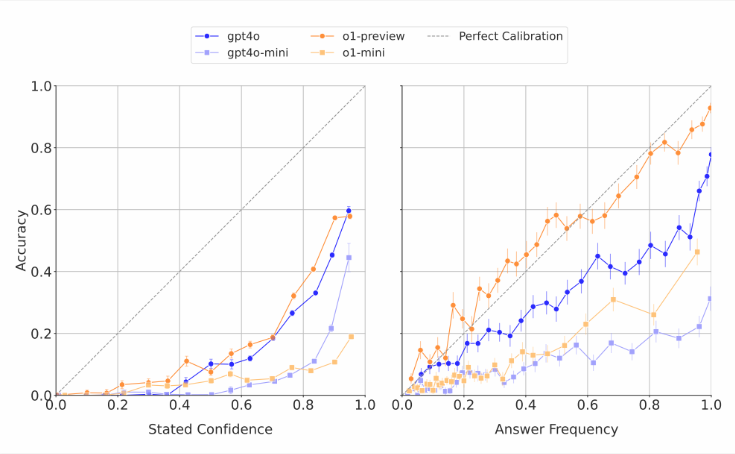

Es ist erwähnenswert, dass KI -Modelle ihre eigenen Fähigkeiten häufig schätzen. Die Forscher fanden heraus, dass diese Modelle, als sie gebeten wurden, Vertrauen in ihre Antworten zu erzielen, normalerweise einen übertriebenen Genauigkeitswert gaben. In Tests, die wiederholt dieselbe Frage beantworten, ist ihre tatsächliche Erfolgsrate immer noch niedriger als die Genauigkeit ihrer Selbstbewertung. Dies steht im Einklang mit der Kritik der Außenwelt, die oft absurde Antworten auf Sprachmodelle hervorbringt, aber zuversichtlich ist.

Die Forscher glauben, dass die sachliche Genauigkeit der aktuellen KI -Systeme eine klare Kluft gibt und dringend verbessert werden muss. Gleichzeitig stellten sie auch eine offene Frage: Ob die Leistung von AI bei der Beantwortung von kurzen sachlichen Fragen vorhersagen kann, wie sie sich beim Umgang mit längeren und komplexeren Antworten entwickelt. Um die Entwicklung von zuverlässigeren Sprachmodellen zu unterstützen, hat OpenAI Daten zu SimpleQA -Benchmarks öffentlich auf GitHub veröffentlicht.

Schlüsselpunkte:

OpenAI -Forschung zeigt, dass die fortschrittlichsten Sprachmodelle bei der Beantwortung von sachlichen Fragen mit einer maximalen Erfolgsquote von nur 42,7%niedrige Erfolgsquoten haben.

Diese KI -Modelle überschätzen ihre Fähigkeiten oft und ihre Vertrauenswerte sind im Allgemeinen übertrieben.

OpenAI hat SimpleQa -Benchmark öffentlich gemacht, um zuverlässigere Sprachmodelle zu erforschen.

Diese Studie erinnert uns daran, dass trotz erheblicher Fortschritte in der KI -Technologie ihre Einschränkungen in praktischen Anwendungen mit Vorsicht behandelt werden müssen und weiterhin technologische Verbesserungen fördern müssen.