· Papel · Benchmark · Página de inicio · Documento ·

✅ [25/07/2024] Visual PEFT Benchmark comienza a publicar conjuntos de datos, códigos, etc.

✅ [20/06/2024] Se crea la página de inicio de Visual PEFT Benchmark.

✅ [01/06/2024] Se crea el repositorio Visual PEFT Benchmark.

Introducción

Empezando

Estructura del código

Inicio rápido

Resultados y puntos de control

Comunidad y Contacto

Citación

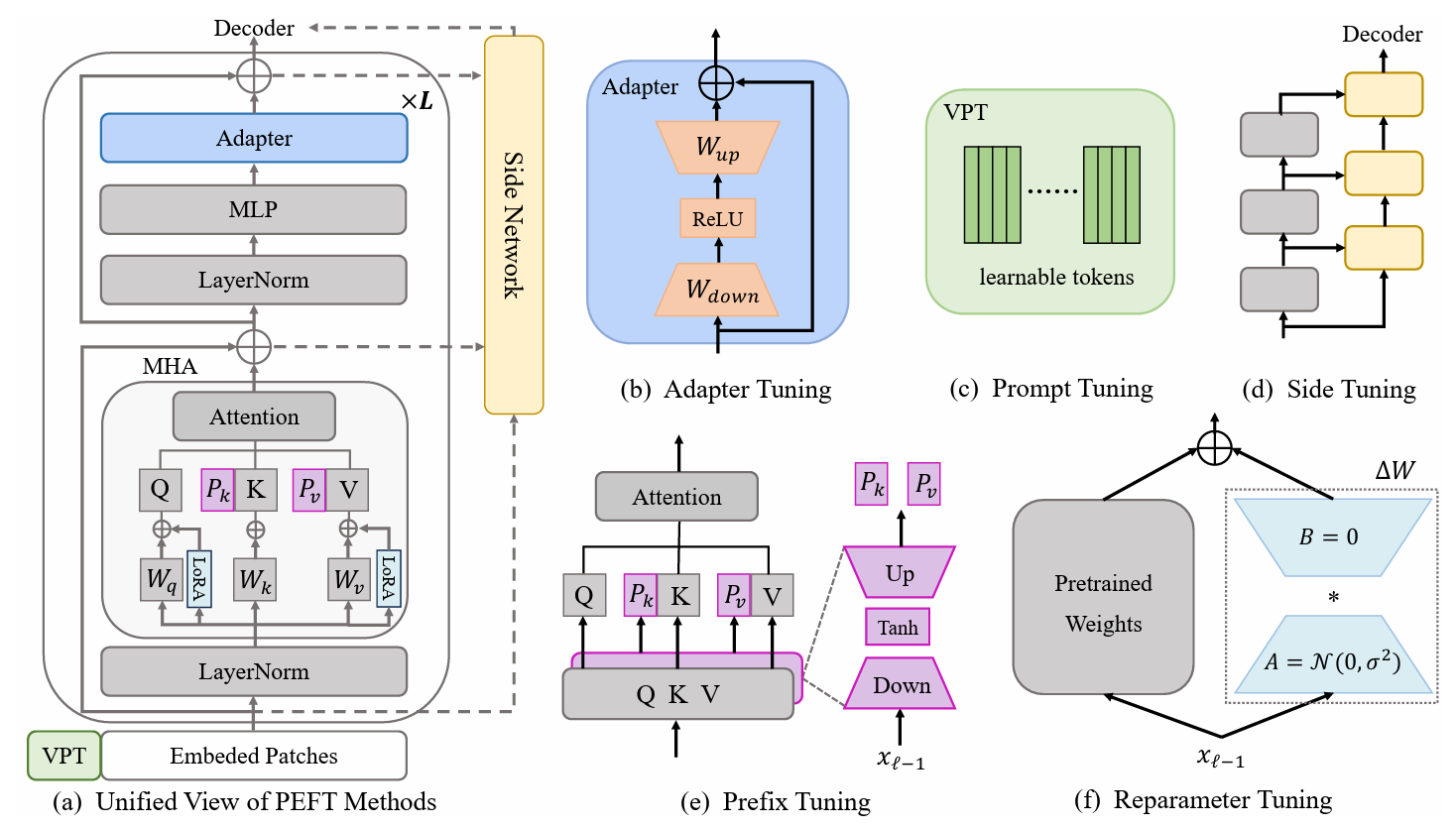

Los métodos de aprendizaje por transferencia eficiente de parámetros (PETL) son prometedores a la hora de adaptar un modelo previamente entrenado a diversas tareas posteriores mientras se entrena solo unos pocos parámetros. En el ámbito de la visión por computadora (CV), se han propuesto numerosos algoritmos PETL, pero su empleo directo o comparación sigue siendo inconveniente. Para abordar este desafío, construimos un punto de referencia visual unificado PETL (V-PETL Bench) para el dominio CV seleccionando 30 conjuntos de datos diversos, desafiantes y completos de reconocimiento de imágenes, reconocimiento de acciones de video y tareas de predicción densa . En estos conjuntos de datos, evaluamos sistemáticamente 25 algoritmos PETL dominantes y abrimos una base de código modular y extensible para una evaluación justa de estos algoritmos.

Tareas de clasificación visual detallada (FGVC)

FGVC comprende cinco conjuntos de datos de clasificación visual detallados. Los conjuntos de datos se pueden descargar siguiendo los enlaces oficiales. Dividimos los datos de entrenamiento si el conjunto de validación pública no está disponible. El conjunto de datos dividido se puede encontrar aquí: Enlace de descarga.

CUB200 2011

NAaves

Flores Oxford

Perros de Stanford

Coches de Stanford

Punto de referencia de adaptación de tareas visuales (VTAB)

VTAB comprende 19 conjuntos de datos de clasificación visual diversos. Hemos procesado todo el conjunto de datos y los datos se pueden descargar aquí: Enlace de descarga. Para obtener consejos y procedimientos de procesamiento específicos, consulte VTAB_SETUP.

Cinética-400

Descargue el conjunto de datos desde Enlace de descarga o Enlace de descarga.

Preprocese el conjunto de datos cambiando el tamaño del borde corto del vídeo a 320 px . Puede consultar MMAction2 Data Benchmark.

Genere las anotaciones necesarias para el cargador de datos ("train.csv , val.csv y test.csv . El formato del archivo *.csv es como:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Algo-Algo V2 (SSv2)

Descargue el conjunto de datos desde el enlace de descarga.

Preprocese el conjunto de datos cambiando la extensión del video de webm a .mp4 con la altura original de 240px . Puede consultar MMAction2 Data Benchmark.

Genere las anotaciones necesarias para el cargador de datos ("train.csv , val.csv y test.csv . El formato del archivo *.csv es como:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-COCO

MS-COCO están disponibles en este enlace de descarga.

ADE20K

El conjunto de formación y validación de ADE20K se puede descargar desde este enlace de descarga. También podemos descargar el conjunto de prueba desde el enlace de descarga.

PASCAL VOC

Pascal VOC 2012 se puede descargar desde el enlace de descarga. Además, los trabajos más recientes sobre el conjunto de datos de Pascal VOC generalmente explotan datos de aumento adicionales, que se pueden encontrar en el enlace de descarga.

Descargue y coloque el modelo previamente entrenado de ViT-B/16 en /path/to/pretrained_models .

mkdir modelos_preentrenados wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

o puede descargar el modelo previamente entrenado de Swin-B. Tenga en cuenta que también debe cambiar el nombre del ckpt Swin-B descargado de swin_base_patch4_window7_224_22k.pth a Swin-B_16.pth .

mkdir modelos_preentrenados wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

Otra forma es descargar modelos previamente entrenados desde el siguiente enlace y colocarlos en /path/to/pretrained_models .

| Columna vertebral previamente entrenada | Objetivo previamente entrenado | Conjunto de datos previamente entrenado | Control |

|---|---|---|---|

| ViT-B/16 | supervisado | ImagenNet-21K | Enlace de descarga |

| ViT-L/16 | supervisado | ImagenNet-21K | Enlace de descarga |

| ViT-H/16 | supervisado | ImagenNet-21K | Enlace de descarga |

| Swin-B | supervisado | ImagenNet-22K | Enlace de descarga |

| Swin-L | supervisado | ImagenNet-22K | Enlace de descarga |

| ViT-B (VideoMAE) | Autosupervisado | Cinética-400 | Enlace de descarga |

| Vídeo Swin-B | supervisado | Cinética-400 | Enlace de descarga |

ImageClassification/configs : maneja los parámetros de configuración para los experimentos.

ImageClassification/config/vtab/cifar100.yaml : configuraciones principales para experimentos y explicación para cada conjunto de datos.

.....

ImageClassification/dataloader : carga y configuración de conjuntos de datos de entrada.

ImageClassification/dataloader/transforms : Transformaciones de imágenes.

ImageClassification/dataloader/loader : construye el cargador de datos para el conjunto de datos dado.

ImageClassification/models : maneja arcos vertebrales y cabezales para diferentes protocolos de ajuste fino

ImageClassification/models/vision_transformer_adapter.py : una carpeta contiene las mismas redes troncales en la carpeta vit_backbones , especificada para el Adaptador.

ImageClassification/models/vision_transformer_sct.py : una carpeta contiene las mismas redes troncales en la carpeta vit_backbones , especificada para SCT.

.....

ImageClassification/train : una carpeta contiene la carpeta training file ,

ImageClassification/train/train_model_adapter.py : llame a este para entrenar y evaluar un modelo con un tipo de transferencia específico, especificado para el Adaptador.

ImageClassification/train/train_model_sct.py : llame a este para entrenar y evaluar un modelo con un tipo de transferencia específico, especificado para SCT.

.....

ImageClassification/scripts : una carpeta contiene la carpeta scripts file ,

ImageClassification/scripts/run_vit_adapter.sh : puede ejecutar el método Adaptador en todos los conjuntos de datos a la vez.

ImageClassification/scripts/run_vit_sct.sh : puede ejecutar el método Adaptador en todos los conjuntos de datos a la vez.

.....

ImageClassification/Visualize : Herramientas de visualización.

ImageClassification/Visualize/AttentionMap.py : visualización del mapa de atención.

ImageClassification/Visualize/TSNE.py : visualización T-SNE.

ImageClassification/utils : crear registrador, establecer semilla, etc.

❗️Nota❗️: Si desea crear su propio algoritmo PETL, preste atención a `ImageClassification/models`.

Este es un ejemplo de cómo configurar V-PETL Bench localmente.

Para obtener una copia local, siga estos sencillos pasos de ejemplo.

clon de git https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

V-PETL Bench está construido sobre pytorch, con torchvision, torchaudio y timm, etc.

Para instalar los paquetes necesarios, puede crear un entorno conda.

conda crear --nombre v-petl-bench python=3.8

Activar el entorno conda.

conda activar v-petl-bench

Utilice pip para instalar los paquetes necesarios.

cd Parámetro-Transferencia-Eficiente-Aprendizaje-Benchmark instalación de pip -r requisitos.txt

Ofrecemos una demostración específica de capacitación y evaluación, tomando como ejemplo LoRA en VTAB Cifar100.

sistema de importación

sys.path.append("Parámetro-Eficiencia-Transferencia-Aprendizaje-Benchmark")

importar antorcha

de las utilidades de importación ImageClassification

desde ImageClassification.dataloader importar vtab

de ImageClassification.train importar tren# obtener métodos lora de timm.scheduler.cosine_lr importar CosineLRScheduler

de ImageClassification.models importa vision_transformer_lora

importar timm# ruta para guardar el modelo y logsexp_base_path = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# parámetro de configuración del conjunto de datosconfig = utils.get_config(' model_lora', 'vtab', 'cifar100')# get vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger, evaluar=False, train_aug=config['train_aug'], batch_size=config['batch_size'])# obtener modelmodel previamente entrenado = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz' , drop_path_rate=0.1, tuning_mode='lora')

model.reset_classifier(config['class_num'])# parámetros de entrenamientotrainable = []para n, p en model.named_parameters(): si 'linear_a' en n o 'linear_b' en n o 'head' en n:

entrenable.append(p)

registrador.info(str(n))

demás:

p.requires_grad = Falso

opt = antorcha.optim.AdamW(entrenable, lr=1e-4, peso_decay=5e-2)

planificador = CosineLRScheduler(opt, t_initial=config['epochs'], warmup_t=config['warmup_epochs'], lr_min=1e-5, warmup_lr_init=1e-6, Cycle_decay = 0.1)# criterio de función crossEntropyLoss = torch.nn.CrossEntropyLoss( )# modelo de entrenamiento = train.train(config, modelo, criterio, train_dl, opt, planificador, registrador, config['épocas'], 'vtab', 'cifar100')# evaluacióneval_acc = train.test(modelo, test_dl, 'vtab ')Puedes entrenar con un algoritmo PETL en un conjunto de datos.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ modelo_punto de control

o puedes entrenar con un algoritmo PETL en todo el conjunto de datos

scripts bash/run_model_sct.sh

Evaluamos 13 algoritmos PETL en cinco conjuntos de datos con modelos ViT-B/16 previamente entrenados en ImageNet-21K.

Para obtener el punto de control, descárguelo en Enlace de descarga.

| Método | CUB-200-2011 | NAaves | Flores Oxford | Perros de Stanford | Coches de Stanford | Significar | Parámetros. | PPT |

|---|---|---|---|---|---|---|---|---|

| Ajuste completo | 87,3 | 82,7 | 98,8 | 89,4 | 84,5 | 88,54 | 85,8 millones | - |

| Sondeo lineal | 85,3 | 75,9 | 97,9 | 86.2 | 51.3 | 79,32 | 0M | 0,79 |

| Adaptador | 87.1 | 84,3 | 98,5 | 89,8 | 68,6 | 85,66 | 0,41 millones | 0,84 |

| Adaptar anterior | 88,4 | 84,7 | 99,2 | 88.2 | 81,9 | 88,48 | 0,46 millones | 0,87 |

| Ajuste de prefijo | 87,5 | 82.0 | 98.0 | 74.2 | 90.2 | 86,38 | 0,36 millones | 0,85 |

| Sintonización en U | 89,2 | 85,4 | 99,2 | 84.1 | 92.1 | 90.00 | 0,36 millones | 0,89 |

| Bitfit | 87,7 | 85.2 | 99,2 | 86,5 | 81,5 | 88.02 | 0,10 millones | 0,88 |

| VPT-poco profundo | 86,7 | 78,8 | 98,4 | 90,7 | 68,7 | 84,66 | 0,25 millones | 0,84 |

| VPT-profundo | 88,5 | 84.2 | 99.0 | 90.2 | 83,6 | 89.10 | 0,85 millones | 0,86 |

| SSF | 89,5 | 85,7 | 99,6 | 89,6 | 89,2 | 90,72 | 0,39 millones | 0,89 |

| lora | 85,6 | 79,8 | 98,9 | 87,6 | 72.0 | 84,78 | 0,77 millones | 0,82 |

| GPS | 89,9 | 86,7 | 99,7 | 92.2 | 90,4 | 91,78 | 0,66 millones | 0,90 |

| HST | 89,2 | 85,8 | 99,6 | 89,5 | 88.2 | 90,46 | 0,78 millones | 0,88 |

| ÚLTIMO | 88,5 | 84,4 | 99,7 | 86.0 | 88,9 | 89,50 | 0,66 millones | 0,87 |

| SNF | 90.2 | 87,4 | 99,7 | 89,5 | 86,9 | 90,74 | 0,25 millones | 0,90 |

Resultados de referencia en VTAB. Evaluamos 18 algoritmos PETL en 19 conjuntos de datos con modelos ViT-B/16 previamente entrenados en ImageNet-21K.

Para obtener el punto de control, descárguelo en Enlace de descarga.

| Método | CIFAR-100 | Caltech101 | DTD | Flores102 | Mascotas | SVHN | sol397 | Parche Camelyon | EuroSAT | Resisc45 | Retinopatía | Inteligente/recuento | Inteligente/distancia | DMLab | KITTI/distancia | dSprites/loc | dSprites/ori | PequeñoNORB/azi | PequeñoNORB/ele | Significar | Parámetros. | PPT |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Ajuste completo | 68,9 | 87,7 | 64.3 | 97,2 | 86,9 | 87,4 | 38,8 | 79,7 | 95,7 | 84.2 | 73,9 | 56.3 | 58,6 | 41,7 | 65,5 | 57,5 | 46,7 | 25,7 | 29.1 | 65,57 | 85,8 millones | - |

| Sondeo lineal | 63.4 | 85.0 | 63.2 | 97.0 | 86,3 | 36,6 | 51.0 | 78,5 | 87,5 | 68,6 | 74.0 | 34.3 | 30,6 | 33.2 | 55,4 | 12.5 | 20.0 | 9.6 | 19.2 | 52,94 | 0M | 0,53 |

| Adaptador | 69.2 | 90.1 | 68.0 | 98,8 | 89,9 | 82,8 | 54.3 | 84.0 | 94,9 | 81,9 | 75,5 | 80,9 | 65,3 | 48,6 | 78,3 | 74,8 | 48,5 | 29,9 | 41,6 | 71,44 | 0,16 millones | 0,71 |

| VPT-poco profundo | 77,7 | 86,9 | 62,6 | 97,5 | 87,3 | 74,5 | 51.2 | 78.2 | 92.0 | 75,6 | 72,9 | 50,5 | 58,6 | 40,5 | 67.1 | 68,7 | 36.1 | 20.2 | 34.1 | 64,85 | 0,08 millones | 0,65 |

| VPT-profundo | 78,8 | 90,8 | 65,8 | 98.0 | 88.3 | 78.1 | 49,6 | 81,8 | 96.1 | 83,4 | 68,4 | 68,5 | 60.0 | 46,5 | 72,8 | 73,6 | 47,9 | 32,9 | 37,8 | 69,43 | 0,56 millones | 0,68 |

| Bitfit | 72,8 | 87.0 | 59.2 | 97,5 | 85,3 | 59,9 | 51.4 | 78,7 | 91,6 | 72,9 | 69,8 | 61,5 | 55,6 | 32.4 | 55,9 | 66,6 | 40.0 | 15.7 | 25.1 | 62.05 | 0,10 millones | 0,61 |

| lora | 67.1 | 91,4 | 69,4 | 98,8 | 90,4 | 85,3 | 54.0 | 84,9 | 95,3 | 84,4 | 73,6 | 82,9 | 69.2 | 49,8 | 78,5 | 75,7 | 47.1 | 31.0 | 44.0 | 72,25 | 0,29 millones | 0,71 |

| Adaptar anterior | 70,8 | 91.2 | 70,5 | 99.1 | 90,9 | 86,6 | 54,8 | 83.0 | 95,8 | 84,4 | 76,3 | 81,9 | 64.3 | 49.3 | 80.3 | 76,3 | 45,7 | 31,7 | 41.1 | 72,32 | 0,16 millones | 0,72 |

| SSF | 69.0 | 92,6 | 75.1 | 99,4 | 91,8 | 90.2 | 52,9 | 87,4 | 95,9 | 87,4 | 75,5 | 75,9 | 62.3 | 53.3 | 80,6 | 77,3 | 54,9 | 29,5 | 37,9 | 73.10 | 0,21 millones | 0,72 |

| NOÉ | 69,6 | 92,7 | 70.2 | 99.1 | 90,4 | 86.1 | 53,7 | 84,4 | 95,4 | 83,9 | 75,8 | 82,8 | 68,9 | 49,9 | 81,7 | 81,8 | 48.3 | 32,8 | 44.2 | 73,25 | 0,43 millones | 0,72 |

| SCT | 75,3 | 91,6 | 72.2 | 99,2 | 91.1 | 91.2 | 55.0 | 85.0 | 96.1 | 86,3 | 76.2 | 81,5 | 65.1 | 51,7 | 80.2 | 75,4 | 46.2 | 33.2 | 45,7 | 73,59 | 0,11 millones | 0,73 |

| Hecho | 70,6 | 90,6 | 70,8 | 99.1 | 90,7 | 88,6 | 54.1 | 84,8 | 96,2 | 84,5 | 75,7 | 82,6 | 68.2 | 49,8 | 80,7 | 80,8 | 47,4 | 33.2 | 43.0 | 73,23 | 0,07 millones | 0,73 |

| Adaptador de representante | 72,4 | 91,6 | 71.0 | 99,2 | 91,4 | 90,7 | 55.1 | 85,3 | 95,9 | 84,6 | 75,9 | 82.3 | 68.0 | 50,4 | 79,9 | 80,4 | 49.2 | 38,6 | 41.0 | 73,84 | 0,22 millones | 0,72 |

| Hidra | 72,7 | 91.3 | 72.0 | 99,2 | 91,4 | 90,7 | 55,5 | 85,8 | 96.0 | 86.1 | 75,9 | 83.2 | 68.2 | 50,9 | 82.3 | 80.3 | 50,8 | 34,5 | 43.1 | 74.21 | 0,28 millones | 0,73 |

| LST | 59,5 | 91,5 | 69.0 | 99,2 | 89,9 | 79,5 | 54,6 | 86,9 | 95,9 | 85,3 | 74.1 | 81,8 | 61,8 | 52.2 | 81.0 | 71,7 | 49,5 | 33,7 | 45.2 | 71,70 | 2,38 millones | 0,65 |

| DTL | 69,6 | 94,8 | 71.3 | 99,3 | 91.3 | 83.3 | 56.2 | 87.1 | 96,2 | 86.1 | 75.0 | 82,8 | 64.2 | 48,8 | 81,9 | 93,9 | 53,9 | 34.2 | 47.1 | 74,58 | 0,04 millones | 0,75 |

| HST | 76,7 | 94.1 | 74,8 | 99,6 | 91.1 | 91.2 | 52.3 | 87.1 | 96,3 | 88,6 | 76,5 | 85,4 | 63,7 | 52,9 | 81,7 | 87,2 | 56,8 | 35,8 | 52.1 | 75,99 | 0,78 millones | 0,74 |

| GPS | 81.1 | 94.2 | 75,8 | 99,4 | 91,7 | 91,6 | 52,4 | 87,9 | 96,2 | 86,5 | 76,5 | 79,9 | 62,6 | 55.0 | 82,4 | 84.0 | 55,4 | 29,7 | 46.1 | 75,18 | 0,22 millones | 0,74 |

| ÚLTIMO | 66,7 | 93,4 | 76.1 | 99,6 | 89,8 | 86.1 | 54.3 | 86.2 | 96,3 | 86,8 | 75,4 | 81,9 | 65,9 | 49,4 | 82,6 | 87,9 | 46,7 | 32.3 | 51,5 | 74,15 | 0,66 millones | 0,72 |

| SNF | 84.0 | 94.0 | 72,7 | 99,3 | 91.3 | 90.3 | 54,9 | 87,2 | 97,3 | 85,5 | 74,5 | 82.3 | 63,8 | 49,8 | 82,5 | 75,8 | 49.2 | 31.4 | 42.1 | 74.10 | 0,25 millones | 0,73 |

Resultados comparativos en SSv2 y HMDB51. Evaluamos 5 algoritmos PETL con ViT-B de VideoMAE y Video Swin Transformer.

Para obtener el punto de control, descárguelo en Enlace de descarga.

| Método | Modelo | Pre-entrenamiento | Parámetros. | SSv2 (Top1) | SSv2 (PPT) | HMDB51 (Top1) | HMDB51 (PPT) |

|---|---|---|---|---|---|---|---|

| Ajuste completo | ViT-B | Cinética 400 | 85,97 millones | 53,97% | - | 46,41% | - |

| Congelado | ViT-B | Cinética 400 | 0M | 29,23% | 0,29 | 49,84% | 0,50 |

| Adaptar anterior | ViT-B | Cinética 400 | 1,19 millones | 59,02% | 0,56 | 55,69% | 0,53 |

| BAPAT | ViT-B | Cinética 400 | 2,06 millones | 57,78% | 0,53 | 57,18% | 0,53 |

| Ajuste completo | Vídeo Swin-B | Cinética 400 | 87,64 millones | 50,99% | - | 68,07% | - |

| Congelado | Vídeo Swin-B | Cinética 400 | 0M | 24,13% | 0,24 | 71,28% | 0,71 |

| lora | Vídeo Swin-B | Cinética 400 | 0,75 millones | 38,34% | 0,37 | 62,12% | 0,60 |

| Bitfit | Vídeo Swin-B | Cinética 400 | 1,09 millones | 45,94% | 0,44 | 68,26% | 0,65 |

| Adaptar anterior | Vídeo Swin-B | Cinética 400 | 1,56 millones | 40,80% | 0,38 | 68,66% | 0,64 |

| Ajuste de prefijo | Vídeo Swin-B | Cinética 400 | 6,37 millones | 39,46% | 0,32 | 56,13% | 0,45 |

| BAPAT | Vídeo Swin-B | Cinética 400 | 6,18 millones | 53,36% | 0,43 | 71,93% | 0,58 |

Resultados comparativos en COCO. Evaluamos 9 algoritmos PETL con modelos Swin-B previamente entrenados en ImageNet-22K.

Para obtener el punto de control, descárguelo en Próximamente.

| Swin-B | Parámetros. | Memoria | COCO ( | Coco (PPT) | COCO ( | Coco (PPT) |

|---|---|---|---|---|---|---|

| Ajuste completo | 86,75 millones | 17061 megas | 51,9% | - | 45,0% | - |

| Congelado | 0,00 millones | 7137 megas | 43,5% | 0,44 | 38,6% | 0,39 |

| bitfit | 0.20M | 13657 megas | 47,9% | 0,47 | 41,9% | 0,42 |

| SINTONIZACIÓN LN | 0,06 millones | 12831 megas | 48,0% | 0,48 | 41,4% | 0,41 |

| Parcial-1 | 12,60 millones | 7301 megas | 49,2% | 0,35 | 42,8% | 0,30 |

| Adaptador | 3,11 millones | 12557 megas | 50,9% | 0,45 | 43,8% | 0,39 |

| lora | 3,03 millones | 11975 megas | 51,2% | 0,46 | 44,3% | 0,40 |

| Adaptar anterior | 3,11 millones | 13186 megas | 51,4% | 0,46 | 44,5% | 0,40 |

| LoRand | 1,20M | 13598 megas | 51,0% | 0,49 | 43,9% | 0,42 |

| E$^3$VA | 1,20M | 7639 megas | 50,5% | 0,48 | 43,8% | 0,42 |

| mona | 4,16 millones | 13996MB | 53,4% | 0,46 | 46,0% | 0,40 |

Resultados comparativos en PASCAL VOC y ADE20K. Evaluamos 9 algoritmos PETL con modelos Swin-L previamente entrenados en ImageNet-22K.

Para obtener el punto de control, descárguelo en Próximamente.

| Swin-L | Parámetros. | Memoria (COV) | Pascal COV ( | Pascal COV (PPT) | ADE20K ( | ADE20K (PPT) |

|---|---|---|---|---|---|---|

| Ajuste completo | 198,58 millones | 15679 megas | 83,5% | - | 52,10% | - |

| Congelado | 0,00 millones | 3967MB | 83,6% | 0,84 | 46,84% | 0,47 |

| bitfit | 0.30M | 10861 megas | 85,7% | 0,85 | 48,37% | 0,48 |

| SINTONIZACIÓN LN | 0,09 millones | 10123 megas | 85,8% | 0,86 | 47,98% | 0,48 |

| Parcial-1 | 28,34 millones | 3943MB | 85,4% | 0,48 | 47,44% | 0,27 |

| Adaptador | 4,66 millones | 10793 megas | 87,1% | 0,74 | 50,78% | 0,43 |

| lora | 4,57 millones | 10127 megas | 87,5% | 0,74 | 50,34% | 0,43 |

| Adaptar anterior | 4,66 millones | 11036 megas | 87,3% | 0,74 | 50,83% | 0,43 |

| LoRand | 1,31 millones | 11572 megas | 86,8% | 0,82 | 50,76% | 0,48 |

| E$^3$VA | 1,79 millones | 4819 megas | 86,5% | 0,81 | 49,64% | 0,46 |

| mona | 5,08 millones | 11958 megas | 87,3% | 0,73 | 51,36% | 0,43 |

La comunidad V-PETL Bench es mantenida por:

Yi Xin ([email protected]), Universidad de Nanjing.

Siqi Luo ([email protected]), Universidad Jiao Tong de Shanghai.

Si considera que nuestra encuesta y nuestro repositorio son útiles para su investigación, cítelos a continuación:

@article{xin2024bench, title={V-PETL Bench: un punto de referencia de aprendizaje por transferencia eficiente de parámetros visuales unificados}, autor={Yi Xin, Siqi Luo, Xuyang Liu, Haodi Zhou, Xinyu Cheng, Christina Luoluo Lee, Junlong Du, Yuntao Du., Haozhe Wang, MingCai Chen, Ting Liu, Guimin Hu, Zhongwei Wan, Rongchao Zhang, Aoxue Li, Mingyang Yi, Xiaohong Liu}, año={2024}}