中文 | 한국어 | 日本語 | ruso | alemán | Francés | Español | Portugués | turco | Tiếng Việt | العربية

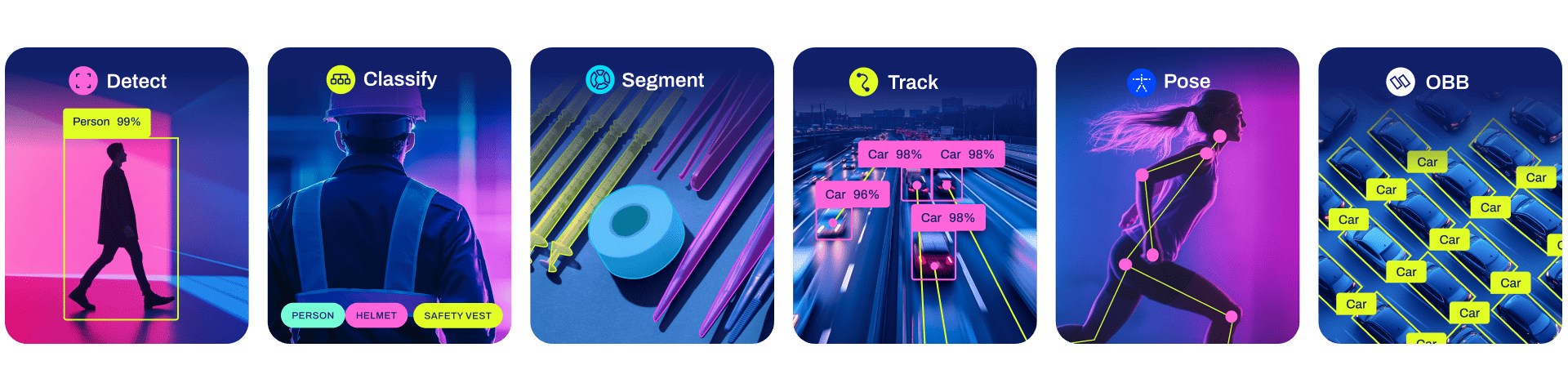

Ultralytics YOLO11 es un modelo de vanguardia (SOTA) que se basa en el éxito de versiones anteriores de YOLO e introduce nuevas características y mejoras para aumentar aún más el rendimiento y la flexibilidad. YOLO11 está diseñado para ser rápido, preciso y fácil de usar, lo que lo convierte en una excelente opción para una amplia gama de tareas de detección y seguimiento de objetos, segmentación de instancias, clasificación de imágenes y estimación de pose.

Esperamos que los recursos aquí le ayuden a aprovechar YOLO al máximo. Explore los documentos de Ultralytics para obtener más detalles, plantee un problema en GitHub para obtener asistencia, preguntas o debates, conviértase en miembro de Ultralytics Discord, Reddit y foros.

Para solicitar una licencia empresarial, complete el formulario en Licencias Ultralytics.

Documentación

Consulte a continuación una instalación de inicio rápido y ejemplos de uso, y consulte nuestros documentos para obtener documentación completa sobre capacitación, validación, predicción e implementación.

Pip instala el paquete ultralytics, incluidos todos los requisitos, en un entorno Python>=3.8 con PyTorch>=1.8 .

ultralíticos de instalación de pip

Para conocer métodos de instalación alternativos, incluidos Conda, Docker y Git, consulte la Guía de inicio rápido.

YOLO se puede utilizar directamente en la interfaz de línea de comandos (CLI) con un comando yolo :

yolo predecir modelo=yolo11n.pt fuente='https://ultralytics.com/images/bus.jpg'

yolo se puede utilizar para una variedad de tareas y modos y acepta argumentos adicionales, es decir, imgsz=640 . Consulte los documentos CLI de YOLO para ver ejemplos.

YOLO también se puede usar directamente en un entorno Python y acepta los mismos argumentos que en el ejemplo de CLI anterior:

desde ultralíticos importar YOLO# Cargar un modelomodelo = YOLO("yolo11n.pt")# Entrenar el modelotrain_results = model.train( data="coco8.yaml", # ruta al conjunto de datos épocas YAML=100, # número de épocas de entrenamiento imgsz= 640, # tamaño de imagen de entrenamiento dispositivo="cpu", # dispositivo para ejecutar, es decir, dispositivo=0 o dispositivo=0,1,2,3 o device=cpu)# Evaluar el rendimiento del modelo en la validación setmetrics = model.val()# Realizar la detección de objetos en una imagenresults = model("path/to/image.jpg")results[0].show()# Exportar el modelo a ONNX formatpath = model.export(format="onnx") # ruta de retorno al modelo exportadoConsulte YOLO Python Docs para obtener más ejemplos.

Modelos

Los modelos YOLO11 Detect, Segment y Pose preentrenados en el conjunto de datos COCO están disponibles aquí, así como los modelos YOLO11 Classify preentrenados en el conjunto de datos ImageNet. El modo Track está disponible para todos los modelos Detectar, Segmentar y Pose.

Todos los modelos se descargan automáticamente desde la última versión de Ultralytics en el primer uso.

Consulte Documentos de detección para ver ejemplos de uso con estos modelos entrenados en COCO, que incluyen 80 clases previamente entrenadas.

| Modelo | tamaño (píxeles) | valor del mapa 50-95 | Velocidad CPUONNX (EM) | Velocidad Tensor T4RT10 (EM) | parámetros (METRO) | FLOP (B) |

|---|---|---|---|---|---|---|

| yolo11n | 640 | 39,5 | 56,1 ± 0,8 | 1,5 ± 0,0 | 2.6 | 6.5 |

| yolo11s | 640 | 47.0 | 90,0 ± 1,2 | 2,5 ± 0,0 | 9.4 | 21,5 |

| YOLO11m | 640 | 51,5 | 183,2 ± 2,0 | 4,7 ± 0,1 | 20.1 | 68.0 |

| yolo11l | 640 | 53.4 | 238,6 ± 1,4 | 6,2 ± 0,1 | 25.3 | 86,9 |

| yolo11x | 640 | 54,7 | 462,8 ± 6,7 | 11,3 ± 0,2 | 56,9 | 194,9 |

Los valores de mAP val son para un solo modelo de escala única en el conjunto de datos COCO val2017.

Reproducir por yolo val detect data=coco.yaml device=0

Velocidad promediada sobre imágenes COCO val utilizando una instancia P4d de Amazon EC2.

Reproducir por yolo val detect data=coco.yaml batch=1 device=0|cpu

Consulte Segmentation Docs para ver ejemplos de uso con estos modelos entrenados en COCO-Seg, que incluyen 80 clases previamente entrenadas.

| Modelo | tamaño (píxeles) | cuadro de mapa 50-95 | máscara de mapa 50-95 | Velocidad CPUONNX (EM) | Velocidad Tensor T4RT10 (EM) | parámetros (METRO) | FLOP (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-seg | 640 | 38,9 | 32.0 | 65,9 ± 1,1 | 1,8 ± 0,0 | 2.9 | 10.4 |

| YOLO11s-seg | 640 | 46,6 | 37,8 | 117,6 ± 4,9 | 2,9 ± 0,0 | 10.1 | 35,5 |

| YOLO11m-seg | 640 | 51,5 | 41,5 | 281,6 ± 1,2 | 6,3 ± 0,1 | 22.4 | 123.3 |

| YOLO11l-seg | 640 | 53.4 | 42,9 | 344,2 ± 3,2 | 7,8 ± 0,2 | 27,6 | 142.2 |

| YOLO11x-seg | 640 | 54,7 | 43,8 | 664,5 ± 3,2 | 15,8 ± 0,7 | 62.1 | 319.0 |

Los valores de mAP val son para un solo modelo de escala única en el conjunto de datos COCO val2017.

Reproducir por yolo val segment data=coco-seg.yaml device=0

Velocidad promediada sobre imágenes COCO val utilizando una instancia P4d de Amazon EC2.

Reproducir por yolo val segment data=coco-seg.yaml batch=1 device=0|cpu

Consulte Classification Docs para ver ejemplos de uso con estos modelos entrenados en ImageNet, que incluyen 1000 clases previamente entrenadas.

| Modelo | tamaño (píxeles) | acc arriba1 | acc top5 | Velocidad CPUONNX (EM) | Velocidad Tensor T4RT10 (EM) | parámetros (METRO) | FLOP (B) en 640 |

|---|---|---|---|---|---|---|---|

| YOLO11n-cls | 224 | 70.0 | 89,4 | 5,0 ± 0,3 | 1,1 ± 0,0 | 1.6 | 3.3 |

| YOLO11s-cls | 224 | 75,4 | 92,7 | 7,9 ± 0,2 | 1,3 ± 0,0 | 5.5 | 12.1 |

| YOLO11m-cls | 224 | 77,3 | 93,9 | 17,2 ± 0,4 | 2,0 ± 0,0 | 10.4 | 39.3 |

| YOLO11l-cls | 224 | 78,3 | 94,3 | 23,2 ± 0,3 | 2,8 ± 0,0 | 12.9 | 49,4 |

| YOLO11x-cls | 224 | 79,5 | 94,9 | 41,4 ± 0,9 | 3,8 ± 0,0 | 28.4 | 110.4 |

Los valores de acc son precisiones del modelo en el conjunto de validación del conjunto de datos ImageNet.

Reproducir por yolo val classify data=path/to/ImageNet device=0

Velocidad promediada sobre imágenes ImageNet val utilizando una instancia Amazon EC2 P4d.

Reproducir por yolo val classify data=path/to/ImageNet batch=1 device=0|cpu

Consulte Pose Docs para ver ejemplos de uso con estos modelos entrenados en COCO-Pose, que incluyen 1 clase por persona previamente entrenada.

| Modelo | tamaño (píxeles) | pose del mapa 50-95 | pose del mapa 50 | Velocidad CPUONNX (EM) | Velocidad Tensor T4RT10 (EM) | parámetros (METRO) | FLOP (B) |

|---|---|---|---|---|---|---|---|

| YOLO11n-pose | 640 | 50.0 | 81.0 | 52,4 ± 0,5 | 1,7 ± 0,0 | 2.9 | 7.6 |

| YOLO11s-pose | 640 | 58,9 | 86,3 | 90,5 ± 0,6 | 2,6 ± 0,0 | 9.9 | 23.2 |

| YOLO11m-pose | 640 | 64,9 | 89,4 | 187,3 ± 0,8 | 4,9 ± 0,1 | 20.9 | 71,7 |

| YOLO11l-pose | 640 | 66.1 | 89,9 | 247,7 ± 1,1 | 6,4 ± 0,1 | 26.2 | 90,7 |

| YOLO11x-pose | 640 | 69,5 | 91.1 | 488,0 ± 13,9 | 12,1 ± 0,2 | 58,8 | 203.3 |

Los valores de mAP val son para un solo modelo de escala única en el conjunto de datos COCO Keypoints val2017.

Reproducir por yolo val pose data=coco-pose.yaml device=0

Velocidad promediada sobre imágenes COCO val utilizando una instancia P4d de Amazon EC2.

Reproducir por yolo val pose data=coco-pose.yaml batch=1 device=0|cpu

Consulte OBB Docs para ver ejemplos de uso con estos modelos entrenados en DOTAv1, que incluyen 15 clases previamente entrenadas.

| Modelo | tamaño (píxeles) | prueba de mapa 50 | Velocidad CPUONNX (EM) | Velocidad Tensor T4RT10 (EM) | parámetros (METRO) | FLOP (B) |

|---|---|---|---|---|---|---|

| YOLO11n-obb | 1024 | 78,4 | 117,6 ± 0,8 | 4,4 ± 0,0 | 2.7 | 17.2 |

| YOLO11s-obb | 1024 | 79,5 | 219,4 ± 4,0 | 5,1 ± 0,0 | 9.7 | 57,5 |

| YOLO11m-obb | 1024 | 80,9 | 562,8 ± 2,9 | 10,1 ± 0,4 | 20.9 | 183,5 |

| YOLO11l-obb | 1024 | 81.0 | 712,5 ± 5,0 | 13,5 ± 0,6 | 26.2 | 232.0 |

| YOLO11x-obb | 1024 | 81.3 | 1408,6 ± 7,7 | 28,6 ± 1,0 | 58,8 | 520.2 |

Los valores de prueba de mAP son para multiescala de modelo único en el conjunto de datos DOTAv1.

Reproduzca mediante yolo val obb data=DOTAv1.yaml device=0 split=test y envíe los resultados combinados a la evaluación de DOTA.

Velocidad promediada sobre imágenes DOTAv1 val utilizando una instancia Amazon EC2 P4d.

Reproducir por yolo val obb data=DOTAv1.yaml batch=1 device=0|cpu

Integraciones

Nuestras integraciones clave con las principales plataformas de IA amplían la funcionalidad de las ofertas de Ultralytics, mejorando tareas como el etiquetado de conjuntos de datos, la capacitación, la visualización y la gestión de modelos. Descubra cómo Ultralytics, en colaboración con W&B, Comet, Roboflow y OpenVINO, puede optimizar su flujo de trabajo de IA.

![]()

![]()

![]()

| ¿HUB de ultralíticos? | W&B | Cometa ⭐ NUEVO | Magia neuronal |

|---|---|---|---|

| Optimice los flujos de trabajo de YOLO: etiquete, capacite e implemente sin esfuerzo con Ultralytics HUB. ¡Pruébalo ahora! | Realice un seguimiento de experimentos, hiperparámetros y resultados con pesos y sesgos | Gratis para siempre, Comet le permite guardar modelos YOLO11, reanudar el entrenamiento y visualizar y depurar predicciones de forma interactiva | Ejecute la inferencia de YOLO11 hasta 6 veces más rápido con Neural Magic DeepSparse |

HUB de ultralíticos

Experimente una IA perfecta con Ultralytics HUB ⭐, la solución todo en uno para visualización de datos, YOLO11. entrenamiento e implementación de modelos, sin ningún tipo de codificación. Transforme imágenes en conocimientos prácticos y haga realidad sus visiones de IA con facilidad utilizando nuestra plataforma de vanguardia y la aplicación Ultralytics fácil de usar. ¡Comienza tu viaje gratis ahora!

Contribuir

¡Nos encanta tu aporte! Ultralytics YOLO no sería posible sin la ayuda de nuestra comunidad. Consulte nuestra Guía de contribución para comenzar y complete nuestra encuesta para enviarnos comentarios sobre su experiencia. Gracias ? a todos nuestros colaboradores!

Licencia

Ultralytics ofrece dos opciones de licencia para adaptarse a diversos casos de uso:

Licencia AGPL-3.0 : esta licencia de código abierto aprobada por OSI es ideal para estudiantes y entusiastas, ya que promueve la colaboración abierta y el intercambio de conocimientos. Consulte el archivo de LICENCIA para obtener más detalles.

Licencia empresarial : diseñada para uso comercial, esta licencia permite una integración perfecta del software Ultralytics y los modelos de IA en bienes y servicios comerciales, sin pasar por los requisitos de código abierto de AGPL-3.0. Si su situación implica integrar nuestras soluciones en una oferta comercial, comuníquese con Ultralytics Licensing.

Contacto

Para informes de errores de Ultralytics y solicitudes de funciones, visite Problemas de GitHub. Conviértase en miembro de Ultralytics Discord, Reddit o foros para hacer preguntas, compartir proyectos, aprender debates o recibir ayuda con todo lo relacionado con Ultralytics.