Hyeongjin Nam* 1 , Daniel Sungho Jung* 1 , Gyeongsik Moon 2 , Kyoung Mu Lee 1

![]()

![]()

1 Universidad Nacional de Seúl , 2 Laboratorio de avatares de códec, Meta

(*Igual contribución)

CONTHO reconstruye conjuntamente seres humanos y objetos en 3D aprovechando el contacto entre humanos y objetos como señal clave para una reconstrucción precisa. Con este fin, integramos la "reconstrucción 3D de objetos humanos" y la "estimación de contacto entre humanos y objetos" , las dos tareas diferentes que se han estudiado por separado en dos pistas, con un marco unificado.

Le recomendamos utilizar un entorno virtual Anaconda. Instale PyTorch >= 1.10.1 y Python >= 3.7.0. Nuestro último modelo CONTHO se prueba en Python 3.9.13, PyTorch 1.10.1, CUDA 10.2.

Configurar el entorno

# Initialize conda environment conda create -n contho python=3.9 conda activate contho # Install PyTorch conda install pytorch==1.10.1 torchvision==0.11.2 torchaudio==0.10.1 cudatoolkit=10.2 -c pytorch # Install all remaining packages pip install -r requirements.txt

Prepare base_data de Google Drive o Onedrive y colóquelo como ${ROOT}/data/base_data .

Descargue el punto de control previamente entrenado desde Google Drive o OneDrive.

Por último, ejecute

python main/demo.py --gpu 0 --checkpoint {CKPT_PATH} Debe seguir la estructura de directorios de los data como se muestra a continuación.

${ROOT}

|-- data

| |-- base_data

| | |-- annotations

| | |-- backbone_models

| | |-- human_models

| | |-- object_models

| |-- BEHAVE

| | |-- dataset.py

| | |-- sequences

| | | |-- Date01_Sub01_backpack_back

| | | |-- Date01_Sub01_backpack_hand

| | | |-- ...

| | | |-- Date07_Sub08_yogamat

| |-- InterCap

| | |-- dataset.py

| | |-- sequences

| | | |-- 01

| | | |-- 02

| | | |-- ...

| | | |-- 10 Descargue las secuencias Data01~Data07 del conjunto de datos BEHAVE a ${ROOT}/data/BEHAVE/sequences .

(Opción 1) Descargue directamente el conjunto de datos BEHAVE desde su página de descarga.

(Opción 2) Ejecute el siguiente script.

scripts/download_behave.sh

Descargue RGBD_Images.zip y Res.zip del conjunto de datos de InterCap a ${ROOT}/data/InterCap/sequences .

(Opción 1) Descargue directamente el conjunto de datos de InterCap desde su página de descarga.

(Opción 2) Ejecute el siguiente script.

scripts/download_intercap.sh

Descargue base_data desde Google Drive o Onedrive.

(Opcional) Descargue los puntos de control publicados para el conjunto de datos BEHAVE (Google Drive | OneDrive) e InterCap (Google Drive | OneDrive).

Para entrenar CONTHO en el conjunto de datos BEHAVE o InterCap, ejecute

python main/train.py --gpu 0 --dataset {DATASET}Para evaluar CONTHO en el conjunto de datos BEHAVE o InterCap, ejecute

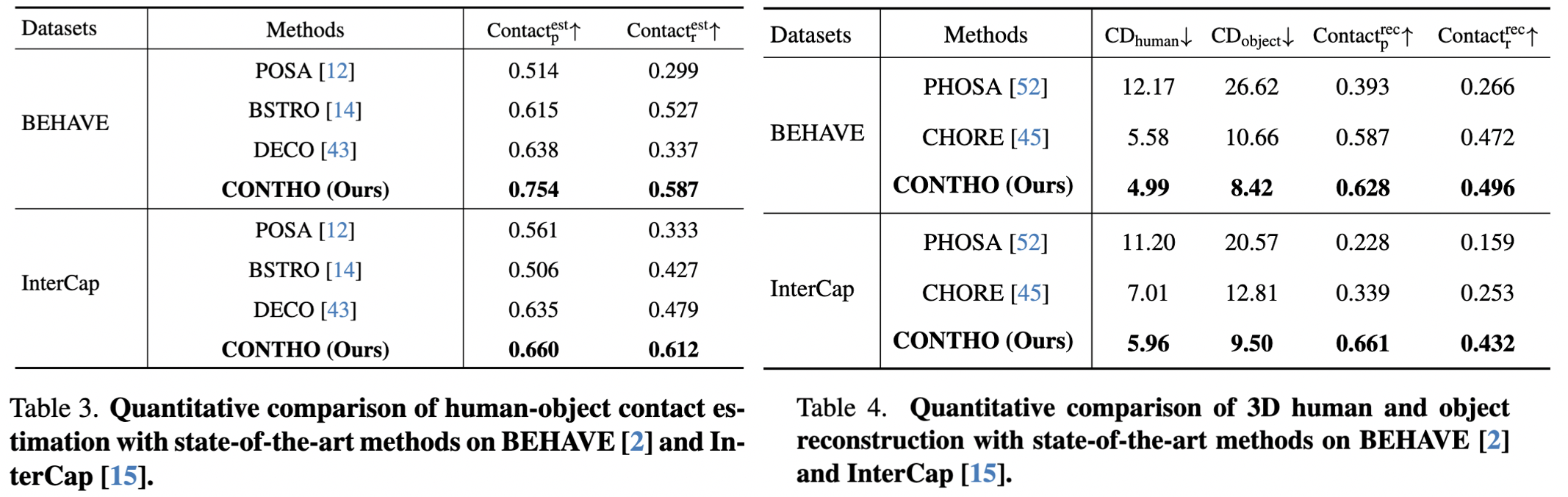

python main/test.py --gpu 0 --dataset {DATASET} --checkpoint {CKPT_PATH} Aquí informamos el desempeño de CONTHO.

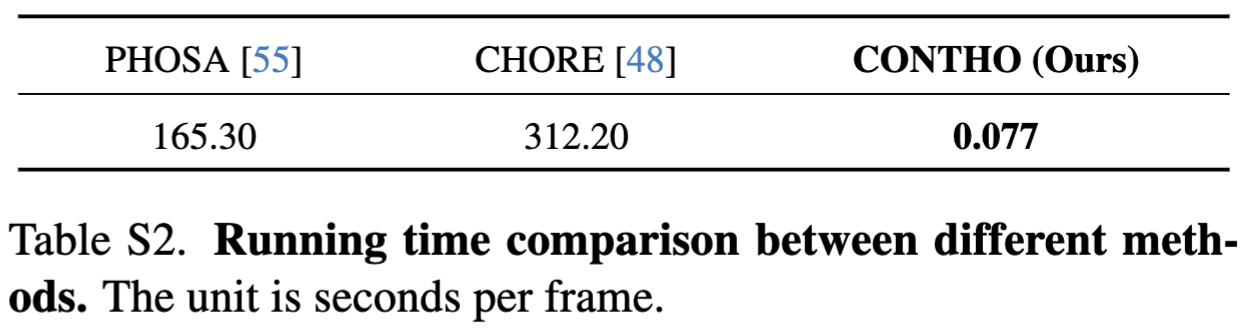

¡CONTHO es un marco de reconstrucción de objetos y personas en 3D rápido y preciso !

RuntimeError: No se admite la resta, el operador - , con un tensor bool. Si está intentando invertir una máscara, utilice el operador ~ o logical_not() en su lugar: consulte la referencia.

bash: scripts/download_behave.sh: Permiso denegado: verifique la referencia.

Agradecemos:

Hand4Whole para la reconstrucción de malla humana en 3D.

TAREAS para entrenar y probar BEHAVE.

InterCap para descargar el script del conjunto de datos.

DECO para la configuración de experimentos en la naturaleza.

@inproceedings{nam2024contho,

title = {Joint Reconstruction of 3D Human and Object via Contact-Based Refinement Transformer},

author = {Nam, Hyeongjin and Jung, Daniel Sungho and Moon, Gyeongsik and Lee, Kyoung Mu},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year = {2024}

}