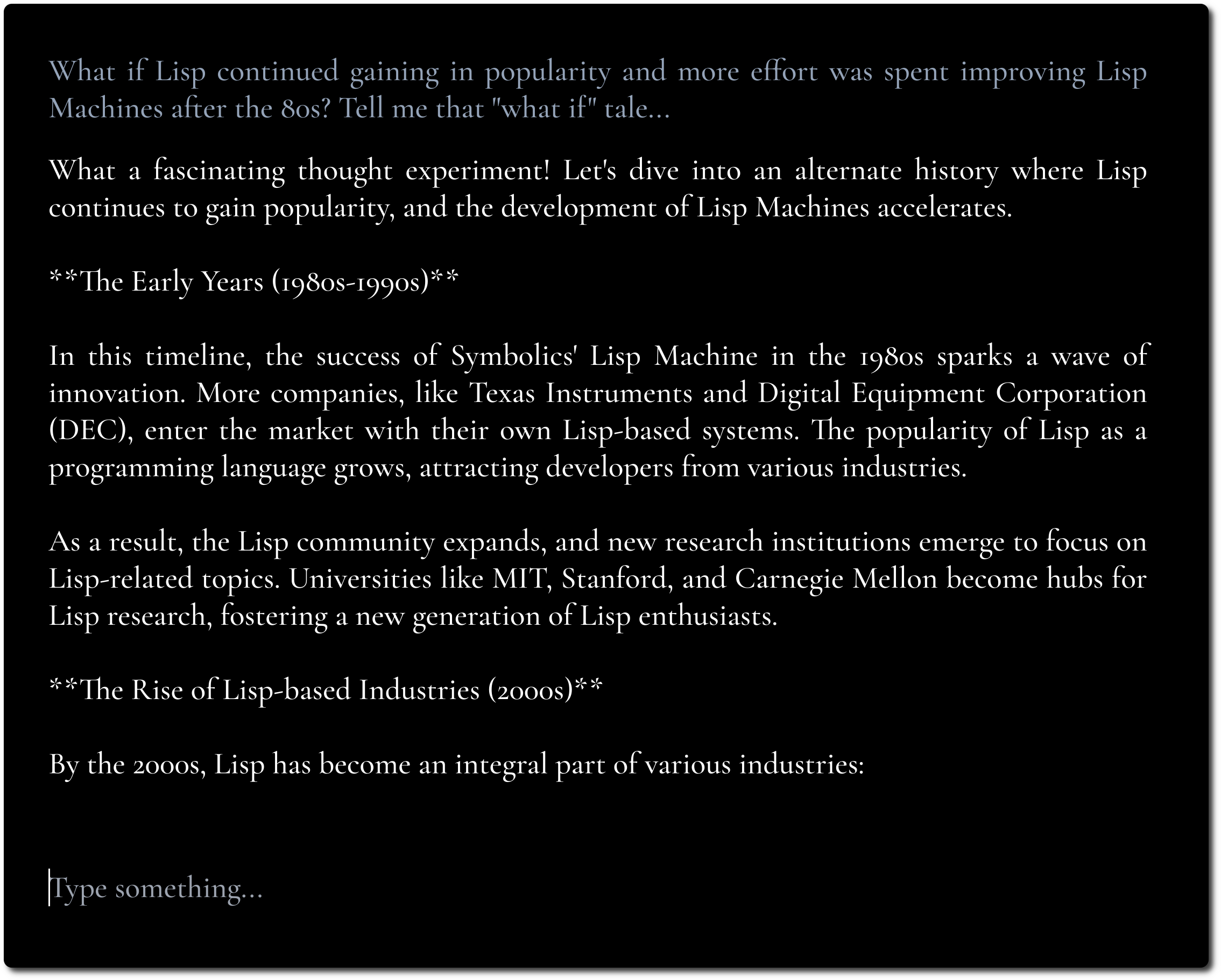

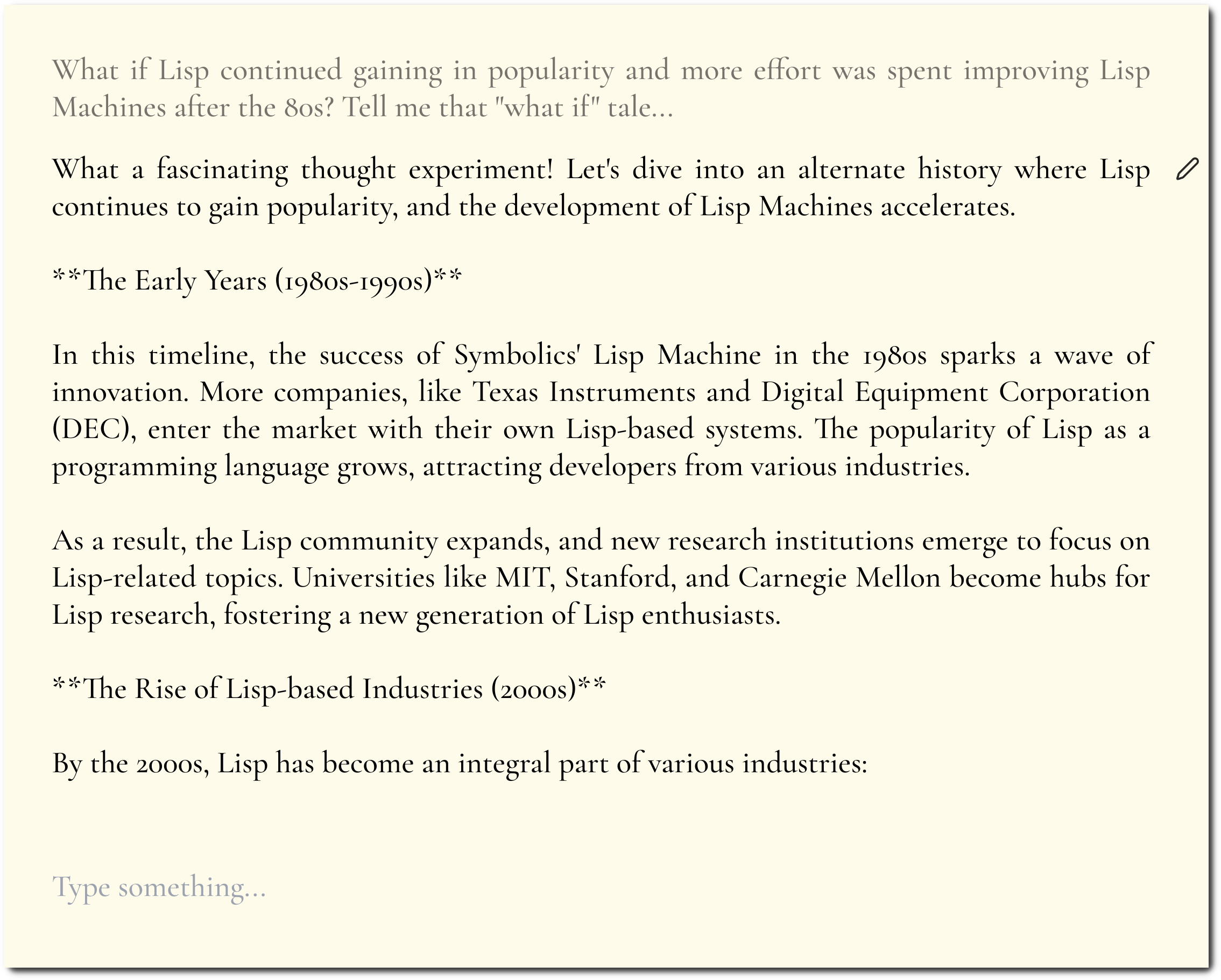

Una interfaz de usuario de chat de LLM minimalista, inspirada en Fooocus y Pi.

Si tiene un punto final API habilitado para CORS para usar, puede probarlo aquí.

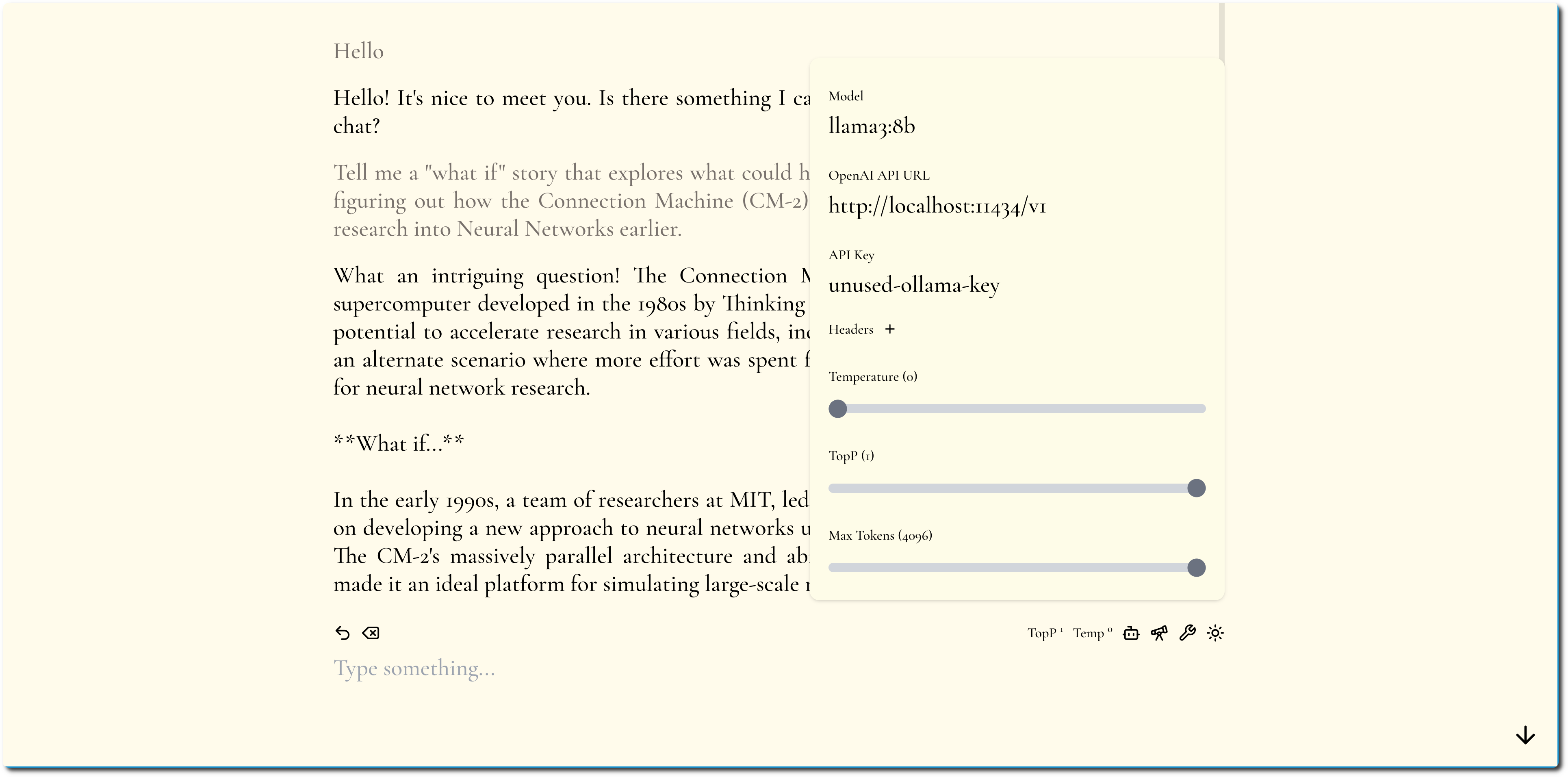

El objetivo es centrarse en el contenido y ocultar tantos retoques y ajustes como sea posible.

Destacamos el contenido mediante el uso de tipografía atrevida y diseño minimalista.

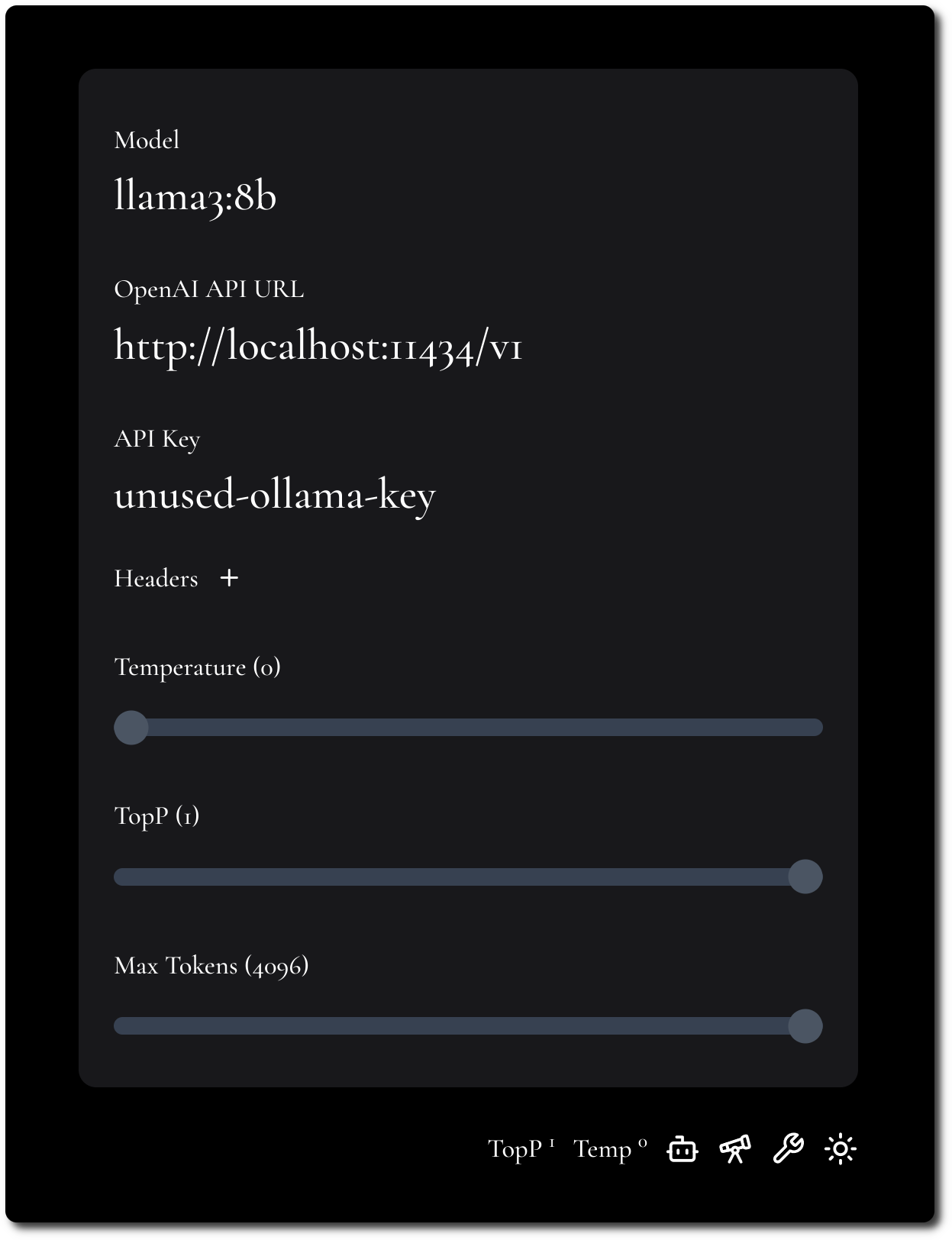

Intentamos mantener la configuración mínima pero flexible.

MiniChat admite API compatibles con OpenAI; consulte la sección Docker Compose para ejecutar MiniChat con varios proveedores de modelos aprovechando puertas de enlace como Portkey.

Puedes ejecutar MiniChat con Docker, la imagen tiene menos de 2 MB.

docker run -p 3216:3216 ghcr.io/functorism/minichat:master

Correr

docker compose -f docker-compose-ollama.yml up

docker exec minichat-ollama-1 ollama pull llama3:8b

Configuración de la interfaz de usuario:

Correr

docker compose -f docker-compose-portkey.yml up

Configuración de la interfaz de usuario:

Correr

docker compose -f docker-compose-tf-tgi.yml up

Configuración de la interfaz de usuario: