¡Dibujo de líneas, segmentación, transferencia de estilo y mejora con Stable Diffusion!

Esta GUI permite generar imágenes a partir de simples pinceladas, o curvas de Bézier, en tiempo real. Las funciones se han diseñado principalmente para su uso en arquitectura y para realizar bocetos en las primeras etapas de un proyecto. Utiliza Stable Diffusion y ControlNet como columna vertebral de IA para el proceso generativo. Se incluye compatibilidad con adaptadores IP, así como una gran biblioteca de estilos predefinidos. Cada imagen de referencia permite transferir un estilo específico a tu línea de trabajo. También se agregó una función exclusiva para exportar resultados en alta resolución (basada en el mosaico ControlNet).

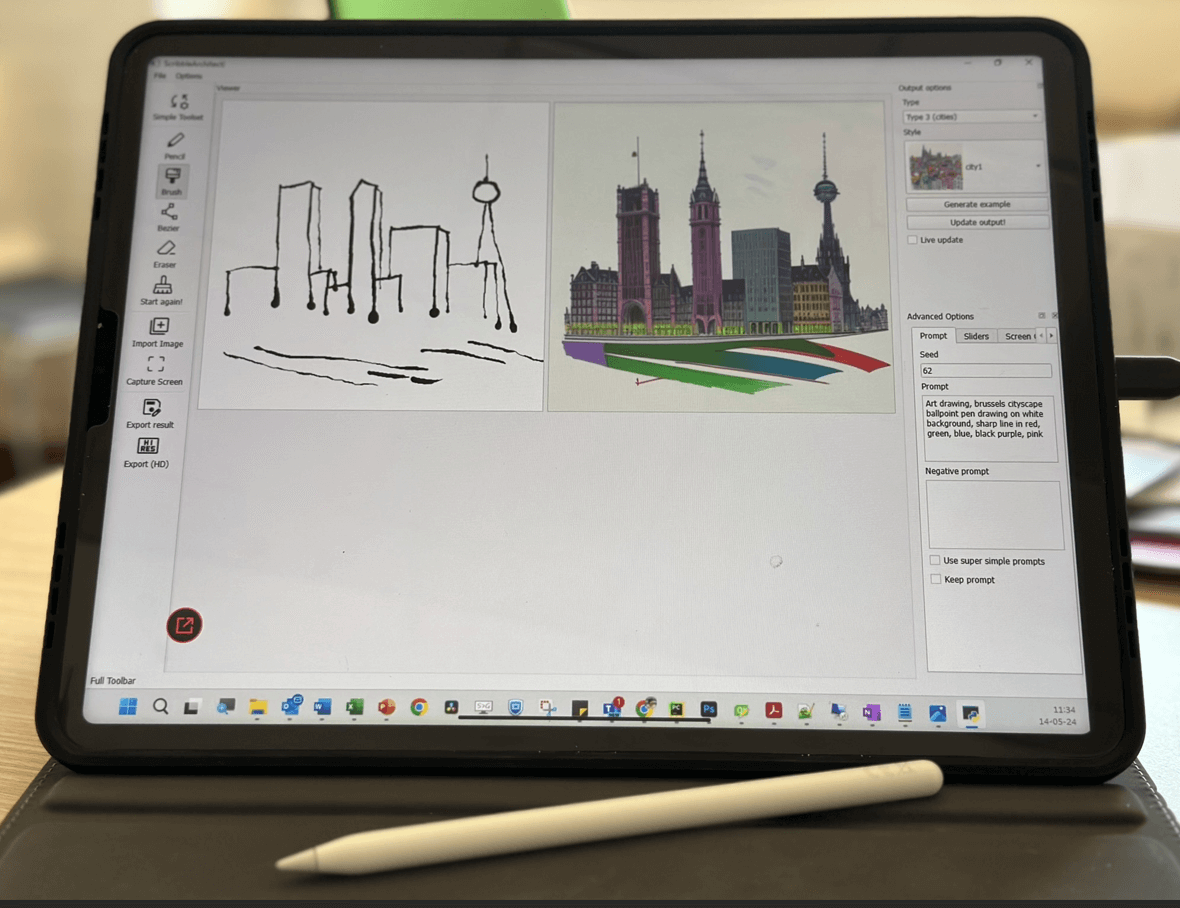

ejemplo que muestra dibujo en vivo

ejemplo que muestra el cambio de estilo (interior)

ejemplo que muestra el cambio de estilo (exterior)

Recientemente se agregaron muchas funciones nuevas:

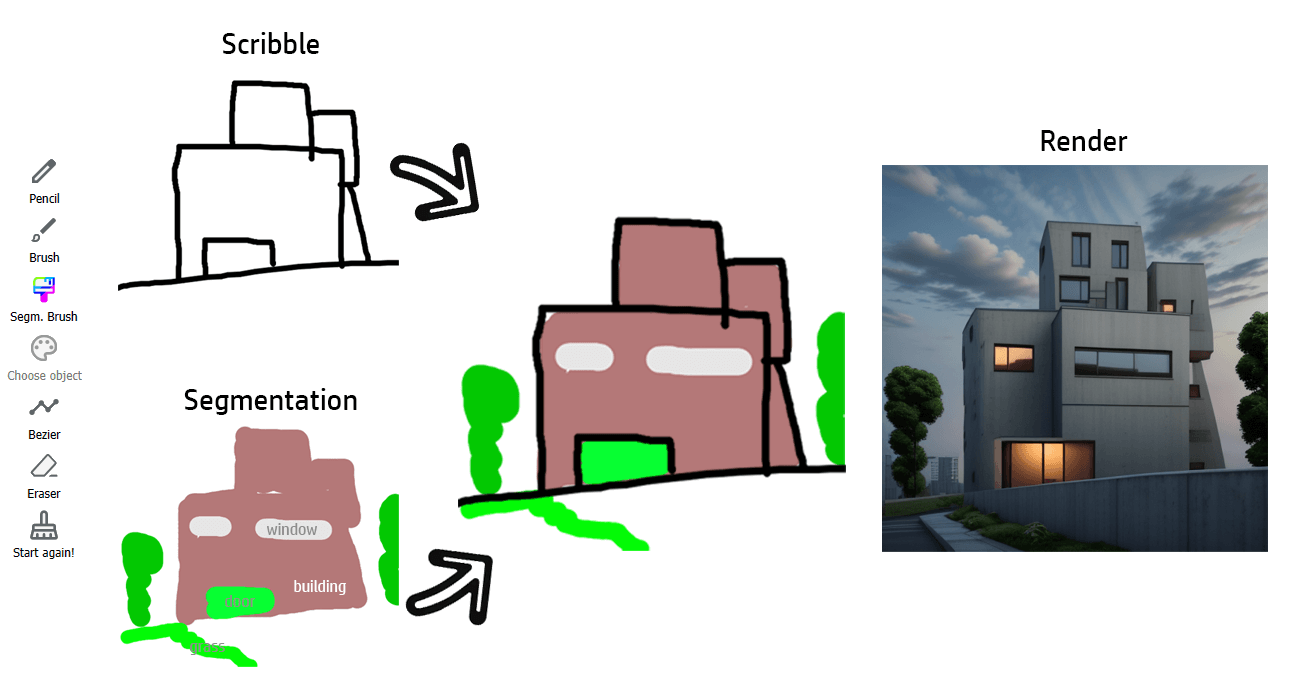

Recientemente hemos incorporado un nuevo sistema de capas, donde el usuario puede dibujar líneas negras (para alimentar ControlNet Scribble) o pinceladas de colores (para ControlNet Segmentation). Consulte 'Usar la aplicación'. NOTA: Aún puede encontrar la versión anterior en la sección "lanzamientos".

Elija un 'tipo' de diseño arquitectónico (representación exterior, alzado de fachada, representación interior,...) y un estilo. A la izquierda, encontrarás el área de dibujo. Puede agregar líneas negras para definir las líneas importantes de su dibujo o zonas coloreadas (un mapa semántico) para definir dónde se deben colocar objetos específicos (un árbol, una ventana, etc.). A cada tipo de objeto se le asocia un código de color específico. No tienes que preocuparte por elegir el color correcto, ya que la interfaz gráfica te permite seleccionar directamente el objeto a dibujar. El proceso de dibujo en sí es completamente estándar. ¡Elige tu herramienta y dibuja! (o eliminar). Verá la imagen propuesta adaptarse en vivo (una casilla de verificación le permite desactivar la inferencia en vivo).

ejemplo que muestra el uso del pincel de segmentación (interior)

Si le falta inspiración, o con fines de prueba, se puede generar automáticamente un dibujo de garabato de ejemplo.

Las imágenes también se pueden importar para generar automáticamente garabatos y/o segmentación.

También agregamos una función de captura de pantalla. crea un cuadro de captura (borde azul) que se puede arrastrar y generará garabatos basados en la zona capturada. Una vez satisfecho con la captura, haga clic nuevamente en la herramienta para desactivarla. Permite trabajar con potentes herramientas como entrada (Adobe Illustrator, Inkscape,...).

Función de captura de pantalla con Inkscape como entrada

El render se puede exportar en alta resolución, gracias a un escalador ControlNet. ¡Pronto se integrarán más opciones!

Mejora de escala (renderizado exterior artístico)

Mejora (renderizado interior realista)

Recientemente se ha incluido soporte para medios de dibujo. Se debe detectar la presión del bolígrafo. Probado en Ipad Pro + EasyCanvas.

El dibujo en vivo requiere una GPU potente. Recomendaría reducir el tamaño de la imagen (en main.py) si hay demasiado retraso. La mejora de imagen requiere mucho uso de GPU...

De forma predeterminada, la aplicación utiliza Dreamshaper (https://huggingface.co/Lykon/dreamshaper-8). Se pueden agregar modelos personalizados en la carpeta dedicada ("custom_models"). Cualquier punto de control SD1.5 debería funcionar.

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

(ver https://pytorch.org/get-started/locally/)

pip install git+https://github.com/sberbank-ai/Real-ESRGAN.git

https://huggingface.co/lllyasviel/sd-controlnet-seg https://huggingface.co/lllyasviel/sd-controlnet-scribble