"Es como si AutoGPT tuviera una brew install ", hecho posible gracias a Kurtosis.

NOTA : Esto ahora se ejecuta con 0.4.0 que deja de ser compatible con Milvus, Weaviate y PineCone. Puede ejecutar Kurtosis contra 0.3.1 kurtosis run github.com/kurtosis-tech/[email protected] con los argumentos deseados.

YOUR_API_KEY_HERE con su clave API OpenAI) kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogpt --exec " python -m autogpt "

YOUR_API_KEY_HERE con su clave API OpenAI) kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} 'kurtosis service shell autogpt autogpty luego dentro del mensaje:

> python -m autogpt kurtosis enclave rm -f autogpt

Para pasar cualquiera de los valores de configuración de AutoGPT enumerados aquí, pase el argumento como una propiedad del objeto JSON que está pasando a Kurtosis tal como pasó en OPENAI_API_KEY .

Por ejemplo, así es como pasarías el indicador RESTRICT_TO_WORKSPACE :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "RESTRICT_TO_WORKSPACE": "False"} ' NOTA: este paquete activa AutoGPT utilizando el backend local de forma predeterminada. Otros backends están disponibles configurando el parámetro MEMORY_BACKEND en el objeto JSON que pasa cuando ejecuta el comando kurtosis run anterior.

Por ejemplo, para configurar el backend de la memoria redis :

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "MEMORY_BACKEND": "redis"} 'NOTA : Redis no funciona con 0.4.0 por ahora

Para ejecutar con una imagen diferente a la codificada en main.star use

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "AUTOGPT_IMAGE": "significantgravitas/auto-gpt:v0.4.0"} ' Kurtosis admite el indicador de configuración ALLOWLISTED_PLUGINS que viene con AutoGPT. Por ejemplo, para ejecutar el complemento AutoGPTTwitter haga lo siguiente:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter"} 'Para ejecutar varios complementos al mismo tiempo; sepárelos con coma sin espacios así:

kurtosis run github.com/kurtosis-tech/autogpt-package --enclave autogpt '{"OPENAI_API_KEY": "YOUR_API_KEY_HERE", "ALLOWLISTED_PLUGINS": "AutoGPTTwitter,AutoGPTEmailPlugin"}'

Debajo del capó, Kurtosis descargará e instalará el paquete por usted.

A partir de ahora se admiten los siguientes complementos:

Para agregar soporte para más complementos, simplemente cree un problema o cree un PR agregando una entrada a plugins.star .

Entendemos que OpenAI puede resultar costoso para algunas personas; Es más, es posible que algunas personas estén intentando utilizar esto con sus propios modelos. AutoGPT-Package admite la ejecución de AutoGPT en un modelo GPT4All que se ejecuta a través de LocalAI . Para utilizar un modelo local:

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true} ' Esto utiliza el modelo predeterminado https://gpt4all.io/models/ggml-gpt4all-j.bin

Para utilizar un modelo diferente, pruebe el parámetro MODEL_URL como:

kurtosis run github.com/kurtosis-tech/autogpt-package ' {"GPT_4ALL": true, "MODEL_URL": "https://gpt4all.io/models/ggml-gpt4all-l13b-snoozy.bin"} ' Para desarrollar este paquete, clone este repositorio y ejecute lo siguiente:

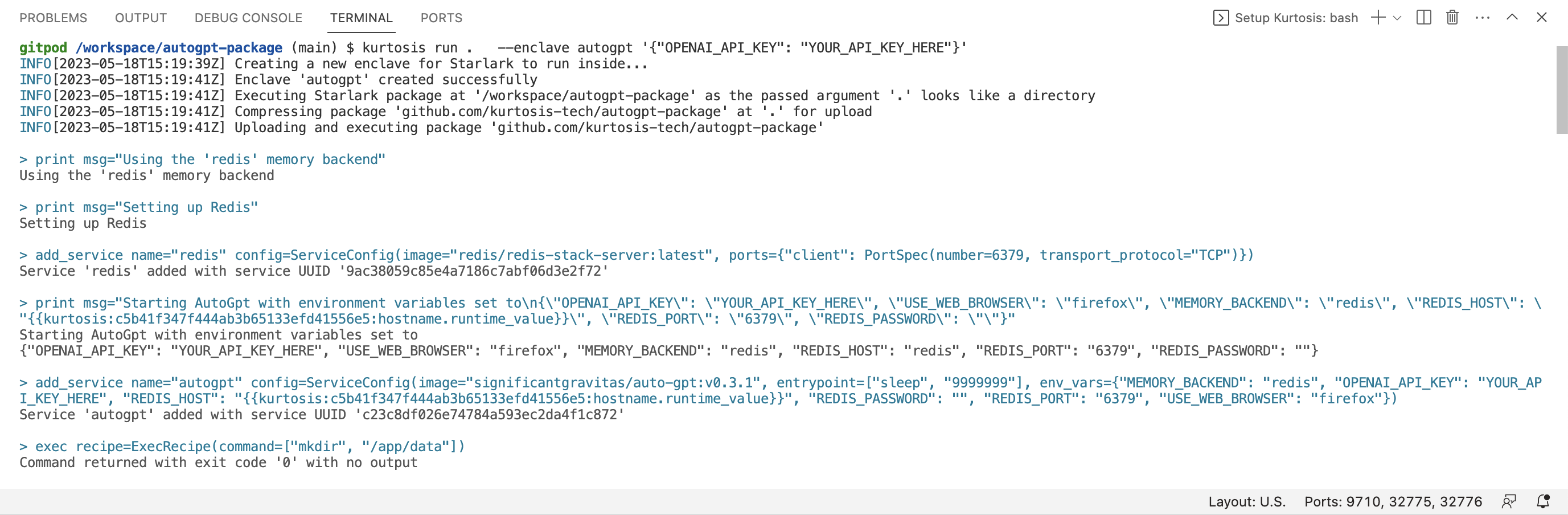

kurtosis run . --enclave autogpt ' {"OPENAI_API_KEY": "YOUR_API_KEY_HERE"} ' Tenga en cuenta el . - esto le dice a Kurtosis que use la versión del paquete en su máquina local (en lugar de la versión en Github).

Kurtosis también tiene una extensión disponible en el mercado VSCode que proporciona resaltado de sintaxis y autocompletado para Starlark del que se compone este paquete.

¡Háganos saber en nuestro Discord o en Twitter @KurtosisTech!

No dudes en crear un problema en GitHub si tienes algún error o solicitud de función.