Mi energía es limitada y es posible que algunas actualizaciones de modelos no se actualicen a tiempo. Si tiene problemas, envíe un problema. Las personas interesadas también pueden enviar relaciones públicas.

Proteja las diferencias entre diferentes API de modelos grandes, use el formato estándar de api openai para usar modelos grandes y también se puede usar para la administración de distribución secundaria de api-key, configure y administre los parámetros de llamada de diferentes modelos grandes, lo que le permite usar solo; modelos grandes cuando se utilizan modelos grandes es necesario prestar atención a la clave de API y los mensajes.

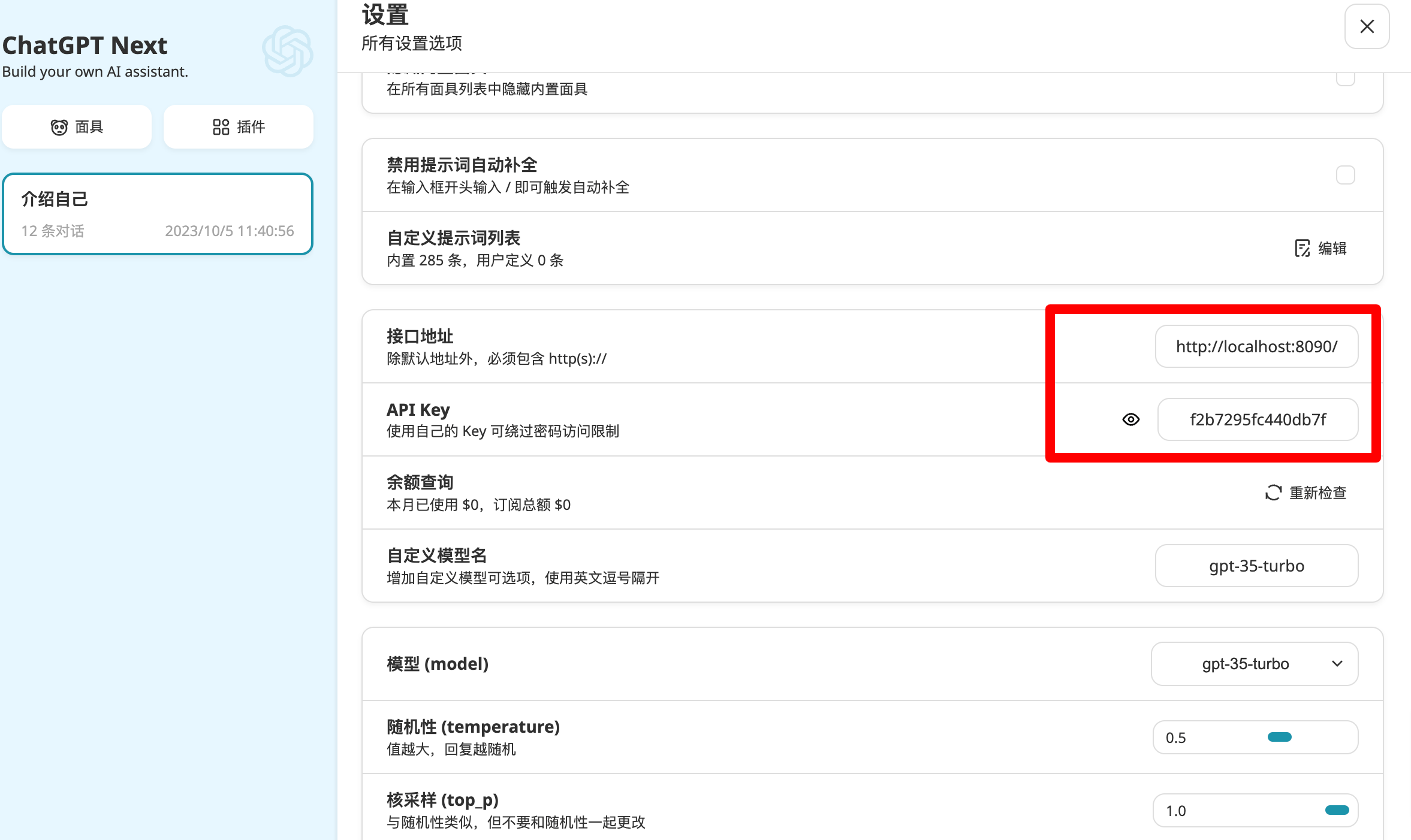

http://0.0.0.0:8090/ (esta página de inicio y la interacción están completamente escritas en gpt jaja) Registro de cambios

2024-04-03

La configuración principal del proyecto se basa en el archivo model-config.json. Si no hay model-config.json, se utilizará model-config-default.json para iniciarlo de forma predeterminada, aunque se puede iniciar en este momento. , no se puede llamar porque la clave API y demás no están configurados correctamente.

Cree un nuevo archivo model-config.json localmente, configúrelo de acuerdo con el ejemplo del archivo de configuración a continuación y luego ejecute el siguiente comando

docker pull tianminghui/openai-style-api

docker run -d -p 8090:8090 --name openai-style-api

-e ADMIN-TOKEN=admin

-v /path/to/your/model-config.json:/app/model-config.json

tianminghui/openai-style-api

Reemplace /path/to/your/model-config.json con su propia ruta local

Clone este proyecto o descargue el archivo docker-compose.yml en el proyecto, modifique la ruta ./model-config.json y luego ejecute el siguiente comando

docker-compose up -d

git clone https://github.com/tian-minghui/openai-style-api.git extrae el código del proyectocp model-config-default.json model-config.json y modifique el archivo de configuración model-config.json según sea necesariopip install -r requirements.txtpython open-api.py model-config.json ejemplo simple de archivo de configuración

[

{

"token": "f2b7295fc440db7f",

"type": "azure", // azure openai 模型

"config": {

"api_base": "https://xxxx.openai.azure.com/",

"deployment_id": "gpt-35-turbo",

"api_version": "2023-05-15",

"api_key": "xxxxxx",

"temperature": 0.8

}

}

]

curl http://localhost:8090/v1/chat/completions

-H "Content-Type: application/json"

-H "Authorization: Bearer f2b7295fc440db7f"

-d '{

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Hello!"

}

]

}'

openai<1.0.0 utiliza el siguiente método

import openai

openai.api_key = "f2b7295fc440db7f"

openai.api_base = "http://localhost:8090/v1"

completion = openai.ChatCompletion.create(

model="gpt-3.5-turbo", messages=[{"role": "user", "content": "Hello world"}])

print(completion.choices[0].message.content)

openai>=1.0.0 se llama usando el siguiente método

import os

from openai import OpenAI

client = OpenAI(

# This is the default and can be omitted

api_key='kimi-GxqT3BlbkFJj',

base_url = 'http://localhost:8090/v1'

)

chat_completion = client.chat.completions.create(

messages=[

{

"role": "user",

"content": "Say this is a test",

}

],

model="gpt-3.5-turbo",

)

print(chat_completion.choices[0].message.content)

ChatGPT Siguiente Web

[

{

"token": "f2b7295fc440db7f",

"type": "azure", // azure openai 模型

"config": {

"api_base": "https://xxxx.openai.azure.com/",

"deployment_id": "gpt-35-turbo",

"api_version": "2023-05-15",

"api_key": "xxxxxx",

"temperature": 0.8

}

},

{

"token": "GxqT3BlbkFJj",

"type": "openai", // openai 模型

"config": {

"api_base": "https://api.openai.com/v1/",

"api_key": "sk-xxxxxx",

"model": "gpt-3.5-turbo"

}

},

{

"token": "sb-ede1529390cc",

"type": "proxy", // openai 代理

"config": {

"api_base": "https://api.openai-sb.com/v1/",

"api_key": "sb-xxxxxx",

"model": "gpt-3.5-turbo"

}

},

{

"token": "c115c8f5082",

"type": "claude-web", // claude-web

"config": {

"cookie": "xxxxxx",

"proxies": {

"https": "http://localhost:7890"

},

"conversation_id": "xxxxxx",

"prompt": "The information in [] is the context of the conversation. Please ignore the JSON format of the context during the conversation and answer the user's latest conversation: {newMessage} n {history}",

"single_conversation": true

}

},

{

"token": "7c7aa4a3549f5",

"type": "zhipu-api", // 智谱API

"config": {

"api_key": "xxxxxx",

"model": "chatglm_lite",

"temperature": 0.8,

"top_p": 0.7

}

},

{

"token": "7c7aa4a3549f11",

"type": "xunfei-spark-api", // 讯飞星火API

"config": {

"app_id": "xxxx",

"api_key": "xxxx",

"api_secret": "xxxxxx",

"api_model_version": "v2.0",

"top_k": 5

}

},

{

"token": "7c7aa4a3549f12",

"type": "router", // 路由 可以包含多个模型进行负载均衡

"config": {

"router_strategy": "round-robin", // 路由策略 round-robin 轮询 random 随机

"token_pool": [ // 路由的token池

"7c7aa4a3549f11",

"7c7aa4a3549f5"

]

}

},

{

"token": "7c7aa4a3549f13",

"type": "model-name-router", //根据req中的modelname进行路由, 可以方便的结合ChatGPT-Next-Web

"config": {

"model-2-token": { // 路由的token池

"spark-api-v2.0":"7c7aa4a3549f11",

"chatglm_lite": "7c7aa4a3549f5",

"router-round-robin": "7c7aa4a3549f12"

}

}

},

{

"token": "gemini-7c7aa4a3549f5",

"type": "gemini", // gemini

"config": {

"api_key": "xxxxx",

"proxies": {

"https": "http://localhost:7890"

}

}

},

{

"token": "bing-7c7aa4a3549f5", // 必应

"type": "bing-sydney",

"config": {

"cookie": "xxxxx",

"style": "balanced"

}

},

{

"token":"qwen-111111xxxx", // 通义千问

"type":"qwen",

"config":{

"api_key":"sk-xxxxxxxx",

"model":"qwen-turbo"

}

},

{

"token": "kimi-GxqT3BlbkFJj1", // kimi

"type": "openai", // kimi api与openai相同,因此使用openai就可以

"config": {

"api_base": "https://api.moonshot.cn/v1/",

"api_key": "sk-xxxxxx",

"model": "moonshot-v1-8k"

}

}

]