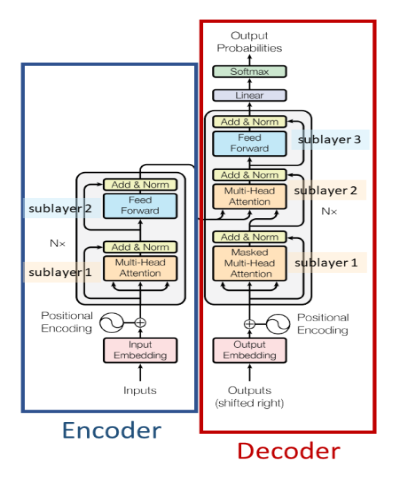

Una arquitectura codificador-decodificador basada en autoatención. Se utiliza principalmente para

Documento: https://arxiv.org/abs/1706.03762

Una arquitectura de codificador basada en la autoatención. Se utiliza principalmente para

Documento: https://arxiv.org/abs/1810.04805

Un modelo autorregresivo basado en decodificador basado en autoatención. Se utiliza principalmente para

Documento: https://paperswithcode.com/method/gpt

Un modelo autorregresivo basado en decodificador basado en autoatención con un ligero cambio en la arquitectura y entrenado en un corpus de texto más grande que GPT-1. Se utiliza principalmente para

Documento: https://d4mucfpksywv.cloudfront.net/better-language-models/language-models.pdf

Una arquitectura de codificador basada en autoatención de última generación para aplicaciones de visión por computadora. Se utiliza principalmente para

Documento: https://arxiv.org/abs/2006.03677

Una arquitectura de codificador-decodificador basada en autoatención con una complejidad de tiempo lineal distinta del transformador que tiene una complejidad de tiempo cuadrática. Se utiliza mayoritariamente

Documento: https://arxiv.org/abs/2009.14794