Aportamos datos visuales realistas y diversos, desde modelos generativos hasta simuladores de física clásica, lo que permite a los robots aprender tareas altamente dinámicas como el parkour sin necesidad de profundidad.

lucidsim contiene nuestros entornos simulados creados con MuJoCo. Proporcionamos los entornos y las herramientas para ejecutar el canal de renderizado LucidSim para parkour cuadrúpedo. El código de entrenamiento aún no está incluido.

Si está buscando el código de aumento generativo (requerido para ejecutar el proceso de renderizado completo), ¡consulte el repositorio de Weaver!

Alan Yu *1 , Ge Yang *1,2 , Ran Choi 1 , Yajvan Ravan 1 , John Leonard 1 , Phillip Isola 1

1 MIT CSAIL, 2 Instituto de IA e Interacciones Fundamentales (IAIFI)

* Indica contribución igual

CORL 2024

|  |

Tabla de contenido

Si siguió las instrucciones de configuración de weaver , no dude en instalarlo encima de ese entorno.

conda create -n lucidsim python=3.10

conda activate lucidsim # Choose the CUDA version that your GPU supports. We will use CUDA 12.1

pip install torch==2.1.2 torchvision==0.16.2 torchaudio==2.1.2 --extra-index-url https://download.pytorch.org/whl/cu121

# Install lucidsim with more dependencies

git clone https://github.com/lucidsim/lucidsim

cd lucidsim

pip install -e . Las últimas dependencias requieren setuptools degradadas y wheel para instalarse. Para instalar, baje la versión y revierta después.

pip install setuptools==65.5.0 wheel==0.38.4 pip==23

pip install gym==0.21.0

pip install gym-dmc==0.2.9

pip install -U setuptools wheel pip Nota: En Linux, asegúrese de configurar la variable de entorno MUJOCO_GL=egl .

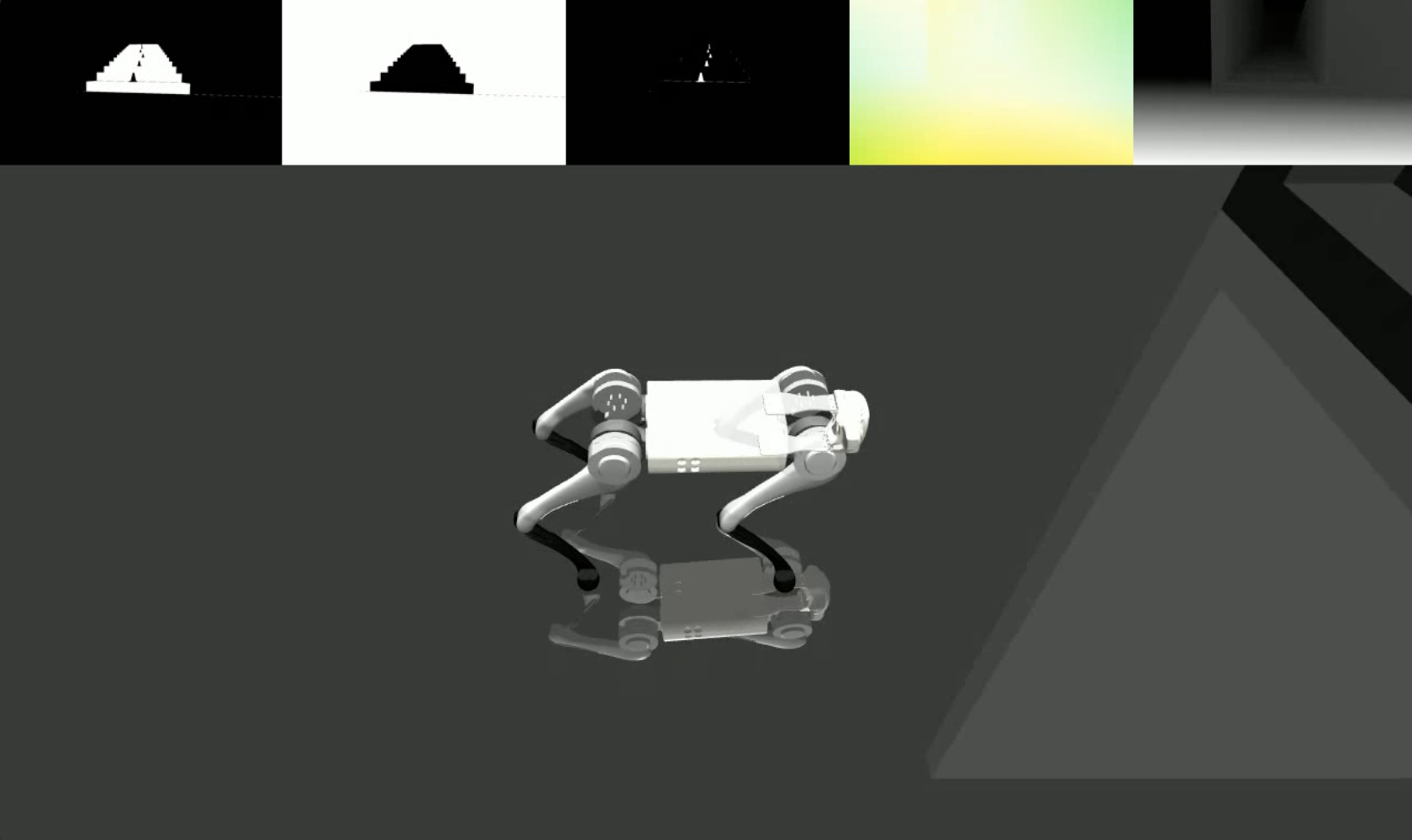

LucidSim genera imágenes fotorrealistas mediante el uso de un modelo generativo para aumentar la representación del simulador, utilizando imágenes condicionantes para mantener el control sobre la geometría de la escena.

Hemos proporcionado un punto de control de políticas experto en checkpoints/expert.pt . Esta política se derivó de la del Extreme Parkour. Puede utilizar esta política para muestrear un entorno y visualizar las imágenes de acondicionamiento con:

# env-name: one of ['parkour', 'hurdle', 'gaps', 'stairs_v1', 'stairs_v2']

python play.py --save-path [--env-name] [--num-steps] [--seed] donde save_path es donde guardar el vídeo resultante.

Para ejecutar el proceso de aumento generativo completo, deberá instalar el paquete weaver desde aquí. Cuando termine, asegúrese también de que las variables de entorno aún estén configuradas correctamente:

COMFYUI_CONFIG_PATH=/path/to/extra_model_paths.yaml

PYTHONPATH=/path/to/ComfyUI: $PYTHONPATHLuego puede ejecutar el proceso completo con:

python play_three_mask_workflow.py --save-path --prompt-collection [--env-name] [--num-steps] [--seed] donde save_path y env_name son los mismos que antes. prompt_collection debe ser una ruta a un archivo .jsonl con indicaciones formateadas correctamente, como en la carpeta weaver/examples .

Agradecemos a los autores de Extreme Parkour por su código base de código abierto, que utilizamos como punto de partida para nuestra política de expertos ( lucidsim.model ).

Si encuentra útil nuestro trabajo, considere citar:

@inproceedings{yu2024learning,

title={Learning Visual Parkour from Generated Images},

author={Alan Yu and Ge Yang and Ran Choi and Yajvan Ravan and John Leonard and Phillip Isola},

booktitle={8th Annual Conference on Robot Learning},

year={2024},

}