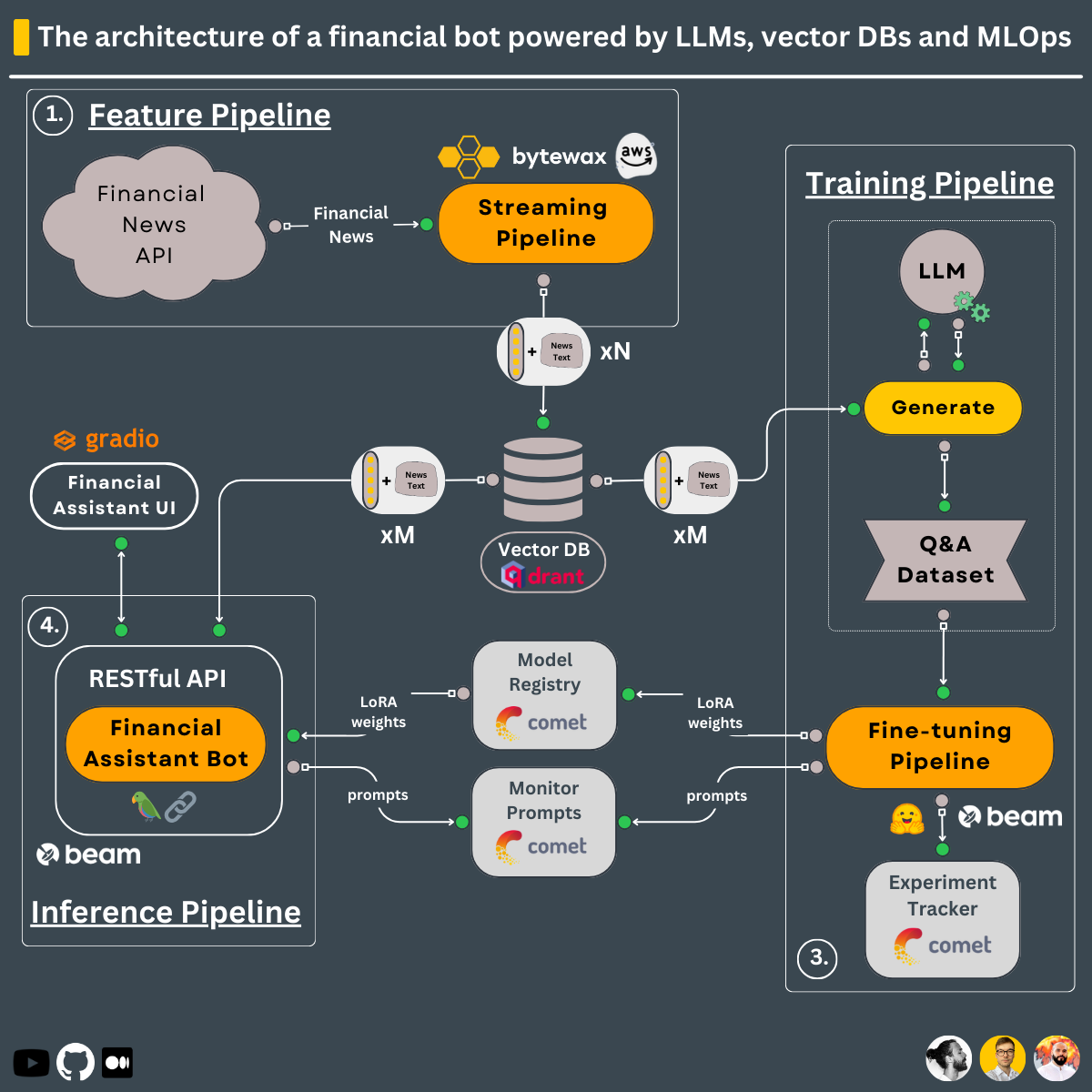

Usando el diseño de 3 tuberías, esto es lo que aprenderá a construir en este curso ↓

Canal de capacitación que:

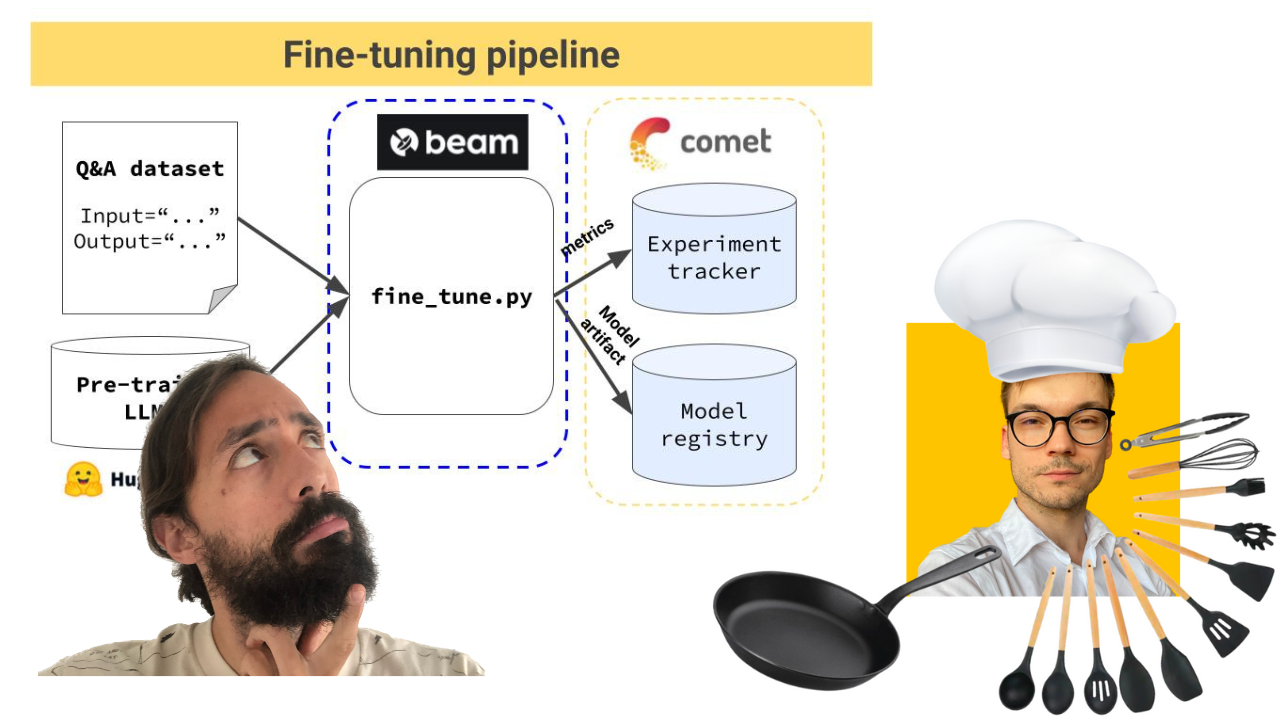

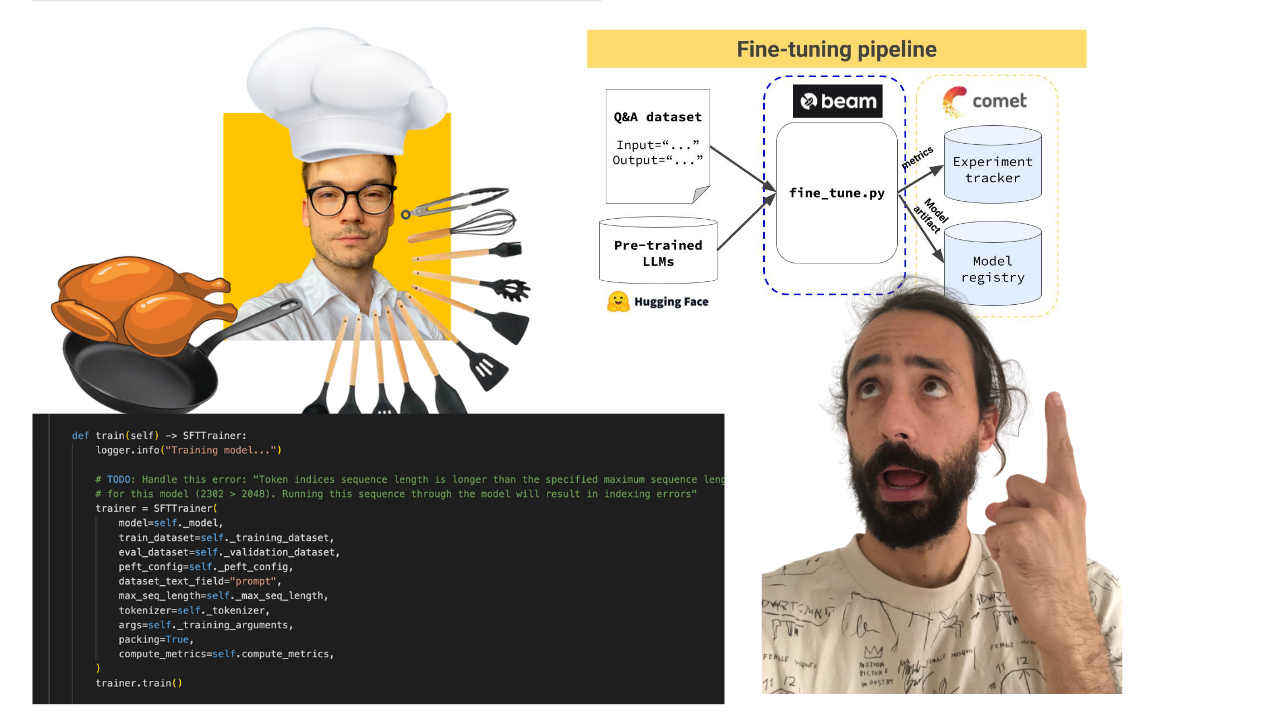

El proceso de capacitación se implementa utilizando Beam como infraestructura de GPU sin servidor.

-> Se encuentra en el directorio modules/training_pipeline .

Nota: No te preocupes si no tienes los requisitos mínimos de hardware. Le mostraremos cómo implementar el proceso de capacitación en la infraestructura sin servidor de Beam y capacitar al LLM allí.

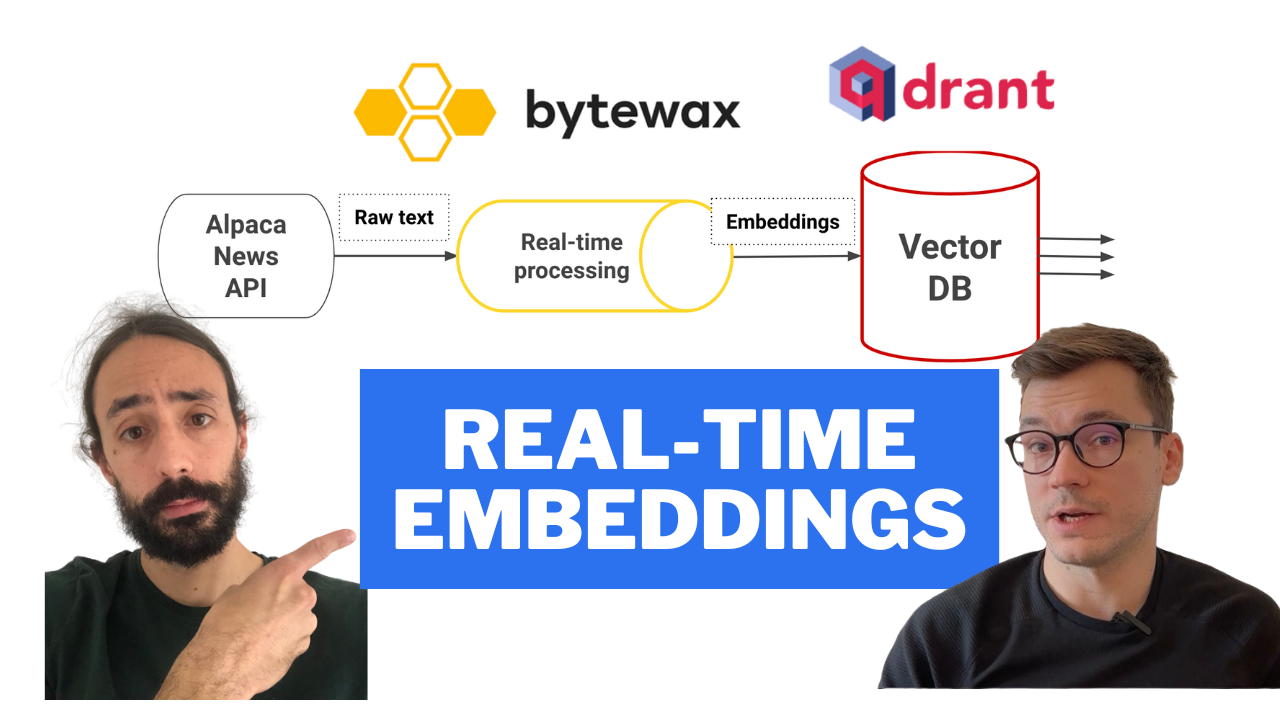

Canalización de funciones en tiempo real que:

La canalización de streaming se implementa automáticamente en una máquina AWS EC2 mediante una canalización de CI/CD integrada en acciones de GitHub.

-> Se encuentra en el directorio modules/streaming_pipeline .

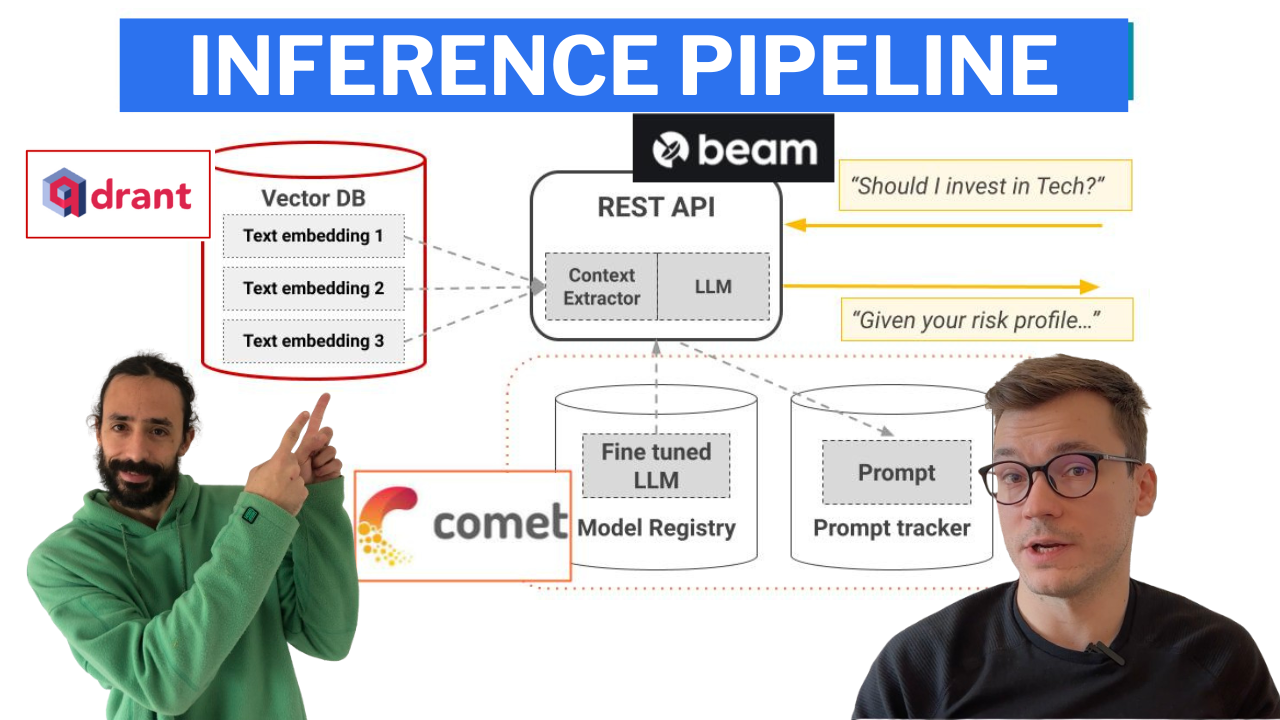

Canal de inferencia que utiliza LangChain para crear una cadena que:

El canal de inferencia se implementa utilizando Beam como infraestructura de GPU sin servidor, como API RESTful. Además, está incluido en una interfaz de usuario con fines de demostración, implementada en Gradio.

-> Se encuentra en el directorio modules/financial_bot .

Nota: No te preocupes si no tienes los requisitos mínimos de hardware. Le mostraremos cómo implementar el canal de inferencia en la infraestructura sin servidor de Beam y llamar al LLM desde allí.

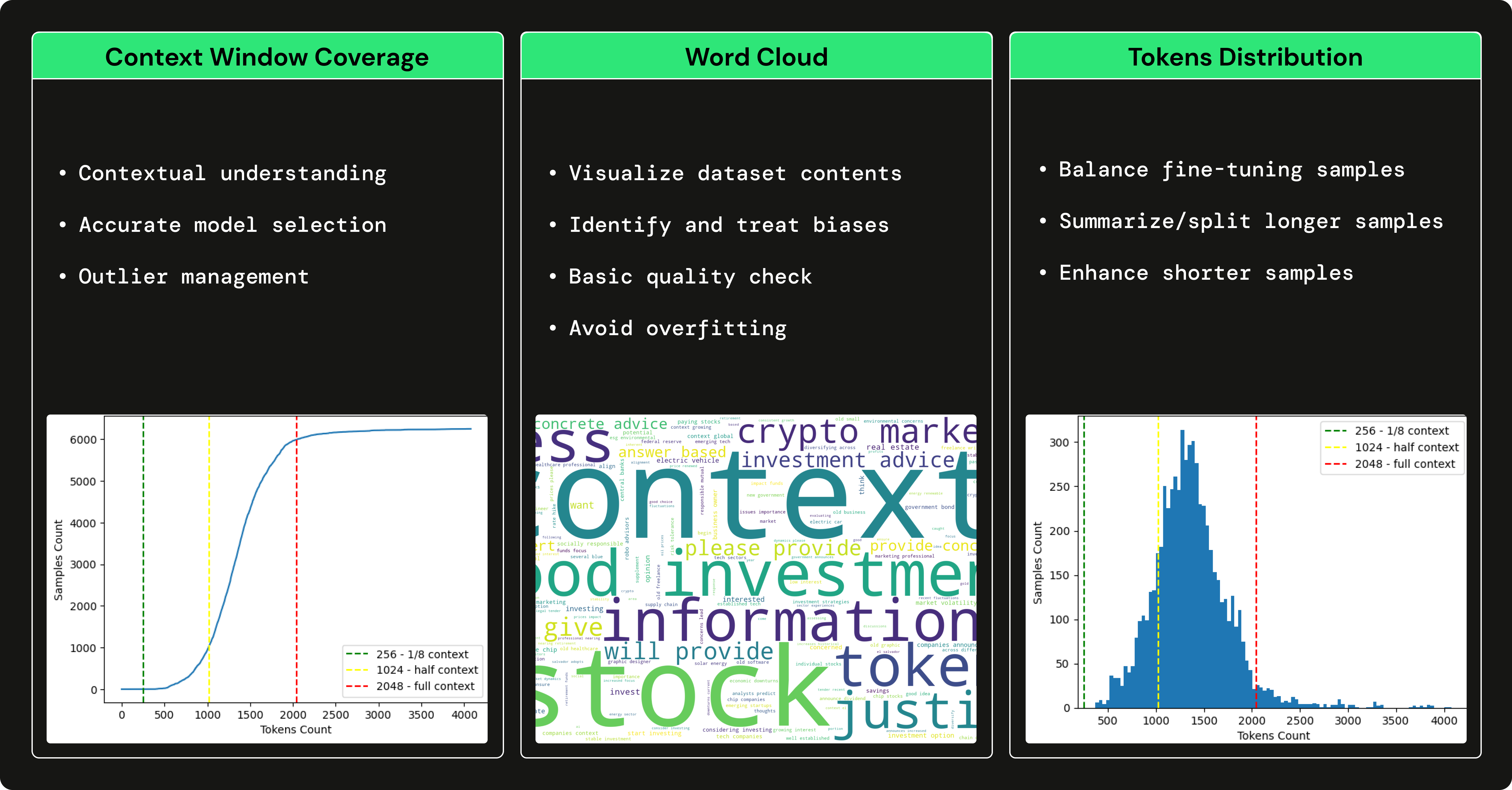

Usamos GPT3.5 para generar un conjunto de datos de preguntas y respuestas financieras para ajustar nuestro LLM de código abierto para especializarnos en el uso de términos financieros y responder preguntas financieras. El uso de un LLM grande, como GPT3.5 para generar un conjunto de datos que entrene un LLM más pequeño (por ejemplo, Falcon 7B) se conoce como ajuste fino con destilación .

→ Para comprender cómo generamos el conjunto de datos de preguntas y respuestas financieras, consulte este artículo escrito por Pau Labarta.

→ Para ver un análisis completo del conjunto de datos de preguntas y respuestas financieras, consulte la subsección dataset_analysis del curso escrito por Alexandru Razvant.

Antes de sumergirse en los módulos, debe configurar un par de herramientas externas adicionales para el curso.

NOTA: Puede configurarlos sobre la marcha para cada módulo, ya que le indicaremos en cada módulo lo que necesita.

financial news data source

Siga este documento para mostrarle cómo crear una cuenta GRATUITA y generar las claves API que necesitará en este curso.

Nota: 1x conexión de datos de Alpaca es GRATIS.

serverless vector DB

Vaya a Qdrant y cree una cuenta GRATIS.

Luego, siga este documento sobre cómo generar las claves API que necesitará en este curso.

Nota: Utilizaremos únicamente el plan freemium de Qdrant.

serverless ML platform

Vaya a Comet ML y cree una cuenta GRATIS.

Luego, sigue esta guía para generar una CLAVE API y un nuevo proyecto, que necesitarás dentro del curso.

Nota: Utilizaremos únicamente el plan freemium de Comet ML.

serverless GPU compute | training & inference pipelines

Vaya a Beam y cree una cuenta GRATIS.

Luego, debe seguir su guía de instalación para instalar su CLI y configurarla con sus credenciales de Beam.

Para leer más sobre Beam, aquí hay una guía de introducción.

Nota: Tienes aproximadamente 10 horas de computación gratuitas. Después, pagas sólo por lo que usas. Si tiene una GPU Nvidia >8 GB de VRAM y no desea implementar los canales de entrenamiento e inferencia, usar Beam es opcional.

Al usar Poetry, tuvimos problemas para ubicar la CLI de Beam dentro de un entorno virtual de Poetry. Para solucionar este problema, después de instalar Beam, creamos un enlace simbólico que apunta a los archivos binarios de Poetry, de la siguiente manera:

export COURSE_MODULE_PATH= < your-course-module-path > # e.g., modules/training_pipeline

cd $COURSE_MODULE_PATH

export POETRY_ENV_PATH= $( dirname $( dirname $( poetry run which python ) ) )

ln -s /usr/local/bin/beam ${POETRY_ENV_PATH} /bin/beam cloud compute | feature pipeline

Vaya a AWS, cree una cuenta y genere un par de credenciales.

Luego, descargue e instale su AWS CLI v2.11.22 y configúrelo con sus credenciales.

Nota: Pagarás sólo por lo que uses. Implementará solo una máquina virtual EC2 t2.small , que cuesta solo ~$0.023 por hora. Si no desea implementar la canalización de funciones, utilizar AWS es opcional.

Cada módulo tiene sus dependencias y scripts. En una configuración de producción, cada módulo tendría su repositorio, pero en este caso de uso, con fines de aprendizaje, ponemos todo en un solo lugar:

Por lo tanto, consulte el archivo README de cada módulo individualmente para ver cómo instalarlo y usarlo:

Le recomendamos encarecidamente que clone este repositorio y replique todo lo que hemos hecho para aprovechar al máximo este curso.

En las videoconferencias, artículos y documentación README de cada módulo, encontrará instrucciones paso a paso.

¡Feliz aprendizaje!

El código GitHub (publicado bajo la licencia MIT) y las videoconferencias (publicadas en YouTube) son totalmente gratuitos. Siempre lo será.

Las lecciones de Medium se publican en el muro pago de Medium. Si ya lo tienes, entonces son gratis. De lo contrario, deberá pagar una tarifa mensual de $5 para leer los artículos.

Si tienes alguna duda o problema durante el curso, te animamos a crear un número en este repositorio donde puedas explicar todo lo que necesitas en profundidad.

De lo contrario, también puedes contactar con los profesores en LinkedIn:

Haga clic aquí para ver el vídeo ?

Haga clic aquí para ver el vídeo ?

Haga clic aquí para ver el vídeo ?

Haga clic aquí para ver el vídeo ?

Haga clic aquí para ver el vídeo ?

To understand the entire code step-by-step, check out our articles ↓

Este curso es un proyecto de código abierto publicado bajo la licencia MIT. Por lo tanto, siempre que distribuya nuestra LICENCIA y reconozca nuestro trabajo, puede clonar o bifurcar este proyecto de manera segura y usarlo como fuente de inspiración para lo que desee (por ejemplo, proyectos universitarios, proyectos de títulos universitarios, etc.).

| Pau Labarta Bajo | Ingeniero sénior de ML y MLOps Profesor principal. El chico de las lecciones en video. Gorjeo/X YouTube Boletín de aprendizaje automático del mundo real Sitio de aprendizaje automático del mundo real |

| Alexandru Razvant | Ingeniero sénior de aprendizaje automático Segundo cocinero. El ingeniero detrás de escena. Neura salta |

| Pablo Iusztin | Ingeniero sénior de ML y MLOps Cocinero principal. Los chicos que aparecen aleatoriamente en las lecciones en video. Gorjeo/X Boletín Decodificación de ML Sitio personal | Centro de aprendizaje automático y operaciones mlops |