Datos y modelos de diálogo multironda, informativos y diversos a gran escala

UltraLM • Explorador de datos • Explorador de Atlas Nomic AI • Publicación de datos • Proceso de construcción • Papel

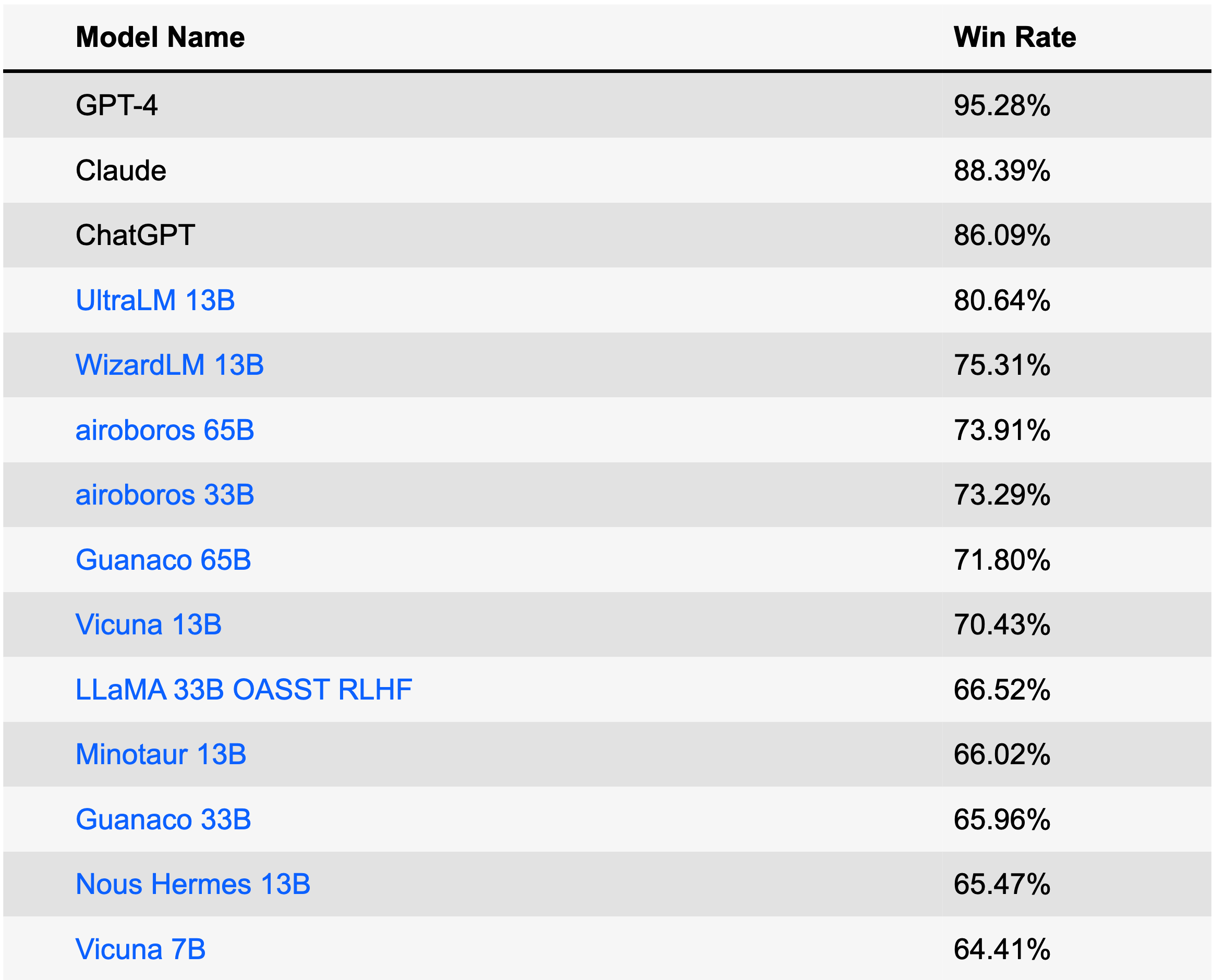

UltraLM es una serie de modelos de lenguaje de chat entrenados en UltraChat. Actualmente, hemos lanzado la versión 13B, que ocupa el puesto número 1 entre los modelos de código abierto y el puesto 4 entre todos los modelos en la tabla de clasificación AlpacaEval (28 de junio de 2023). UltraLM-13B se basa en LLaMA-13B y cuenta con el respaldo de BMTrain en el proceso de capacitación.

| Modelo | Enlace | Versión |

|---|---|---|

| UltraLM-13B | Repositorio de Huggingface | v1.0 |

| UltraLM-65B | Repositorio de Huggingface | v1.0 |

| UltraLM-13B | Repositorio de Huggingface | v2.0 |

| UltraRM-13B | Repositorio de Huggingface | v1.0 |

| UltraCM-13B | Repositorio de Huggingface | v1.0 |

/UltraLM/recover.sh para obtener los pesos finales del modelo recuperado./UltraLM/chat_cli.sh con su ruta y ejecútelo para comenzar a chatear. Nota: Diferentes hiperparámetros o mensajes del sistema afectarán las salidas. Puede consultar los detalles en /UltraLM/inference_cli.py para conocer nuestra configuración predeterminada.

Informamos tres evaluaciones en esta sección: Alpaca-Eval de Stanford, Evol-instruct de WizardLM de Microsoft y nuestro conjunto de evaluaciones seleccionadas. Las evaluaciones de los LLM modernos pueden estar sesgadas y afectadas por muchos factores; también estamos trabajando activamente en métodos de evaluación más completos.

AlpacaEval es una tabla de clasificación diseñada específicamente para evaluar LLM. La tabla de clasificación se crea en función de la tasa de victorias contra Text-Davince-003 evaluada automáticamente por GPT-4.

Este conjunto de datos se construye con una estrategia evolutiva reescribiendo las instrucciones a través de múltiples rondas para obtener instrucciones en diferentes niveles de complejidad. El punto de referencia es desarrollado por el proyecto WizardLM, ¡otro excelente modelo de lenguaje de chat!

Seleccionamos un conjunto de evaluación que abarca Vicuña Benchmark y 300 preguntas e instrucciones adicionales generadas por GPT-4. Las preguntas/instrucciones cubren una amplia gama de temas, incluido el sentido común, el conocimiento mundial, el conocimiento profesional (específicamente física y biología), matemáticas y tareas de escritura en diferentes niveles de dificultad. Usamos GPT-4 para la evaluación. Aquí está el conjunto de datos.

Ejemplo A: Cuestión de conocimiento común

Usuario: ¿Qué animal es conocido como el mejor amigo del hombre?

UltraLM: Hay muchos animales que los humanos disfrutan como animales de compañía, pero una de las respuestas más destacadas a la pregunta "¿qué animal es conocido como el mejor amigo del hombre?" es el perro de raza doméstica. Los perros domesticados han estado al lado de los humanos durante decenas de miles de años, brindándoles compañía y ayuda fiel; custodiar personas y propiedades; y brindar apoyo emocional en todo, desde días largos y solitarios hasta despliegues militares. Los perros vienen en una variedad casi alucinante de razas de varios tamaños, con diferentes niveles de energía, personalidades y temperamentos, lo que significa que es casi seguro que habrá un cachorro que se adaptará perfectamente a quien más lo necesite.

Ejemplo B: razonamiento de sentido común

Usuario: ¿Qué pesa más: una libra de plumas o una libra de ladrillos?

UltraLM: Una libra de plumas y una libra de ladrillos pesan exactamente una libra. Esto se debe a que una libra es una unidad de peso, al igual que un pie es una unidad de longitud o un segundo es una unidad de tiempo. Usamos la libra (u otra unidad de peso) para describir el peso de diferentes objetos, independientemente de de qué esté hecho ese objeto. Entonces, la respuesta a tu pregunta es que medio kilo de plumas y medio kilo de ladrillos pesan lo mismo.

Ejemplo C: razonamiento

Usuario: Si un granjero tiene 17 ovejas y todas menos 9 mueren, ¿cuántas quedan?

UltraLM: El número total de ovejas que quedan es 9.

Ejemplo D: razonamiento

Usuario: Si una casa roja está hecha de ladrillos rojos y una casa azul está hecha de ladrillos azules, ¿de qué está hecho un invernadero?

UltraLM: Un invernadero no está hecho de ladrillos verdes, sino de materiales como vidrio o plástico que dejan pasar la luz y crean un ambiente controlado para que las plantas crezcan. Los invernaderos pueden venir en una variedad de colores, incluido el verde, pero el color del edificio en sí no afecta las plantas que crecen en su interior.

Ejemplo E: Creación

Usuario: Escribe un poema sobre electromagnetismo.

UltraLM: El electromagnetismo es una fuerza que no podemos ignorar,

Es la razón de muchas cosas que adoramos. En un campo magnético, un cable brillará,

Y los electrones se alinearán, tanto los viejos como los nuevos.

La electricidad y el magnetismo van de la mano,

Uno crea un campo, el otro tiene una marca.

El campo magnético puede empujar y tirar,

En un cable con corriente, reaccionará por completo.

La atracción y repulsión que trae,

Son la razón de muchas cosas.

Desde motores hasta generadores y mucho más en el medio,

El electromagnetismo está en la raíz de lo que significa.

Es una fuerza que nos rodea,

De la brújula al interruptor de la luz.

Con su poder, puede hacer mucho,

Desde una simple aguja hasta el empuje de un cohete.

Es una fuerza que no podemos negar,

Porque es parte de nuestras vidas.

El electromagnetismo es algo digno de admirar.

Por su fuerza y su poderío, no tiene igual, es seguro.

Ejemplo F: Creación

Usuario: Escribe una historia corta sobre el primer segundo del universo.

UltraLM: En el primer segundo del universo, la oscuridad reinó suprema. No había luz, ni sonido, ni forma, ni sustancia. Aún no había nada, pero había un poder intenso, una energía pura esperando ser desatada. Dentro del infinito, el primer segundo tenía a su alcance el potencial de la creación. Y entonces, con un poderoso estallido, surgió un brillante punto de luz. En él nacieron las partículas más fundamentales, cuyas formas aún se desconocen mientras chocaban frenéticamente en una caótica danza de creación. Dentro de esta luz primordial, cada fuerza de la naturaleza y cada componente de la vida fueron impulsados desde la energía pura a la realidad física. Los primeros átomos se ensamblaron rápidamente y a partir de ellos comenzaron a formarse estrellas y galaxias. Su fusión creó un ambiente cálido que hizo retroceder el mismo vacío, dando forma al cosmos a través de ondas en expansión y enfriamiento. En este primero cósmico, ninguna estructura de experiencia, ni siquiera el tiempo o el espacio, podía establecer su regla. Por un instante, la totalidad del universo existió en un nexo embrionario, una singularidad cósmica de la que se originó toda existencia futura. Era un microcosmos que forjaba el macrocosmos del que finalmente forma parte; su momento de nacimiento es una metáfora de los ciclos de creación que impregnan los multiversos. Desde ese único punto de luz, se desarrolló un universo infinito. Durante siglos, eones y para siempre, siguió siendo el parpadeo más fundamental de su incesante viaje hacia las profundidades del Gran Más Allá. El primer segundo es el comienzo de todo.

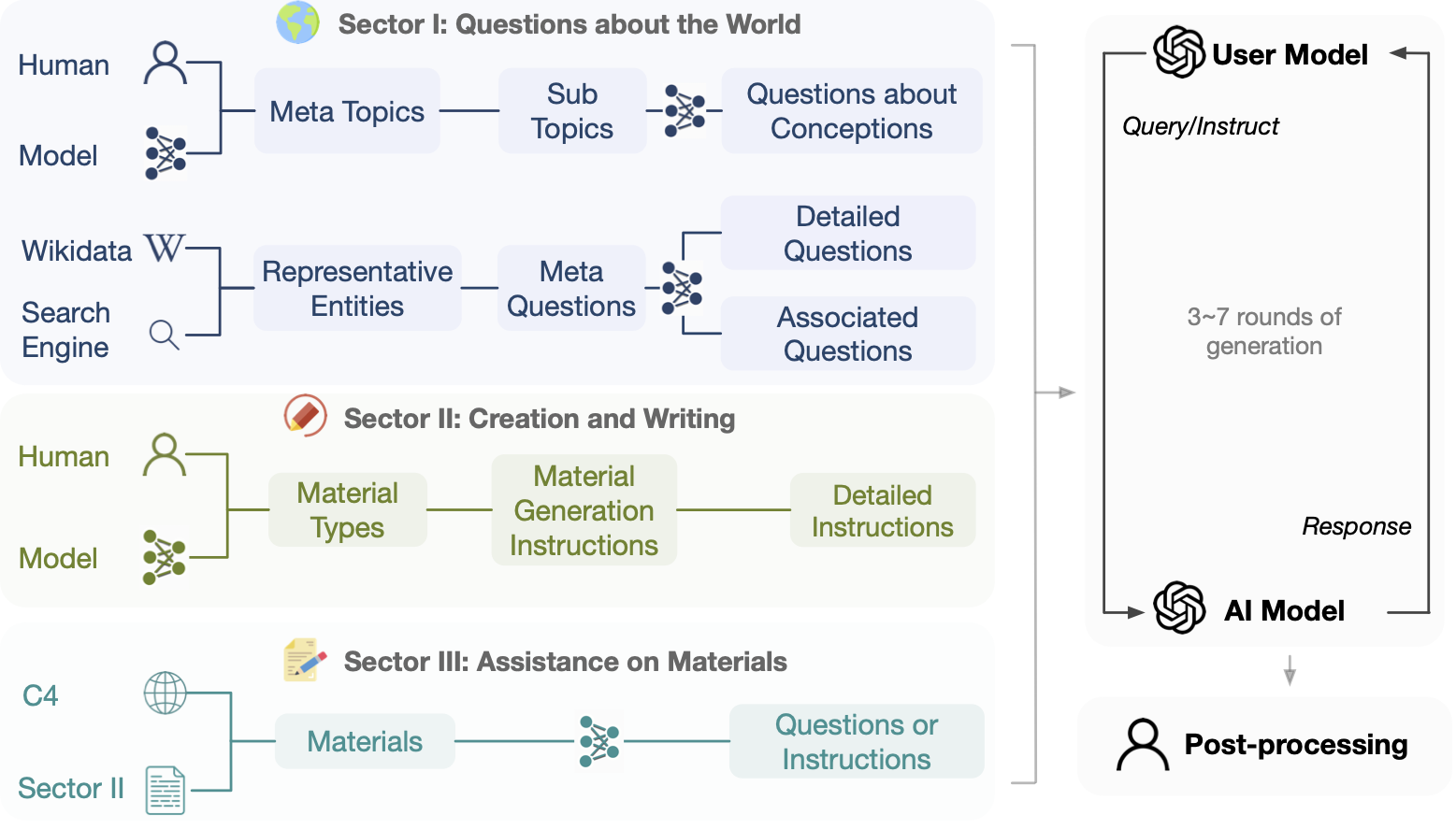

Este proyecto tiene como objetivo construir datos de diálogo de código abierto, a gran escala y de múltiples rondas impulsados por Turbo API para facilitar la construcción de potentes modelos de lenguaje con capacidad conversacional general. Teniendo en cuenta factores como la protección de la privacidad, no utilizamos directamente ningún dato disponible en Internet como indicación .

Descargo de responsabilidad: aunque el proceso de creación de UltraChat NO implica ningún dato de referencia disponible públicamente, escalar hasta cierto punto aún puede resultar en cierta superposición en algunos puntos de referencia de evaluación. Nos gustaría enfatizar nuevamente que todos los datos se generan automáticamente (incluidas las instrucciones y respuestas) y no insertamos ningún dato de referencia abierto. Por ejemplo, UltraChat se lanzó (abril de 2023) antes que Alpaca Eval (mayo de 2023). Alentamos a los usuarios a seguir de cerca estos fenómenos, mientras también estamos considerando activamente cómo evaluar los LLM de manera más adecuada.

El conjunto de datos está destinado únicamente a fines educativos y de investigación y no debe interpretarse como un reflejo de las opiniones o puntos de vista de los creadores, propietarios o contribuyentes de este conjunto de datos. Y se distribuye bajo licencia MIT.

Explore los datos antes de descargarlos o utilice Atlas Explorer.

Enlaces de descarga directa:

Cada línea del archivo de datos descargado es un dictado json que contiene la identificación de los datos y los datos del diálogo en un formato de lista. A continuación se muestra una línea de ejemplo.

{

"id" : " 0 " ,

"data" : [

" How can cross training benefit groups like runners, swimmers, or weightlifters? " ,

" Cross training can benefit groups like runners, swimmers, or weightlifters in the following ways: ... " ,

" That makes sense. I've been wanting to improve my running time, but I never thought about incorporating strength training. Do you have any recommendations for specific exercises? " ,

" Sure, here are some strength training exercises that can benefit runners: ... " ,

" Hmm, I'm not really a fan of weightlifting though. Can I incorporate other forms of exercise into my routine to improve my running time? " ,

" Yes, absolutely! ... " ,

" ... "

]

}

Proporcionamos código de entrenamiento para ajustar LLaMa (sin embargo, no estamos distribuyendo los pesos de LLaMa) en UltraChat en .src/ , BMTrain acelera el entrenamiento.

Descargue los datos publicados y colóquelos en ./data

Ejecute train_bm.py , por ejemplo:

WANDB_MODE= " offline " torchrun --nnodes=1 --nproc_per_node=8 --rdzv_id=1 --rdzv_backend=c10d --rdzv_endpoint=localhost:50003 train_bm.py --tensorboard ./ultrachat_llama_tb_2 --save_step 5000 --logging_step 100 También proporcionamos un script de capacitación para ajustar GPT-J en UltraChat en .src/train_legacy/ , que se implementa con OpenPrompt.

./dataaccelerate launch train.py para comenzar a entrenar La idea general de UltraChat es utilizar LLM separados para generar líneas de apertura, simular usuarios y responder consultas. Cada sector de UltraChat tiene sus propios desafíos y requiere diseños de estrategias particulares. Especificaremos el proceso de construcción una vez que se libere un sector de UltraChat.

No dudes en citar el repositorio si crees que UltraChat es útil.

@article { ding2023enhancing ,

title = { Enhancing Chat Language Models by Scaling High-quality Instructional Conversations } ,

author = { Ding, Ning and Chen, Yulin and Xu, Bokai and Qin, Yujia and Zheng, Zhi and Hu, Shengding and Liu, Zhiyuan and Sun, Maosong and Zhou, Bowen } ,

journal = { arXiv preprint arXiv:2305.14233 } ,

year = { 2023 }

}