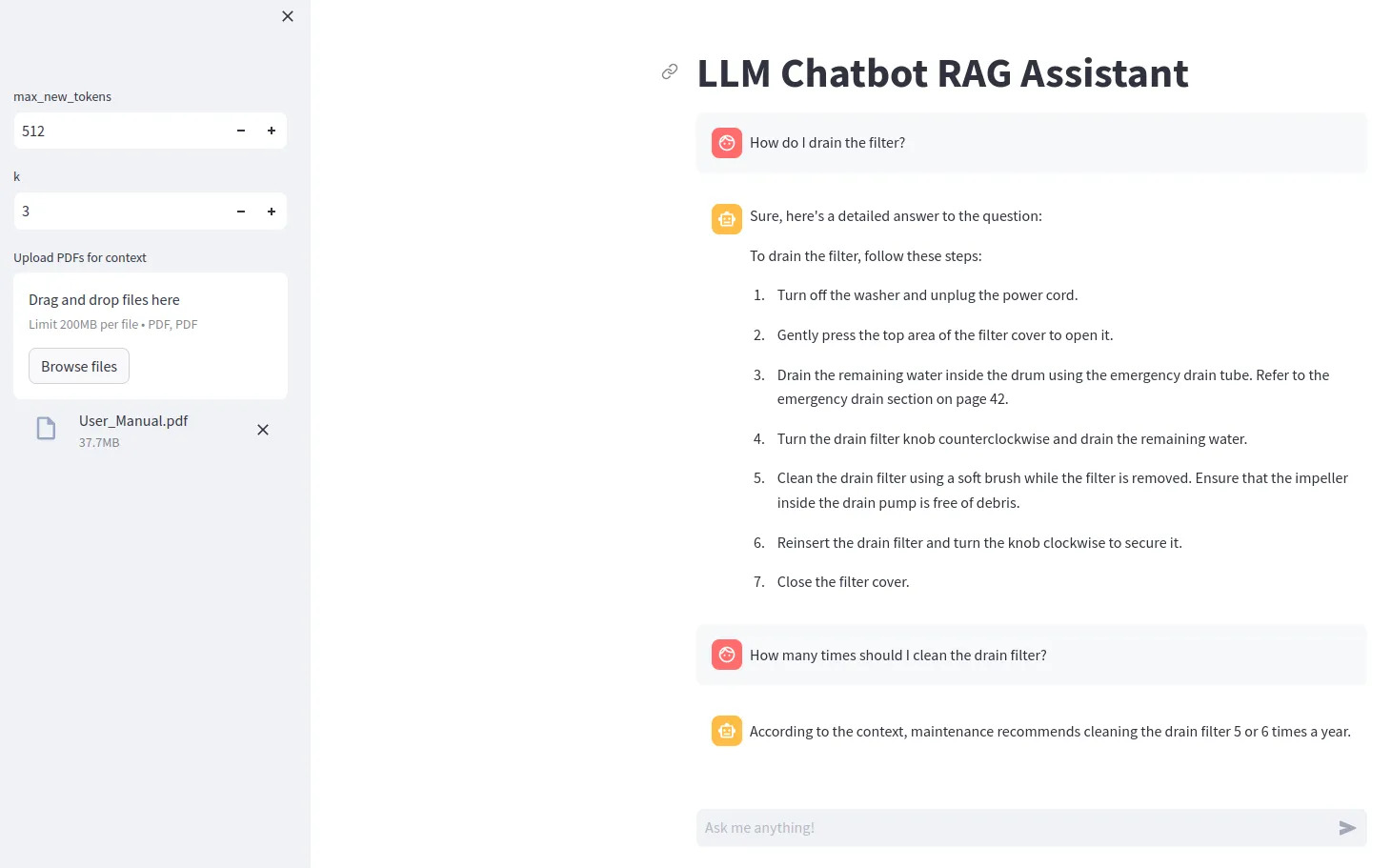

llm chatbot rag

1.0.0

Para utilizar ciertos modelos LLM (como Gemma), debe crear un archivo .env que contenga la línea ACCESS_TOKEN=<your hugging face token>

Instale dependencias con pip install -r requirements.txt

Ejecute con streamlit run src/app.py

Para utilizar la cuantificación de bits y bytes, se requiere una GPU Nvidia. Asegúrese de instalar primero el kit de herramientas NVIDIA y luego PyTorch.

Puedes comprobar si tu GPU está disponible en Python con

import torch

print(torch.cuda.is_available())

Si no tiene una GPU compatible, intente configurar device="cpu" para el modelo y elimine la configuración de cuantificación.