Este es el repositorio del proyecto ChatPLUG, cuyo objetivo es construir y compartir un sistema de diálogo de dominio abierto chino.

| 爱用emoji的萌妹子小婉 | 富有智慧的得道高僧 | 会说古文的的三国NPC关羽 |

|---|---|---|

|  |  |

Chat de juego de roles

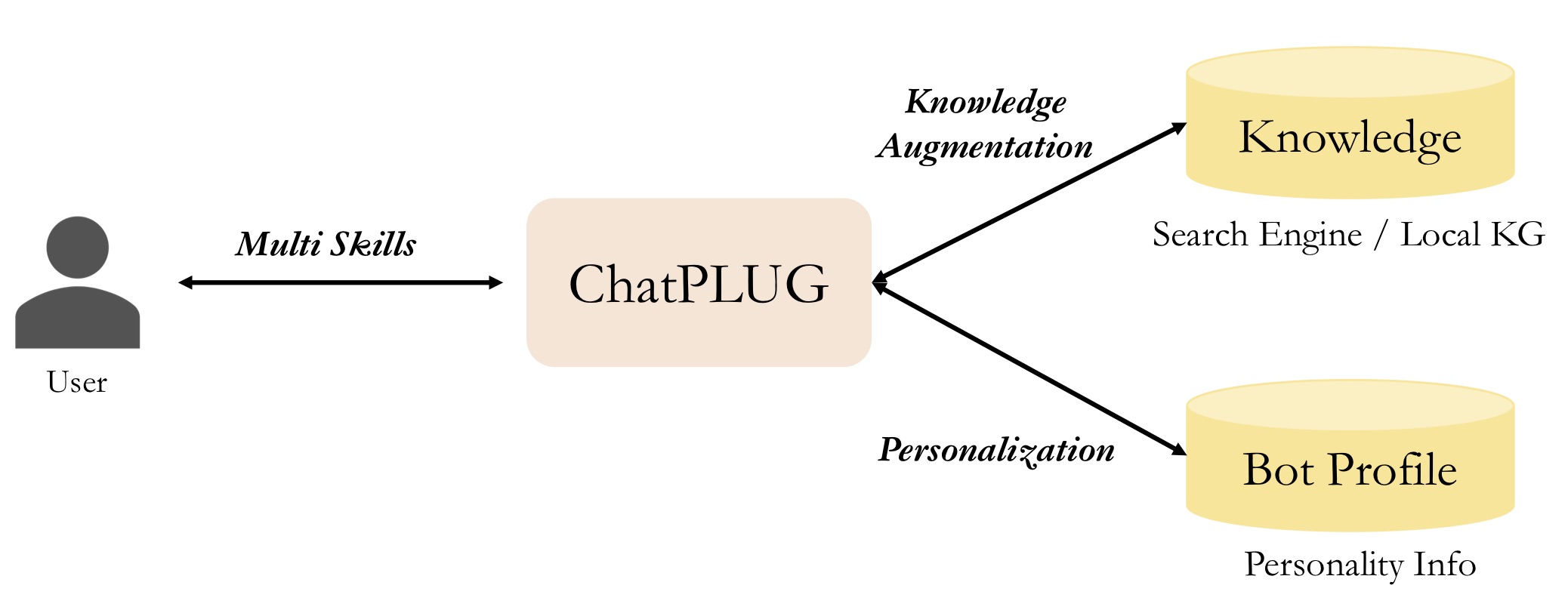

En comparación con los modelos de código abierto existentes, destacamos tres características de ChatPLUG de la siguiente manera:

Es flexible integrar conocimiento externo durante la inferencia y esta es una entrada opcional. Puede utilizar un

search enginepara adquirir información actualizada o utilizar una base de conocimientos local para obtener conocimientos del dominio.

Es fácil personalizar el estilo de las conversaciones y los personajes configurando

bot profileso usandorole-paly instructions.

Demuestra su competencia en el diálogo de dominio abierto a través de conversaciones de varios turnos, al mismo tiempo que muestra impresionantes

multi-task abilitiesen una amplia gama de tareas de PNL.

Ofrecemos tres métodos para usar o continuar desarrollando ChatPLUG de la siguiente manera:

| Empezando | Inferencia | Tren | Desplegar | |

|---|---|---|---|---|

| ModeloScope | Fácil | ✔️ CLI | No listo | No listo |

| AbrazosCara | Medio | ✔️ CLI | No listo | No listo |

| XDPX | Duro | ✔️ CLI | ✔️ Soporte | ✔️ Sirviendo |

Puede descargar y utilizar modelos ChatPLUG desde ModelScope.

| Nombre del modelo | URL |

|---|---|

| ChatPLUG-240M | ChatPLUG-开放域对话模型-240M |

| ChatPLUG-3.7B | ChatPLUG-开放域对话模型-3.7B |

Muy pronto.

XDPX es una biblioteca fácil de usar que permite a investigadores y desarrolladores entrenar modelos personalizados y crear sus propios chatbots de manera optimizada. Su funcionalidad todo en uno permite una solución integral que simplifica procesos complejos. inicio rápido

Cuando utilice ChatPLUG-3.7B, puede configurar

core_chat_half_precision : truepara ahorrar memoria.

# Requirement

# in the dir of XDPX

cd XDPX

pip install -e .

# Download checkpoints

# in the same dir as the download.sh

cd ..

sh download.sh

# Inference

# in the dir of XDPX

cd XDPX

CUDA_VISIBLE_DEVICES=0 x-script fidchat_new chat_pipeline/chatplug_3.7B_sftv2.6.0_instruction.hjson

# input `#exit` and exit the terminal Si su GPU (por ejemplo, A100, A10) admite bf16, configure

deepspeed_bf16: trueydeepspeed_fp16: false; de lo contrario, configuredeepspeed_bf16: falseydeepspeed_fp16: true

# 1. Download dataset from belle

# in ChatPLUG/data/belle dir

cd data/belle

git lfs install

git clone https://huggingface.co/datasets/BelleGroup/train_0.5M_CN

python process_belle_0.5M.py

# $ls data/belle

# train_0.jsonl dev.jsonl ...

# 2. Preprocess Data

# in XDPX dir

x-prepro chat_pipeline/chatplug_prepro_sft_instruction.hjson

# $ls data/dialogue/sft/chatplug/belle_instruction

# train_0.pt dev.pt

# 3. Training

# in XDPX dir

x-train chat_pipeline/chatplug_3.7B_train_sftv2.6.0_instruction.hjsonMuy pronto.

Consulte Instalación para obtener instrucciones de instalación.

Para obtener guías de usuario detalladas, consulte nuestra documentación:

Guías de usuario

Guías avanzadas

Si encuentra nuestro proyecto útil en su trabajo, cite:

@misc{tian2023chatplug,

title={ChatPLUG: Open-Domain Generative Dialogue System with Internet-Augmented Instruction Tuning for Digital Human},

author={Junfeng Tian and Hehong Chen and Guohai Xu and Ming Yan and Xing Gao and Jianhai Zhang and Chenliang Li and Jiayi Liu and Wenshen Xu and Haiyang Xu and Qi Qian and Wei Wang and Qinghao Ye and Jiejing Zhang and Ji Zhang and Fei Huang and Jingren Zhou},

year={2023},

eprint={2304.07849},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{plug2021,

title = {{PLUG: Pre-training for Language Understanding and Generation}},

author={ModelScope},

publisher = {ModelScope},

journal = {ModelScope repository},

year = {2021},

howpublished = {url{https://modelscope.cn/models/damo/nlp_plug_text-generation_27B/summary}},

}

Este código tiene la licencia Apache (Versión 2.0).