KServir

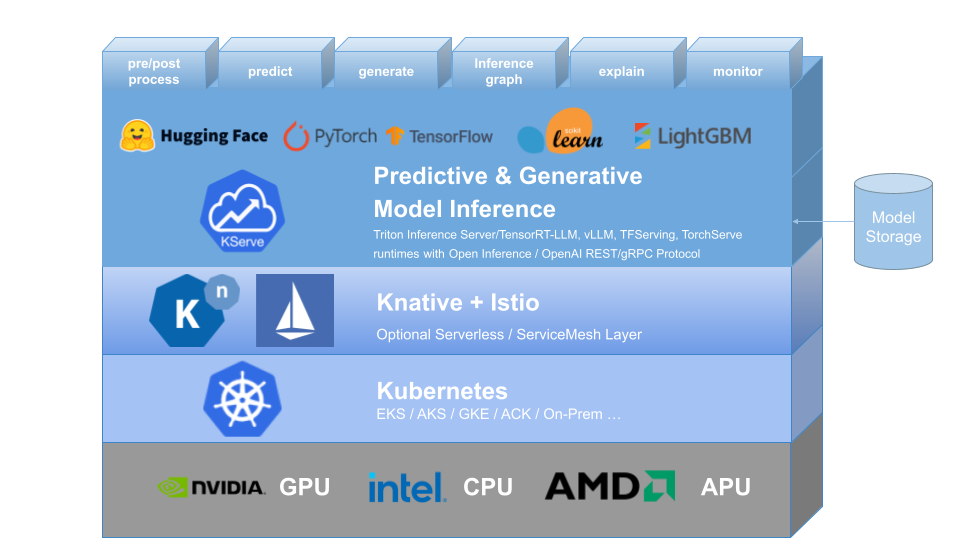

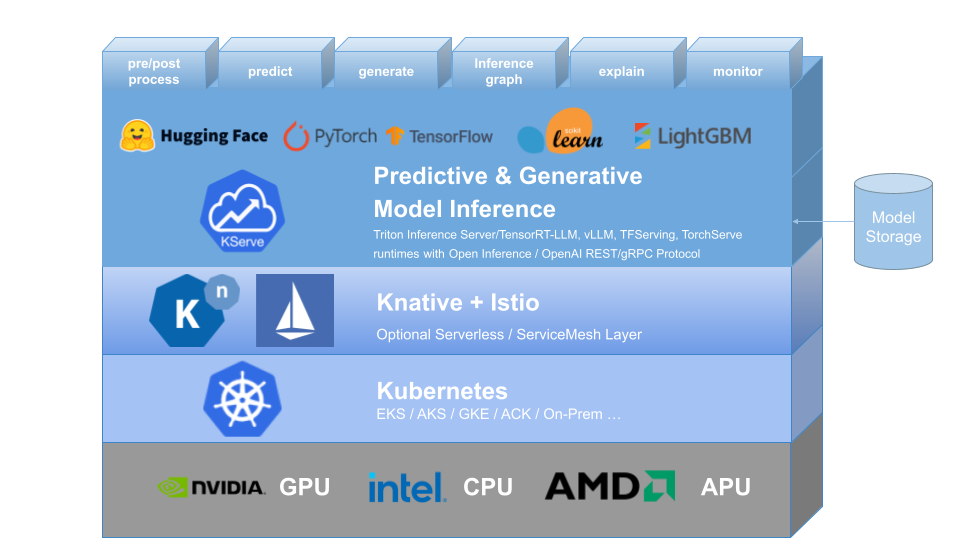

KServe proporciona una definición de recursos personalizada de Kubernetes para servir modelos de aprendizaje automático (ML) predictivos y generativos. Su objetivo es resolver casos de uso de modelos de producción proporcionando interfaces de alta abstracción para modelos Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM utilizando protocolos de plano de datos estandarizados.

Encapsula la complejidad del escalado automático, las redes, la verificación del estado y la configuración del servidor para brindar funciones de servicio de vanguardia como el escalado automático de GPU, escalar a cero y Canary Rollouts a sus implementaciones de aprendizaje automático. Permite una historia simple, conectable y completa para Production ML Serving que incluye predicción, preprocesamiento, posprocesamiento y explicabilidad. KServe se utiliza en varias organizaciones.

Para obtener más detalles, visite el sitio web de KServe.

KFServing ha pasado a llamarse KServe desde la versión 0.7.

¿Por qué KServe?

- KServe es una plataforma de inferencia de modelos estándar e independiente de la nube para ofrecer modelos de IA predictivos y generativos en Kubernetes, diseñada para casos de uso altamente escalables.

- Proporciona un protocolo de inferencia estandarizado y de alto rendimiento en todos los marcos de aprendizaje automático, incluida la especificación OpenAI para modelos generativos.

- Admite cargas de trabajo de inferencia modernas sin servidor con escalado automático basado en solicitudes, incluido el escalado a cero en CPU y GPU .

- Proporciona alta escalabilidad, empaquetado de densidad y enrutamiento inteligente utilizando ModelMesh .

- Producción simple y conectable que sirve para inferencia , procesamiento previo y posterior , monitoreo y explicabilidad .

- Implementaciones avanzadas para implementación canary , canalización y conjuntos con InferenceGraph .

Más información

Para obtener más información sobre KServe, cómo utilizar varias funciones compatibles y cómo participar en la comunidad de KServe, siga la documentación del sitio web de KServe. Además, hemos compilado una lista de presentaciones y demostraciones para profundizar en varios detalles.

Instalación

Instalación independiente

- Instalación sin servidor : KServe instala de forma predeterminada Knative para la implementación sin servidor para InferenceService.

- Instalación de implementación sin formato : en comparación con la instalación sin servidor, esta es una instalación más liviana . Sin embargo, esta opción no admite la implementación canary ni el escalado automático basado en solicitudes con escala a cero.

- Instalación de ModelMesh : Opcionalmente, puede instalar ModelMesh para habilitar casos de uso de servicio de modelos de alta escala , alta densidad y que cambian con frecuencia .

- Instalación rápida : instale KServe en su máquina local.

Instalación de Kubeflow

KServe es un componente adicional importante de Kubeflow; obtenga más información en la documentación de Kubeflow KServe. Consulte las siguientes guías para ejecutar en AWS o en OpenShift Container Platform.

? Crea tu primer servicio de inferencia

Hoja de ruta

Referencia de la API de servicio de inferencia

? Guía para desarrolladores

✍️ Guía del colaborador

? Adoptantes