100 días de codificación con aprendizaje automático propuesto por Siraj Raval

Obtenga los conjuntos de datos desde aquí

Consulte el código desde aquí.

Consulte el código desde aquí.

Consulte el código desde aquí.

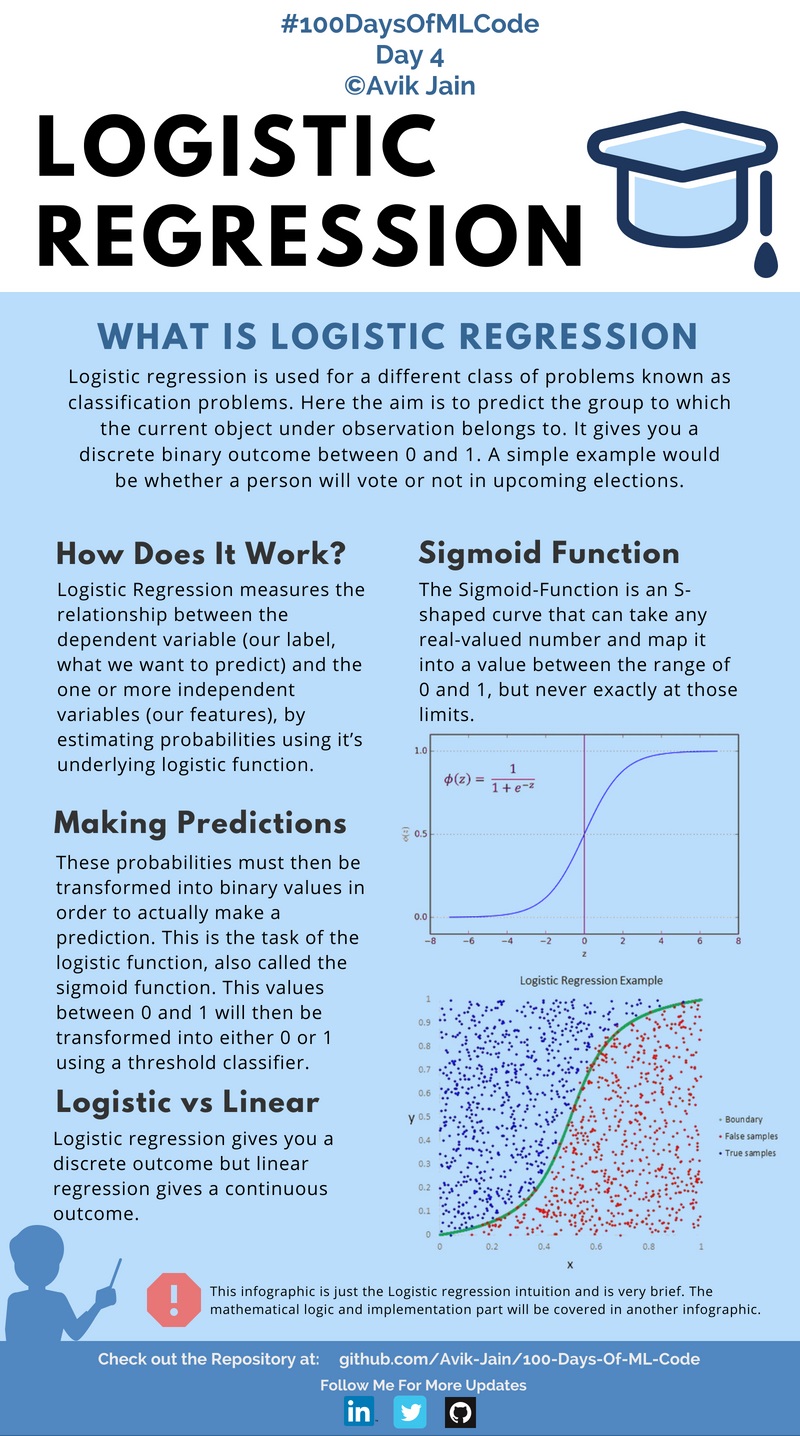

Avanzando hacia #100DaysOfMLCode hoy, profundicé en lo que realmente es la regresión logística y cuáles son las matemáticas involucradas detrás de ella. Aprendí cómo se calcula la función de costos y luego cómo aplicar el algoritmo de descenso de gradiente a la función de costos para minimizar el error en la predicción.

Debido a menos tiempo, ahora publicaré una infografía en días alternos. Además, si alguien quiere ayudarme con la documentación del código y ya tiene algo de experiencia en el campo y conoce Markdown para github, contácteme en LinkedIn :).

Consulta el Código aquí

#100DaysOfMLCode Para aclarar mis ideas sobre la regresión logística, estaba buscando en Internet algún recurso o artículo y encontré este artículo (https://towardsdatascience.com/logistic-regression-detailed-overview-46c4da4303bc) de Saishruthi Swaminathan.

Ofrece una descripción detallada de la regresión logística. Compruébalo.

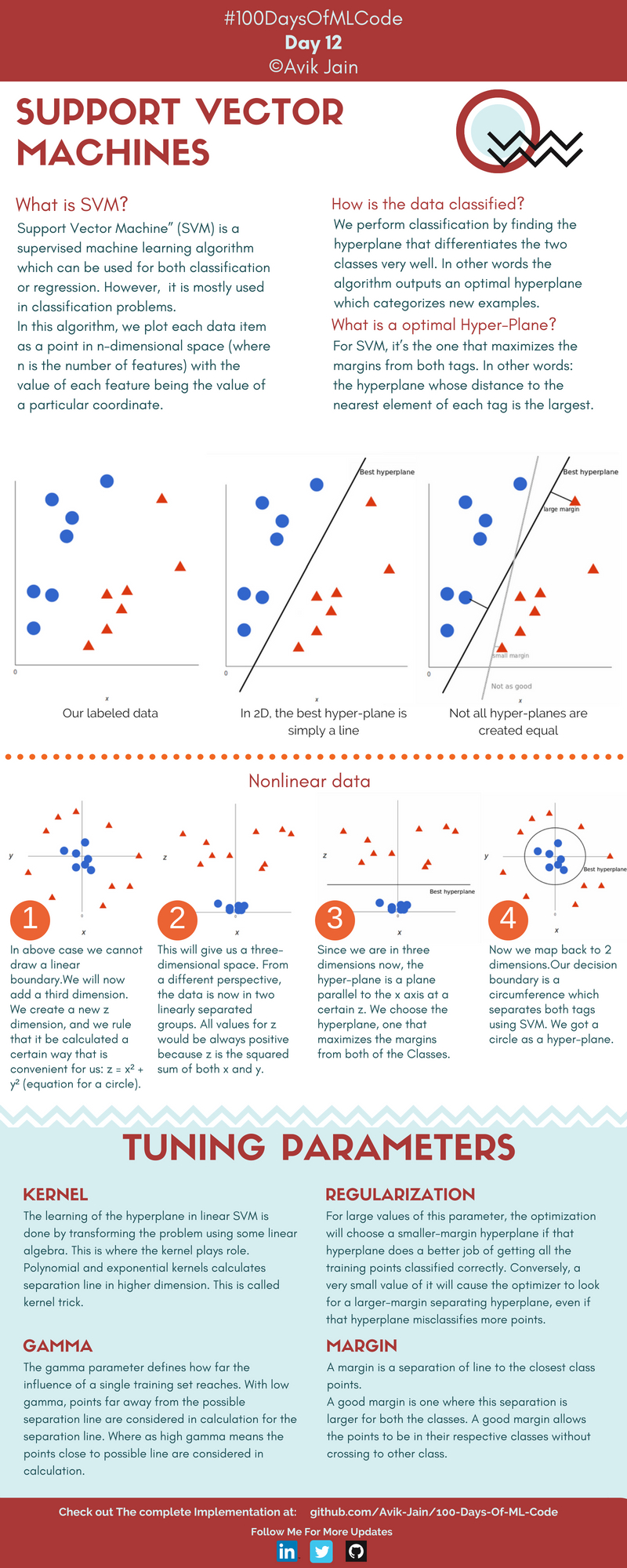

Tengo una intuición sobre qué es SVM y cómo se utiliza para resolver problemas de clasificación.

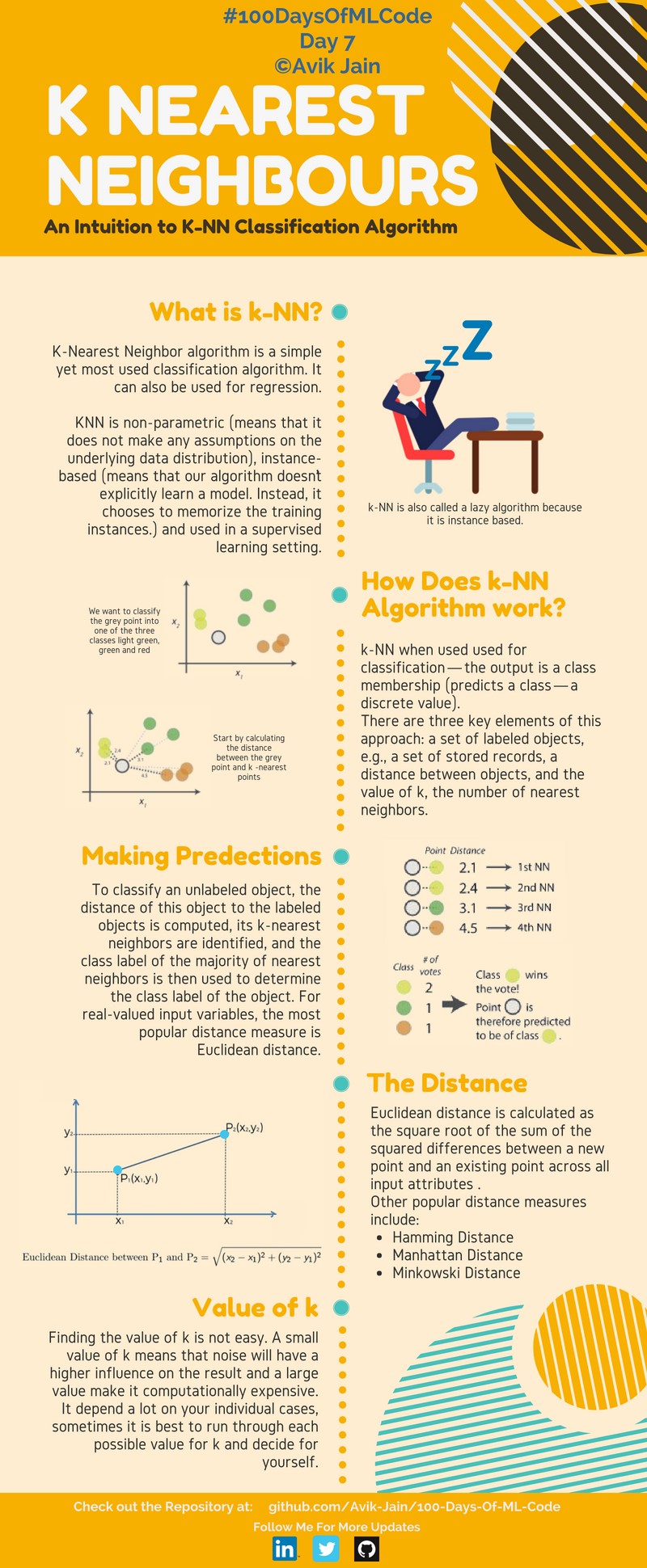

Aprendí más sobre cómo funciona SVM y cómo implementar el algoritmo K-NN.

Implementó el algoritmo K-NN para clasificación. La infografía de la máquina vectorial de soporte #100DaysOfMLCode está a mitad de camino. Lo actualizaré mañana.

Continuando con #100DaysOfMLCode, hoy revisé el clasificador Naive Bayes. También estoy implementando SVM en Python usando scikit-learn. Actualizará el código pronto.

Hoy implementé SVM en datos relacionados linealmente. Biblioteca Scikit-Learn usada. En Scikit-Learn tenemos el clasificador SVC que utilizamos para realizar esta tarea. Usaremos kernel-trick en la próxima implementación. Consulta el código aquí.

Aprendí sobre diferentes tipos de clasificadores bayesianos ingenuos. También comenzaron las conferencias de Bloomberg. El primero en la lista de reproducción fue Black Box Machine Learning. Ofrece una descripción general completa sobre funciones de predicción, extracción de características, algoritmos de aprendizaje, evaluación del rendimiento, validación cruzada, sesgo de muestra, no estacionariedad, sobreajuste y ajuste de hiperparámetros.

El uso de la biblioteca Scikit-Learn implementó el algoritmo SVM junto con la función del kernel que asigna nuestros puntos de datos a una dimensión superior para encontrar el hiperplano óptimo.

Completaste toda la Semana 1 y la Semana 2 en un solo día. Regresión logística aprendida como red neuronal.

Completé el Curso 1 de la especialización en aprendizaje profundo. Implementé una red neuronal en Python.

Inició la lección 1 de 18 del curso de aprendizaje automático de Caltech - CS 156 a cargo del profesor Yaser Abu-Mostafa. Fue básicamente una introducción a las próximas conferencias. También explicó el algoritmo perceptrón.

Completó la Semana 1 de Mejora de las redes neuronales profundas: ajuste, regularización y optimización de hiperparámetros.

Vi algunos tutoriales sobre cómo hacer web scraping usando Beautiful Soup para recopilar datos para construir un modelo.

Conferencia 2 de 18 del curso de aprendizaje automático de Caltech - CS 156 a cargo del profesor Yaser Abu-Mostafa. Aprendí sobre la desigualdad de Hoeffding.

La lección 3 del curso Bloomberg ML introdujo algunos de los conceptos básicos como espacio de entrada, espacio de acción, espacio de resultados, funciones de predicción, funciones de pérdida y espacios de hipótesis.

Consulta el código aquí.

Encontré un canal increíble en youtube 3Blue1Brown. Tiene una lista de reproducción llamada Essence of Linear Algebra. Comenzó completando 4 videos que brindaban una descripción completa de vectores, combinaciones lineales, intervalos, vectores base, transformaciones lineales y multiplicación de matrices.

Enlace a la lista de reproducción aquí.

Continuando con la lista de reproducción, complete los siguientes 4 videos que analizan temas Transformaciones 3D, Determinantes, Matriz inversa, Espacio de columnas, Espacio nulo y Matrices no cuadradas.

Enlace a la lista de reproducción aquí.

En la lista de reproducción de 3Blue1Brown completó otros 3 vídeos de la esencia del álgebra lineal. Los temas cubiertos fueron Producto escalar y Producto cruzado.

Enlace a la lista de reproducción aquí.

Completé toda la lista de reproducción hoy, videos 12-14. Realmente una lista de reproducción increíble para actualizar los conceptos de Álgebra lineal. Los temas cubiertos fueron el cambio de base, vectores propios y valores propios, y espacios vectoriales abstractos.

Enlace a la lista de reproducción aquí.

Completando la lista de reproducción - Essence of Linear Algebra de 3blue1brown, apareció una sugerencia en youtube con respecto a una serie de videos nuevamente del mismo canal 3Blue1Brown. Como ya me había impresionado la serie anterior sobre álgebra lineal, me sumergí directamente en ella. Completé alrededor de 5 videos sobre temas como Derivadas, Regla de la Cadena, Regla del Producto y derivada de exponencial.

Enlace a la lista de reproducción aquí.

Vi 2 videos sobre el tema Diferenciación implícita y límites de la lista de reproducción Essence of Calculus.

Enlace a la lista de reproducción aquí.

Vi los 4 videos restantes que cubren temas como integración y derivados de orden superior.

Enlace a la lista de reproducción aquí.

Consulta el código aquí.

Un video asombroso sobre redes neuronales del canal de youtube 3Blue1Brown. Este video brinda una buena comprensión de las redes neuronales y utiliza un conjunto de datos de dígitos escritos a mano para explicar el concepto. Enlace al vídeo.

Segunda parte de redes neuronales por el canal de youtube 3Blue1Brown. Este video explica los conceptos de Gradient Descent de una manera interesante. 169 hay que verlo y es muy recomendable. Enlace al vídeo.

Tercera parte de redes neuronales por el canal de youtube 3Blue1Brown. Este video analiza principalmente las derivadas parciales y la retropropagación. Enlace al vídeo.

Cuarta parte de redes neuronales por el canal de youtube 3Blue1Brown. El objetivo aquí es representar, en términos algo más formales, la intuición de cómo funciona la retropropagación y el video analiza principalmente las derivadas parciales y la retropropagación. Enlace al vídeo.

Enlace al vídeo.

Enlace al vídeo.

Enlace al vídeo.

Enlace al vídeo.

Pasó al aprendizaje no supervisado y estudió sobre agrupación. Trabajando en mi sitio web, échale un vistazo a avikjain.me. También encontré una animación maravillosa que puede ayudar a comprender fácilmente K - Means Clustering Link.

Se implementó K significa agrupación. Consulta el código aquí.

Obtuve un nuevo libro, "Python Data Science HandBook" de JK VanderPlas. Consulte los cuadernos de Jupyter aquí.

Comenzó con el capítulo 2: Introducción a Numpy. Se cubrieron temas como tipos de datos, matrices Numpy y cálculos en matrices Numpy.

Verifique el código -

Introducción a NumPy

Comprender los tipos de datos en Python

Los conceptos básicos de las matrices NumPy

Computación en matrices NumPy: funciones universales

Capítulo 2: Agregaciones, comparaciones y radiodifusión

Enlace al cuaderno:

Agregaciones: mínima, máxima y todo lo intermedio

Computación en matrices: radiodifusión

Comparaciones, máscaras y lógica booleana

Capítulo 2: Indexación elegante, clasificación de matrices, datos estructurados

Enlace al cuaderno:

Indexación elegante

Ordenar matrices

Datos estructurados: matrices estructuradas de NumPy

Capítulo 3: Manipulación de datos con Pandas

Se cubrieron varios temas como objetos Pandas, indexación y selección de datos, operación con datos, manejo de datos faltantes, indexación jerárquica, ConCat y Append.

Enlace a los cuadernos:

Manipulación de datos con Pandas

Presentamos los objetos Pandas

Indexación y selección de datos

Operando con datos en Pandas

Manejo de datos faltantes

Indexación jerárquica

Combinando conjuntos de datos: Concat y Append

Capítulo 3: Se completaron los siguientes temas: Fusionar y unir, Agregación y agrupación y Tablas dinámicas.

Combinando conjuntos de datos: fusionar y unir

Agregación y agrupación

Tablas dinámicas

Capítulo 3: Operaciones de cadenas vectorizadas, trabajo con series temporales

Enlaces a cuadernos:

Operaciones de cadenas vectorizadas

Trabajar con series temporales

Pandas de alto rendimiento: eval() y query()

Capítulo 4: Visualización con Matplotlib Aprendí sobre diagramas de líneas simples, diagramas de dispersión simples y diagramas de densidad y contorno.

Enlaces a cuadernos:

Visualización con Matplotlib

Gráficos de líneas simples

Gráficos de dispersión simples

Visualizando errores

Gráficos de densidad y contorno

Capítulo 4: Visualización con Matplotlib Aprendí sobre histogramas, cómo personalizar leyendas de gráficos, barras de colores y cómo crear subtramas múltiples.

Enlaces a cuadernos:

Histogramas, binnings y densidad

Personalización de las leyendas de la trama

Personalización de barras de colores

Múltiples subtramas

Texto y anotación

Capítulo 4: Trazado tridimensional cubierto en Mathplotlib.

Enlaces a cuadernos:

Trazado tridimensional en Matplotlib

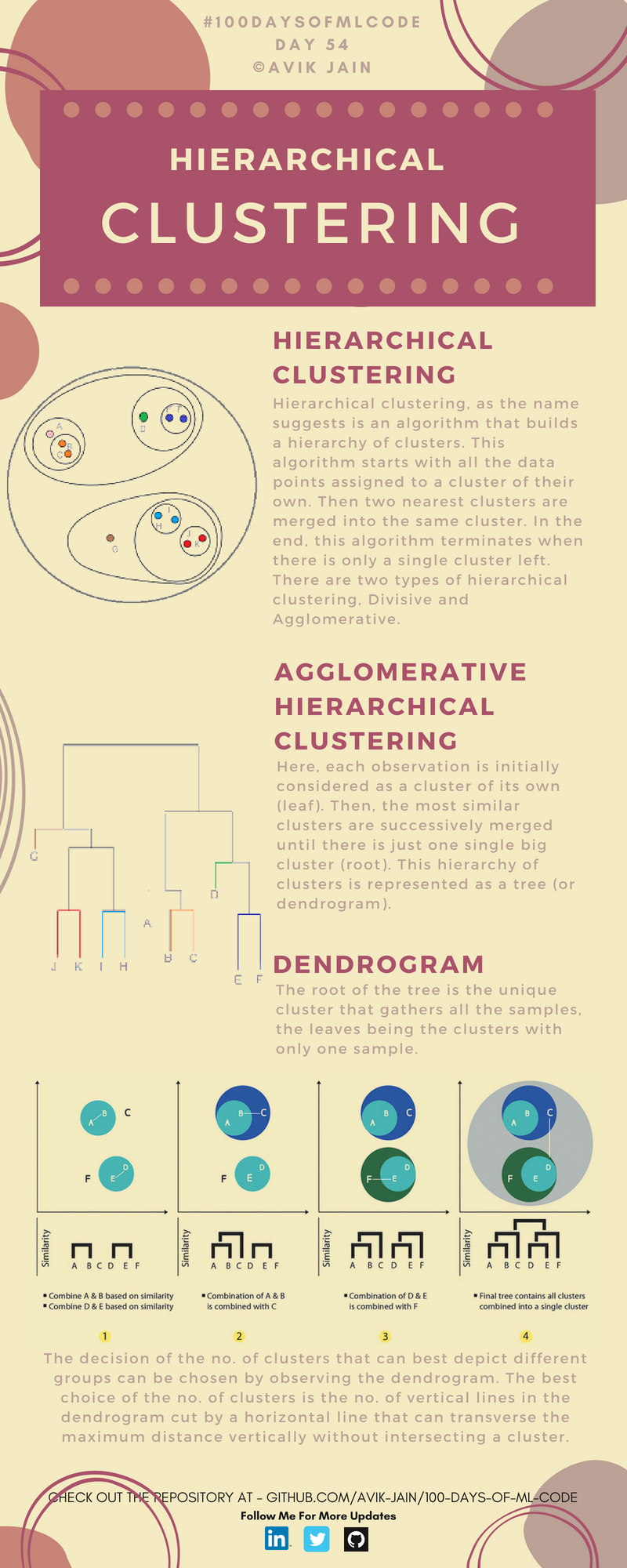

Estudió sobre Agrupación Jerárquica. Mira esta increíble visualización.