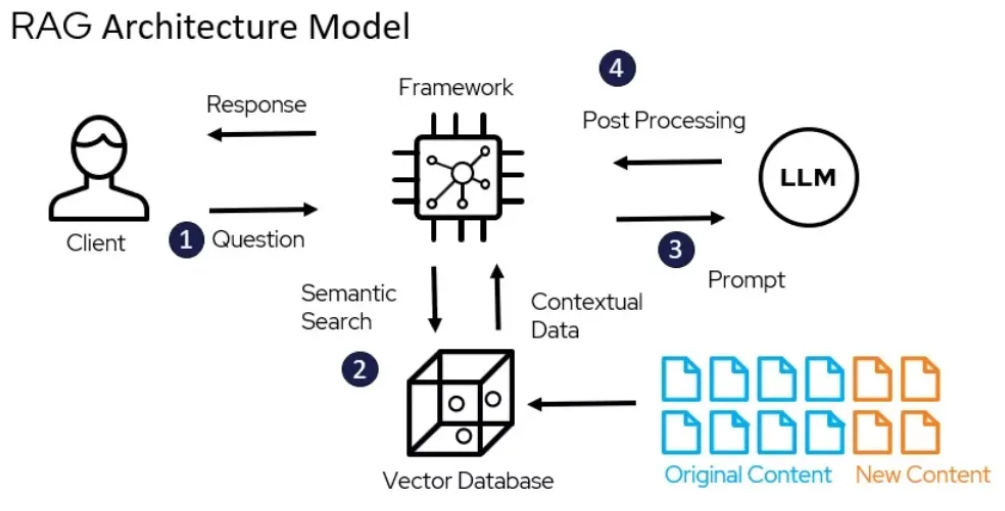

Como sabemos, los LLM como Gemini carecen de información específica de la empresa. Pero esta información más reciente está disponible a través de archivos PDF, archivos de texto, etc. Ahora, si podemos conectar nuestro LLM con estas fuentes, podemos crear una aplicación mucho mejor.

Utilizando el marco LangChain, construí un sistema de recuperación de generación aumentada (RAG) que puede utilizar el poder de LLM como Gemini 1.5 Pro para responder preguntas sobre el documento "Leave No Context Behind" publicado por Google el 10 de abril de 2024. En este proceso, externo Los datos (es decir, el documento Leave No Context Behind) se recuperan y luego se pasan al LLM durante el paso de generación.

Puedes encontrar el documento aquí.

Encuentre la implementación completa del código aquí.