nvidia llm

1.0.0

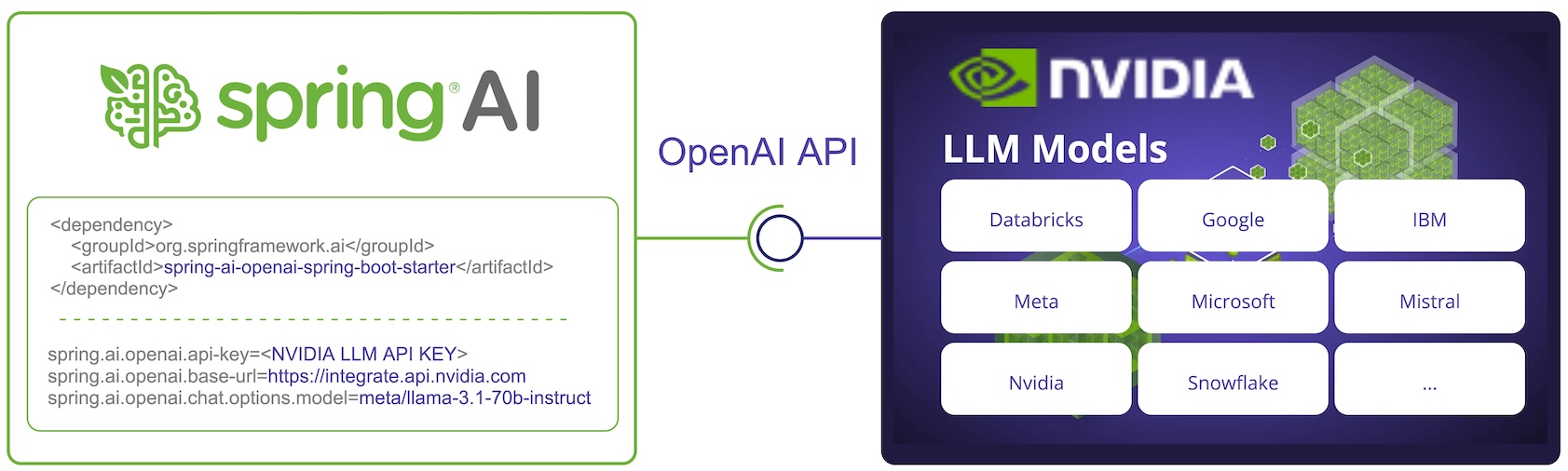

NVIDIA LLM API es un motor de inferencia de IA proxy que ofrece una amplia gama de modelos de varios proveedores.

Spring AI se integra con la API NVIDIA LLM mediante la reutilización del cliente Spring AI OpenAI existente.

Para esto, debe configurar la URL base en https://integrate.api.nvidia.com , seleccione uno de los https://docs.api.nvidia.com/nim/reference/llm-apis#model proporcionados. Modelos LLM] y obtenga una api-key para ello.

NOTA: La API NVIDIA LLM requiere que el parámetro max-token se establezca explícitamente o se generará un error del servidor.

Encuentre más en la documentación de referencia de SpringAI/NVIDIA: https://docs.spring.io/spring-ai/reference/api/chat/nvidia-chat.html