qevals

1.0.0

Evals es un marco de evaluación y generación de datos sintéticos para aplicaciones LLM y RAG.

Tiene 2 módulos principales:

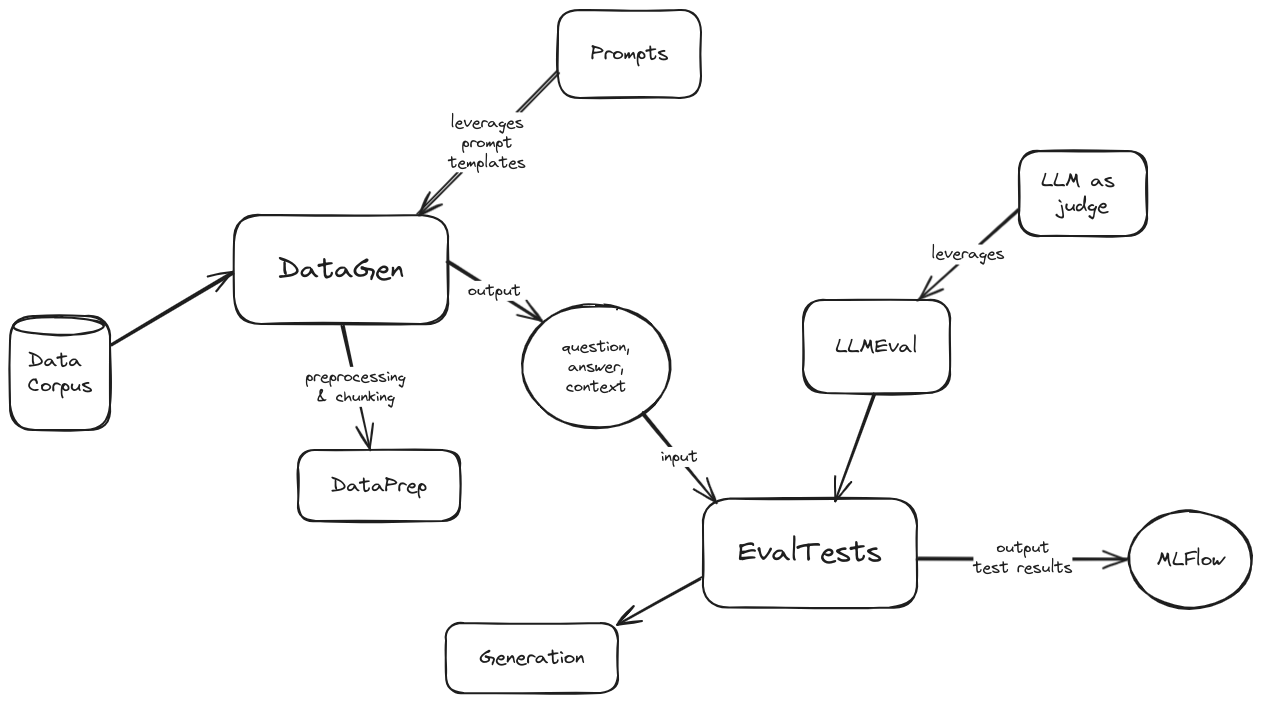

Un diagrama de arquitectura de alto nivel de evaluaciones es el siguiente:

Diagrama de arquitectura

Para comenzar con las evaluaciones, siga estos pasos:

pip install -r requirements.txt en el directorio del proyecto.config/config.toml.template y asígnele el nombre config/config.toml .config.toml :MISCDATAGENDATA_DIR controla la ubicación del corpus de datos para generar datos sintéticos, es relativo al directorio datagen/data/ . En otras palabras, agregue sus directorios de datos allí y especifique su nombre en la variable.GEN_PROVIDER permite elegir entre azure o vertex .DATAEVALEVAL_TESTS ofrece una lista de pruebas de evaluación compatibles con el marco. Las opciones posibles son AnswerRelevancy , Hallucination , Faithfulness , Bias , Toxicity , Correctness , Coherence , PromptInjection , PromptBreaking , PromptLeakage .EVAL_RPVODER permite elegir entre azure o vertex .Para ejecutar el módulo de generación de datos sintéticos:

Modificar/adaptar el cliente de muestra proporcionado ( datagen/client.py )

Ejecute python -m datagen.client

Los datos generados sintéticamente se almacenarán en el directorio datagen/qa_out/ como un archivo CSV con el formato:

```csv

question,context,ground_truth

```

Para ejecutar el módulo de evaluación:

eval/client.py )question , context , ground_truth ).ground_truth puede usarse o no dependiendo de la configuración use_answers_from_dataset . Cuando se establece en False ignorará esa columna de datos y generará nuevos resultados utilizando el modelo generativo configurado.mlflow ui --port 5000python -m eval.client