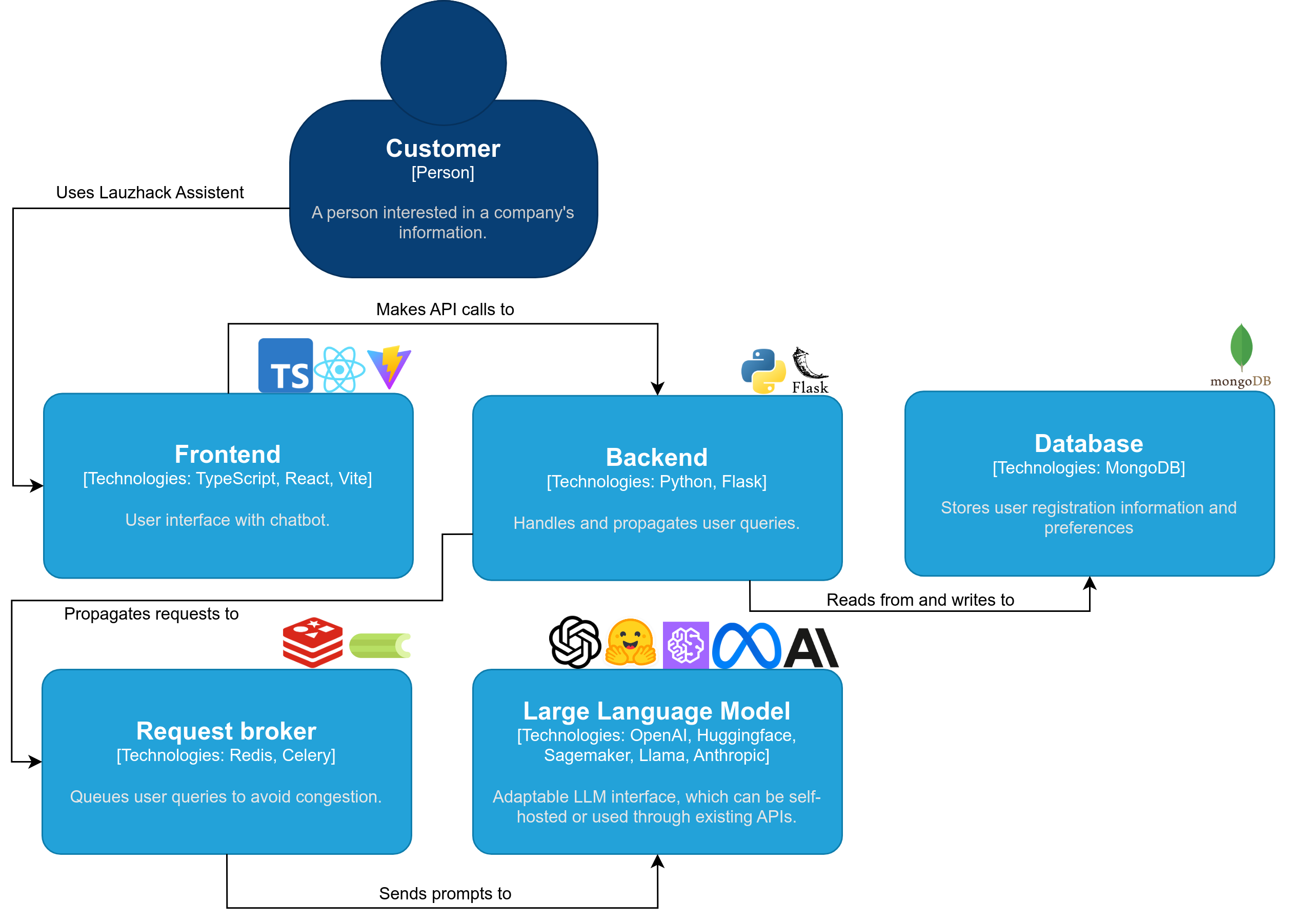

lauzcom assistant es una solución interactiva y fácil de usar diseñada para brindar acceso fluido a datos críticos de Swisscom. Al integrar potentes modelos GPT , los clientes pueden hacer preguntas fácilmente sobre los datos públicos de Swisscom y recibir respuestas precisas rápidamente.

Dígale adiós a las tediosas búsquedas manuales y deje que lauzcom assistant revolucione las interacciones con sus clientes.

El proyecto lauzcom assistant está creado por:

Vídeo de demostración

Nota

Asegúrate de tener instalado Docker

En macOS o Linux, ejecute:

./setup.shInstala todas las dependencias y te permite descargar un modelo localmente o usar OpenAI. El Asistente LauzHack ahora se ejecuta en http://localhost:5173.

De lo contrario, siga estos pasos:

Descargue y abra este repositorio con git clone [email protected]:cern-lauzhack-2023/Lauzcom-Assistant.git .

Cree un archivo .env en su directorio raíz y configure la variable env API_KEY con su clave API OpenAI y VITE_API_STREAMING en verdadero o falso, dependiendo de si desea transmitir respuestas o no.

API_KEY= < YourOpenAIKey >

VITE_API_STREAMING=trueConsulte las variables de entorno opcionales en los archivos /.env-template y /application/.env_sample.

Ejecute ./run-with-docker-compose.sh.

El Asistente LauzHack ahora se ejecuta en http://localhost:5173.

Para detenerlo, presione Ctrl + C

Para el desarrollo, solo se utilizan dos contenedores de docker-compose.yaml (eliminando todos los servicios excepto Redis y Mongo). Consulte el archivo docker-compose-dev.yaml.

Correr:

docker compose -f docker-compose-dev.yaml build

docker compose -f docker-compose-dev.yaml up -dNota

Asegúrese de tener Python 3.10 o 3.11 instalado.

.env en la carpeta /application ..env con su token de API OpenAI para los campos API_KEY y EMBEDDINGS_KEY . (Consulte application/core/settings.py si desea ver más opciones de configuración).

(opcional) Cree un entorno virtual de Python: siga la documentación oficial de Python para entornos virtuales.

a) En Linux y macOS:

python -m venv venv

. venv/bin/activateb) En Windows:

python -m venv venv

venv/Scripts/activateInstale dependencias para el backend:

pip install -r application/requirements.txtflask --app application/app.py run --host=0.0.0.0 --port=7091La API de backend ahora se ejecuta en http://localhost:7091.

celery -A application.app.celery worker -l INFONota

Asegúrate de tener Node versión 16 o superior.

husky y vite (ignore si ya están instalados). npm install husky -g

npm install vite -gnpm install --include=devnpm run devLa interfaz ahora se ejecuta en http://localhost:5173.

La licencia del código fuente es MIT, como se describe en el archivo LICENCIA.

Construido con ? ? LangChain