tokviz /

├── assets/

│ ├── example-deberta-v3-small.png

│ └── example-gpt2.png

├── tokviz /

│ ├── __init__.py

│ └── visualization.py

├── README.md

├── LICENSE

├── setup.py

└── pyproject.toml

tokviz es una biblioteca de Python para visualizar patrones de tokenización en diferentes modelos de lenguaje. Esta biblioteca ofrece una plataforma integral para que investigadores, científicos de datos y entusiastas de la PNL obtengan información sobre cómo los diferentes modelos de lenguaje procesan y tokenizan el texto.

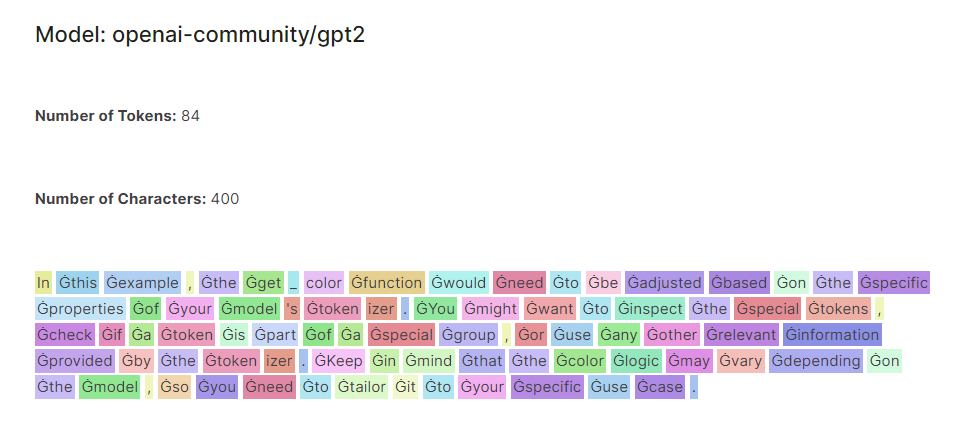

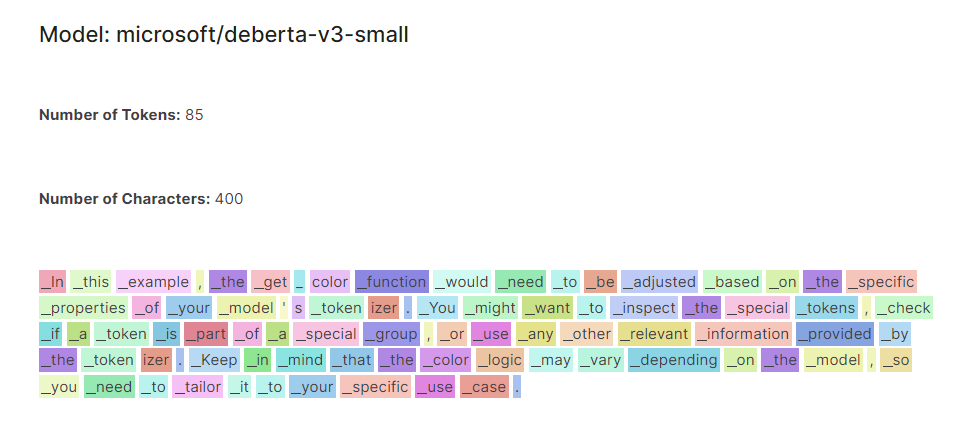

Comparación de modelos: el visualizador permite a los usuarios comparar patrones de tokenización en múltiples modelos de lenguaje, incluidos modelos populares como GPT-2, DistilGPT-2 y DeBERTa-v3-small. Al mostrar tokens codificados por colores uno al lado del otro, los usuarios pueden identificar fácilmente diferencias y similitudes en el comportamiento de tokenización.

Entrada flexible: los usuarios pueden ingresar cualquier texto de su elección, lo que permite la exploración dinámica de patrones de tokenización en diversas entradas de texto. Ya sea analizando oraciones cortas, párrafos o documentos completos, el visualizador se adapta a las entradas del usuario para un análisis completo.

Visualización codificada por colores: los tokens están codificados por colores según sus propiedades e índice, lo que proporciona una representación visual intuitiva de los patrones de tokenización. Esto permite a los usuarios identificar rápidamente tokens y patrones individuales dentro del texto, lo que facilita un análisis e interpretación más profundos.

Puedes instalar tokviz a través de pip:

pip install tokviz from tokviz import token_visualizer

# Define input text

text = "In this example, the get_color function would need to be adjusted based on the specific properties of your model's tokenizer.

You might want to inspect the special tokens, check if a token is part of a special group,

or use any other relevant information provided by the tokenizer.

Keep in mind that the color logic may vary depending on the model,

so you need to tailor it to your specific use case."

# Compare tokenization across different language models

token_visualizer ( text , models = [ 'microsoft/deberta-v3-small' , 'openai-community/gpt2' ])Esto visualizará patrones de tokenización para el texto de entrada utilizando los modelos de lenguaje especificados. Puede pasar una lista de nombres o identificadores de modelos al parámetro de modelos. De forma predeterminada, compara la tokenización con el modelo GPT-2.

Esta biblioteca está basada en el cuaderno LLM Tokenizer Visualizer.