Chatea con modelos de lenguaje generativo localmente en tu computadora sin necesidad de configuración. LocalChat es un chat de IA local simple, fácil de configurar y de código abierto creado sobre llama.cpp. No requiere conocimientos técnicos y permite a los usuarios experimentar un comportamiento similar a ChatGPT en sus propias máquinas, totalmente compatible con GDPR y sin temor a filtrar información accidentalmente. Descargue LocalChat para macOS, Windows o Linux aquí.

Tabla de contenido

Descripción general | Justificación | Requisitos del sistema | Inicio rápido | Documentación

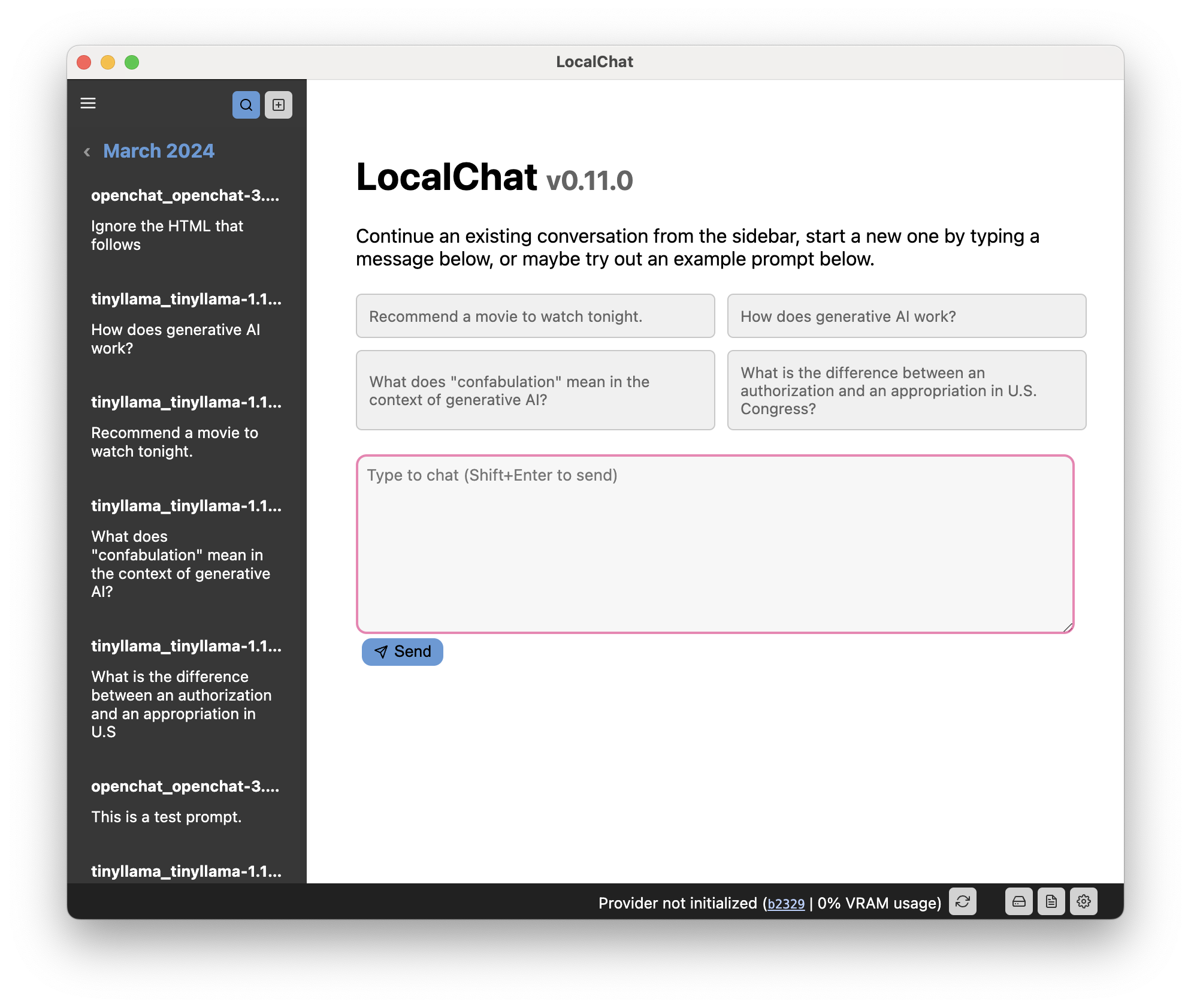

LocalChat proporciona una interfaz similar a un chat para interactuar con modelos de lenguaje grande (LLM) generativos. Se ve y se siente como cualquier conversación de chat, pero ocurre localmente en su computadora. Nunca se transmiten datos a algún servidor en la nube.

Ya existen varios modelos de lenguaje generativo extremadamente capaces que se parecen casi a ChatGPT. La principal diferencia es que esos modelos se ejecutan localmente y son de peso abierto.

Importante

Como probablemente ya sepa, conversar con un LLM puede parecer muy natural, pero los modelos siguen siendo probabilísticos: generarán la siguiente palabra probable en función de lo que haya en el mensaje. Los LLM no tienen sentido del tiempo, la causalidad, el contexto y lo que los lingüistas llaman pragmática. Por lo tanto, tienden a inventar eventos que nunca sucedieron, mezclar hechos de eventos completamente diferentes o decir mentiras (lo que se conoce como "alucinación"). Lo mismo se aplica al código o los cálculos que estos modelos pueden generar. Dicho esto:

Tenga cuidado y utilice este modelo bajo su propia responsabilidad. Ten en cuenta que es un juguete, no algo fiable.

Cuando ChatGPT se lanzó en noviembre de 2022, estaba muy emocionado, pero al mismo tiempo también cauteloso. Si bien quedé muy impresionado por las capacidades de GPT-3, estaba dolorosamente consciente del hecho de que el modelo era propietario y, incluso si no lo fuera, sería imposible ejecutarlo localmente. Como ciudadano europeo consciente de la privacidad, no me gusta la idea de depender de una corporación multimillonaria que puede cortar el acceso en cualquier momento.

Debido a esto, no podía jugar con GPT y decidí esperar a lo inevitable: el desarrollo de herramientas mejores y más pequeñas. Por ahora, hay varios modelos que cumplen todos los requisitos: se ejecutan localmente y se sienten como ChatGPT. Con la cuantización (que básicamente reduce la resolución con algunas pérdidas de calidad), incluso se pueden ejecutar en hardware más antiguo.

Sin embargo, si no tiene experiencia con LLM, será difícil ejecutarlos .

La razón por la que existe esta aplicación es (a) quería implementarla yo mismo para ver cómo funciona ergonómicamente y (b) quería proporcionar una capa muy simple para interactuar con estas cosas sin tener que preocuparme por configurar PyTorch y Transformadores localmente.

Sólo instalas la aplicación, descargas un modelo y listo.

Esta aplicación requiere una computadora moderadamente reciente para ejecutarse. Sin embargo, esta aplicación depende de los LLM, que son notoriamente ávidos de poder. Por lo tanto, el hardware de su computadora determinará qué modelos puede ejecutar.

Los modelos de tamaño "normal" probablemente necesiten una tarjeta gráfica dedicada con entre 6 y 18 GB de memoria de video, a menos que esté dispuesto a esperar más de un segundo por palabra.

Hoy en día, muchos modelos vienen en forma cuantificada, lo que hace que los modelos más grandes también estén disponibles para hardware más antiguo o menos potente. La cuantización a veces reduce bastante los requisitos del sistema incluso de modelos demasiado grandes sin demasiadas pérdidas de calidad (pero su kilometraje puede variar de un modelo a otro).

Importante

Como modelo de lenguaje grande, generar respuestas llevará un poco de tiempo. Especialmente si no tiene una GPU dedicada en su computadora, tenga paciencia o pruebe un modelo más pequeño.

Consejo

Puede encontrar la documentación completa en el sitio web de la aplicación.

La interfaz de usuario se divide en tres componentes principales:

Este código tiene licencia a través de GNU GPL 3.0. Lea más en el archivo LICENCIA.