Impresionantes algoritmos de auditoría

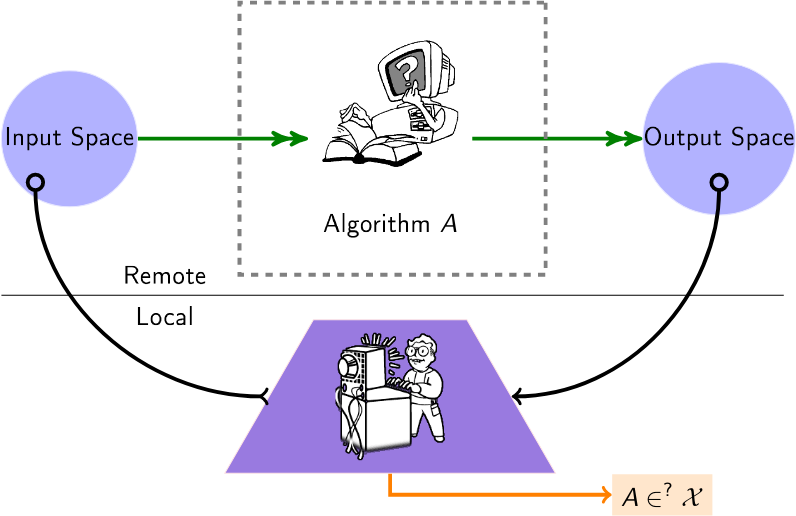

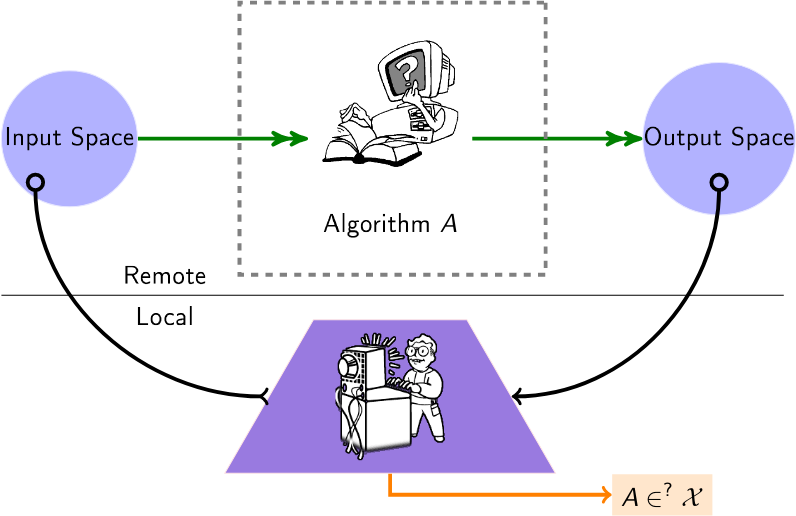

Una lista seleccionada de algoritmos para auditar algoritmos de caja negra. Hoy en día, muchos algoritmos (recomendación, puntuación, clasificación) se operan en proveedores externos, sin que los usuarios o instituciones tengan idea de cómo operan con sus datos. Por lo tanto, los algoritmos de auditoría de esta lista se aplican a esta configuración, denominada configuración de "caja negra", en la que un auditor quiere obtener información sobre estos algoritmos remotos.

Un usuario consulta un algoritmo remoto (por ejemplo, a través de API disponibles) para inferir información sobre ese algoritmo.

Contenido

- Papeles

- Eventos relacionados (conferencias/talleres)

Papeles

2024

- Auditar explicaciones locales es difícil: (NeurIPS) brinda la complejidad de consulta (prohibitiva) de las explicaciones de auditoría.

- Los LLM también alucinan gráficos: una perspectiva estructural - (redes complejas) Consulta los LLM en busca de gráficos conocidos y estudia alucinaciones topológicas. Propone un rango de alucinación estructural.

- Auditoría de equidad con colaboración de múltiples agentes (ECAI) Considera que varios agentes trabajan juntos, cada uno de los cuales audita la misma plataforma para diferentes tareas.

- Mapeo del campo de la auditoría de algoritmos: una revisión sistemática de la literatura Identificación de tendencias de investigación, disparidades lingüísticas y geográficas - (Arxiv) Revisión sistemática de estudios de auditoría de algoritmos e identificación de tendencias en sus enfoques metodológicos.

- FairProof: equidad confidencial y certificable para redes neuronales - (Arxiv) Propone un paradigma alternativo a la auditoría tradicional utilizando herramientas criptográficas como pruebas de conocimiento cero; ofrece un sistema llamado FairProof para verificar la equidad de pequeñas redes neuronales.

- Bajo manipulaciones, ¿algunos modelos de IA son más difíciles de auditar? - (SATML) Relaciona la dificultad de las auditorías de caja negra con la capacidad de los modelos objetivo, utilizando la complejidad de Rademacher.

- Ataques de inferencia de membresía mejorados contra modelos de clasificación de idiomas: (ICLR) Presenta un marco para ejecutar ataques de inferencia de membresía contra clasificadores, en modo auditoría.

- Auditoría de equidad mediante apuestas - (Neurips) [Código] Métodos secuenciales que permiten el monitoreo continuo de los datos entrantes desde un clasificador o regresor de caja negra.

2023

- Auditoría de privacidad con una (1) ejecución de capacitación: (NeurIPS - mejor artículo) Un esquema para auditar sistemas de aprendizaje automático diferencialmente privados con una única ejecución de capacitación.

- Auditar la equidad bajo el desconocimiento a través del razonamiento contrafactual - (Procesamiento y gestión de la información) Muestra cómo revelar si un modelo de caja negra, que cumple con las regulaciones, sigue siendo sesgado o no.

- XAudit: una mirada teórica a la auditoría con explicaciones - (Arxiv) Formaliza el papel de las explicaciones en la auditoría e investiga si las explicaciones modelo pueden ayudar a las auditorías y cómo.

- Mantenerse al día con los modelos de lenguaje: interacción entre robustez y sesgo en datos y modelos NLI - (Arxiv) Propone una manera de extender la vida útil de los conjuntos de datos de auditoría mediante el uso de los propios modelos de lenguaje; también encuentra problemas con las métricas de auditoría de sesgo actuales y propone alternativas; estas alternativas resaltan que la fragilidad del modelo aumentó superficialmente las puntuaciones de sesgo anteriores.

- Auditoría de equidad en línea mediante refinamiento iterativo: (KDD) Proporciona un proceso adaptativo que automatiza la inferencia de garantías probabilísticas asociadas con la estimación de métricas de equidad.

- Robar los algoritmos de decodificación de modelos de lenguaje - (CCS) Robar el tipo e hiperparámetros de los algoritmos de decodificación de un LLM.

- Modelado de madrigueras de conejos en YouTube: (SNAM) Modela la dinámica de captura de los usuarios en madrigueras de conejos en YouTube y proporciona una medida de este recinto.

- Auditoría del algoritmo de recomendación de YouTube para burbujas de filtro de información errónea - (Transacciones en sistemas de recomendación) Lo que se necesita para "reventar la burbuja", es decir, revertir el recinto de la burbuja de las recomendaciones.

- Auditar la clasificación empresarial y la recomendación de revisión de Yelp a través de la lente de la equidad: (Arxiv) Audita la equidad de los sistemas de recomendación de revisión y clasificación empresarial de Yelp, con paridad demográfica, exposición y pruebas estadísticas como regresión lineal cuantil y logística.

- Confidential-PROFITT: PRUEBA confidencial de entrenamiento justo de árboles - (ICLR) Propone algoritmos de aprendizaje de árboles de decisión justos junto con protocolos de prueba de conocimiento cero para obtener una prueba de equidad en el servidor auditado.

- ESCALE-UP: una detección eficiente de puerta trasera a nivel de entrada de caja negra mediante el análisis de la coherencia de la predicción escalada (ICLR) Considera la detección de puerta trasera bajo la configuración de caja negra en aplicaciones de aprendizaje automático como servicio (MLaaS).

2022

- Dos caras: Auditoría adversaria de sistemas comerciales de reconocimiento facial: (ICWSM) Realiza una auditoría adversaria en múltiples API de sistemas y conjuntos de datos, realizando una serie de observaciones preocupantes.

- Ampliación de las auditorías de motores de búsqueda: conocimientos prácticos para la auditoría de algoritmos - (Journal of Information Science) (Código) Audita múltiples motores de búsqueda utilizando un comportamiento de navegación simulado con agentes virtuales.

- Una ralladura de lima: hacia distancias de modelos independientes de la arquitectura - (ICLR) Mide la distancia entre dos modelos remotos utilizando LIME.

- Auditoría de equidad activa: (ICML) Estudios de algoritmos de auditoría basados en consultas que pueden estimar la paridad demográfica de los modelos de ML de una manera eficiente en las consultas.

- ¡Mira la variación! Explicaciones eficientes de caja negra con análisis de sensibilidad basado en Sobol: (NeurIPS) Los índices de Sobol proporcionan una forma eficiente de capturar interacciones de orden superior entre regiones de la imagen y sus contribuciones a la predicción de una red neuronal (de caja negra) a través de la lente de la varianza.

- Se escuchan sus ecos: seguimiento, elaboración de perfiles y orientación de anuncios en el ecosistema de altavoces inteligentes de Amazon - (arxiv) Infiere un vínculo entre el sistema Amazon Echo y el algoritmo de orientación de anuncios.

2021

- Cuando el árbitro también interviene: sesgo en las recomendaciones de productos de marca privada en mercados de comercio electrónico - (FAccT) ¿Los productos de marca privada de Amazon obtienen una proporción injusta de recomendaciones y, por lo tanto, tienen ventajas en comparación con productos de terceros?

- Auditoría de algoritmos cotidiana: comprender el poder de los usuarios cotidianos para sacar a la luz comportamientos algorítmicos dañinos - (CHI) Defiende la "auditoría algorítmica cotidiana" por parte de los usuarios.

- Auditoría de modelos de predicción de caja negra para el cumplimiento de la minimización de datos: (NeurIPS) Mide el nivel de minimización de datos satisfecho por el modelo de predicción utilizando un número limitado de consultas.

- Dejando las cosas claras sobre la prohibición en la sombra - (INFOCOM) (Código) Considera la posibilidad de la prohibición en la sombra en Twitter (es decir, el algoritmo de caja negra de moderación) y mide la probabilidad de varias hipótesis.

- Extracción de datos de entrenamiento de modelos de lenguaje grandes: (Seguridad USENIX) Extraiga secuencias de texto textuales de los datos de entrenamiento del modelo GPT-2.

- FairLens: Auditoría de sistemas de apoyo a decisiones clínicas de caja negra - (Procesamiento y gestión de información) Presenta un proceso para detectar y explicar posibles problemas de equidad en Clinical DSS, mediante la comparación de diferentes medidas de disparidad de clasificación de etiquetas múltiples.

- Auditoría del sesgo algorítmico en Twitter - (WebSci).

- Ejecución del algoritmo bayesiano: estimación de propiedades computables de funciones de caja negra utilizando información mutua - (ICML) Un procedimiento de optimización bayesiano con presupuesto limitado para extraer propiedades de un algoritmo de caja negra.

2020

- Black-Box Ripper: copia de modelos de caja negra utilizando algoritmos evolutivos generativos - (NeurIPS) Replica la funcionalidad de un modelo neuronal de caja negra, pero sin límite en la cantidad de consultas (a través de un esquema de profesor/estudiante y una búsqueda evolutiva) .

- Auditar las vías de radicalización en - (FAT*) Estudia la accesibilidad de los canales radicales entre sí, utilizando recorridos aleatorios sobre recomendaciones de canales estáticos.

- Extracción de modelos adversarios en redes neuronales de gráficos: (Taller AAAI sobre aprendizaje profundo en gráficos: metodologías y aplicaciones) Presenta la extracción de modelos GNN y presenta un enfoque preliminar para esto.

- La explicabilidad remota enfrenta el problema del gorila - (Nature Machine Intelligence volumen 2, páginas 529–539) (Código) Muestra la imposibilidad (con una solicitud) o la dificultad de detectar mentiras en las explicaciones de una decisión de IA remota.

- GeoDA: un marco geométrico para ataques adversarios de caja negra - (CVPR) (Código) Crea ejemplos adversarios para engañar a los modelos, en una configuración de caja negra pura (sin gradientes, solo clase inferida).

- El juego de la imitación: selección de algoritmos mediante la explotación del recomendador de caja negra - (Netys) (código) Parametrice un algoritmo de recomendación local imitando la decisión de uno remoto y mejor capacitado.

- Auditoría de sistemas de curación de noticias: un estudio de caso que examina la lógica algorítmica y editorial en Apple News - (ICWSM) Estudio de auditoría de Apple News como sistema de curación de noticias sociotécnicas (sección de historias de actualidad).

- Algoritmos de auditoría: sobre las lecciones aprendidas y los riesgos de la minimización de datos - (AIES) Una auditoría práctica para una aplicación de recomendación de bienestar desarrollada por Telefónica (principalmente sesgada).

- Extracción de datos de entrenamiento de modelos de lenguaje grandes: (arxiv) Realiza un ataque de extracción de datos de entrenamiento para recuperar ejemplos de entrenamiento individuales consultando el modelo de lenguaje.

2019

- Adversarial Frontier Stitching para marcas de agua de redes neuronales remotas - (Computación neuronal y aplicaciones) (Implementación alternativa) Compruebe si un modelo de aprendizaje automático remoto es uno "filtrado": a través de solicitudes API estándar a un modelo remoto, extraiga (o no) un cero- marca de agua de bits, que se insertó para marcar con agua modelos valiosos (por ejemplo, grandes redes neuronales profundas).

- Redes de imitación: robo de funcionalidad de modelos de caja negra - (CVPR) Pregunte hasta qué punto puede un adversario robar la funcionalidad de dichos modelos de "víctima" basándose únicamente en interacciones de caja negra: imagen que entra, predicciones que salen.

- Abriendo la caja negra: auditoría del algoritmo de noticias destacadas de Google: (Flairs-32) Auditoría del panel de noticias destacadas de Google que proporciona información sobre sus opciones algorítmicas para seleccionar y clasificar a los editores de noticias.

- Hacer que los ataques de evasión de caja negra dirigidos sean efectivos y eficientes: (arXiv) Investiga cómo un adversario puede utilizar de manera óptima su presupuesto de consultas para ataques de evasión dirigidos contra redes neuronales profundas.

- Aprendizaje en línea para medir la compatibilidad de incentivos en subastas de anuncios: (WWW) Mide los mecanismos (arrepentimiento) de compatibilidad de incentivos (IC) de las plataformas de subastas de caja negra.

- TamperNN: Detección eficiente de manipulación de redes neuronales implementadas - (ISSRE) Algoritmos para crear entradas que puedan detectar la manipulación con un modelo clasificador ejecutado de forma remota.

- Ataques de extracción de modelos de redes neuronales en dispositivos perimetrales al escuchar sugerencias arquitectónicas - (arxiv) Mediante la adquisición de eventos de acceso a la memoria a partir del espionaje del bus, la identificación de la secuencia de capas mediante el modelo LSTM-CTC, la conexión de la topología de las capas de acuerdo con el patrón de acceso a la memoria y la estimación de la dimensión de las capas bajo limitaciones de volumen de datos, demuestra que se puede recuperar con precisión una arquitectura de red similar al punto de partida del ataque

- Robo de conocimiento de redes neuronales profundas protegidas utilizando datos compuestos sin etiquetar: (ICNN) Método compuesto que se puede utilizar para atacar y extraer el conocimiento de un modelo de caja negra incluso si oculta por completo su salida softmax.

- Inversión de redes neuronales en un entorno adversario mediante alineación de conocimientos previos: (CCS) Enfoque de inversión del modelo en un entorno adversario basado en el entrenamiento de un modelo de inversión que actúa como un inverso del modelo original. Sin un conocimiento completo de los datos de entrenamiento originales, aún es posible realizar una inversión precisa entrenando el modelo de inversión en muestras auxiliares extraídas de una distribución de datos más genérica.

2018

- Explicaciones contrafactuales sin abrir la caja negra: decisiones automatizadas y el RGPD - (Harvard Journal of Law & Technology) Para explicar una decisión sobre x, encuentre un contrafactual: el punto más cercano a x que cambia la decisión.

- Destilar y comparar: auditoría de modelos de caja negra mediante destilación de modelos transparentes: (AIES) Trata los modelos de caja negra como maestros y entrena modelos de estudiantes transparentes para imitar las puntuaciones de riesgo asignadas por los modelos de caja negra.

- Hacia redes neuronales de caja negra de ingeniería inversa - (ICLR) (Código) Inferir hiperparámetros internos (por ejemplo, número de capas, tipo de activación no lineal) de un modelo de red neuronal remota analizando sus patrones de respuesta a ciertas entradas.

- Ataques exploratorios basados en datos sobre clasificadores de caja negra en dominios adversarios: (Neurocomputación) Ingeniería inversa de modelos de clasificadores remotos (por ejemplo, para evadir una prueba CAPTCHA).

- xGEM: Generación de ejemplos para explicar modelos de caja negra - (arXiv) Busca sesgos en el modelo de caja negra entrenando un modelo generativo implícito no supervisado. Luego resume cuantitativamente el comportamiento del modelo de caja negra perturbando muestras de datos a lo largo de la variedad de datos.

- Redes de aprendizaje a partir de similitudes de nodos basados en caminatas aleatorias: (NIPS) Inversión de gráficos mediante la observación de algunos tiempos de viaje de caminatas aleatorias.

- Identificación de la familia de aprendizaje automático a partir de modelos de caja negra: (CAEPIA) Determina qué tipo de modelo de aprendizaje automático está detrás de las predicciones devueltas.

- Robo de redes neuronales a través de canales laterales de sincronización - (arXiv) Robo/aproximación de un modelo mediante ataques de sincronización utilizando consultas.

- Copycat CNN: Robo de conocimiento mediante la persuasión de una confesión con datos aleatorios no etiquetados - (IJCNN) (Código) Robo de conocimiento de modelos de caja negra (CNN) consultándolos con imágenes naturales aleatorias (ImageNet y Microsoft-COCO).

- Auditoría de la personalización y composición de las páginas de resultados de los motores de búsqueda relacionadas políticamente: (WWW) Una extensión de Chrome para encuestar a los participantes y recopilar las páginas de resultados de los motores de búsqueda (SERP) y sugerencias de autocompletar, para estudiar la personalización y la composición.

2017

- Descubriendo libros de cocina de influencia: ingeniería inversa del impacto topológico en los servicios de clasificación de pares - (CSCW) Tiene como objetivo identificar qué métricas de centralidad se utilizan en un servicio de clasificación de pares.

- La cara topológica de la recomendación: modelos y aplicación a la detección de sesgos - (Redes complejas) Propone un marco de detección de sesgos para los elementos recomendados a los usuarios.

- Ataques de inferencia de membresía contra modelos de aprendizaje automático: (Simposio sobre seguridad y privacidad) Dado un modelo de aprendizaje automático y un registro, determine si este registro se utilizó como parte del conjunto de datos de entrenamiento del modelo o no.

- Ataques prácticos de caja negra contra el aprendizaje automático: (Asia CCS) Comprenda cuán vulnerable es un servicio remoto a ataques de clasificación adversarios.

2016

- Transparencia algorítmica mediante influencia de entrada cuantitativa: teoría y experimentos con sistemas de aprendizaje - (IEEE S&P) Evaluar la influencia individual, conjunta y marginal de las características en un modelo utilizando valores de Shapley.

- Auditoría de modelos de caja negra para influencia indirecta: (ICDM) Evalúa la influencia de una variable en un modelo de caja negra eliminándola "inteligentemente" del conjunto de datos y observando la brecha de precisión.

- Proyección iterativa de características ortogonales para diagnosticar sesgos en modelos de caja negra: (Taller FATML) Realiza clasificación de características para analizar modelos de caja negra

- Sesgo en los mercados independientes en línea: evidencia de TaskRabbit - (taller de datos) Mide la clasificación del algoritmo de búsqueda de TaskRabbit.

- Robo de modelos de aprendizaje automático a través de API de predicción: (Seguridad Usenix) (Código) Tiene como objetivo extraer modelos de aprendizaje automático utilizados por servicios remotos.

- “¿Por qué debería confiar en usted?” Explicando las predicciones de cualquier clasificador - (arXiv) (Código) Explica un modelo de clasificador de caja negra mediante muestreo de instancias de datos.

- De nuevo en negro: hacia un análisis formal de caja negra de desinfectantes y filtros - (Seguridad y privacidad) Análisis de caja negra de desinfectantes y filtros.

- Transparencia algorítmica a través de la influencia cuantitativa de las entradas: teoría y experimentos con sistemas de aprendizaje - (Seguridad y privacidad) Introduce medidas que capturan el grado de influencia de las entradas sobre las salidas del sistema observado.

- Un análisis empírico de precios algorítmicos en Amazon Marketplace - (WWW) (Código) Desarrolla una metodología para detectar precios algorítmicos y utilizarla empíricamente para analizar su prevalencia y comportamiento en Amazon Marketplace.

2015

- Certificar y eliminar impactos dispares: (SIGKDD) Propone métodos basados en SVM para certificar la ausencia de sesgos y métodos para eliminar sesgos de un conjunto de datos.

- Mirando debajo del capó de Uber - (IMC) Inferir detalles de implementación del algoritmo de aumento de precios de Uber.

2014

- Un vistazo a la caja negra: exploración de clasificadores mediante aleatorización - (revista de minería de datos y descubrimiento de conocimientos) (código) Encuentra grupos de características que se pueden permutar sin cambiar la etiqueta de salida de las muestras predichas

- XRay: mejora de la transparencia de la Web con correlación diferencial: (Seguridad USENIX) Audita qué datos de perfil de usuario se utilizaron para orientar un anuncio, recomendación o precio en particular.

2013

- Medición de la personalización de la búsqueda web - (WWW) Desarrolla una metodología para medir la personalización en los resultados de la búsqueda web.

- Auditoría: aprendizaje activo con costos de consulta dependientes de los resultados: (NIPS) Aprende de un clasificador binario que paga solo por etiquetas negativas.

2012

- Estrategias de consulta para evadir clasificadores inductores convexos - (JMLR) Métodos de evasión para clasificadores convexos. Considera la complejidad de la evasión.

2008

- Privacy Oracle: un sistema para encontrar fugas de aplicaciones con pruebas diferenciales de caja negra - (CCS) Privacy Oracle: un sistema que descubre fugas de información personal de aplicaciones en transmisiones a servidores remotos.

2005

- Aprendizaje adversario: (KDD) Ingeniería inversa de clasificadores lineales remotos, utilizando consultas de membresía.

Eventos relacionados

2024

- 1er Congreso Internacional de Auditoría e Inteligencia Artificial

- Taller de ML regulable (RegML'24)

2023

- Respaldar la participación de los usuarios en las pruebas, auditorías y impugnaciones de la IA (auditoría de IA de usuarios de CSCW)

- Taller sobre Auditorías Algorítmicas de Algoritmos (WAAA)

- Taller de ML regulable (RegML'23)