Diseñamos un novedoso marco de reconstrucción basado en DL para abordar el problema de la recuperación rápida y de alta calidad de imágenes en imágenes de un solo píxel.

Bienvenido a mirar ? este repositorio para obtener las últimas actualizaciones.

✅ [2023.12.18] : ¡Hemos publicado nuestro código!

✅ [2021.07.21] : Hemos publicado nuestro artículo, SPI-GAN en arXiv.

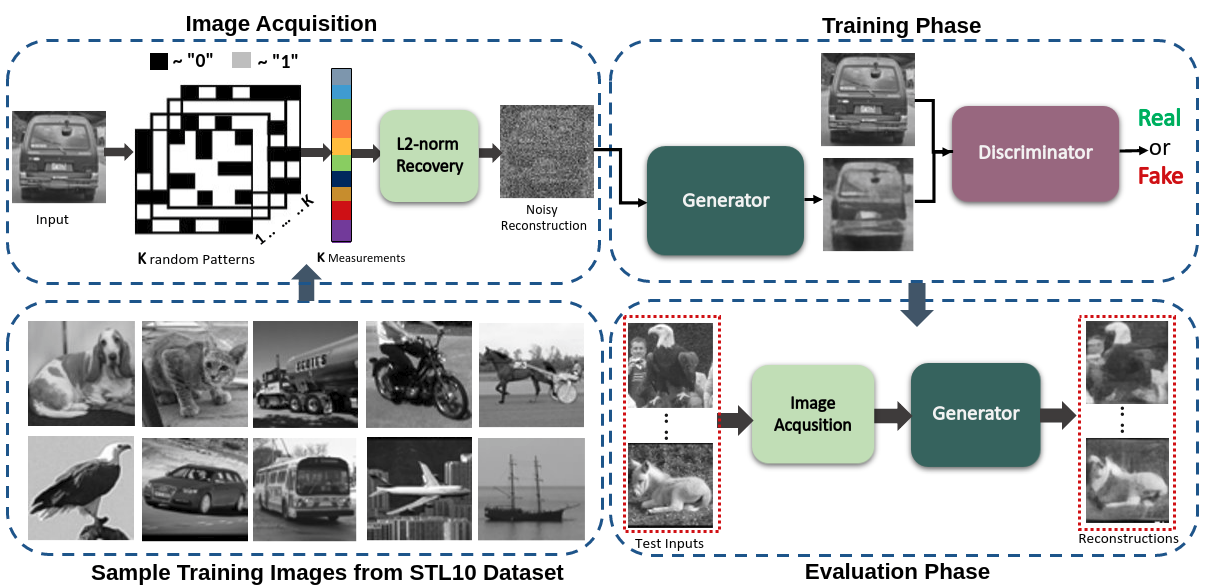

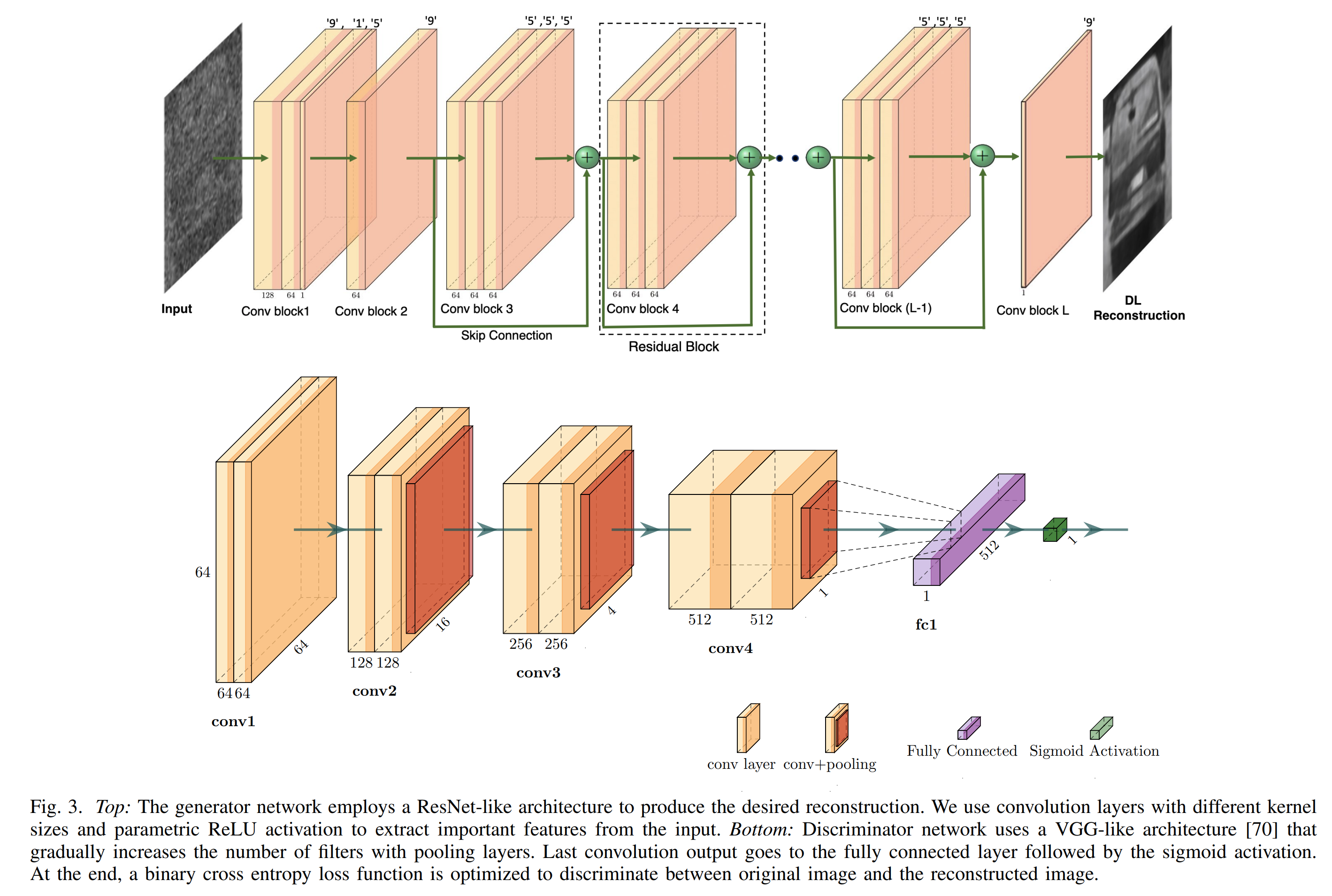

Nuestro marco SPI-GAN propuesto consiste principalmente en un generador que toma la solución ruidosa de norma l2 (xˆ_noisy) y produce una reconstrucción clara (xˆ) que es comparable a x. Por otro lado, un discriminador aprende a diferenciar entre x y xˆ en un intento de no dejarse engañar por el generador.

Nuestro marco SPI-GAN propuesto consiste principalmente en un generador que toma la solución ruidosa de norma l2 (xˆ_noisy) y produce una reconstrucción clara (xˆ) que es comparable a x. Por otro lado, un discriminador aprende a diferenciar entre x y xˆ en un intento de no dejarse engañar por el generador.

Instale Anaconda y cree un entorno.

conda create -n spi_gan python=3.10

conda activate spi_ganDespués de crear un entorno virtual, ejecute

pip install -r requirements.txtPrimero descargue los conjuntos de datos STL10 y UCF101. Puede encontrar ambos conjuntos de datos muy fácilmente.

Si desea crear las imágenes que se enviarán a la GAN, ejecute el código de Matlab "L2Norm_Solution.m" para generar la solución l2-norm. Cree las carpetas necesarias antes de ejecutar. También subiré la versión Python de esto en el futuro.

Ejecute esto para crear el archivo .npy con diferentes configuraciones

python save_numpy.pyPara entrenar-

python Main_Reconstruction.pyDescarga vídeos y divisiones de entrenamiento/prueba aquí.

Convierta archivos avi a jpg usando util_scripts/generate_video_jpgs.py

python -m util_scripts.generate_video_jpgs avi_video_dir_path jpg_video_dir_path ucf101 Genere un archivo de anotaciones en formato json similar a ActivityNet usando util_scripts/ucf101_json.py

annotation_dir_path incluye classInd.txt, trainlist0{1, 2, 3}.txt, testlist0{1, 2, 3}.txt

python -m util_scripts.ucf101_json annotation_dir_path jpg_video_dir_path dst_json_path

Si encuentra que nuestro artículo y nuestro código son útiles en su investigación, considere otorgar una estrella y una cita.

@misc { karim2021spigan ,

title = { SPI-GAN: Towards Single-Pixel Imaging through Generative Adversarial Network } ,

author = { Nazmul Karim and Nazanin Rahnavard } ,

year = { 2021 } ,

eprint = { 2107.01330 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}