El condicionamiento operante es un paradigma clásico utilizado en psicología experimental en el que los animales aprenden a realizar una acción para lograr una recompensa. Al utilizar este paradigma, es posible extraer curvas de aprendizaje y medir con precisión los tiempos de reacción. Aquí describimos un dispositivo totalmente imprimible en 3D que es capaz de realizar condicionamiento operante en ratones que se mueven libremente, mientras realiza un seguimiento en tiempo real de la posición del animal.

Puedes encontrar modelos impresos en 3D aquí o aquí.

En figuras/VISTA DESPIECE.jpg se muestra un esquema intuitivo del esquema de montaje. Imprimimos todos los componentes usando Cura 4.0 con una resolución media (100 µm), una velocidad de 90 mm/s y un relleno del 20%. El diseño de la cámara OC es bastante simple, por lo que casi todas las impresoras son lo suficientemente precisas como para imprimir con éxito toda la cámara.

Puede encontrar una lista de todos los componentes aquí: Lista de materiales

CÁMARA OC

CÁMARA

ENTREGA

Además necesitas:

Conecte todos los componentes como se describe en figure/diagram_scheme.png

Para instalar el software en Raspberry Pi (RPI), simplemente descargue o copie el código completo en una carpeta del sistema operativo Raspian.

Pitón

arduino

Compile y cargue en el Arduino UNO el sketch llamado skinner.ino

Para calibrar los umbrales de los sensores capacitivos, cargue el boceto de Arduino llamado skinnerCapacitiveTest. Esta función simplemente imprime en los valores del sensor capacitivo del puerto serie. Es útil establecer el valor de umbral adecuado para detectar toques del mouse.

Para ejecutar el código escriba en la terminal:

cd h ome p i o c_chamber \ or replace with the folder path containing the scpript

python3 cvConditioningTracking.pyAlternativamente, abra cvConditioningTracking en IDLE IDE y presione F5.

El usuario puede personalizar algunos de los parámetros de bajo nivel de los experimentos editando el valor de las variables en las primeras 25 líneas del archivo cvConditioningTracking.py. En el propio archivo se proporciona una explicación más detallada de esos parámetros.

La cámara puede realizar experimentos en 2 modos: modo de entrenamiento y modo de permutación . El usuario puede seleccionar uno de los dos modos editando la tarea de parámetros en el archivo cvConditioningTracking. Los detalles y diferencias de los 2 modos se pueden encontrar en el documento.

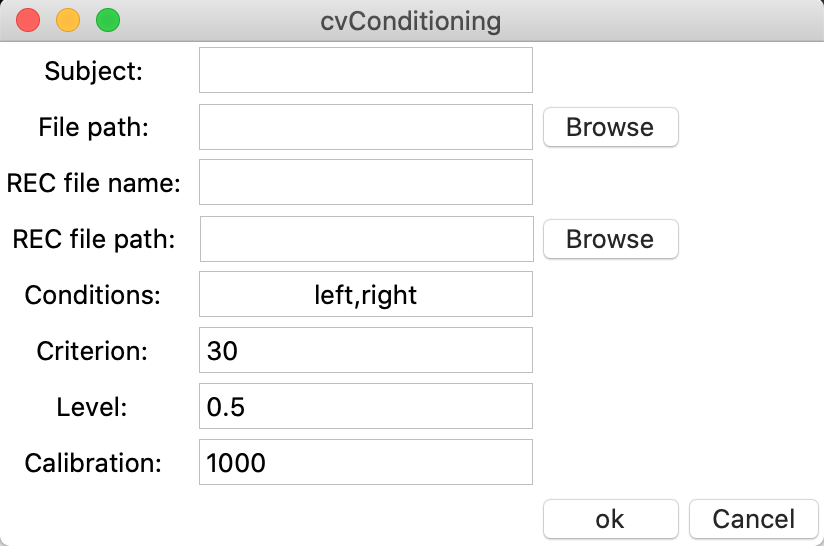

Al comienzo de los experimentos, se muestra al usuario una GUI que recopila información básica sobre los experimentos que están a punto de ejecutarse.

Asunto: una cadena que contiene un identificador para el mouse actual. Si se deja vacío, no se guarda ningún archivo.

Ruta del archivo: ubicación para guardar el archivo del experimento. El resultado consta de dos archivos .txt que contienen el conjunto de datos del experimento como se describe en la sección del conjunto de datos, almacenados dentro de las carpetas DATA y DATAtracker. El usuario puede buscar una ubicación en la PC; si el campo se deja vacío, el valor predeterminado es el directorio de trabajo actual.

Nombre del archivo REC: una cadena que contiene el nombre que se utilizará para guardar la grabación de vídeo. Si se deja vacío, no se guarda ningún archivo.

Ruta del archivo REC: Ubicación para guardar la grabación de video con una superposición que contiene la posición del mouse y el área activa. El usuario puede buscar una ubicación en la PC; si el campo se deja vacío, el valor predeterminado es el directorio de trabajo actual.

Condiciones: Condiciones experimentales. La lista de estímulos que se presentarán en el experimento. Se pueden especificar una o más condiciones, divididas por una coma:

Todas las condiciones aquí especificadas se presentarán en orden aleatorio.

Criterio: Número de fotogramas necesarios para que el ratón permanezca en el área activa para activar una prueba. 20 cuadros = 1 segundo

Nivel: Seleccione la posición vertical de la línea que separa el área activa de la cámara de la inactiva. El valor está normalizado a la altura de la cámara. 0 = parte inferior de la cámara, 1 = parte superior de la cámara, 0,5 (predeterminado) = mitad de la cámara

Calibración: Número de fotogramas que se utilizarán al inicio del experimento para la calibración de la cámara. Es importante calibrar la cámara al comienzo del experimento para rastrear mejor el mouse sobre el fondo.

Otras opciones de personalización están disponibles editando las primeras líneas de los siguientes archivos:

Para permitir el uso de estímulos visuales más complejos, puede encontrar una versión principal del código que funciona con una pantalla LCD. Para ejecutar el código se requiere Psychopy2. Para instalar Psychopy en RPI, siga estas instrucciones. Una vez instalado Psychopy, abra cvConditioningTracking.py en el IDE de Psychopy y ejecute el código. Este código contiene un módulo llamado LCD.py que se puede utilizar para mostrar imágenes seleccionadas. Por ahora, el código es un código auxiliar, una versión no probada y se ejecuta con fines demostrativos.

La carpeta del conjunto de datos contiene nuestros datos sin procesar, descritos en este artículo, con 6 temas. Cada tema está contenido en su propia carpeta y codificado mediante el esquema: CAGE-LABEL-GENO. Además, hay dos Jupyter Notebooks con un ejemplo sobre cómo leer archivos de salida de texto en Python como marcos de datos de pandas.

La descripción detallada del aparato se puede encontrar aquí: Dispositivo imprimible en 3D para el condicionamiento operante automatizado en el ratón

Para cualquier información y solución de problemas no dude en contactarnos en