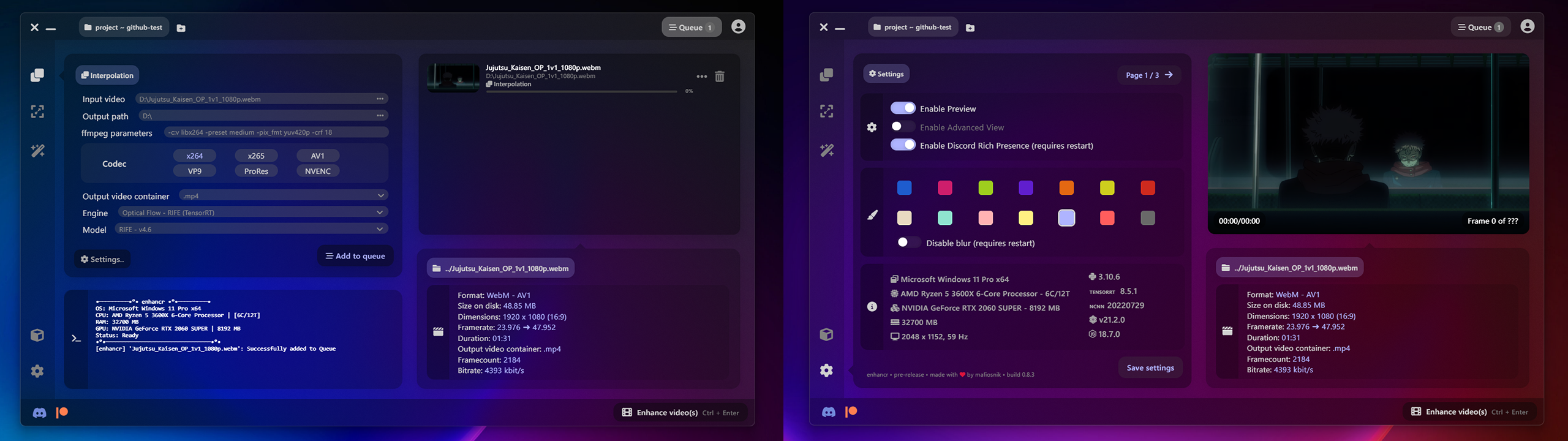

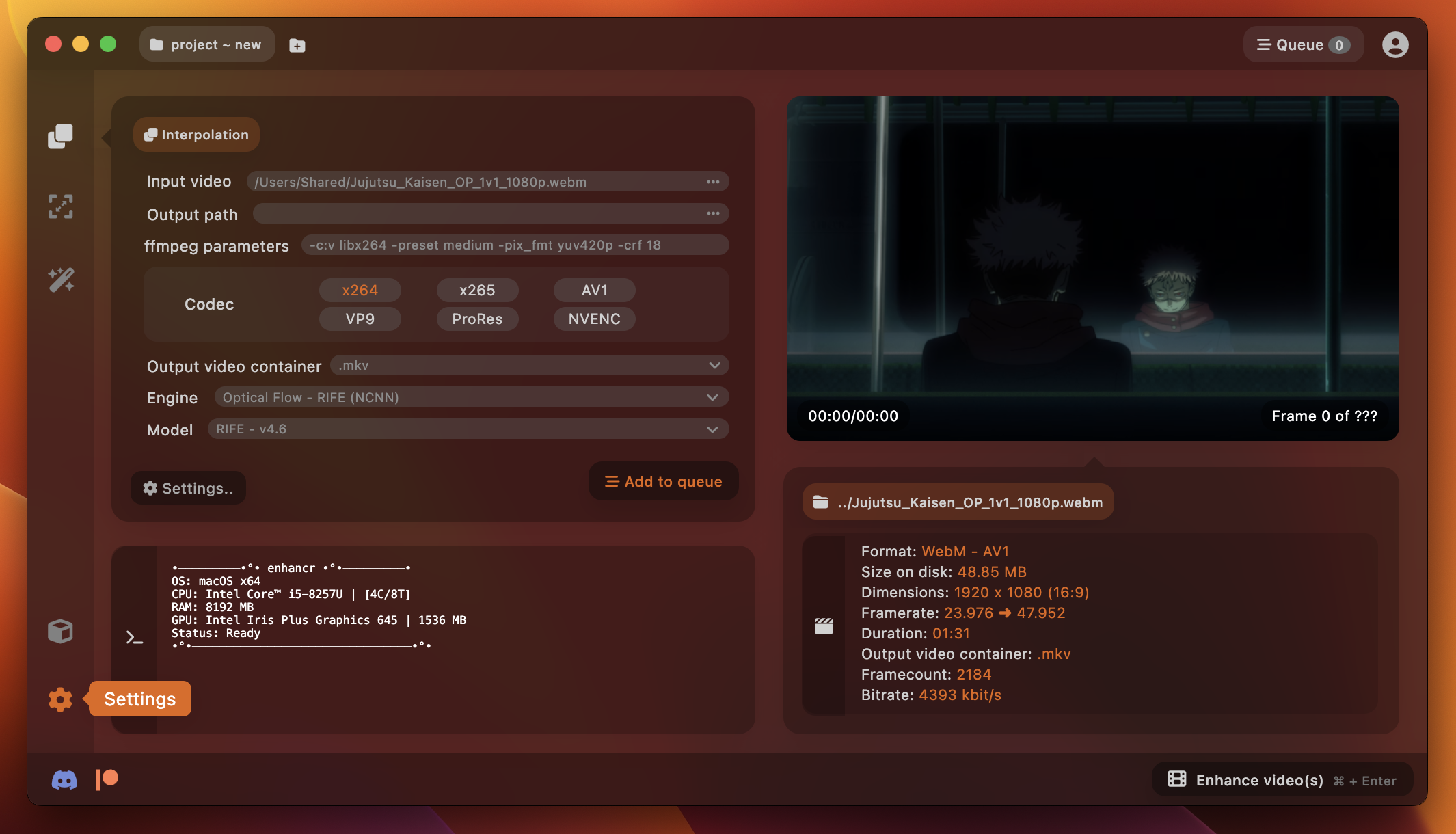

enhancr es una GUI elegante y fácil de usar para interpolación de cuadros de video y mejora de escala de video que aprovecha la inteligencia artificial creada con node.js y Electron . Fue creado para mejorar la experiencia del usuario para cualquier persona interesada en mejorar secuencias de video utilizando inteligencia artificial. La GUI fue diseñada para brindar una experiencia sorprendente impulsada por tecnologías de última generación sin parecer torpe y obsoleta como otras alternativas.

Cuenta con inferencia TensorRT ultrarrápida de NVIDIA, que puede acelerar significativamente los procesos de IA. Preempaquetado, sin necesidad de instalar Docker o WSL (Subsistema de Windows para Linux), y la inferencia NCNN de Tencent, que es liviana y se ejecuta en NVIDIA , AMD e incluso Apple Silicon , a diferencia de la gigantesca inferencia que es PyTorch, que solo se ejecuta en GPU NVIDIA .

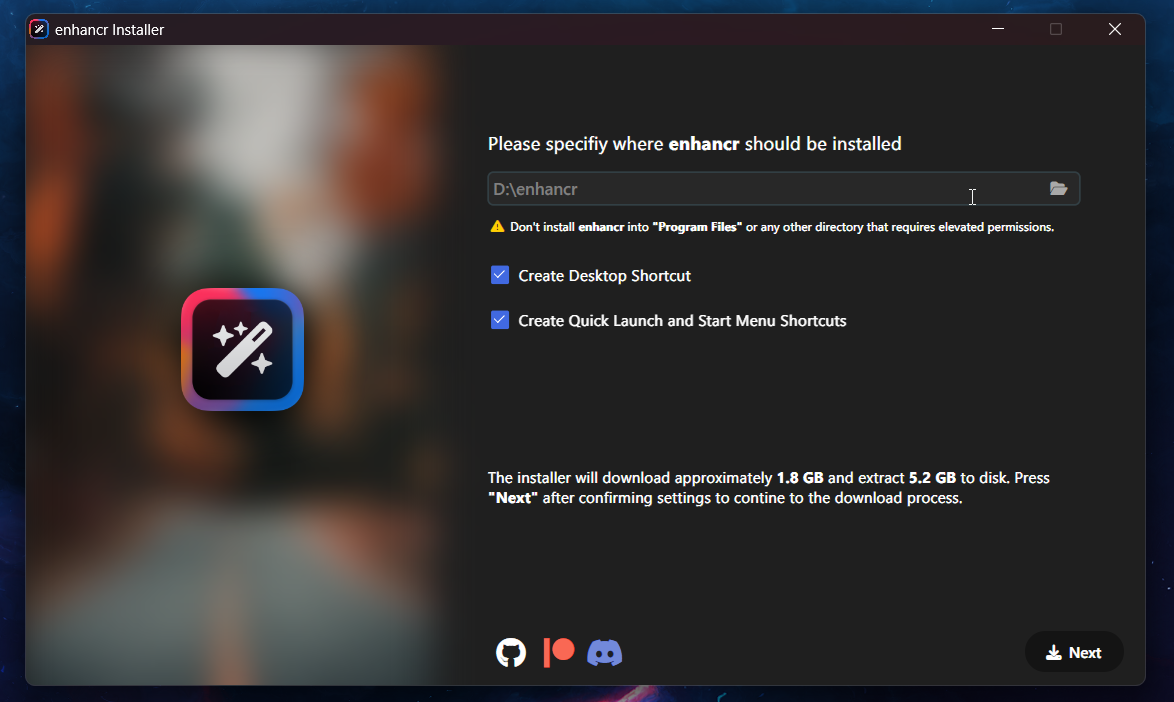

¿La versión 0.9.9 incluye una versión gratuita? https://dl.enhancr.app/setup/enhancr-setup-free-0.9.9.exe

Para asegurarse de tener la versión más reciente del software y todas las dependencias necesarias, le recomendamos descargar el instalador de Patreon. Tenga en cuenta que las compilaciones y un entorno Python integrable para la versión Pro no se proporcionan a través de este repositorio.

RIFE (NCNN) - megvii-research/ ECCV2022-RIFE - impulsado por styler00dollar/ VapourSynth-RIFE-NCNN-Vulkan

RIFE (TensorRT) - megvii-research/ ECCV2022-RIFE - impulsado por AmusementClub/ vs-mlrt & styler00dollar/ VSGAN-tensorrt-docker

GMFSS - Unión (PyTorch/TensorRT) - 98mxr/ GMFSS_Union - impulsado por HolyWu/ vs-gmfss_union

GMFSS - Fortuna (PyTorch/TensorRT) - 98mxr/ GMFSS_Fortuna - impulsado por HolyWu/ vs-gmfss_fortuna

CAIN (NCNN) - myungsub/ CAIN - impulsado por mafiosnik/ vsynth-cain-NCNN-vulkan (inédito)

CAIN (DirectML) - myungsub/ CAIN - impulsado por AmusementClub/ vs-mlrt

CAIN (TensorRT) - myungsub/ CAIN - impulsado por HubertSotnowski/ cain-TensorRT

ShuffleCUGAN (NCNN) - styler00dollar/ VSGAN-tensorrt-docker - impulsado por AmusementClub/ vs-mlrt

ShuffleCUGAN (TensorRT) - styler00dollar/ VSGAN-tensorrt-docker - impulsado por AmusementClub/ vs-mlrt

RealESRGAN (NCNN) - xinntao/ Real-ESRGAN - impulsado por AmusementClub/ vs-mlrt

RealESRGAN (DirectML) - xinntao/ Real-ESRGAN - impulsado por AmusementClub/ vs-mlrt

RealESRGAN (TensorRT) - xinntao/ Real-ESRGAN - impulsado por AmusementClub/ vs-mlrt

RealCUGAN (TensorRT) - bilibili/ ailab/Real-CUGAN - impulsado por AmusementClub/ vs-mlrt

SwinIR (TensorRT) - JingyunLiang/ SwinIR - impulsado por mafiosnik777/ SwinIR-TensorRT (inédito)

DPIR (DirectML) - cszn/ DPIR - impulsado por AmusementClub/ vs-mlrt

DPIR (TensorRT) - cszn/ DPIR - impulsado por AmusementClub/ vs-mlrt

SCUNet (TensorRT) - cszn/ SCUNet - impulsado por mafiosnik777/ SCUNet-TensorRT (inédito)

Nota al margen: a partir de TensorRT 8.6, se eliminó la compatibilidad con Kepler y Maxwell de segunda generación (serie 900 y versiones inferiores). Necesitará al menos una GPU Pascal (serie 1000 y superiores) y una versión del controlador CUDA 12.0 + >= 525.xx para ejecutar la inferencia usando TensorRT.

La GUI se creó teniendo en cuenta la compatibilidad multiplataforma y es compatible con ambos sistemas operativos. Nuestro objetivo principal en este momento es garantizar una solución estable y completamente funcional para los usuarios de Windows, pero la compatibilidad con Linux y macOS estará disponible con la actualización 1.0.

También está previsto el soporte para Apple Silicon. pero actualmente solo tengo una Macbook Pro Intel disponible para probar Conseguiré una instancia de Apple Silicon en Amazon AWS para implementar esto, a tiempo para la versión 1.0.

Tamaño de entrada: 1920x1080 @ 2x

| RTX 2060S 1 | RTX 3070 2 | RTX A4000 3 | RTX 3090Ti 4 | RTX 4090 5 | |

|---|---|---|---|---|---|

| RIFE / rife-v4.6 (NCNN) | 53,78 fps | 64,08 fps | 80,56 fps | 86,24 fps | 136,13 fps |

| RIFE / rife-v4.6 (TensorRT) | 70,34 fps | 94,63 fps | 86,47 fps | 122,68 fps | 170,91 fps |

| CAÍN / cvp-v6 (NCNN) | 9,42 fps | 10,56 fps | 13,42 fps | 17,36 fps | 44,87 fps |

| CAÍN/cvp-v6 (TensorRT) | 45,41 fps | 63,84 fps | 81,23 fps | 112,87 fps | 183,46 fps |

| GMFSS/Arriba (PyTorch) | - | - | 4,32 fps | - | 16,35 fps |

| GMFSS/Unión (PyTorch) | - | - | 3,68 fps | - | 13,93 fps |

| GMFSS/Unión (TensorRT) | - | - | 6,79 fps | - | - |

| RealESRGAN / animevideov3 (TensorRT) | 7,64 fps | 9,10 fps | 8,49 fps | 18,66 fps | 38,67 fps |

| RealCUGAN (TensorRT) | - | - | 5,96 fps | - | - |

| SwinIR (PyTorch) | - | - | 0,43 fps | - | - |

| DPIR / Eliminación de ruido (TensorRT) | 4,38 fps | 6,45 fps | 5,39 fps | 11,64 fps | 27,41 fps |

1 Ryzen 5 3600X - Gainward RTX 2060 Super @ Stock

2 Ryzen 7 3800X - Gigabyte RTX 3070 Eagle OC en stock

3 Ryzen 5 3600X - PNY RTX A4000 en stock

4 i9 12900KF - ASUS RTX 3090 Ti Strix OC @ ~2220MHz

5 Ryzen 9 5950X - ASUS RTX 4090 Strix OC - @ ~3100MHz con curva para lograr el máximo rendimiento

Esta sección se ha trasladado a la wiki: https://github.com/mafiosnik777/enhancr/wiki

Échale un vistazo para obtener más información sobre cómo aprovechar al máximo Enhancr o cómo solucionar varios problemas.

TensorRT es un tiempo de ejecución de inferencia de IA altamente optimizado para GPU NVIDIA. Utiliza evaluaciones comparativas para encontrar el kernel óptimo para su GPU específica, y hay un paso adicional para construir un motor en la máquina en la que va a ejecutar la IA. Sin embargo, el rendimiento resultante también suele ser mucho mejor que el de cualquier implementación de PyTorch o NCNN.

NCNN es un marco informático de inferencia de redes neuronales de alto rendimiento optimizado para plataformas móviles. NCNN no tiene dependencias de terceros. Es multiplataforma y se ejecuta más rápido que todos los marcos de código abierto conocidos en la mayoría de las plataformas principales. Es compatible con NVIDIA, AMD, Intel Graphics e incluso Apple Silicon. NCNN se utiliza actualmente en muchas aplicaciones de Tencent, como QQ, Qzone, WeChat, Pitu, etc.

Le agradecería que pudiera mostrar su apoyo a este proyecto contribuyendo en Patreon o mediante una donación en PayPal. Su apoyo ayudará a acelerar el desarrollo y traer más actualizaciones al proyecto. Además, si tienes las habilidades, también puedes contribuir abriendo una solicitud de extracción. Independientemente de la forma de apoyo que elija brindar, sepa que será muy apreciado.

Trabajo continuamente para mejorar el código base, incluida la solución de cualquier inconsistencia que pueda haber surgido debido a limitaciones de tiempo. Se publicarán actualizaciones periódicas, incluidas nuevas funciones, correcciones de errores y la incorporación de nuevas tecnologías y modelos a medida que estén disponibles. Gracias por su comprensión y apoyo.

Nuestro reproductor depende de mpv y ModernX para OSC.

Gracias a HubertSontowski y styler00dollar por ayudarnos a implementar CAIN.

Para interactuar con la comunidad, compartir sus resultados u obtener ayuda cuando encuentre algún problema, visite nuestro discordia. Allí también se mostrarán avances de las próximas versiones.