Destaca CoDA y compártelo. Gracias

[Artículo] [Página del proyecto]

Yang Cao, Yihan Zeng, Hang Xu, Dan Xu

La Universidad de Ciencia y Tecnología de Hong Kong

Laboratorio del Arca de Noé de Huawei

Actualizaciones

☑ Como el primer trabajo para introducir el 3D Gaussian Splatting en la detección de objetos 3D, ¡3DGS-DET se lanza aquí!

☑ Nuestro trabajo extendido CoDAv2 ha sido lanzado, ¡compruébalo en arXiv!

☑ Aquí se recopilan los últimos artículos y códigos sobre la percepción del vocabulario abierto.

☑ ¡Se han publicado todos los códigos, datos y modelos previamente entrenados!

☑ Se han publicado los códigos de formación y prueba.

☑ Se han lanzado los modelos previamente entrenados.

☑ Se han publicado los conjuntos de datos SUN-RGBD de configuración de OV.

☑ Se han publicado los conjuntos de datos ScanNet de configuración de OV.

☑ Los códigos LaTeX en papel están disponibles en https://scienhub.com/Yang/CoDA.

Nuestro código está basado en PyTorch 1.8.1, torchvision==0.9.1, CUDA 10.1 y Python 3.7. Puede funcionar con otras versiones.

Instale también las siguientes dependencias de Python:

matplotlib

opencv-python

plyfile

'trimesh>=2.35.39,<2.35.40'

'networkx>=2.2,<2.3'

scipy

Instale las capas pointnet2 ejecutando

cd third_party/pointnet2 && python setup.py install

Instale una implementación Cythonized de gIOU para un entrenamiento más rápido.

conda install cython

cd utils && python cython_compile.py build_ext --inplace

Para lograr la configuración OV, reorganizamos el ScanNet y SUN RGB-D originales y adoptamos anotaciones de más categorías. Descargue directamente los conjuntos de datos de configuración de OV que proporcionamos aquí: OV SUN RGB-D y OV ScanNet. También puedes descargarlos fácilmente ejecutando:

bash data_download.sh

Luego ejecute el archivo *.tar descargado:

bash data_preparation.sh

Descargue los modelos previamente entrenados aquí. Luego ejecuta:

bash test_release_models.sh

bash scripts/coda_sunrgbd_stage1.sh

bash scripts/coda_sunrgbd_stage2.sh

bash run_samples.sh

Si CoDA es útil, cite:

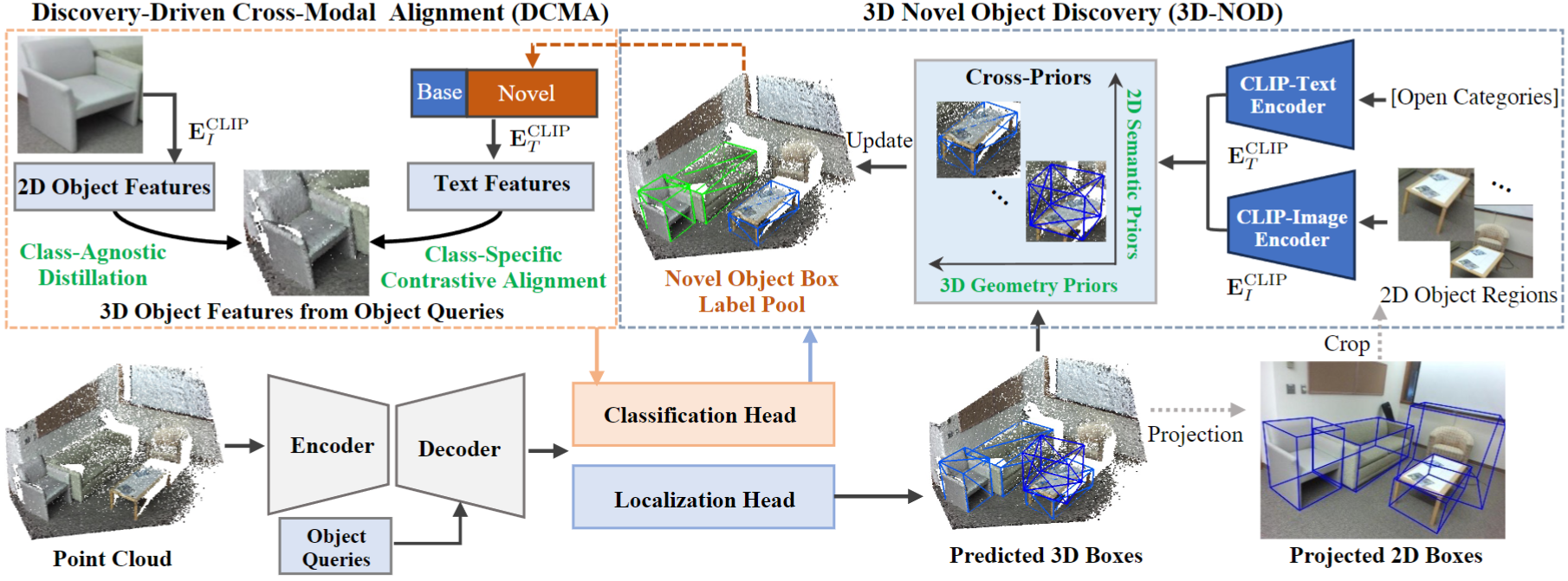

@inproceedings{cao2023coda,

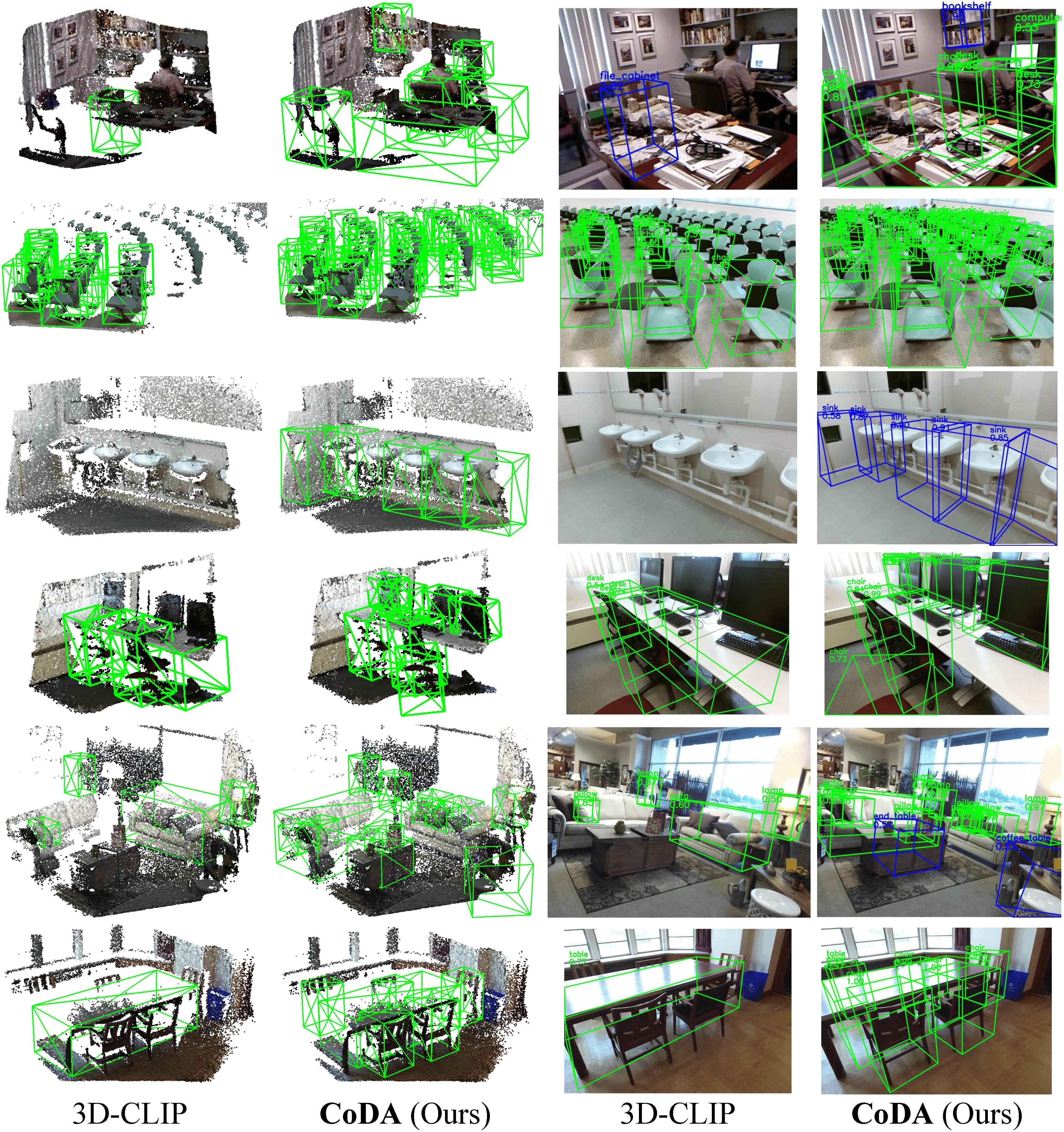

title={CoDA: Collaborative Novel Box Discovery and Cross-modal Alignment for Open-vocabulary 3D Object Detection},

author={Cao, Yang and Zeng, Yihan and Xu, Hang and Xu, Dan},

booktitle={NeurIPS},

year={2023}

}

@misc{cao2024collaborative,

title={Collaborative Novel Object Discovery and Box-Guided Cross-Modal Alignment for Open-Vocabulary 3D Object Detection},

author={Yang Cao and Yihan Zeng and Hang Xu and Dan Xu},

year={2024},

eprint={2406.00830},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2406.00830},

}

Si tiene alguna pregunta o necesidad de colaboración (con fines de investigación o fines comerciales), envíe un correo electrónico [email protected] .

CoDA está inspirado en CLIP y 3DETR. Apreciamos sus fantásticos códigos.