Importante

2024.10.10: cirugía, restauración de emergencia del servidor de archivos que proporciona el paquete WHL

2024.10.8: Versión 3..90 Agregar soporte preliminar para Llama-Desex, Versión 3.80 Agrega la función de menú secundario de complemento (consulte Wiki para más detalles)

2024.5.1: Agregue la función del documento PDF de traducción DOC2X, Ver detalles

2024.3.11: ¡Apoye totalmente modelos de idiomas grandes chinos como Qwen, GLM, Deepseekcoder! Sovits Módulo de clonación de voz, Ver detalles 2024.1.17: Al instalar dependencias, seleccione la versión especificada en requirements.txt . Comando de instalación: pip install -r requirements.txt . Este proyecto es completamente abierto y gratuito.

Si te gusta este proyecto, dale una estrella;

Si te gusta este proyecto, dale una estrella multi_language.py

Nota

1. La función de cada archivo en este proyecto es el informe de auto -traducción self_analysis.md . Con la iteración de la versión, también puede hacer clic en el enchufe de la función relevante en cualquier momento para llamar al informe de auto -parsante de re -generación de GPT. Para preguntas comunes, consulte Wiki.

2. Este proyecto es compatible y fomenta el juicio de modelos de base de idioma chino grande y doméstico como Tongyi Qianqian, Wisdom Spectrum GLM, etc. Admite múltiples API-Key Key Coexistence, puede completar el archivo de configuración, como API_KEY="openai-key1,openai-key2,azure-key3,api2d-key4" . Cuando necesite reemplazar temporalmente API_KEY , ingrese el API_KEY temporal en el área de entrada y luego envíelo a la clave de viaje para entrar en vigencia.

| Función (= nuevas características recientes) | describir |

|---|---|

| Nuevo modelo | Baidu Qianfan y Wenxin dijeron, Tongyi Qian Qi Qwen, Shanghai Ai-Lab Scholar, Xun Feixing Fire, Llama2, Speed Speed Glm4, Dalle3, Deepseekcoder |

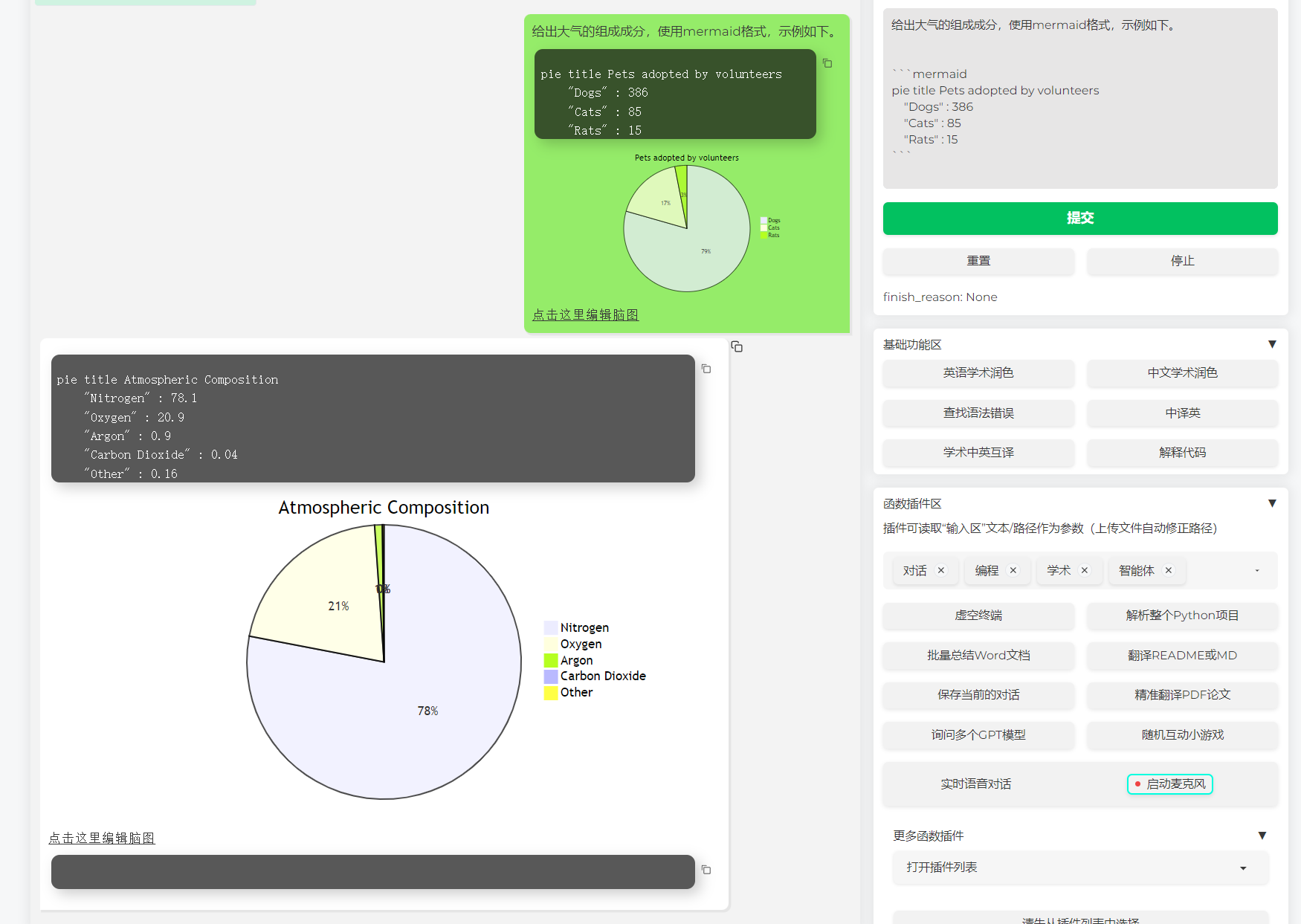

| Admitir representación de imágenes de sirena | Soporte para permitir que GPT genere diagramas de flujo, diagramas de transferencia de estado, mapas GAND, pasteles, gitgraph, etc. (Versión 3.7) |

| Tesis de Arxiv Traducción fina (Docker) | [Plug -in] traducción de un clic de la tesis ARXIV con un solo clic, la mejor herramienta de traducción en papel actualmente |

| Entrada de diálogo de voz en tiempo real | [Plug -in] audio de escucha asincrónica, desconexión automática de oraciones, encuentre automáticamente el tiempo para responder |

| Complemento Autogen Multi -Smart | [Plug -in] Con la ayuda de Microsoft Autogen, explore la posibilidad de la aparición inteligente del agente duo! |

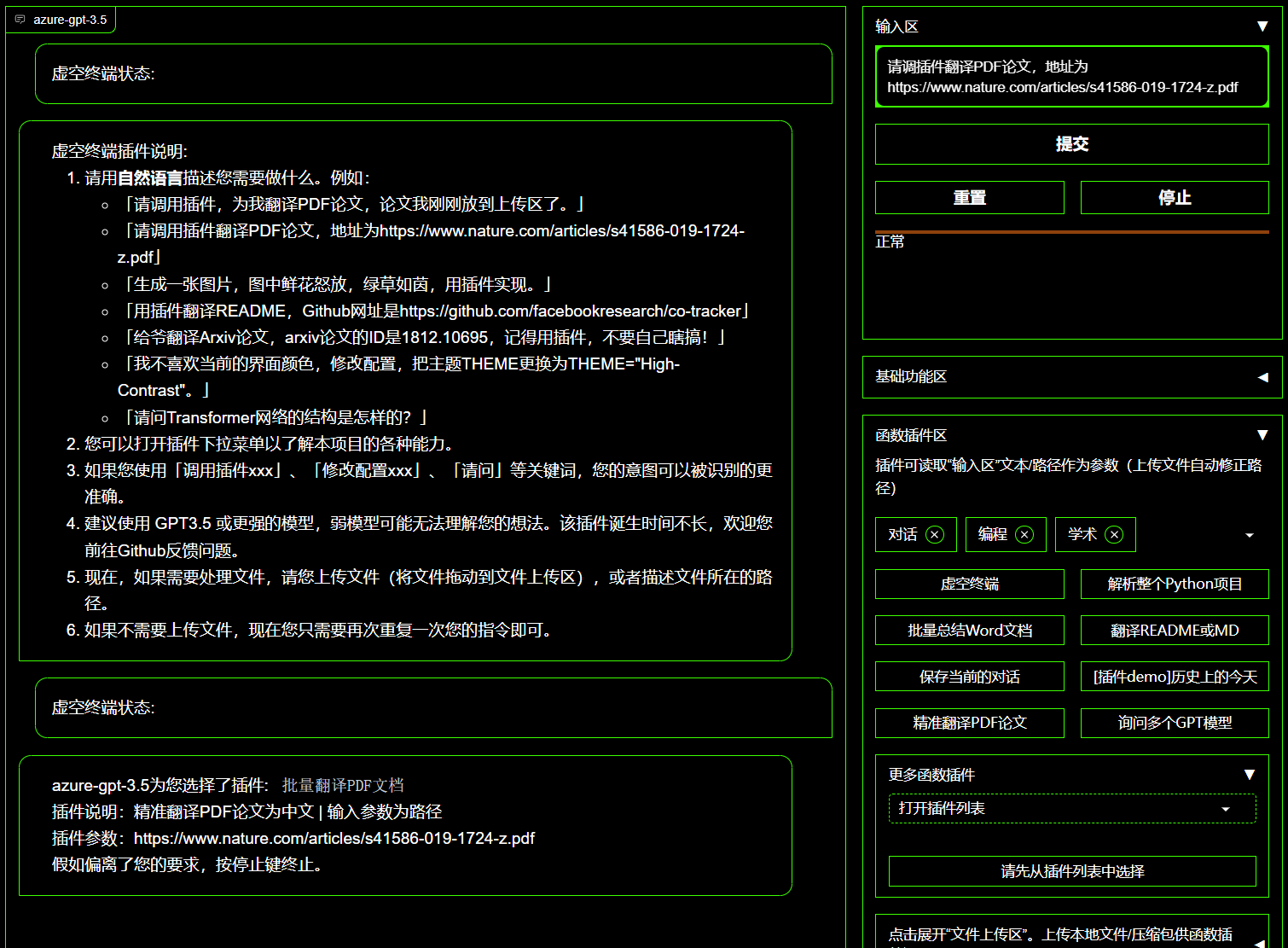

| Complemento de terminal vacío | [Plug -in] puede programar directamente otro plug -in en este proyecto en lenguaje natural |

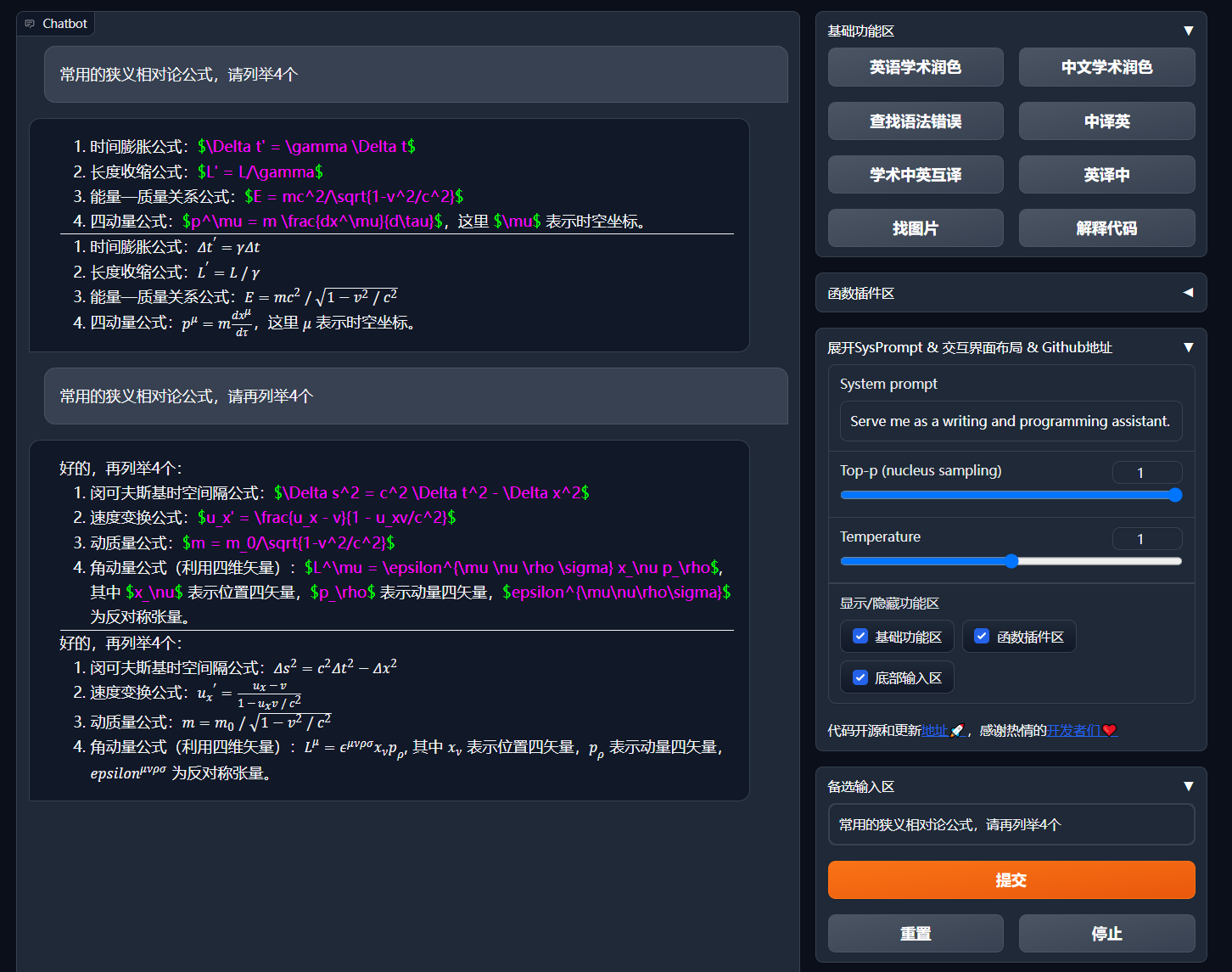

| Interpretación del color, traducción, explicación del código | Hidratación de un solo clic, Traducción, Encontrar errores de gramática de documentos, código de interpretación |

| Clave de acceso directo personalizado | Soporte de teclas de acceso directo personalizado |

| Diseño modular | Admitir el plug -in sólido personalizado, plug -in admite actualizaciones en caliente |

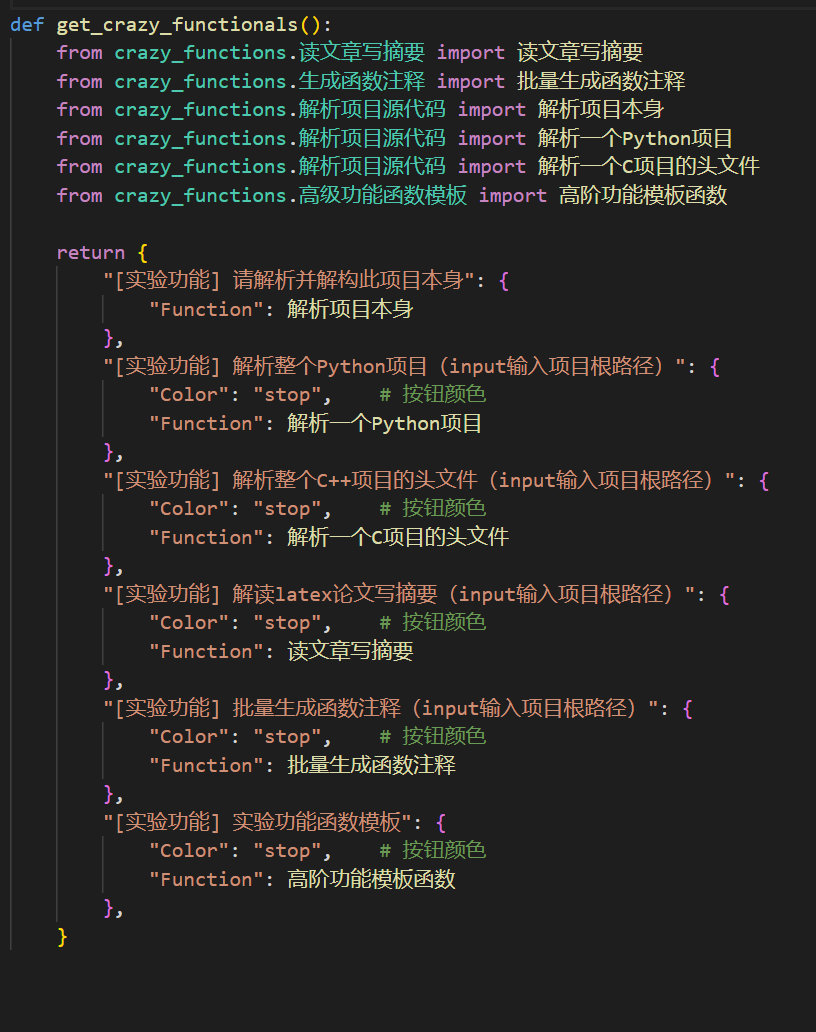

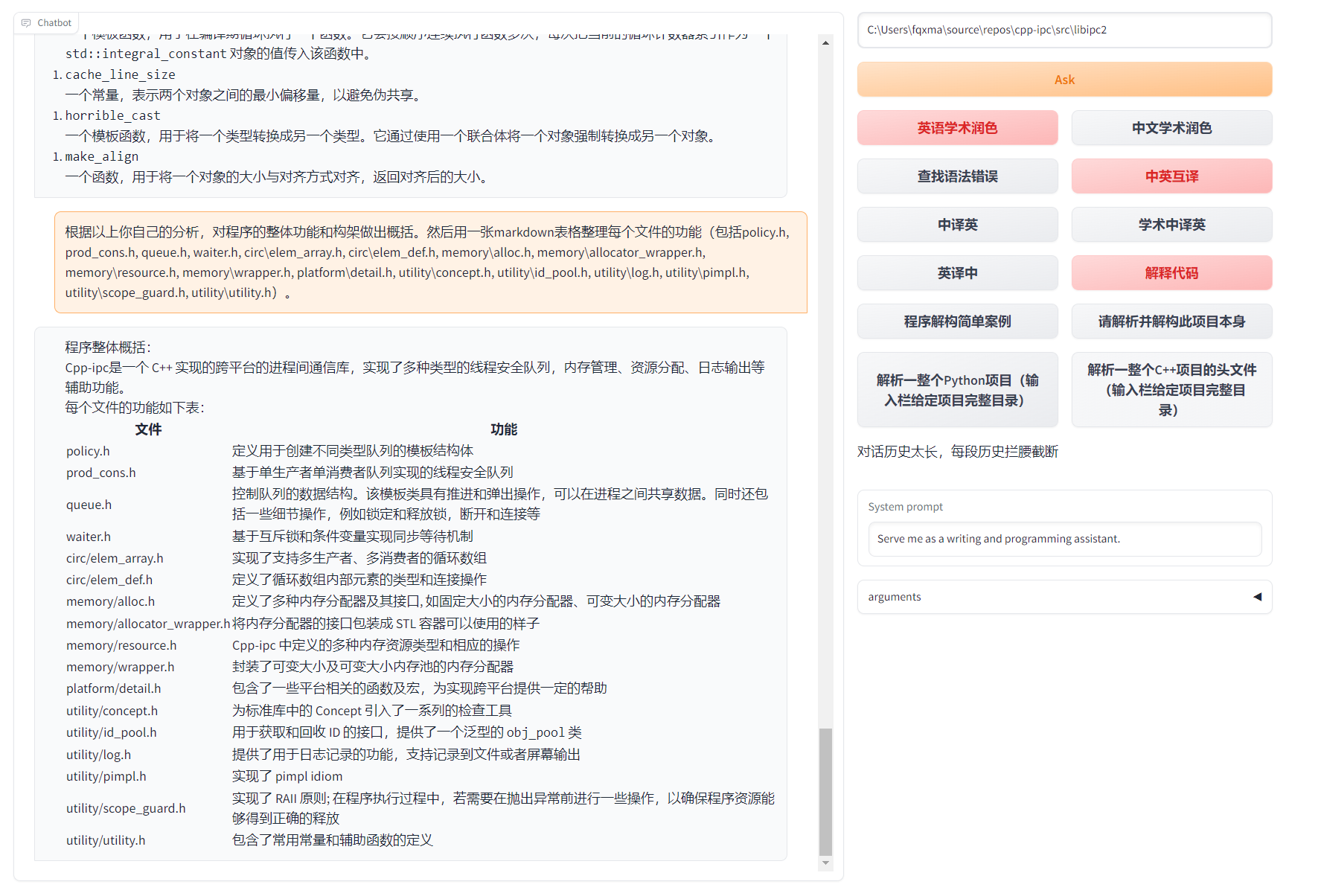

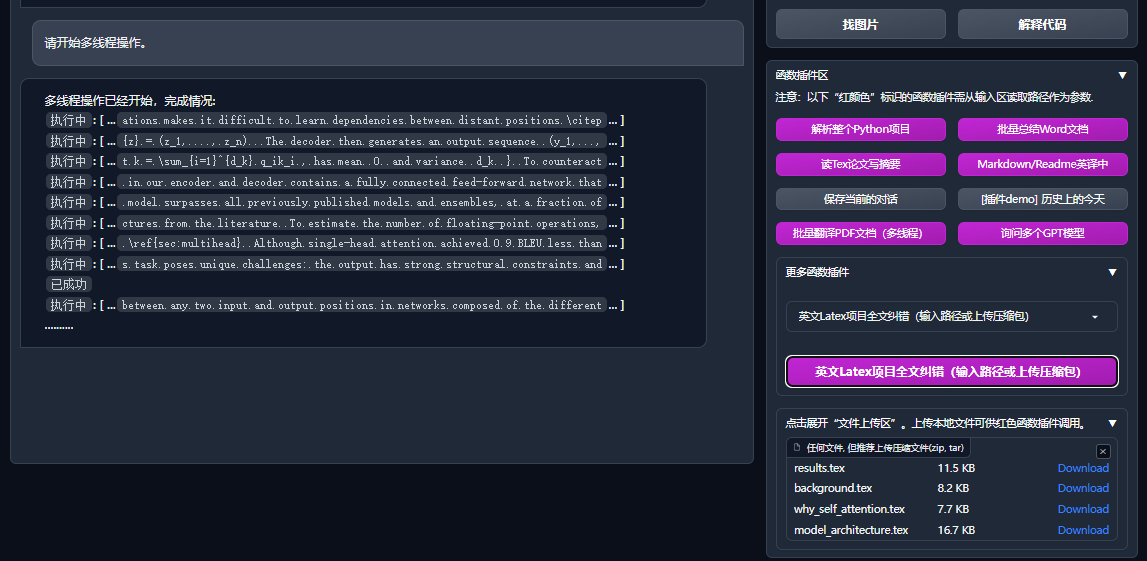

| Análisis de programas | [Plug -in] Análisis de un clic de Python/C/C ++/java/lua/... árbol de proyecto o autoanálisis |

| Lea el documento, Traduce la tesis | [Plug -in] Interpretación de un clic del latex/pdf Paper Text Full Text and Generating Abstracts |

| Traducción de textos completos de látex, hidratación | [Plug -in] traducción de un clic o papel de látex hidratante |

| Anotación por lotes | [Plug -in] anotación de funciones de generación de lotes de un solo clic |

| Traducciones mutuas chinas y británicas de Markdown | [Plug -in] ¿Ves el idioma Read 5? Es de su escritura a mano |

| Función de traducción de texto completo en PDF | [Plug -in] PDF Paper Extract Preguntas y resumen+Texto completo de traducción (múltiples huéspedes) |

| Asistente de arxiv | [Plug -in] Ingrese la URL del artículo de ARXIV a un resumen de traducción de un clic+Descargar PDF |

| Papeles de látex One -Haga clic en la escuela | [Plug -in] imitación de gramática a sintaxis, corrección de hechizos+control de salida pdf en artículos de látex |

| Asistente de integración académica de Google | [Plug -in] Dada la URL de la página de búsqueda académica de Ren Italia, deje que GPT lo ayude a escribir trabajos relacionados |

| Agregación de información de Internet+GPT | [Plug -in] Unllock para permitir que GPT obtenga información de Internet y responda preguntas, de modo que la información nunca esté desactualizada |

| Pantalla de fórmula/imagen/formulario | Puede mostrar la fórmula y la forma de representación de la fórmula al mismo tiempo, y admitir la fórmula y el código destacado |

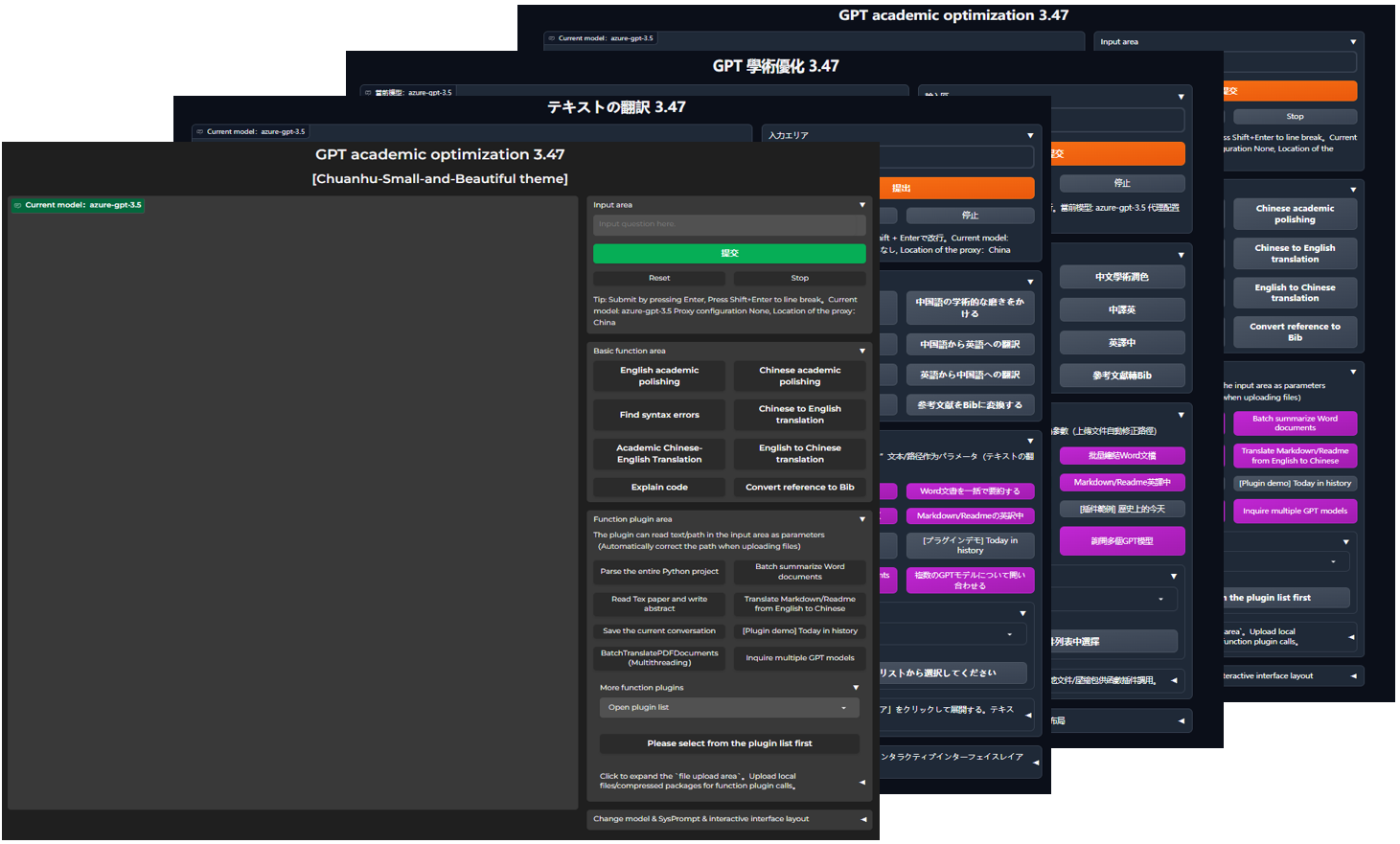

| Iniciar tema oscuro | Agregar /?__theme=dark después de la url del navegador puede cambiar el tema oscuro |

| Soporte del modelo Multi LLM | Al mismo tiempo, la sensación de ser atendida por GPT3.5, GPT4, Tsinghua ChatGlm2, Fudan Moss debe ser muy bueno? |

| Más acceso al modelo de LLM, soporte de implementación de Huggingface | Únase a la interfaz nueva (nueva Must), introduzca Tsinghua Jittorllms para admitir LLAMA y Pangu α |

| paquete de pipo de terminal void | Dejando la GUI, llame directamente a todos los enchufes de función del elemento en Python (en desarrollo) |

| Más visualización de características nuevas (generación de imágenes, etc.) ... | Vea el final de este artículo ... |

config.py para lograr el "diseño de la izquierda" y el "diseño superior e inferior" conmutación)

TD de diagrama de flujo

A {"Método de instalación"} -> w1 ("i.? Ejecutar directamente (Windows, Linux o macOS)")))

W1-> W11 ["1. Dependencia de gestión de paquetes Python Pip"]

W1-> W12 ["2. Dependencias de gestión de paquetes de Anaconda (recomendación)"]]

A -> w2 ["ii.? Use Docker (Windows, Linux o macOS)"]]

W2-> K1 ["1. Imagen de espejo grande que implementa todas las capacidades (recomendación)"]]

W2-> K2 ["2. Solo modelo en línea (GPT, GLM4, etc.) Mirror"]

W2-> K3 ["3. Modelo en línea+ Mirror grande de Latex"]

A -> w4 ["iv. Otros métodos de implementación"]]

W4-> C1 ["1. Windows/MacOS One -Click Instalación y Ejecutar Script (Recomendación)"]

W4-> C2 ["2. Huggingface, implementación remota de feas"]]

W4-> c4 ["3 ... otros ..."]]

Descargar proyecto

git clone --depth=1 https://github.com/binary-husky/gpt_academic.git

cd gpt_academicConfigurar API_Key y otras variables

En config.py , configure variables como la tecla API. Método especial de configuración de entorno de red, descripción de configuración del proyecto wiki.

"El programa dará prioridad a la verificación de si hay un archivo de configuración privado llamado config_private.py , y configurar el mismo nombre con la configuración de config.py . Si puede comprender la lógica de lectura anterior, recomendamos encarecidamente que cree debajo del config_private.py misma config_private.py de la ruta config.py .

"Apoye el elemento de configuración环境变量, consulte el archivo docker-compose.yml o nuestra página wiki del formato de escritura de la variable de entorno. Prioridad de lectura de configuración:环境变量> config_private.py > config.py ".

Dependencia de la instalación

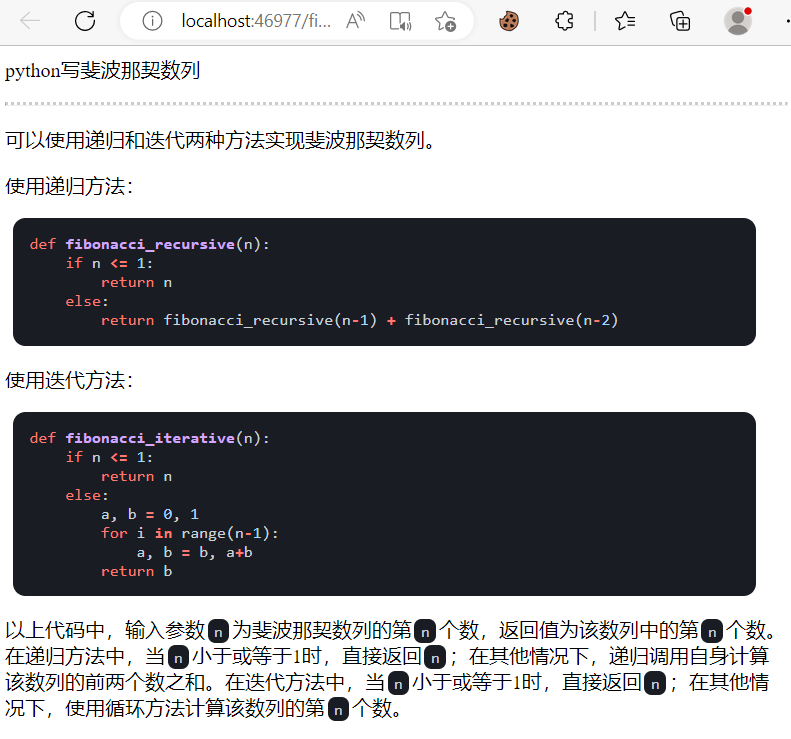

# (选择I: 如熟悉python, python推荐版本 3.9 ~ 3.11)备注:使用官方pip源或者阿里pip源, 临时换源方法:python -m pip install -r requirements.txt -i https://mirrors.aliyun.com/pypi/simple/

python -m pip install -r requirements.txt

# (选择II: 使用Anaconda)步骤也是类似的 (https://www.bilibili.com/video/BV1rc411W7Dr):

conda create -n gptac_venv python=3.11 # 创建anaconda环境

conda activate gptac_venv # 激活anaconda环境

python -m pip install -r requirements.txt # 这个步骤和pip安装一样的步骤[Pasos opcionales] Si necesita admitir Tsinghua ChatGlm3/Fudan Moss como back -end, debe instalar más dependencias (requisito previo: familiarizado con la configuración de la computadora Python + PyTorch +):

# 【可选步骤I】支持清华ChatGLM3。清华ChatGLM备注:如果遇到"Call ChatGLM fail 不能正常加载ChatGLM的参数" 错误,参考如下: 1:以上默认安装的为torch+cpu版,使用cuda需要卸载torch重新安装torch+cuda; 2:如因本机配置不够无法加载模型,可以修改request_llm/bridge_chatglm.py中的模型精度, 将 AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True) 都修改为 AutoTokenizer.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True)

python -m pip install -r request_llms/requirements_chatglm.txt

# 【可选步骤II】支持复旦MOSS

python -m pip install -r request_llms/requirements_moss.txt

git clone --depth=1 https://github.com/OpenLMLab/MOSS.git request_llms/moss # 注意执行此行代码时,必须处于项目根路径

# 【可选步骤III】支持RWKV Runner

参考wiki:https://github.com/binary-husky/gpt_academic/wiki/%E9%80%82%E9%85%8DRWKV-Runner

# 【可选步骤IV】确保config.py配置文件的AVAIL_LLM_MODELS包含了期望的模型,目前支持的全部模型如下(jittorllms系列目前仅支持docker方案):

AVAIL_LLM_MODELS = [ " gpt-3.5-turbo " , " api2d-gpt-3.5-turbo " , " gpt-4 " , " api2d-gpt-4 " , " chatglm " , " moss " ] # + ["jittorllms_rwkv", "jittorllms_pangualpha", "jittorllms_llama"]

# 【可选步骤V】支持本地模型INT8,INT4量化(这里所指的模型本身不是量化版本,目前deepseek-coder支持,后面测试后会加入更多模型量化选择)

pip install bitsandbyte

# windows用户安装bitsandbytes需要使用下面bitsandbytes-windows-webui

python -m pip install bitsandbytes --prefer-binary --extra-index-url=https://jllllll.github.io/bitsandbytes-windows-webui

pip install -U git+https://github.com/huggingface/transformers.git

pip install -U git+https://github.com/huggingface/accelerate.git

pip install peftpython main.py Todas las capacidades de implementación de proyectos (este es un espejo grande que contiene CUDA y látex. Pero si tiene una velocidad de red lenta y un pequeño disco duro, este método no se recomienda implementar un elemento completo)

# 修改docker-compose.yml,保留方案0并删除其他方案。然后运行:

docker-compose up Solo chatgpt + glm4 + wenxin dijo + spark y otros modelos en línea (recomendados por la mayoría de las personas)

# 修改docker-compose.yml,保留方案1并删除其他方案。然后运行:

docker-compose upSi PS necesita confiar en la función de látex plug -in, consulte Wiki. Además, también puede usar directamente el esquema 4 o el esquema 0 para obtener la función de látex.

CHATGPT + GLM3 + MOSS + LLAMA2 + Tongyi Qianwen (necesita estar familiarizado con Nvidia Docker cuando se ejecuta)

# 修改docker-compose.yml,保留方案2并删除其他方案。然后运行:

docker-compose upWindows One -Haga clic en Script de tiempo de ejecución . Los usuarios de Windows que no están familiarizados con el entorno de Python pueden descargar el script de ejecución único publicado en el lanzamiento para instalar una versión sin modelos locales. Fuente de contribución de script: Oobabooga.

Use API de tercera parte, Azure, etc., Wen Xinyi, Fire Star, etc., vea la página Wiki

Los servidores en la nube implementaron de forma remota las pautas para evitar el PIT. Visite la wiki de implementación remota del servidor en la nube

Desplegar en otras plataformas e implementación de URL secundaria

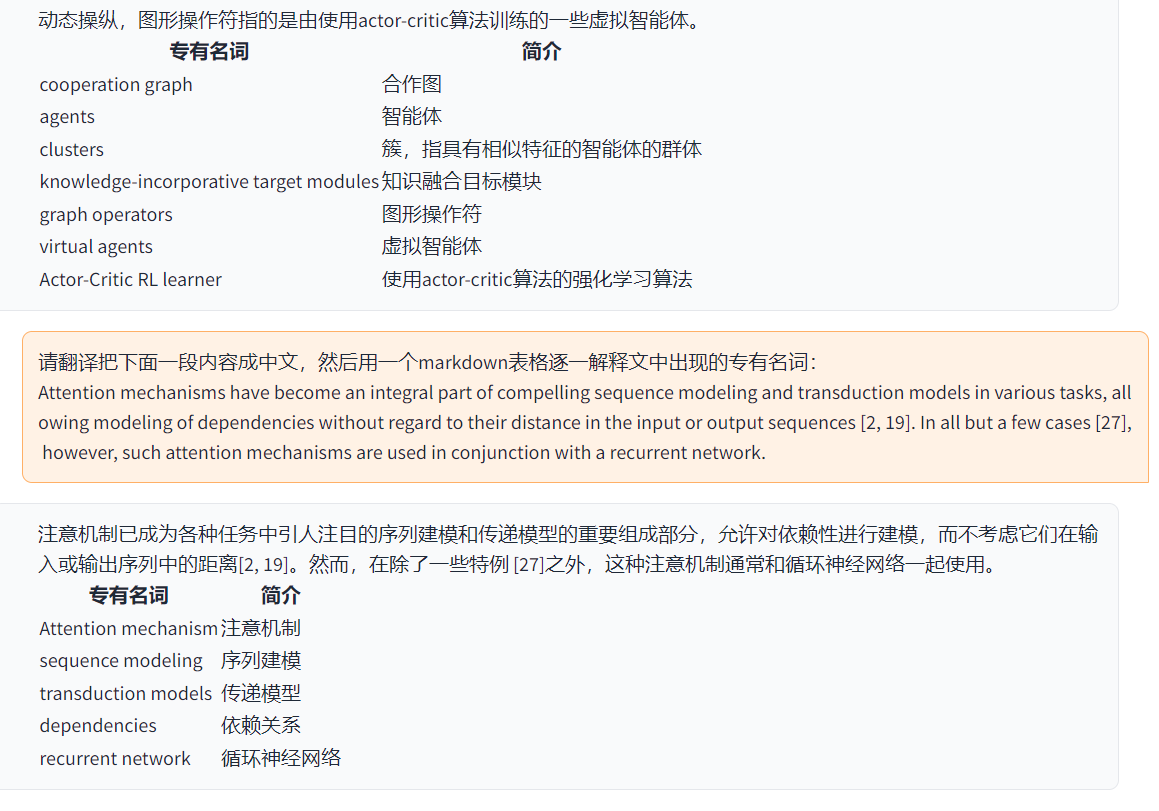

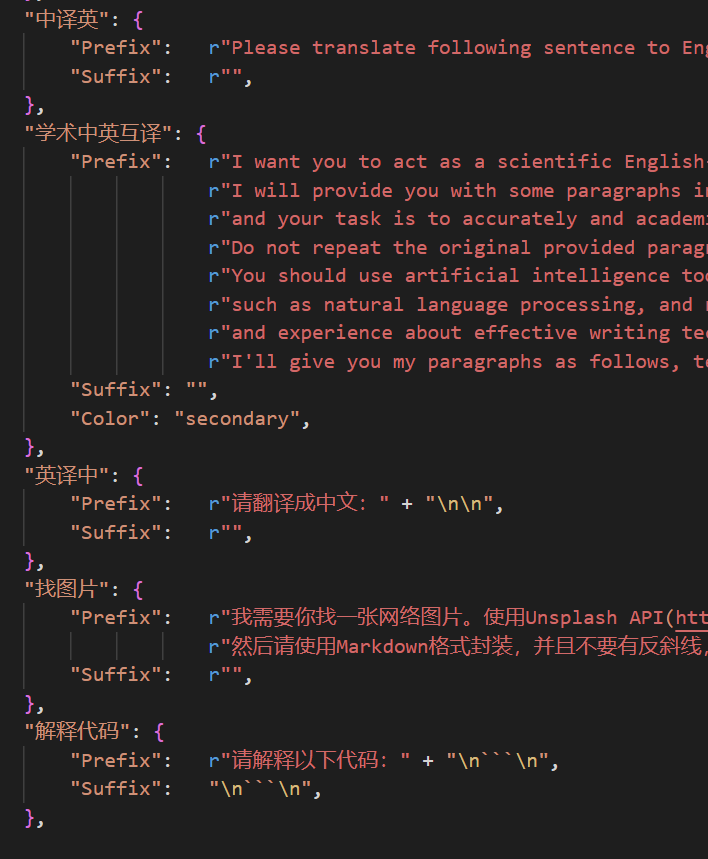

http://localhost/subpath ). Visite las instrucciones de operación de Fastapi Ahora puede agregar un nuevo botón conveniente自定义菜单en el menú界面外观en la interfaz de usuario. Si necesita definirlo en el código, use cualquier editor de texto para abrir core_functional.py , agregue las siguientes entradas:

"超级英译中" : {

# 前缀,会被加在你的输入之前。例如,用来描述你的要求,例如翻译、解释代码、润色等等

"Prefix" : "请翻译把下面一段内容成中文,然后用一个markdown表格逐一解释文中出现的专有名词: n n " ,

# 后缀,会被加在你的输入之后。例如,配合前缀可以把你的输入内容用引号圈起来。

"Suffix" : "" ,

},

Escriba un enchufe de funciones potente para realizar cualquier tarea que desee e inesperadamente. El enchufe y la depuración de este proyecto son muy bajos. Para obtener más detalles, consulte la Guía Función Plug -In.

保存当前的对话en el área载入对话历史存档Funcion Plug -In para guardar el diálogo actual como legible+archivos HTML recuperables.载入对话历史存档para restaurar la sesión anterior. Consejo: Si no especifica el archivo, haga clic载入对话历史存档para ver el caché de archivo HTML histórico.

===>

===>

config.py )

===>

===>

GPT Academic Developer QQ Group: 610599535

requirement.txt para instalar Gradio Línea de tiempo LR

Título GPT-Academic Project Development Process Sección 2.x

1.0 ~ 2.2: Función básica: Introducir la función modular Plug -In: Diseño plegable: Función enchufe -En admite la carga térmica 2.3 ~ 2.5: Mejorar la interacción multifre -threaded: nueva Función de traducción de contenido completo de PDF: Nuevo área de conmutación de área de entrada Función: Actualizado 2.6: Reconstruyendo la estructura de plug -in: Mejora de la interacción: agregue más plug -in Sección 3.x

3.0 ~ 3.1: Soporte para chatglm: admite otro pequeño LLM: admite múltiples modelos GPT al mismo tiempo: admite múltiples apikey de carga de carga 3.2 ~ 3.3: plug -entre -admite más interfaz de parámetros: Guardar la función de diálogo: interpretar cualquier código de idioma:: Al mismo tiempo, pregunte a cualquier combinación de LLM: Información de Internet Función integral 3.4: Unir la traducción de tesis ARXIV: Agregar Función de corrección de tesis de látex 3.44: Admite oficialmente Azure: Interfaz optimizada fácil Uso 3.46: Modelo de filtro CHATGLM2 personalizado: Diálogo de voz de tiempo real 3.49: Soporte Alida Mo Yuan Tongyi Qian Qian: Shanghai AI-Lab Scholar: Xun Fei Xinghuo: Soporte de la plataforma Baidu Qianfan & Wenxin A Word 3.50: Void Terminal: Soporte Clasificación de complemento: Mejore la interfaz de usuario: Diseñe el nuevo tema 3.53: Dynamic Seleccione diferentes temas de interfaz de interfaz : Estabilidad de mejora: resuelva el problema del conflicto de múltiples usuarios 3.55: Código dinámico intérprete: Reconstrucción de la interfaz front -end: Introducción de ventanas suspendidas y barra de menú 3.56: Botón dinámico de función básica adicional: nuevo informe PDF Resumen Página 3.57: GLM3, Star Fire V3: Soporte Wenxinyi Speaking V4: corrige el error concurrente del modelo local

3.60: Introducción al autógeno

3.70: Introduzca el dibujo de sirena: implementación de funciones como GPT Brain Drawing 3.80 (TODO): Autógeno optimizado Tema de Autógeno: Bug -Engling de diseño de diseño Puedes cambiar los temas modificando el THEME

Chuanhu-Small-and-Beautifulmaster : rama principal, versión establefrontier Branch: rama de desarrollo, versión de prueba代码中参考了很多其他优秀项目中的设计,顺序不分先后:

# 清华ChatGLM2-6B:

https://github.com/THUDM/ChatGLM2-6B

# 清华JittorLLMs:

https://github.com/Jittor/JittorLLMs

# ChatPaper:

https://github.com/kaixindelele/ChatPaper

# Edge-GPT:

https://github.com/acheong08/EdgeGPT

# ChuanhuChatGPT:

https://github.com/GaiZhenbiao/ChuanhuChatGPT

# Oobabooga one-click installer:

https://github.com/oobabooga/one-click-installers

# More:

https://github.com/gradio-app/gradio

https://github.com/fghrsh/live2d_demo