Este monitor de acción comenta a los problemas y extrae solicitudes, y recuerde al remitente si se encuentra un lenguaje ofensivo.

Cree el siguiente archivo de flujo de trabajo mind-your-language.yml en el directorio .github/workflows/ de su repositorio:

name : Mind your language

on :

issues :

types :

- opened

- edited

issue_comment :

types :

- created

- edited

pull_request_review_comment :

types :

- created

- edited

jobs :

echo_issue_comment :

runs-on : ubuntu-latest

name : profanity check

steps :

- name : Checkout

uses : actions/checkout@v2

- name : Profanity check step

uses : tailaiw/[email protected]

env :

GITHUB_TOKEN : ${{ secrets.GITHUB_TOKEN }} Cada vez que se crea un comentario a una solicitud de problema o extracción, el flujo de trabajo realizará una verificación de blasfemias contra el texto del comentario y tomará una reacción si se encuentra un lenguaje ofensivo.

Actualmente estoy utilizando Urfanity Check, un paquete de Python de detección de blasfemias basado en el aprendizaje automático, para determinar si un comentario es ofensivo o no. No es súper poderoso, pero es sensible al lenguaje ofensivo obvio. Espero poder usar algunos algoritmos de PNL de vanguardia para obtener un mejor rendimiento. Crearé un repositorio separado para buscar mejores alternativas pronto. Si está interesado en ello, estad atentos.

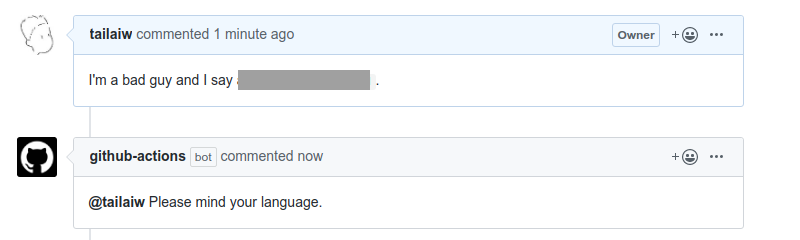

La reacción en este momento es un bot de Github-Actions Bot que menciona al remitente de comentarios ofensivos. Vea el ejemplo como lo siguiente.

Soy un nuevo desarrollador de GitHub Action, por lo que la sugerencia y la ayuda son más que bienvenidas. Por supuesto, "cuida tu idioma"?