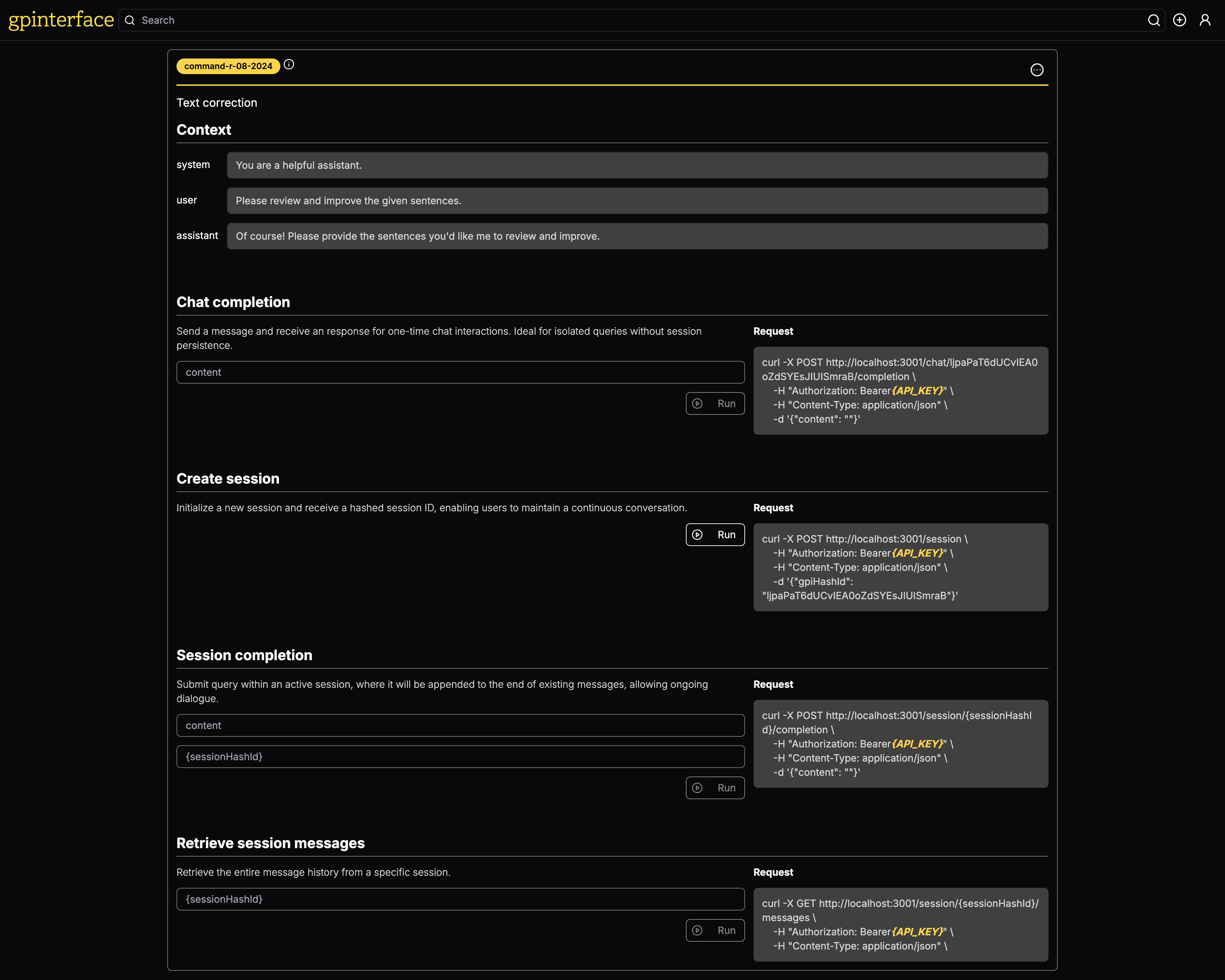

Con gpinterface , puede crear fácilmente API para sus indicaciones.

Una demostración en vivo está disponible en gpinterface.com.

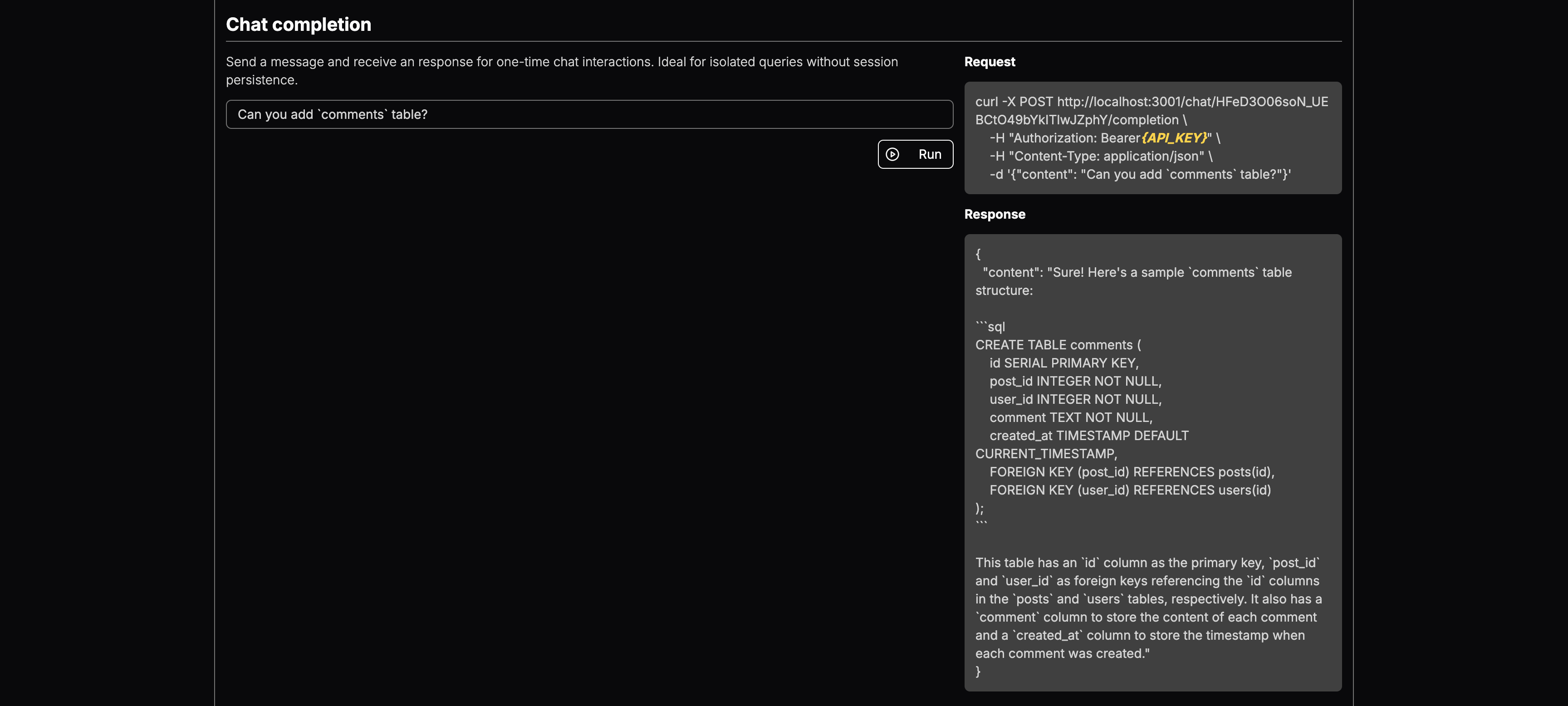

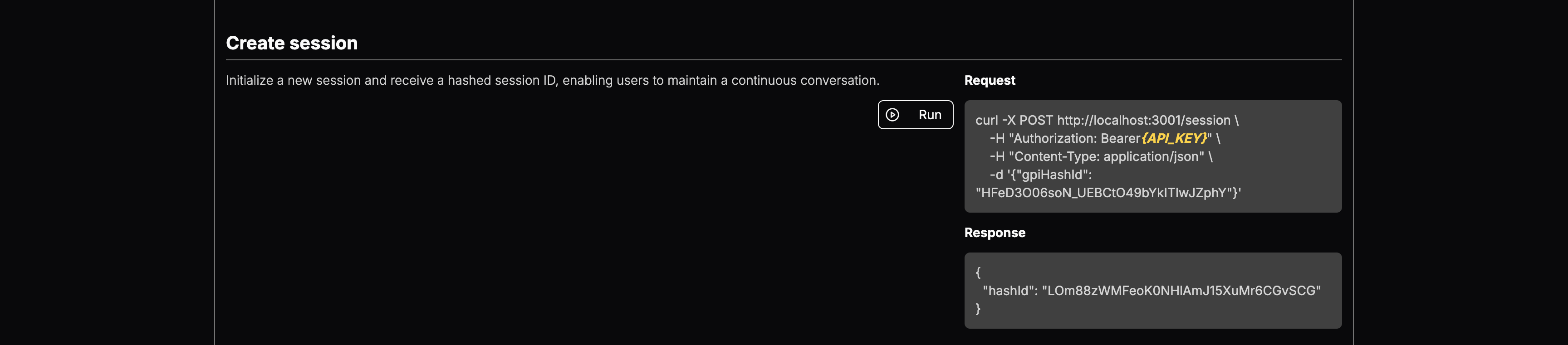

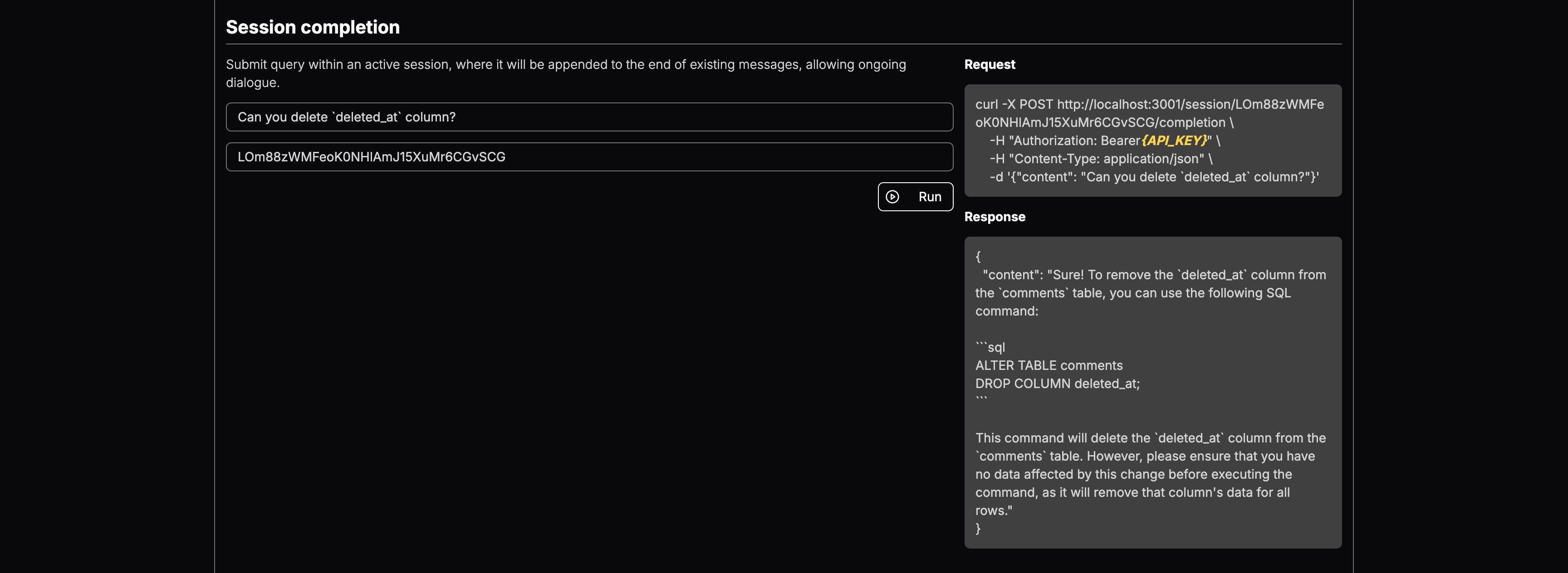

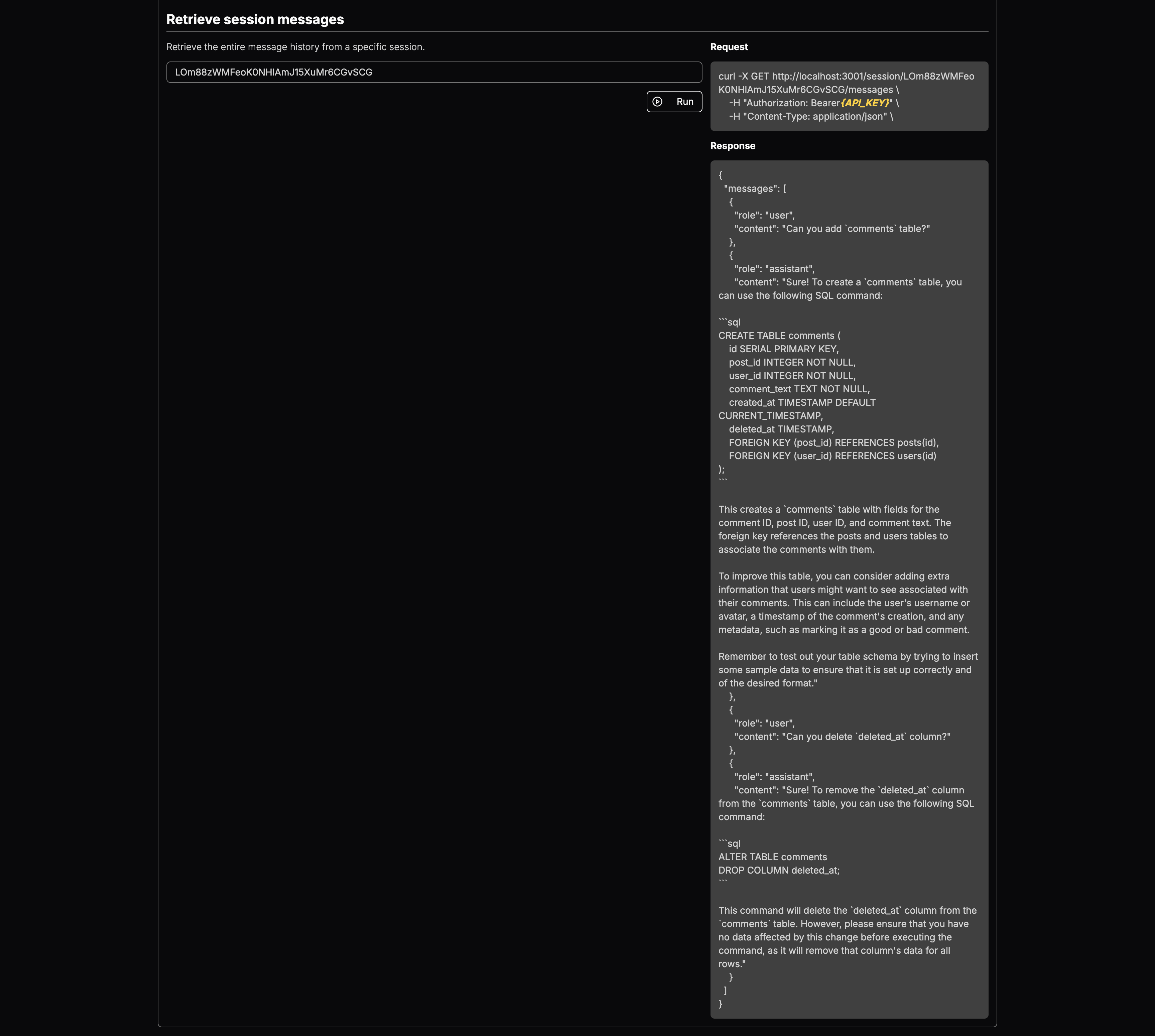

Aquí hay algunos ejemplos específicos de lo que puede hacer gpinterface :

Puede seleccionar el modelo LLM y agregar contexto. Una vez implementado, obtendrá puntos finales para:

Es una herramienta poderosa diseñada para optimizar la prueba y la implementación de indicaciones generativas en múltiples modelos de idiomas grandes (LLM). Con una interfaz web fácil de usar, gpinterface permite una configuración y experimentación rápida.

gpinterface actualmente admite una variedad de modelos de idiomas grandes principales, que incluyen:

Este soporte diverso le permite elegir el mejor modelo para sus necesidades y requisitos específicos.

¿No ves tu modelo favorito? ¡No dude en abrir las relaciones públicas o contácteme!

La aplicación requiere una base de datos PostgreSQL. Inicie la base de datos usando Docker:

cd backend

docker-compose up -dEl backend utiliza prisma para administrar el esquema de la base de datos y las migraciones. Ejecute los siguientes comandos en la inicialización de la base de datos:

npm run prisma:migratePara sembrar la base de datos con datos iniciales para cada modelo de lenguaje grande compatible, ejecute los siguientes comandos:

npx ts-node prisma/seedBackend

El backend requiere que se establezcan las siguientes variables de entorno:

CLIENT_URL= " http://localhost:3003 "

DATABASE_URL= " postgresql://postgres:[email protected]:5432/postgres " # can be replaced with your DB endpoint

AI21_API_KEY= " YOUR_AI21_API_KEY "

ANTHROPIC_API_KEY= " YOUR_ANTHROPIC_API_KEY "

COHERE_API_KEY= " YOUR_COHERE_API_KEY "

GOOGLE_API_KEY= " YOUR_GOOGLE_API_KEY "

MISTRAL_API_KEY= " YOUR_MISTRAL_API_KEY "

OPENAI_API_KEY= " YOUR_OPENAI_API_KEY "

AWS_ACCESS_KEY_ID= " AWS_ACCESS_KEY " # you need Llama model access in AWS Bedrock

AWS_SECRET_ACCESS_KEY= " AWS_SECRET_KEY " # you need Llama model access in AWS Bedrock

JWT_SECRET= " SECURE_RANDOM_STRING "

COOKIE_SECRET= " SECURE_RANDOM_STRING "

NODE_ENV= " development " # for development logging Asegúrese de que estas variables se establezcan en un archivo .env en el directorio de backend antes de comenzar la aplicación.

Interfaz

La aplicación frontend requiere las siguientes variables de entorno:

NEXT_PUBLIC_API_ENDPOINT= " http://localhost:3000 "

NEXT_PUBLIC_CHAT_ENDPOINT= " http://localhost:3001 "

NEXT_PUBLIC_HOSTNAME= " http://localhost:3003 "

NEXT_PUBLIC_GOOGLE_OAUTH_CLIENT_KEY= " "Estos deben configurarse para que coincidan con los puntos finales donde los servicios de backend están disponibles, asegurando que el frontend pueda comunicarse con el backend correctamente.

Para ejecutar los componentes de la aplicación por separado para fines de desarrollo:

Backend de carrera

cd backend && npm run devCorrer frontend

cd frontend && npm run devPara construir todos los componentes para la implementación de producción, siga estos pasos secuencialmente

cd shared

npm run build

cd ../backend

npm run build

cd ../frontend

npm run buildPara iniciar el servidor

Backend de carrera

cd backend && npm run startEjecutar el servidor de chat (servidor API)

cd backend && npm run start:chatCorrer frontend

cd frontend && npm run start