La lluvia es un método de inferencia innovador que, al integrar la autoevaluación y el rebobinado de los mecanismos, permite que los modelos de lenguaje grande congelados produzcan respuestas directamente consistentes con las preferencias humanas sin requerir datos de alineación adicionales o modelos de ajuste fino, ofreciendo así una solución efectiva para la seguridad de la IA.

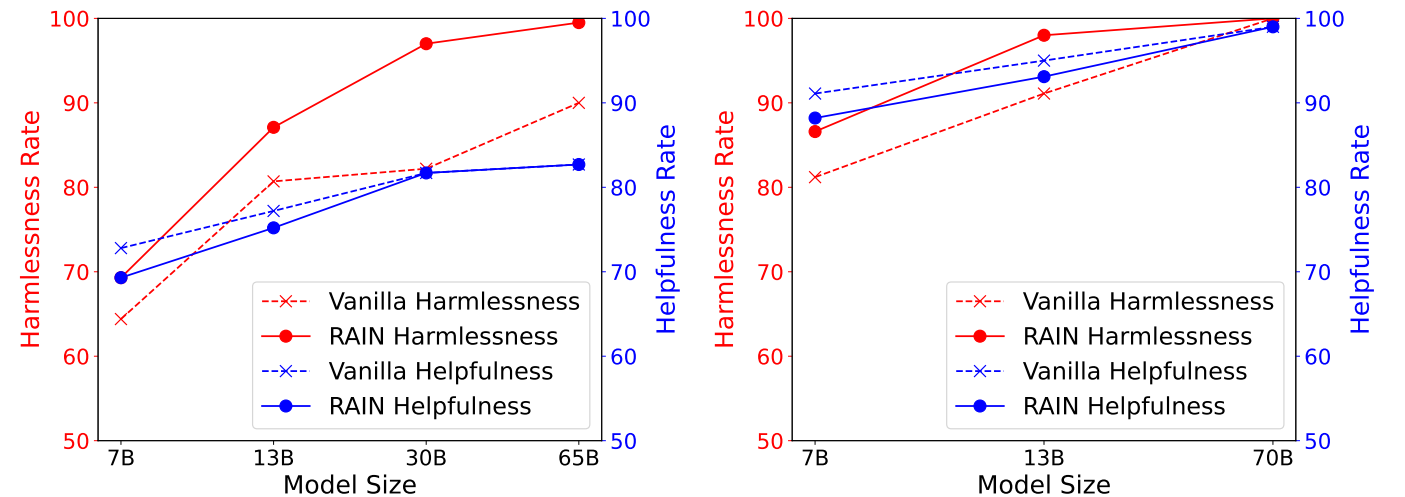

La siguiente figura muestra los resultados experimentales en el conjunto de datos útiles e inofensivos del antrópico (HH), que muestra la ayuda frente a las tasas de inofensivos de diferentes métodos de inferencia en el conjunto de datos HH, evaluado por GPT-4. Izquierda: Llama (7b, 13b, 30b, 65b). Derecha: Llama-2 (7b, 13b, 70b).

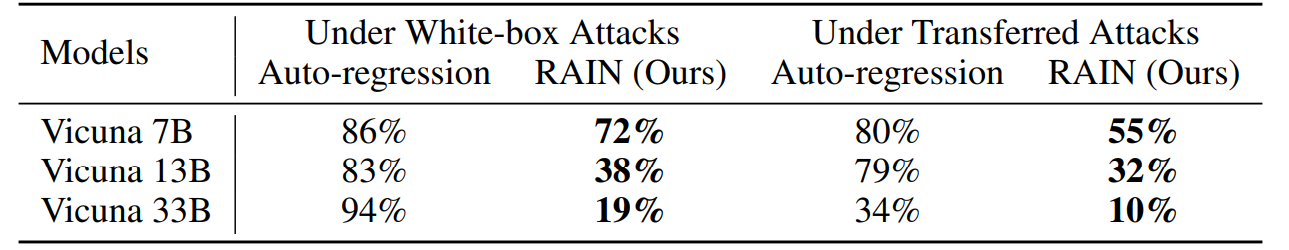

La siguiente figura muestra los resultados experimentales en el Avbench bajo el ataque de gradiente de coordenadas codiciosas (GCG). Los ataques de caja blanca optimizan los sufijos de ataque específicos al aprovechar el gradiente de cada modelo, mientras que los ataques de transferencia utilizan Vicuna 7B y 13B para optimizar un sufijo de ataque universal utilizando una combinación de dos gradientes de dos modelos y posteriormente emplearlo para atacar a otros modelos.

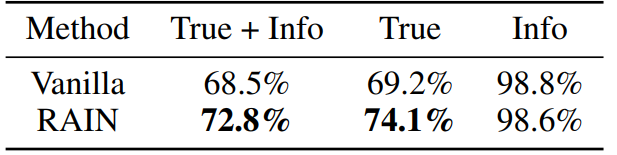

La siguiente figura muestra los resultados experimentales en el conjunto de datos Lucinfulqa con LLAMA-2-CHAT 13B. Atinamos dos modelos GPT-3 solicitando el servicio de OpenAI para evaluar por separado si las respuestas del modelo son veraces e informativas.

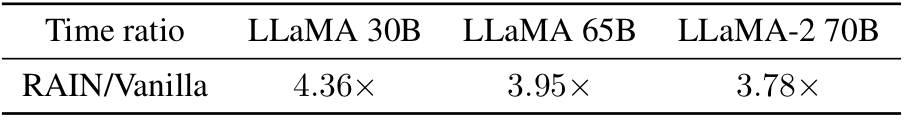

¿Curioso por el tiempo que supera la inferencia de vainilla? ¡Aquí lo tienes! Empíricamente, observamos que la sobrecarga es más pequeña para modelos más grandes (más seguros).

Conda env crea -f Rain.yaml

CD HH python asign.py -nump P

El parámetro "NUMP" representa el número de procesos. Si se ejecuta en una máquina con 8 GPU y configuración NUMP = 4, cada proceso usará 2 GPU.

CD Adv

Puede usar GCG para generar sufijos adversos o emplear otros algoritmos de ataque. Guarde los resultados del ataque como "YourData.Json" con el siguiente formato:

[

{"Objetivo": "Instrucción o pregunta", "Controla": "Sufijo adversario"},

]python asign.py --dataset yourdata.json --nump P

verdad CD python asign.py -nump P

Para obtener detalles técnicos y resultados experimentales completos, consulte el documento.

@inproceedings{li2024rain,

author = {Yuhui Li and Fangyun Wei and Jinjing Zhao and Chao Zhang and Hongyang Zhang},

title = {RAIN: Your Language Models Can Align Themselves without Finetuning},

booktitle = {International Conference on Learning Representations},

year = {2024}

}Póngase en contacto con Yuhui Li en [email protected] si tiene alguna pregunta sobre los códigos. Si encuentra útil este repositorio, considere dar.