ebsynth_utility

Descripción general

Extensión de UI automática1111 para crear videos utilizando IMG2IMG y EBSYNTH.

Esta extensión le permite emitir videos editados con EBSYNTH (AE no es necesario)

¡Con Controlnet instalado, he confirmado que todas las características de esta extensión funcionan correctamente!

Controlnet es imprescindible para la edición de video, por lo que recomiendo instalarlo.

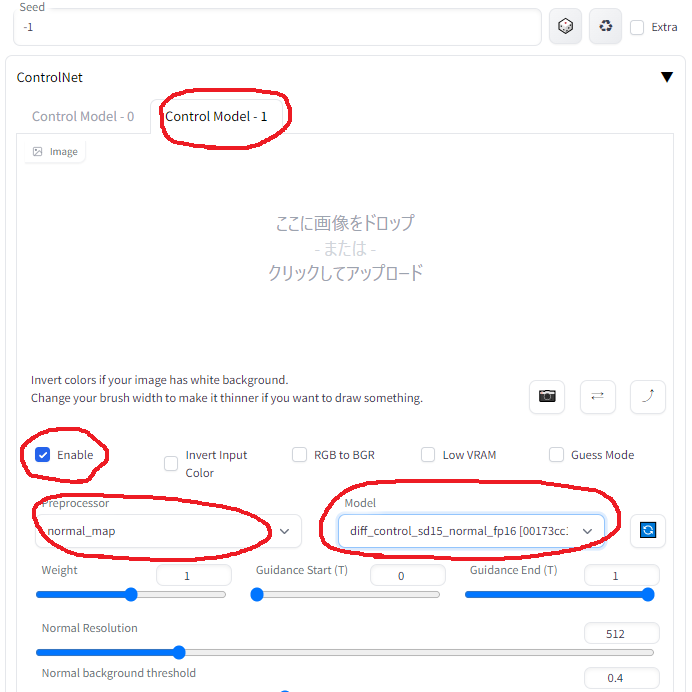

Multi Controlnet ("Canny" + "Mapa normal") sería adecuado para la edición de video.

Modifiqué Animatediff-CLI para crear una herramienta TXT2Video que permite una especificación de inmediato flexible. Puedes usarlo si quieres.

Animatediff-Cli-Prompt-Travel

muestra2.mp4

Ejemplo

- La siguiente muestra es la salida sin procesar de esta extensión.

Muestra 1 máscara con clipseg

- Primero desde la izquierda: original

- Segundo desde la izquierda: enmascarar "Cat" excluir "dedo"

- Tercero desde la izquierda: enmascarar "Cat Head"

- Derecha: Color corregido con el combate de color (ver la etapa 3.5)

- También se pueden especificar múltiples objetivos (por ejemplo, gato, perro, niño, niña)

sample_clipseg_and_colormacher.mp4

Muestra 2 de mezcla de fondo

- Persona: obra maestra, mejor calidad, obra maestra, 1 girl, obra maestra, mejor calidad, captura de pantalla de anime, estilo de anime

- Antecedentes: cyberpunk, fábrica, habitación, recipiente de anime, estilo de anime

- También es posible mezclar con sus videos favoritos.

muestra6.mp4

muestra 3 etiquetado automático

- Izquierda: original

- Centro: aplique las mismas indicaciones en todos los cuadros de teclas

- Derecha: aplique el etiquetado automático de DeepDanbooru en todos los cuadros de teclas

- Esta función mejora los cambios detallados en las expresiones faciales, expresiones manuales, etc.

En el video de muestra, se han agregado las etiquetas "cerradas_eyes" y "Hands_on_own_face" para que representen mejor parpadear y las manos traídas frente a la cara.

sample_autotag.mp4

Muestra 4 etiquetado automático (aplique lora dinámicamente)

- Izquierda: aplique etiquetado automático de DeepDanbooru en todos los cuadros de teclas

- Derecha: aplique el etiquetado automático de DeepDanbooru en todos los plazos de teclas + Aplicar "Anyahehface" Lora dinámicamente

- Se agregó la función para aplicar dinámicamente TI, Hypernet, Lora y las indicaciones adicionales de acuerdo con las etiquetas adjuntas automáticamente.

En el video de muestra, si se da la etiqueta "Smile", las palabras clave de disparo Lora y Lora se agregarán de acuerdo con la fuerza de la etiqueta "Smile".

Además, dado que las etiquetas agregadas automáticamente son a veces incorrectas, las etiquetas innecesarias se enumeran en la lista negra.

Aquí está el archivo de configuración real utilizado. colocado en "Directorio de proyectos" para su uso.

Muestra.anyaheh.mp4

Instalación

- Instale ffmpeg para su sistema operativo (https://www.geeksforgeeks.org/how-to-install-ffmpeg-on-windows/)

- Instalar EBSYNTH

- Use la pestaña Extensiones de la webui para [instalar desde URL]

Uso

- Vaya a la pestaña [EBSYNTH Utility].

- Cree un directorio vacío en algún lugar y complete el campo "Directorio de proyectos".

- Coloque el video que desea editar desde algún lugar y complete el campo "Ruta de película original". Use videos cortos de unos pocos segundos al principio.

- Seleccione la etapa 1 y genere.

- Ejecutar en orden de la etapa 1 a 7. El progreso durante el proceso no se refleja en WebUI, así que consulte la pantalla de la consola. Si ves "completado". En Webui, se completa.

(En el último WebUI actual, parece causar un error si no suelta la imagen en la pantalla principal de IMG2Img.

Por favor, deje caer la imagen, ya que no afecta el resultado).

Nota 1

Como referencia, esto es lo que hice cuando edité un video de 1280x720 30 fps 15sec basado en

Etapa 1

No hay nada que configurar.

Se generan todos los cuadros de las imágenes de video y máscara para todos los cuadros.

Etapa 2

En la implementación de esta extensión, el intervalo de fotograma clave se elige para ser más corto donde hay mucho movimiento y más tiempo donde hay poco movimiento.

Si la animación se rompe, aumente el fotograma clave, si parpadea, disminuya el plazo clave.

Primero, genere una vez con la configuración predeterminada y avance sin preocuparse por el resultado.

Etapa 3

Seleccione uno de los fotogramas clave, tírelo a IMG2Img y ejecute [Interrogate DeepBooru].

Eliminar palabras no deseadas como el desenfoque de la solicitud mostrada.

Complete el resto de la configuración como lo haría normalmente para la generación de imágenes.

Aquí está la configuración que usé.

- Método de muestreo: Euler A

- Pasos de muestreo: 50

- Ancho: 960

- Altura: 512

- Escala CFG: 20

- Fuerza de descenso: 0.2

Aquí está la configuración de extensión.

- Modo de máscara (anular el modo de máscara IMG2Img): normal

- IMG2IMG Repetir recuento (bucle hacia atrás): 5

- Agregue n a la semilla al repitir: 1

- Use la cosecha facial img2img: verdadero

- Método de detección de cara: Yunet

- Tamaño máximo de cultivo: 1024

- Fuerza de desnudos de cara: 0.25

- Aumento del área de la cara: 1.5 (cuanto más grande sea el número, más cerca del estilo de pintura del modelo, pero más probabilidades tendrá de cambiar cuando se fusione con el cuerpo).

- Habilitar el aviso de cara: Falso

La prueba y el error en este proceso es la parte más lento.

Monitoree la carpeta de destino y, si no le gustan los resultados, interrumpe y cambia la configuración.

[Aviso] [La resistencia a la renovación] y la configuración de [Facticising Strength] cuando se usa IMG2IMG de cultivo facial afectarán en gran medida el resultado.

Para obtener más información sobre Face Crop IMG2Img, consulte aquí

Si tiene mucha memoria de sobra, aumentar los valores de ancho y altura mientras se mantiene la relación de aspecto puede mejorar en gran medida los resultados.

Esta extensión puede ayudar con el ajuste.

https://github.com/s9roll7/img2img_for_all_method

La información anterior es de un momento en que no había control.

Cuando Controlnet se usa juntos (especialmente los controles múltiples), incluso establecer la "resistencia de renovación" a un valor alto funciona bien, e incluso establecerlo en 1.0 produce resultados significativos.

Si la "fuerza de desnudos" se establece en un valor alto, "bucle Back" se puede establecer en 1.

Etapa 4

Escalarlo hacia arriba o hacia abajo y procesarlo exactamente al mismo tamaño que el video original.

Este proceso solo debe hacerse una vez.

- Ancho: 1280

- Altura: 720

- Upcaler 1: R-ESRGAN 4X+

- Upcaler 2: R-ESRGAN 4X+ Anime6B

- Upcaler 2 Visibilidad: 0.5

- Visibilidad de GFPGan: 1

- Visibilidad del formador de código: 0

- CodeFormer Peso: 0

Etapa 5

No hay nada que configurar.

El archivo .EBS se generará.

Etapa 6

Ejecute el archivo .ebs.

No cambiaría la configuración, pero podría ajustar la configuración de .EBS.

Etapa 7

Finalmente, emite el video.

En mi caso, todo el proceso del 1 al 7 tomó unos 30 minutos.

- Tasa de mezcla de Fade Cross: 1.0

- Tipo de exportación: MP4

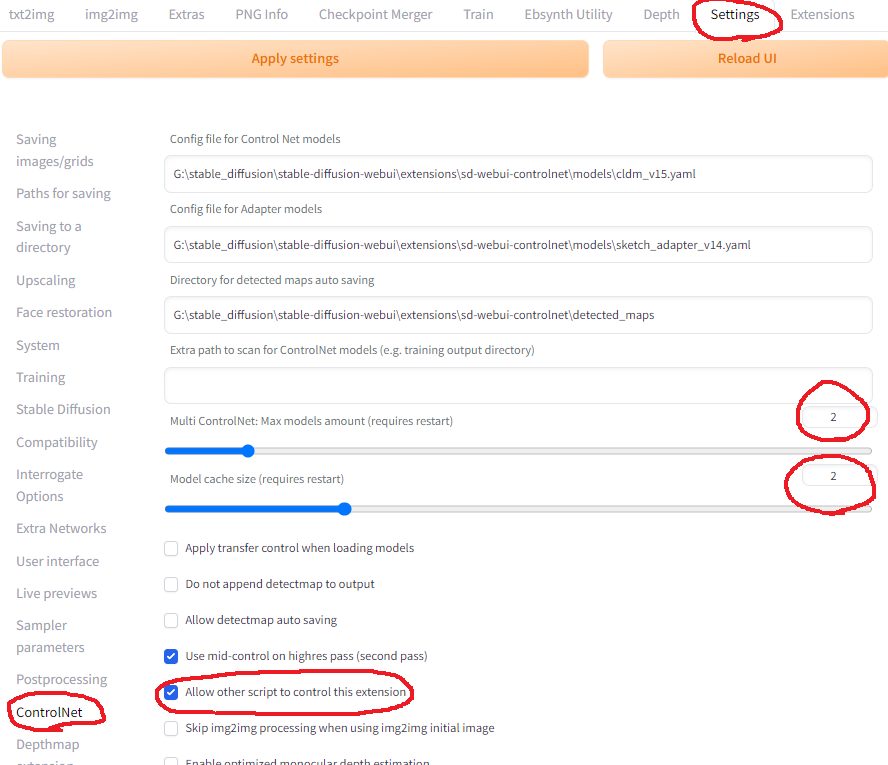

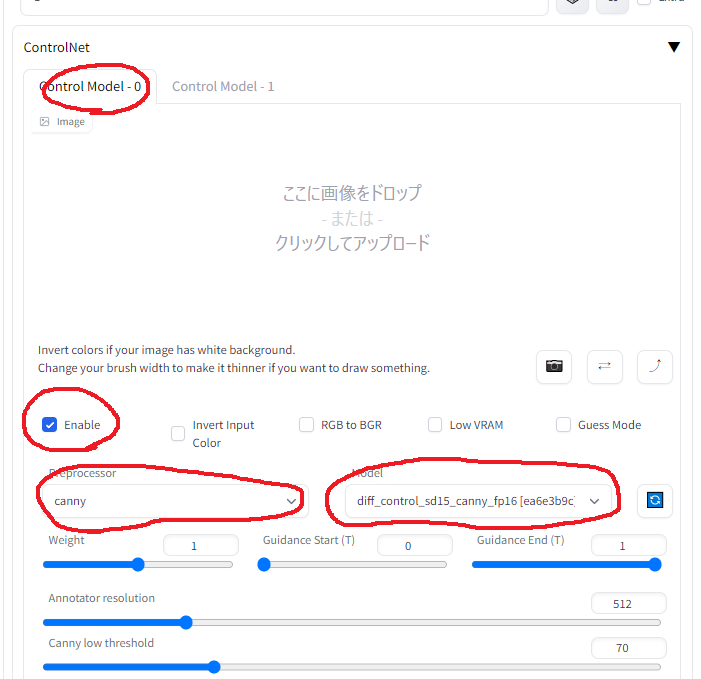

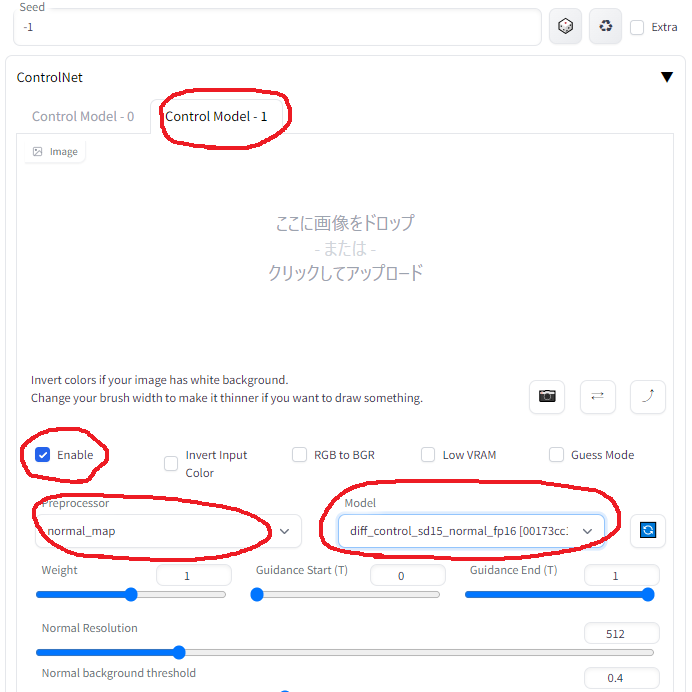

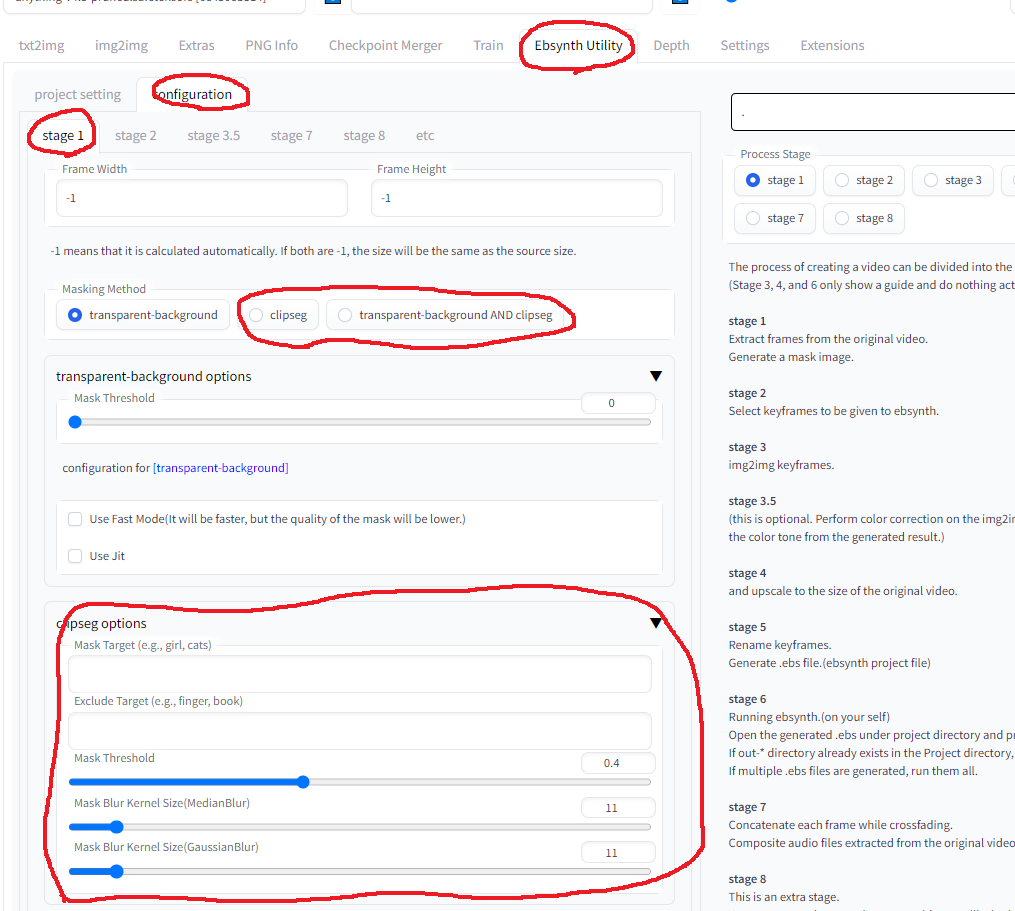

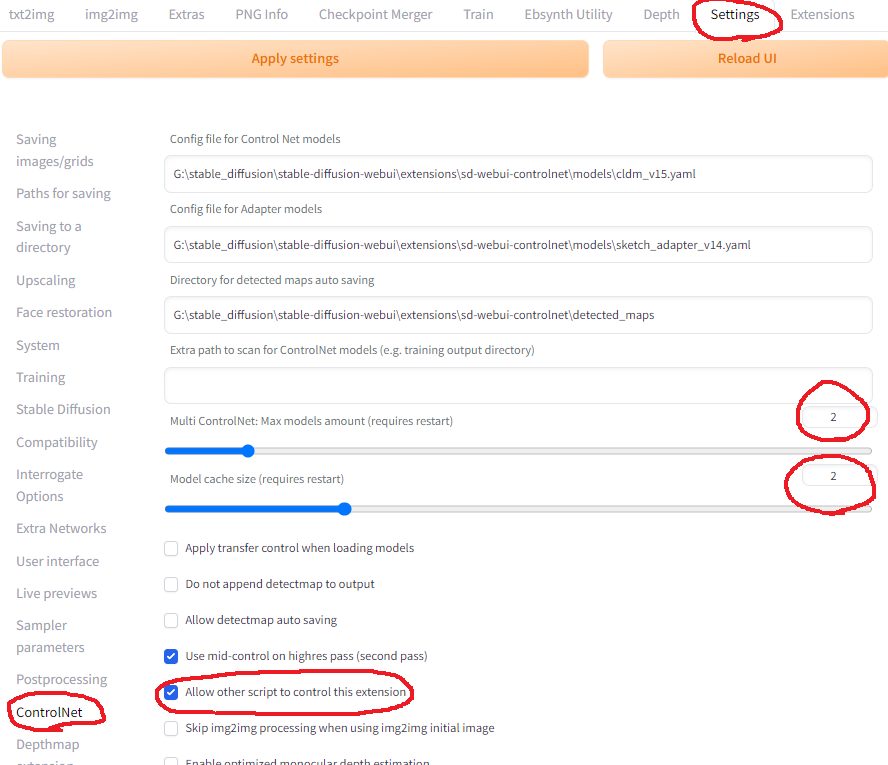

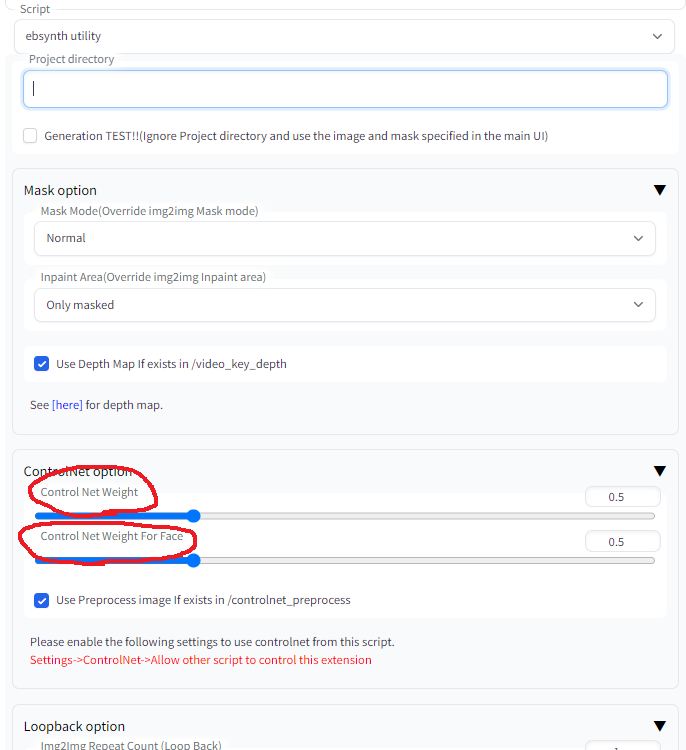

Nota 2: Cómo usar multi-controlnet juntos

En la configuración de Webui

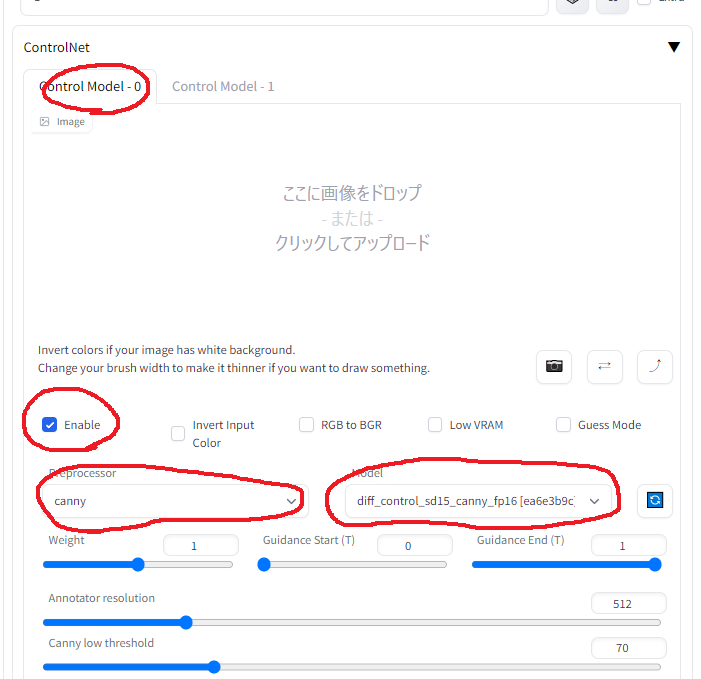

En Configuración de Controlnet en la pestaña IMG2IMG (para Controlnet 0)

En Configuración de Controlnet en la pestaña IMG2IMG (para Controlnet 1)

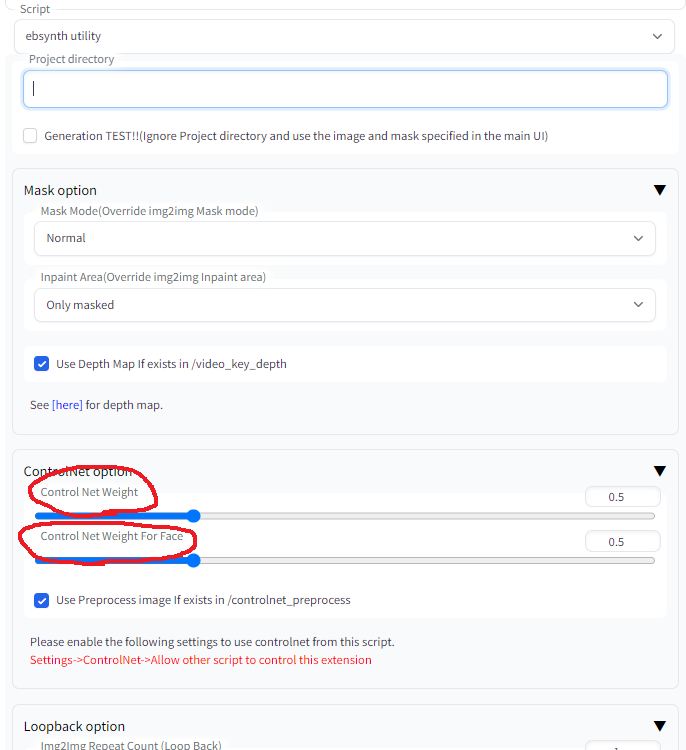

En la configuración de EBSYNTH_UTILity en la pestaña IMG2Img

ADVERTENCIA: "Peso" en la configuración de Controlnet se anula por los siguientes valores

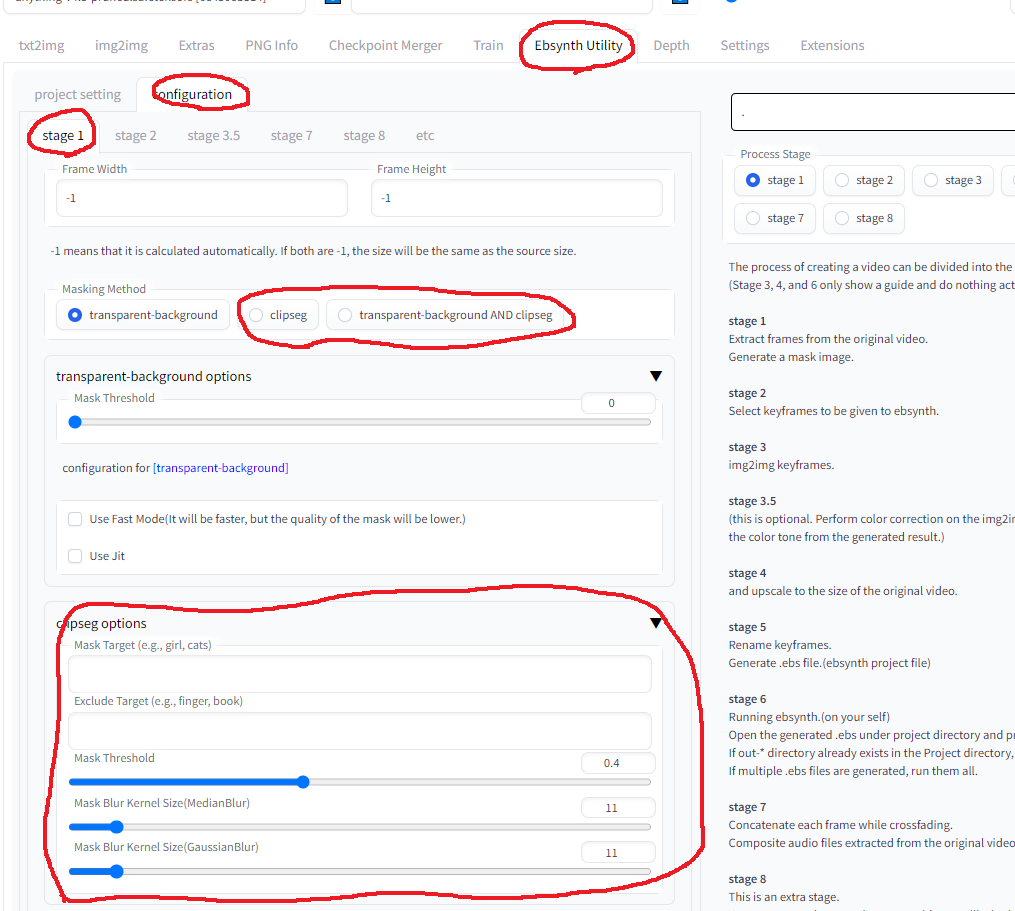

Nota 3: Cómo usar ClipSeg