Trol: transversal de capas para grandes modelos de lenguaje y visión [ARXIV]

Trol: transversal de capas para grandes modelos de lenguaje y visión [ARXIV]

Gracias al personal de Huggingface, podemos usar ZerogPu gratuito (NVIDIA A100) para cada usuario, pero hay consultas limitadas, por lo que si las inferencias están atascadas, espere unos minutos. (La velocidad de demostración local es mucho más más rápida que este espacio de GPU en línea).

Trol-1.8b ahora está disponible en los modelos de Huggingface. (Readme de demostración local incluido)

Trol-3.8b ahora está disponible en los modelos de Huggingface. (Readme de demostración local incluido)

TROL-7B ahora está disponible en los modelos de Huggingface. (Readme de demostración local incluido)

La demostración del trol en línea ahora está disponible en los espacios de la cara de abrazos. (Puede elegir el tamaño del modelo)

Código oficial de implementación de Pytorch para realizar la parte técnica del recorrido de las capas (trol) para mejorar numerosos rendimientos de lenguaje de visión con un tamaño de modelo eficiente. Este código se desarrolla desde cero. Así que he estado tratando de mejorar la lectura y la simplicidad del código, en comparación con Llava, que tiene un código estructurado de manera relativamente compleja.

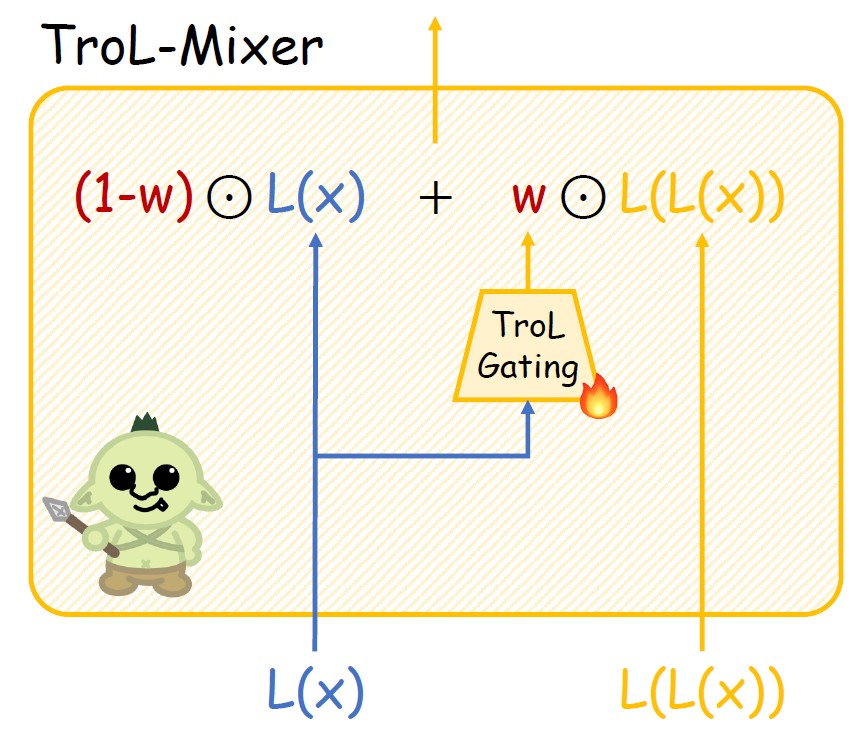

Figura 1. Capa de Trol. Nueva propagación.

Figura 2. Estructura del mezcla de trol.

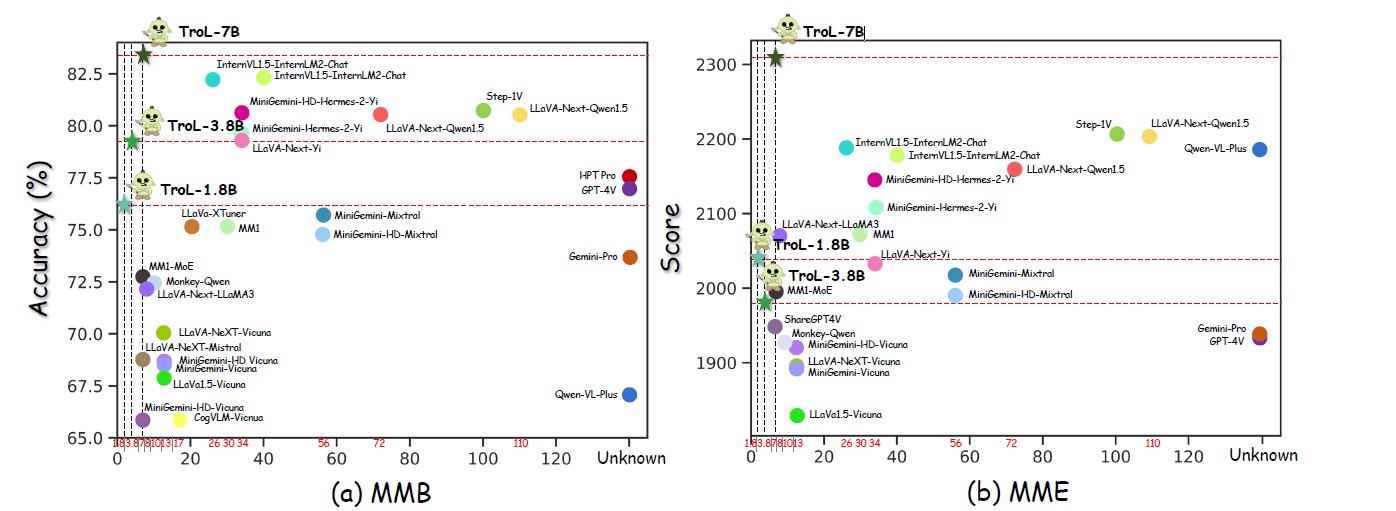

Figura 3. Actuaciones en numerosos tamaños de modelo.

Figura 4. Comparación con LLVM de código cerrado.

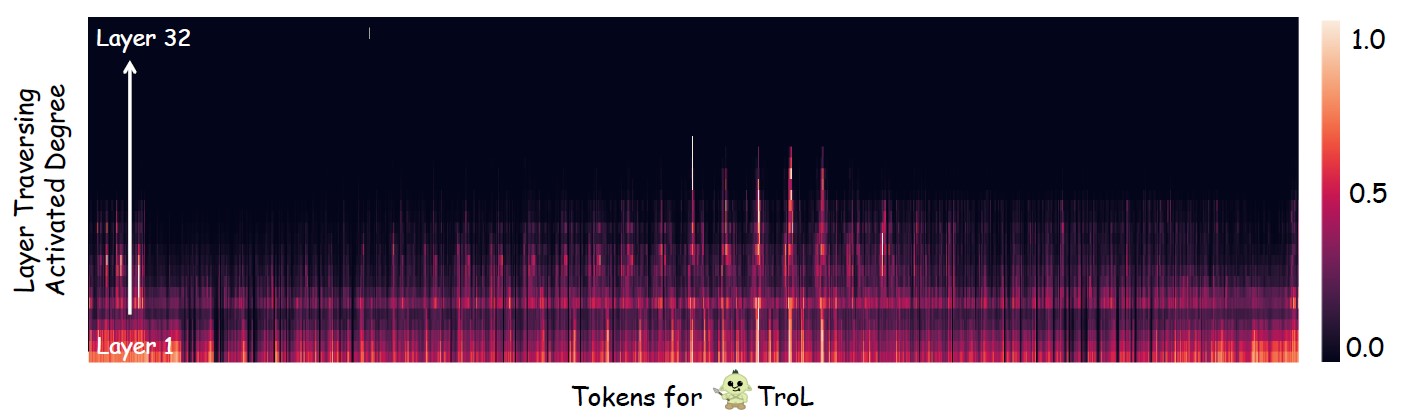

Figura 5. Investigar dónde ocurre principalmente las capas (reutilizaciones de capas).

LLVM de código abierto con tamaño de modelo estándar

| LLVMS | Sqa-img | PAPA | Mete | MMB | Mathvista | Semilla-img | Mm-vet | Llava-W |

|---|---|---|---|---|---|---|---|---|

| Yi-vl-6b | 71.7 | 82.5 | 1915 | 64.2 | 29.7 | 67.5 | 32.1 | 51.9 |

| Llava-next-7b | 70.1 | 86.5 | 1851 | 69.6 | 34.6 | 70.2 | 43.9 | 72.3 |

| Mm1-7b | 72.6 | 86.6 | 1858 | 72.3 | 35.9 | 70.9 | 42.1 | - |

| Trol-1.8b | 87.5 | 88.6 | 2038 | 76.1 | 45.4 | 69.0 | 45.1 | 69.7 |

| Trol-3.8b | 90.8 | 86.5 | 1980 | 79.2 | 55.1 | 70.5 | 51.1 | 76.6 |

| Trol-7b | 92.8 | 87.8 | 2308 | 51.8 | 75.3 | 54.7 | 92.8 | 87.1 |

LLVM de código abierto con tamaños de modelo grandes

| LLVMS | Ai2d | Chartqa | Mete | MMB | Mathvista | Mm-vet | Llava-W |

|---|---|---|---|---|---|---|---|

| Intervl1.5-40B | 79.0 | 68.0 | 2175 | 82.2 | 47.7 | 48.9 | - |

| Intervl1.5-26b | 80.7 | 83.8 | 2188 | 82.2 | 53.5 | 62.8 | - |

| Mm1-30b | - | - | 2069 | 75.1 | 39.4 | 48.7 | - |

| Minigemina-34b | - | - | 2105 | 79.6 | 38.9 | 53.0 | - |

| Minigemini-hd-34b | - | - | 2141 | 80.6 | 43.3 | 59.3 | - |

| Llava-next-34b | 74.9 | 68.7 | 2030 | 79.3 | 46.0 | 57.4 | 88.8 |

| Llava-next-8b | 71.6 | 69.5 | 1972 | 72.1 | 37.5 | - | 80.1 |

| Llava-next-72b | 77.4 | 77.0 | 2159 | 80.5 | 46.6 | - | 89.2 |

| Llava-next-1110b | 80.4 | 80.4 | 2201 | 80.5 | 49.0 | - | 90.4 |

| Trol-1.8b | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 45.1 | 69.7 |

| Trol-3.8b | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 51.1 | 76.6 |

| Trol-7b | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 54.7 | 92.8 |

LLVM de código cerrado

| LLVMS | Sqa-img | Ai2d | Chartqa | Mete | MMB | Mathvista | Semilla-img | Mmstar |

|---|---|---|---|---|---|---|---|---|

| Qwen-vl-plus | 71.6 | 75.9 | 78.1 | 2183 | 67.0 | 43.3 | 72.7 | 39.7 |

| Gemini-pro | 80.1 | 73.9 | 74.1 | 1933 | 73.6 | 45.2 | 70.7 | 41.6 |

| GPT-4V | 84.6 | 78.2 | 78.5 | 1927 | 77.0 | 49.9 | 69.1 | 46.1 |

| Trol-1.8b | 87.5 | 68.9 | 64.0 | 2038 | 76.1 | 45.4 | 69.0 | 45.5 |

| Trol-3.8b | 90.8 | 73.6 | 73.8 | 1980 | 79.2 | 55.1 | 70.5 | 46.5 |

| Trol-7b | 92.8 | 78.5 | 71.2 | 2308 | 83.5 | 51.8 | 75.3 | 51.3 |

Trol

TrolTotal: 2273830 (2.3m)

------------------------------* Imagen del mundo real: 755k* Texto del mundo real: 143k* Documento y gráfico y diagrama & Sign & Symbol: 627k* Matemáticas: 747k

- Matemáticas con visión: 180k

- Matemáticas solo con texto: 566k

------------------------------

- ShareGPT4V-Caption [sin SAM] (91021, 91k)

-ShareGPT4V-Instrucción [sin pocas muestras de OCR-VQA] (664703, 664K)

- Allava4v-text (143000, 143k)

- Minigemini-Instrucción [Docvqa, Chartqa, DVQA, AI2D] (27670, 27k)

- DocDownstream (574268, 574k)

- Docreson (25877, 25k)

- Gllava-Align (60252, 60k)

- Gllava-Qa (117205, 117k)

- MathVision (3040, 3k)

- Mathinstruct [TextonlyDataSet] (262040, 262k)

- Mathplus [TextonlyDataSet] (304754, 304k)Recopilamos los siguientes nueve conjuntos de datos. Para los minigemini, usamos selectivamente muestras de datos solo para DOCVQA, CACHQA, DVQA y AI2D. Por lo tanto, no es necesario que descargue todas las muestras de datos para minigemini.

ShareGPT4V [enlace]

Allava4v-text [enlace]

Minigemini [enlace]

Docdownstream [enlace]

Docreson [enlace]

Gllava [enlace]

MathVision [enlace]

Mathinstruct [enlace]

Mathplus [enlace]

Diseño del conjunto de datos reunido

Trol_dataset_path

├── llava # sharegpt4v│ └── llava_prain

│ └── Imágenes

├── Coco # sharegpt4v│ └── Train2017

├── sam # sharegpt4v│ └── imágenes

├── GQA # sharegpt4v│ └── Imágenes

├── OCR_VQA # shareGPT4V│ └── Imágenes

├── Textvqa # sharegpt4v│ └── Train_images

├── vg # sharegpt4v│ ├── vg_100k

│ └── VG_100K_2

├── share_textvqa # sharegpt4v│ └── Imágenes

├── Web-Celebrity # shareGPT4V│ └── Imágenes

├── Web-landmark # sharegpt4v│ └── Imágenes

├── Wikiart # sharegpt4v│ └── Imágenes

├── share_textvqa # sharegpt4v│ └── Imágenes

├── Docvqa # Minigemini│ └── Imágenes

├── Chartqa # Minigemini│ └── Tren

│ └── Imágenes

├── dvqa # minigemini│ └── imágenes

├── Ai2d # minigemini│ └── Imágenes

├── IMGS # DOCDOWNSTREAM & DOCTRONS│ └── CHARTQA

│ └── Due_Benchmark

│ └── Forma profunda

│ └── Docvqa

│ └── Infographicsvqa

│ └── Kleistercharity

│ └── Tabfact

│ └── WikititableCuestions

│ └── TextCaps

│ └── Textvqa

│ └── VisualMrc

├── Geo3k # gllava | └─ ─ Tren

├── Geoqa_Plus # gllava├─ Images # MathVision | ├── shareGPT4V_INSTRUCT_GPT4-VISION_CAP100K.JSON # shareGPT4V-Caption├_div2k.json Evol-Instructo-GPT4-TURBO-143K. json # allava4v-text├── tran.jsonl # docdownstream├── detallado_explanation.jsonl # docreson├── minigemini_instruction.json # minigemini-instruction├── gllava_align.parquet # gllava-align. Qa├── MathVision.Parquet # MathVision├── Mathinstruct.json # Mathinstruct└── Mathplus.Parquet # MathplusEstos son la lista de conjuntos de datos de evaluación. Si los descarga completamente, el conjunto de datos debe colocarse en la carpeta mediante el siguiente diseño del directorio.

Q-Bench [enlace]

Sqa-img [enlace]

Ai2d [enlace]

Chartqa [enlace]

Semilla [enlace]

Papa [Enlace]

HallusionBench [enlace]

Mme [enlace]

Mathvista [enlace]

MMB [enlace]

Mm-vet [enlace]

Llava-W [enlace]

Mmstar [enlace]

Mathverse [enlace]

VisualWebbench [enlace]

Diseño del directorio del conjunto de datos de evaluación

Evaluación_dataset_path ├── llvisionqa-qbench # Q-bench├── Scienceqa # sqa-img├── ai2d # ai2d├── chartqa # chartqa├├ sement-bench # semilla-img├── Pope # Pope├─ HallusionBench # HallusionBench├── mme_benchmark_release_version # mme├── mathvista # mathvista├── mmbench # mmb├─: mm-vet # mm-vet├── llava-bench-in-the-wild # llava banco en el silvestre en el silvestre en el silvestre en el silvestre en el silvestre en el silvestre en el silvestre en el silvestre ─ Mmstar # mmstar├── Mathverse # Mathverse└── Visualwebbench # VisualWebbench