Este repositorio contiene la implementación para ICLR2024 Paper LLCP: Aprendizaje de procesos causales latentes para la pregunta de video basada en el razonamiento PDF

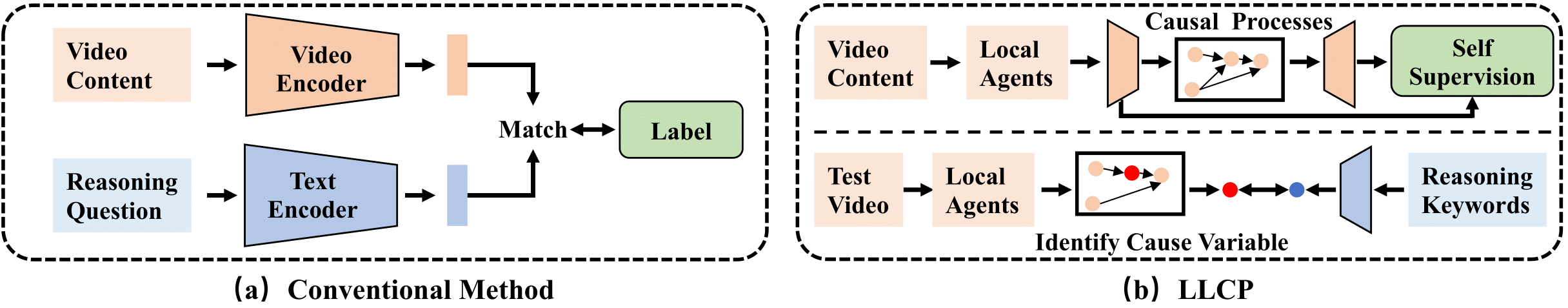

LLCP es un marco causal diseñado para mejorar el razonamiento de video al enfocarse en la dinámica espacial temporal de los objetos dentro de los eventos, sin la necesidad de anotaciones de datos extensas. Al emplear el aprendizaje auto-supervisado y aprovechar la modularidad de los mecanismos causales, LLCP aprende un modelo generativo multivariado para la dinámica espacial-temporal y, por lo tanto, permite una atribución de accidentes efectiva y una predicción contrafactual de VideoQa basado en el razonamiento.

Primero, instale la versión reciente de Pytorch y TorchVision como pip install torch torchvision . Luego, puede instalar otro paquete ejecutando pip install -r requirements.txt

Proporcionamos las características procesadas utilizadas en nuestros experimentos. Descargue los datos y el modelo en este enlace1 y este enlace2. Luego, descomprima las flodas como ./data/ y ./results/ y reemplace las flodas originales como las descargadas.

La estructura del directorio debe verse como

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

Para entrenar el modelo CVAE, puede ejecutar este comando:

python train.py --cfg configs/sutd-traffic_transition.yml

Para evaluar el modelo capacitado, consulte:

python validate.py --cfg configs/sutd-traffic_transition.yml

Ver LLCP-simulación.

Si encuentra útil nuestro trabajo en su investigación, considere citar:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

Nuestra implementación se basa principalmente en el Sutd-Trafficqa y TEM-Adapter, agradecemos a los autores que liberen sus códigos.