中文 Readme 请按此处

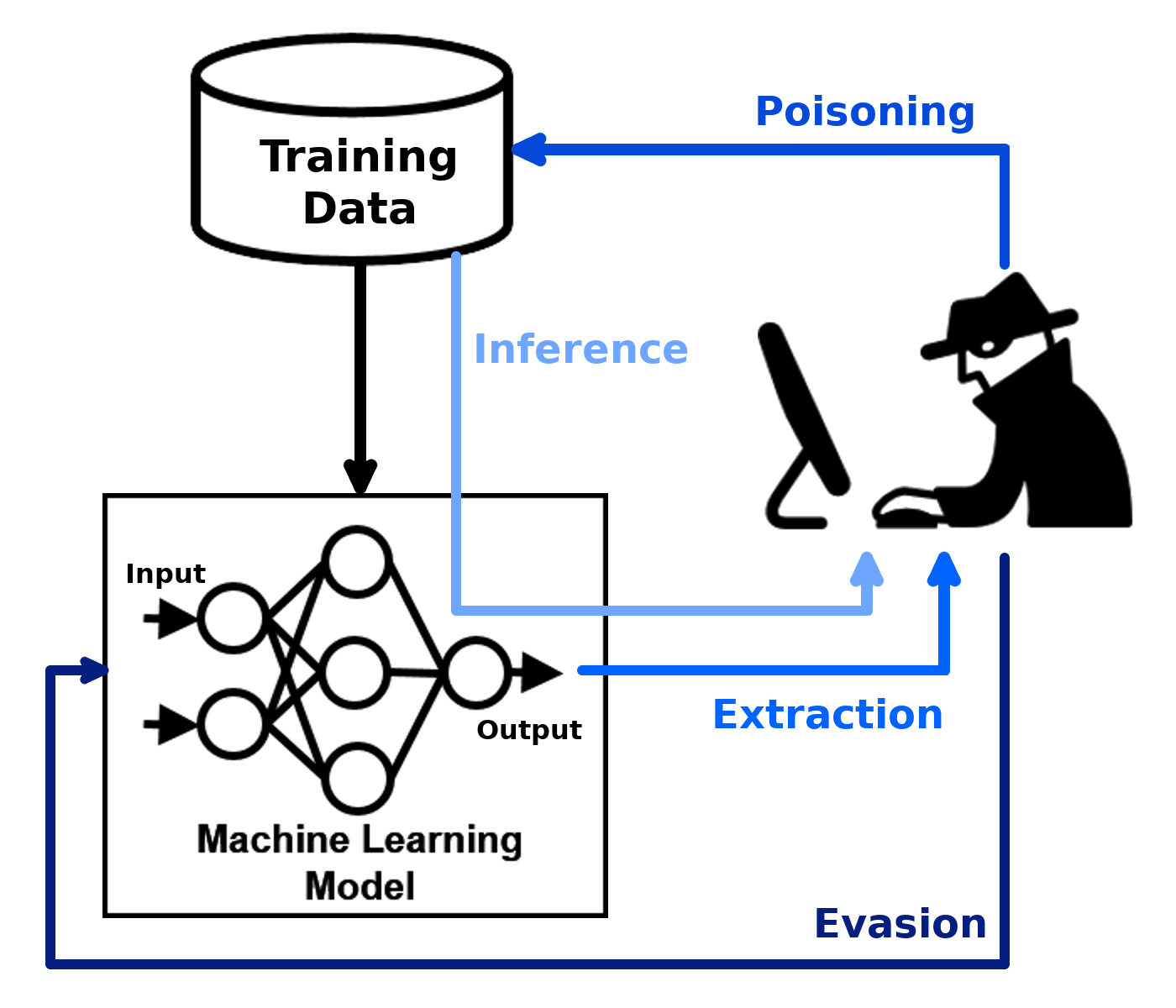

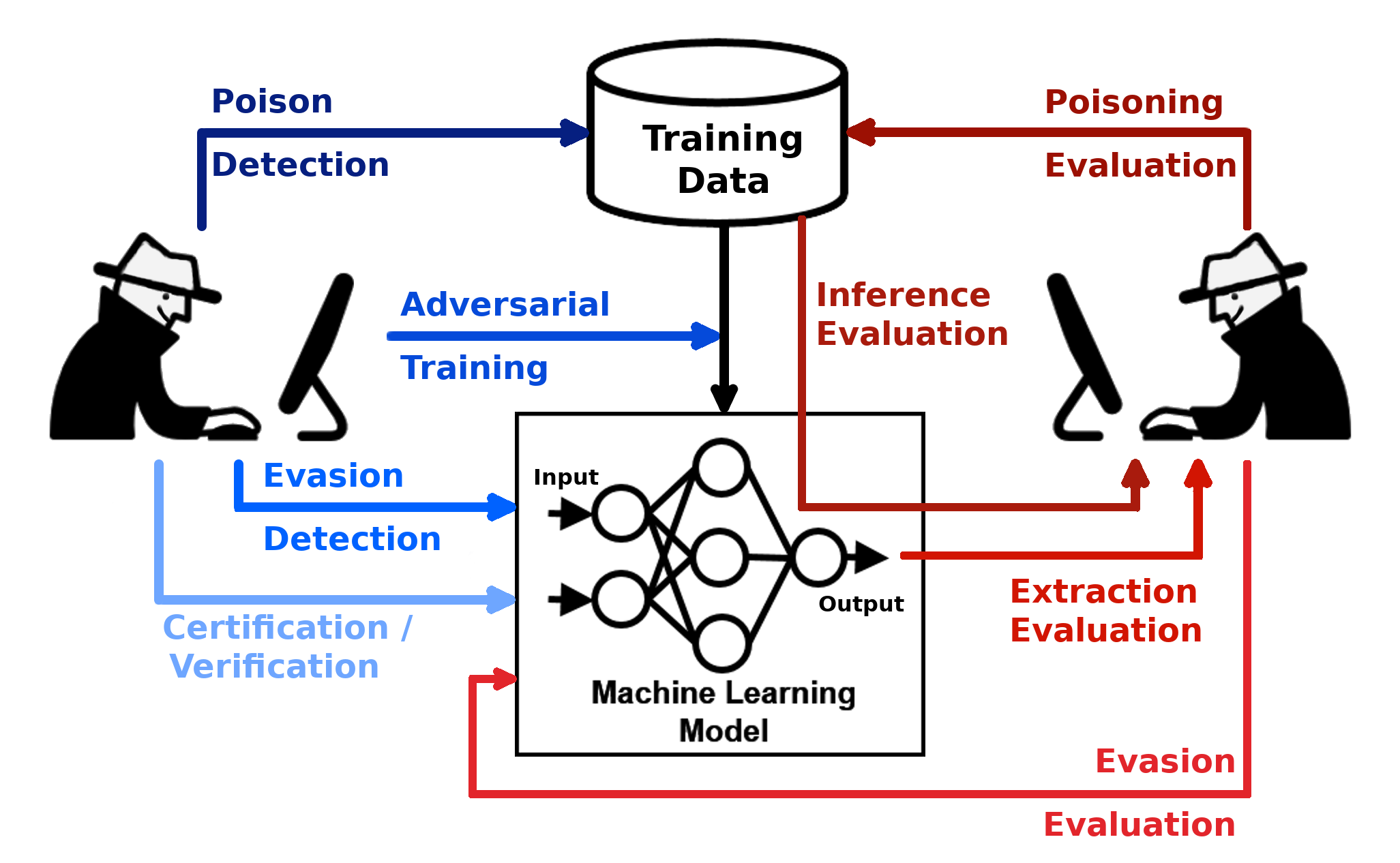

La caja de robustez adversas (ART) es una biblioteca de Python para la seguridad del aprendizaje automático. Art está alojado por la Fundación Linux AI & Data Foundation (LF AI & Data). Art proporciona herramientas que permiten a los desarrolladores e investigadores defender y evaluar modelos y aplicaciones de aprendizaje automático contra las amenazas adversas de evasión, envenenamiento, extracción e inferencia. El arte admite todos los marcos populares de aprendizaje automático (TensorFlow, Keras, Pytorch, MXNET, Scikit-Learn, XGBOost, LightGBM, Catboost, GPY, etc.), todos los tipos de datos (imágenes, tablas, audio, video, etc.) y aprendizaje automático Tareas (clasificación, detección de objetos, reconocimiento de voz, generación, certificación, etc.).

| Empezar | Documentación | Que contribuye |

|---|---|---|

| - Instalación - Ejemplos - cuadernos | - ataques - defensas - Estimadores - Métricas - Documentación técnica | - Slack, invitación - contribuyendo - Hoja de ruta - citando |

La biblioteca está bajo desarrollo continuo. ¡Los comentarios, los informes de errores y las contribuciones son muy bienvenidos!

Este material se basa parcialmente en el trabajo respaldado por la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA) bajo el contrato No. HR001120C0013. Cualquier opinión, hallazgos y conclusiones o recomendaciones expresadas en este material son las de los autores y no reflejan necesariamente las opiniones de la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA).