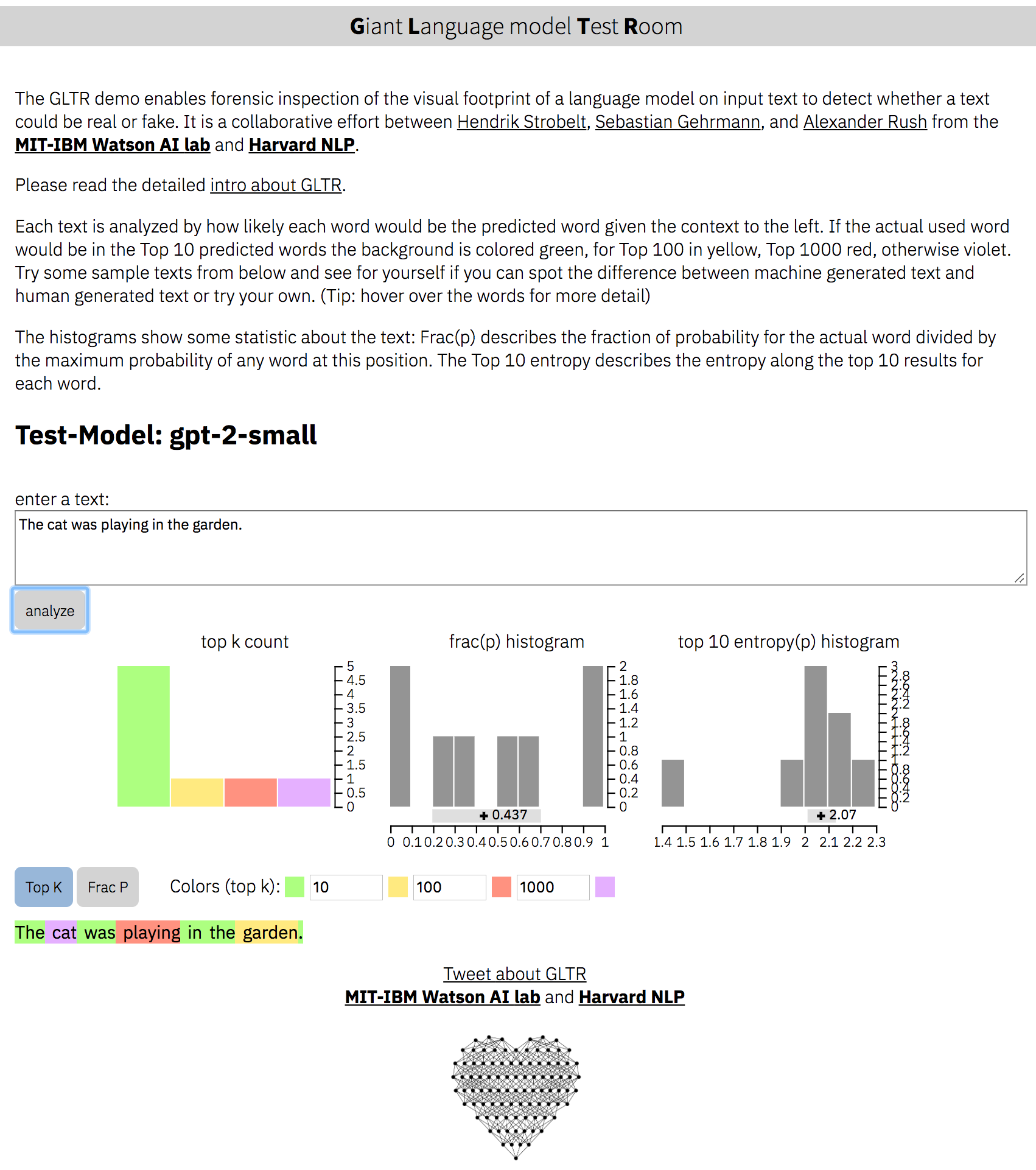

Detección de texto que se generó a partir de modelos de idiomas grandes (por ejemplo, GPT-2).

Página web: http://gltr.io

en línea-demo: http://gltr.io/dist/index.html

Documento: https://arxiv.org/abs/1906.04043

Un proyecto de Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush.

Colaboración de MIT-IBM Watson AI Lab y Harvardnlp

Instalar dependencias para Python> 3.6:

pip install -r requirements.txt Ejecutar servidor para gpt-2-small :

python server.py

La instancia de demostración se ejecuta ahora en http: // localhost: 5001/client/index.html

Inicie el servidor para BERT :

python server.py --model BERT La instancia se ejecuta ahora en http: // localhost: 5001/client/index.html? Nodemo. Sugerencia: solo proporcionamos textos de demostración para gpt2-small .

usage: server.py [-h] [--model MODEL] [--nodebug NODEBUG] [--address ADDRESS]

[--port PORT] [--nocache NOCACHE] [--dir DIR] [--no_cors]

optional arguments:

-h, --help show this help message and exit

--model MODEL choose either 'gpt-2-small' (default) or 'BERT' or your own

--nodebug NODEBUG server in non-debugging mode

--port PORT port to launch UI and API (default:5001)

--no_cors launch API without CORS support (default: False)

El backend define una serie de API del modelo que el servidor puede invocarlo con el parámetro --model NAME . Para agregar un modelo personalizado, debe escribir su propia API en backend/api.py y agregar el decorador @register_api(name=NAME) .

Cada API debe ser una clase que herede de AbstractLanguageChecker , que define dos funciones check_probabilities y postprocess . Siga la documentación dentro de api.py al implementar la clase y las funciones.

El código fuente para el front-end está en client/src .

Para modificar, es necesaria la instalación de dependencias de nodo:

cd client/src ; npm install ; cd ../..Re-compilación de front-end:

> rm -rf client/dist ; cd client/src/ ; npm run build ; cd ../..Apache 2

(c) 2019 por Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush