【2024.06.13】 Modelo MiniCPM-Llama3-V-2_5 de MODEL_NAME=minicpm-v PROMPT_NAME=minicpm-v DTYPE=bfloat16

[2024.06.12] Admite el modelo GLM-4V , modifique la variable de entorno MODEL_NAME=glm-4v PROMPT_NAME=glm-4v DTYPE=bfloat16 , consulte GLM4V para ver ejemplos de pruebas.

【2024.06.08】 El modelo QWEN2 ha sido compatible, modifique la variable de entorno MODEL_NAME=qwen2 PROMPT_NAME=qwen2

【2024.06.05】 Admite el modelo GLM4 y modifique la variable de entorno MODEL_NAME=chatglm4 PROMPT_NAME=chatglm4

【2024.04.18】 Code Qwen , Demo de preguntas y respuestas de SQL

【2024.04.16】 Soporte del modelo de reordenamiento Rerank , método de uso

【 QWEN1.5 】 La variable de entorno MODEL_NAME=qwen2 PROMPT_NAME=qwen2

Para más noticias e historial, vaya aquí

Contenido principal de este proyecto

Este proyecto implementa una interfaz de backend unificada para el razonamiento de los modelos grandes de código abierto, que es consistente con la respuesta de OpenAI y tiene las siguientes características:

Llame a varios modelos de código abierto en forma de OpenAI ChatGPT API

? ️ Admite la respuesta de transmisión para lograr el efecto de la impresora

Implementar el modelo de integración de texto para proporcionar soporte para las preguntas y respuestas de conocimiento de documentos

? ️ Admite varias funciones de langchain , una herramienta de desarrollo de modelos de idiomas a gran escala

chatgpt

Admite la carga de modelos lora autónomos

⚡ Soporte de la aceleración y procesamiento de la inferencia de VLLM de solicitudes concurrentes

| capítulo | describir |

|---|---|

| ? | Modelos de código abierto compatibles con este proyecto e información breve |

| ? Método de inicio | Comandos de configuración y inicio del entorno para modelos de inicio |

| Método de inicio ⚡vllm | Comandos de configuración y inicio del entorno para modelos iniciales utilizando vLLM |

| Método de llamadas | Cómo llamar después de comenzar el modelo |

| ❓faq | Responde a algunas preguntas frecuentes |

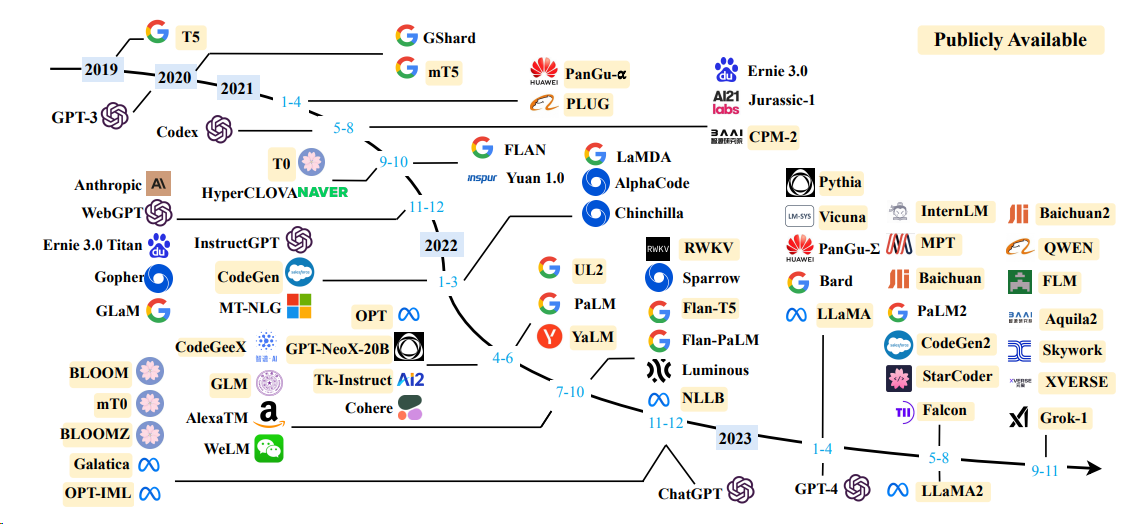

Modelo

| Modelo | Tamaño del parámetro del modelo |

|---|---|

| Baichuan | 7b/13b |

| Chatglm | 6b |

| Veterano | 7b/16b/67b/236b |

| Prostituta | 7B/20B |

| Llama | 7b/13b/33b/65b |

| Llama-2 | 7B/13B/70B |

| LLAMA-3 | 8B/70B |

| Qwen | 1.8b/7b/14b/72b |

| Qwen1.5 | 0.5B/1.8B/4B/7B/14B/32B/72B/110B |

| Qwen2 | 0.5B/1.5B/7B/57B/72B |

| Yi (1/1.5) | 6B/9B/34B |

Para obtener más detalles, consulte el método de inicio de VLLM y el método de inicio de Transformers.

Modelo de incrustación

| Modelo | Dimensión | Enlace de peso |

|---|---|---|

| BGE-LARGE-ZH | 1024 | BGE-LARGE-ZH |

| M3E-Large | 1024 | Moka-Ai/M3E-Large |

| text2vec-Large-chines | 1024 | text2vec-Large-chines |

| BCE-Embedding-Base_V1 (recomendado) | 768 | BCE-Embedding-Base_V1 |

OPENAI_API_KEY : solo complete una cadena aquí

OPENAI_API_BASE : la dirección de la interfaz del inicio del backend, como: http: //192.168.0.xx: 80/v1

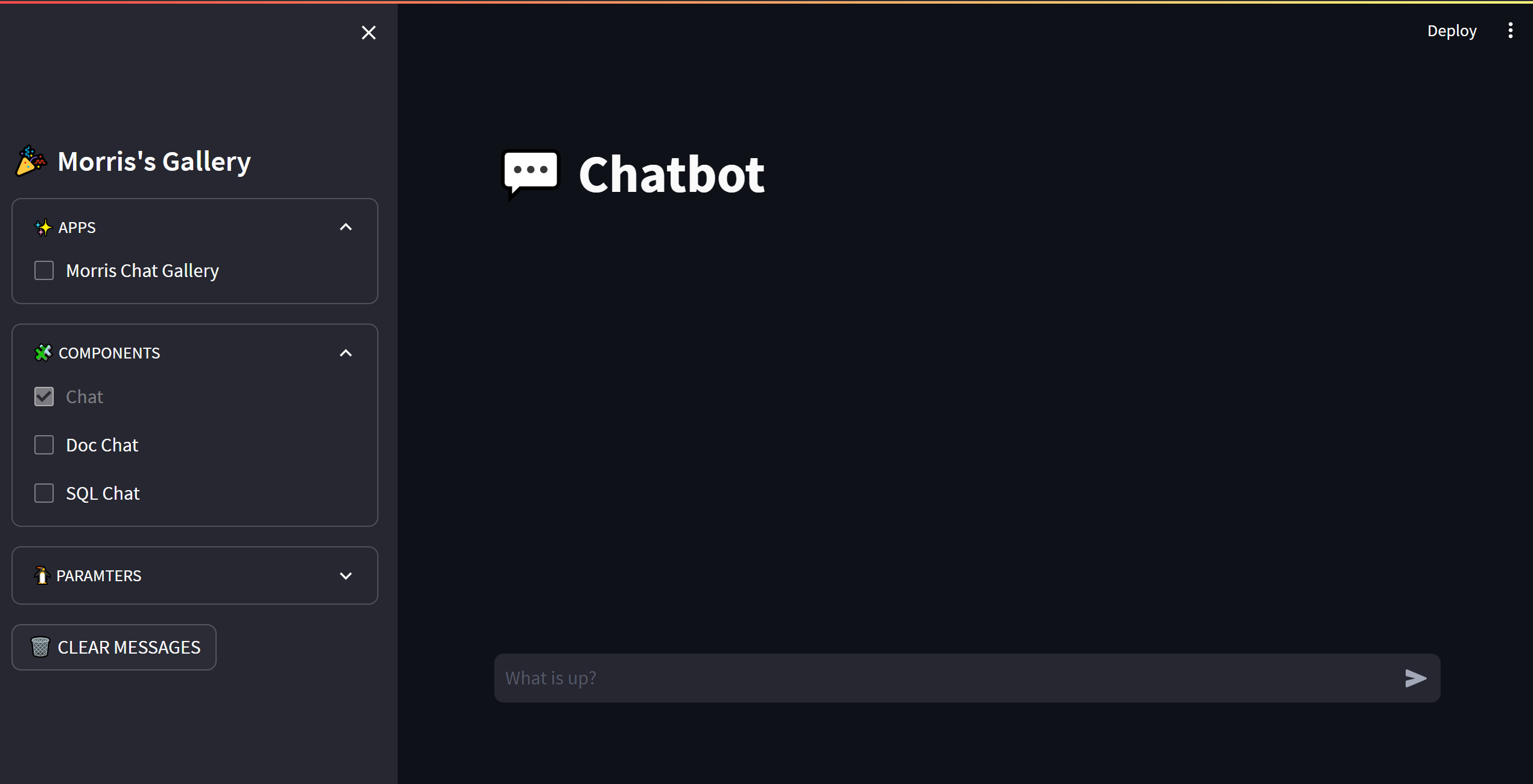

cd streamlit-demo

pip install -r requirements.txt

streamlit run streamlit_app.py

from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

chat_completion = client . chat . completions . create (

messages = [

{

"role" : "user" ,

"content" : "你好" ,

}

],

model = "gpt-3.5-turbo" ,

)

print ( chat_completion )

# 你好!我是人工智能助手 ChatGLM3-6B,很高兴见到你,欢迎问我任何问题。

# stream = client.chat.completions.create(

# messages=[

# {

# "role": "user",

# "content": "感冒了怎么办",

# }

# ],

# model="gpt-3.5-turbo",

# stream=True,

# )

# for part in stream:

# print(part.choices[0].delta.content or "", end="", flush=True) from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# Chat completion API

completion = client . completions . create (

model = "gpt-3.5-turbo" ,

prompt = "你好" ,

)

print ( completion )

# 你好!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。 from openai import OpenAI

client = OpenAI (

api_key = "EMPTY" ,

base_url = "http://192.168.20.59:7891/v1/" ,

)

# compute the embedding of the text

embedding = client . embeddings . create (

input = "你好" ,

model = "text-embedding-ada-002"

)

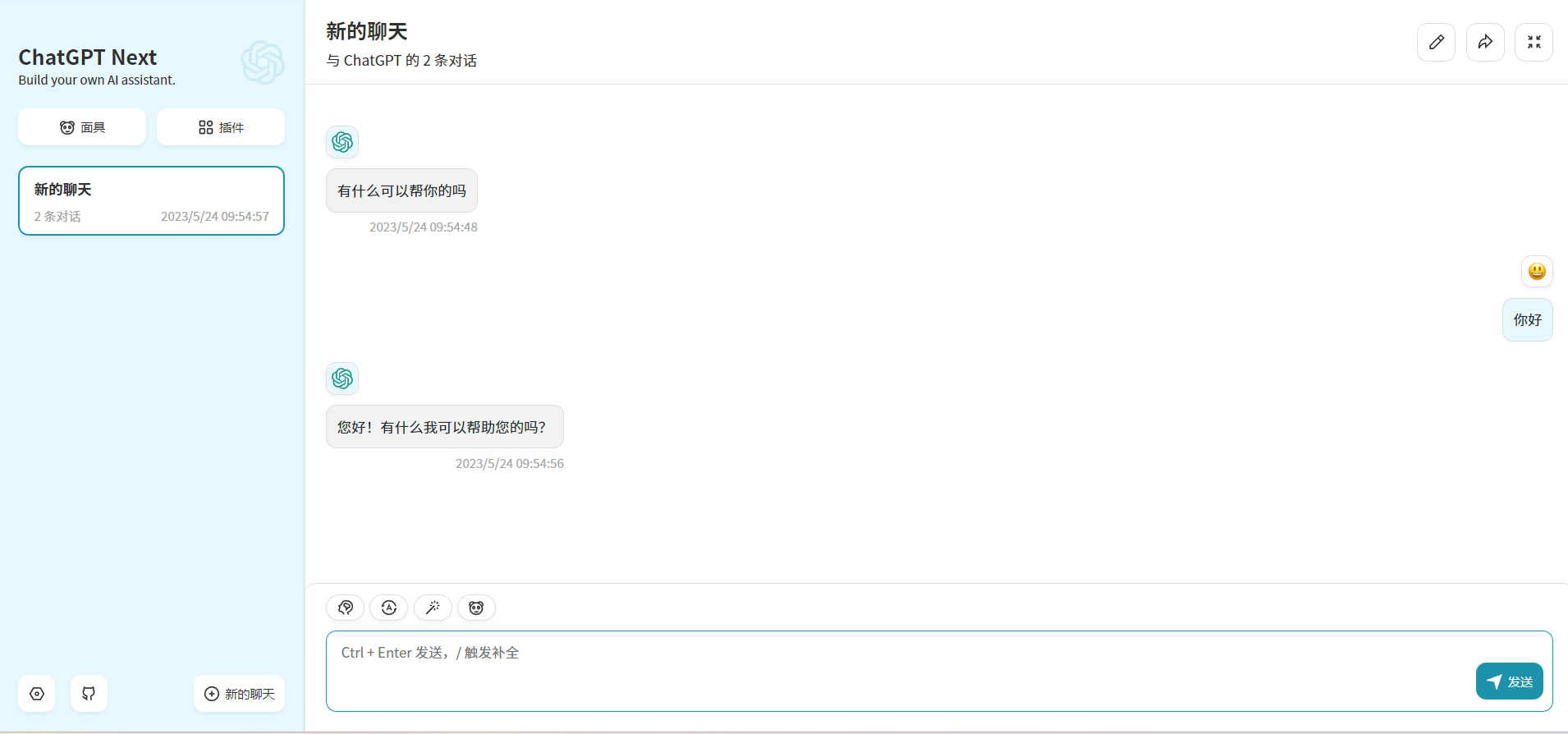

print ( embedding ) Al modificar OPENAI_API_BASE , ¡la mayoría de las aplicaciones chatgpt y los proyectos front-end pueden conectarse sin problemas!

docker run -d -p 3000:3000

-e OPENAI_API_KEY= " sk-xxxx "

-e BASE_URL= " http://192.168.0.xx:80 "

yidadaa/chatgpt-next-web

# 在docker-compose.yml中的api和worker服务中添加以下环境变量

OPENAI_API_BASE: http://192.168.0.xx:80/v1

DISABLE_PROVIDER_CONFIG_VALIDATION: ' true '

Este proyecto tiene licencia bajo la licencia Apache 2.0 , consulte el archivo de licencia para obtener más información.

Chatglm: un modelo de lenguaje de diálogo bilingüe abierto

Bloom: un modelo de lenguaje multilingüe de acceso abierto de 176b-parámetro

LLAMA: modelos de lenguaje de base abierto y eficiente

Codificación de texto eficiente y efectiva para la llama china y la alpaca

Phoenix: Democratizing Chatgpt en todos los idiomas

Moss: un modelo de lenguaje conversacional de origen abierto de complementos de código abierto

FastChat: una plataforma abierta para capacitación, servir y evaluar chatbots basados en modelos de idiomas grandes

Langchain: Aplicaciones de construcción con LLM a través de la composibilidad

Chuanhuchatgpt