Pico MLX Server es la forma más fácil de comenzar con el marco MLX AI de Apple

Pico MLX Server proporciona una GUI para el servidor MLX. El servidor MLX proporciona una API para los modelos MLX locales que conforman la API de OpenAI. Esto le permite utilizar la mayoría de los clientes de Chat Operai existentes con el servidor Pico MLX.

Ver comunidad MLX en Huggingface

Para instalar el servidor PICO MLX, cree la fuente con Xcode o descargue el ejecutable notarizado directamente desde GitHub.

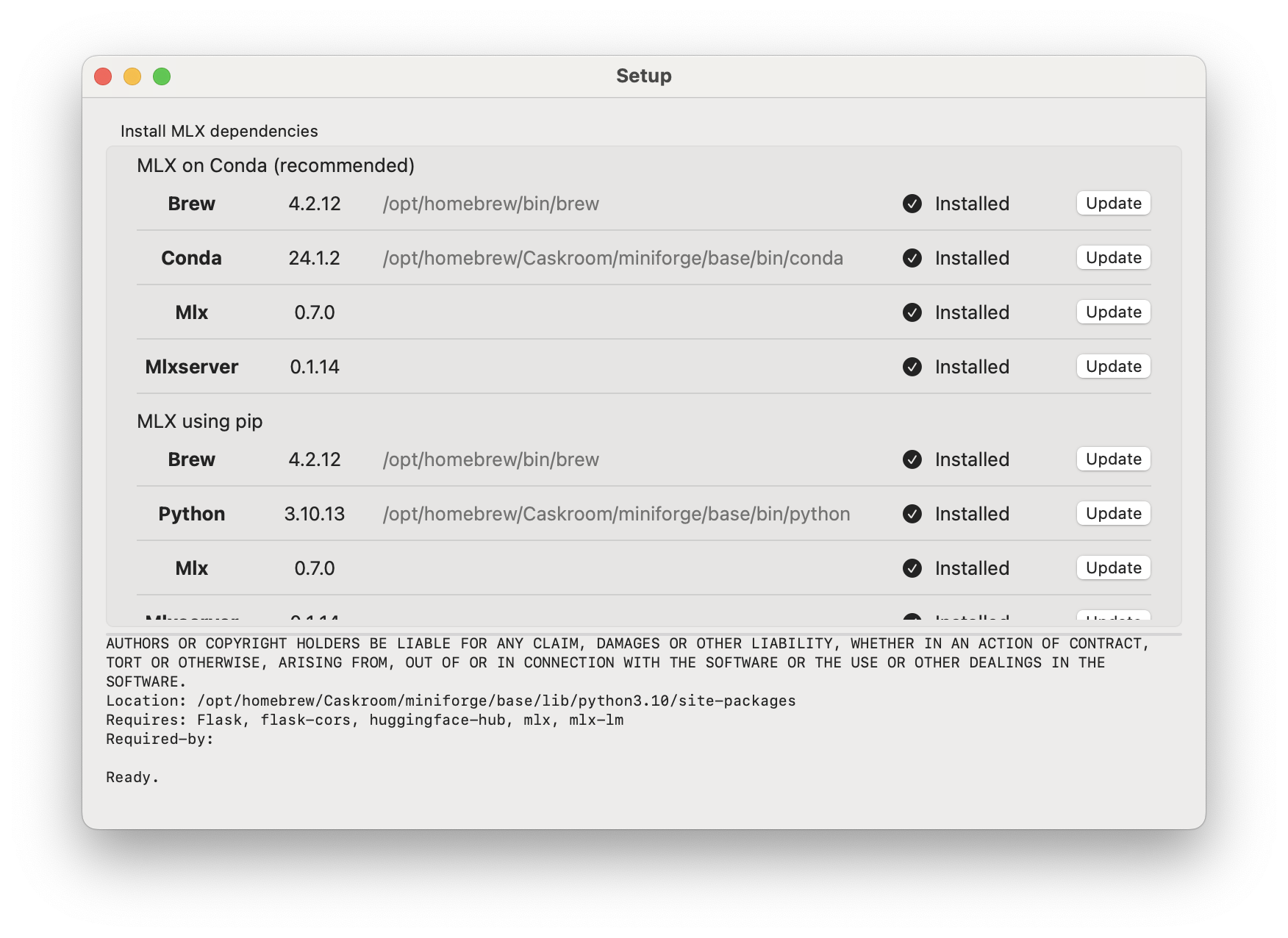

Para configurar el servidor PICO MLX, abra la aplicación y

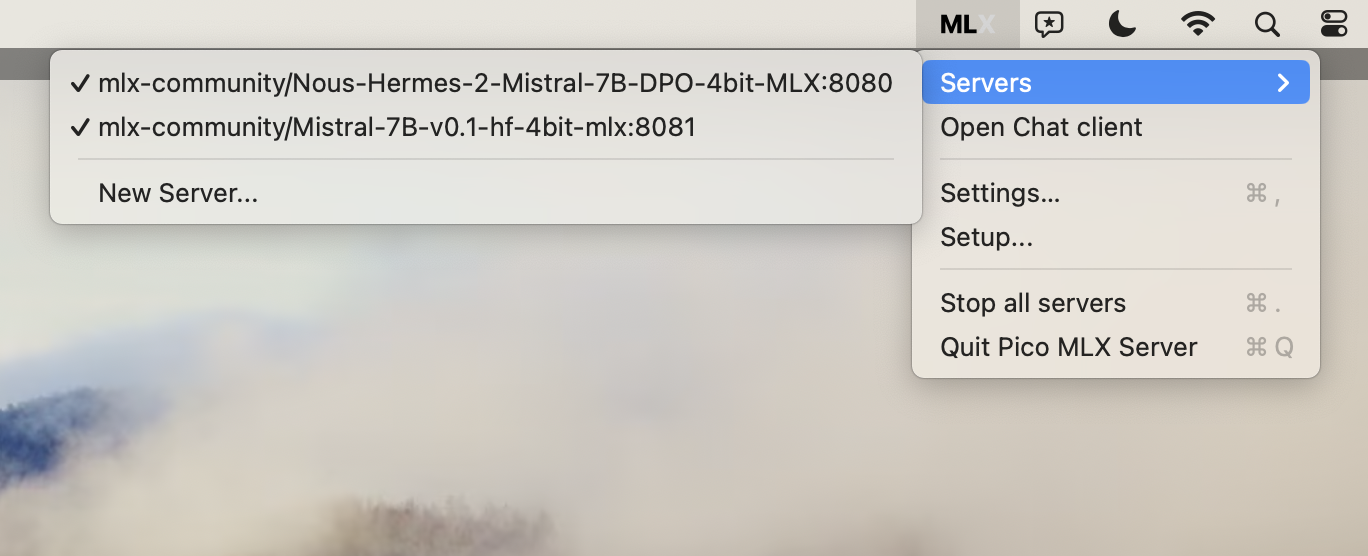

MLX -> Setup... )Settings

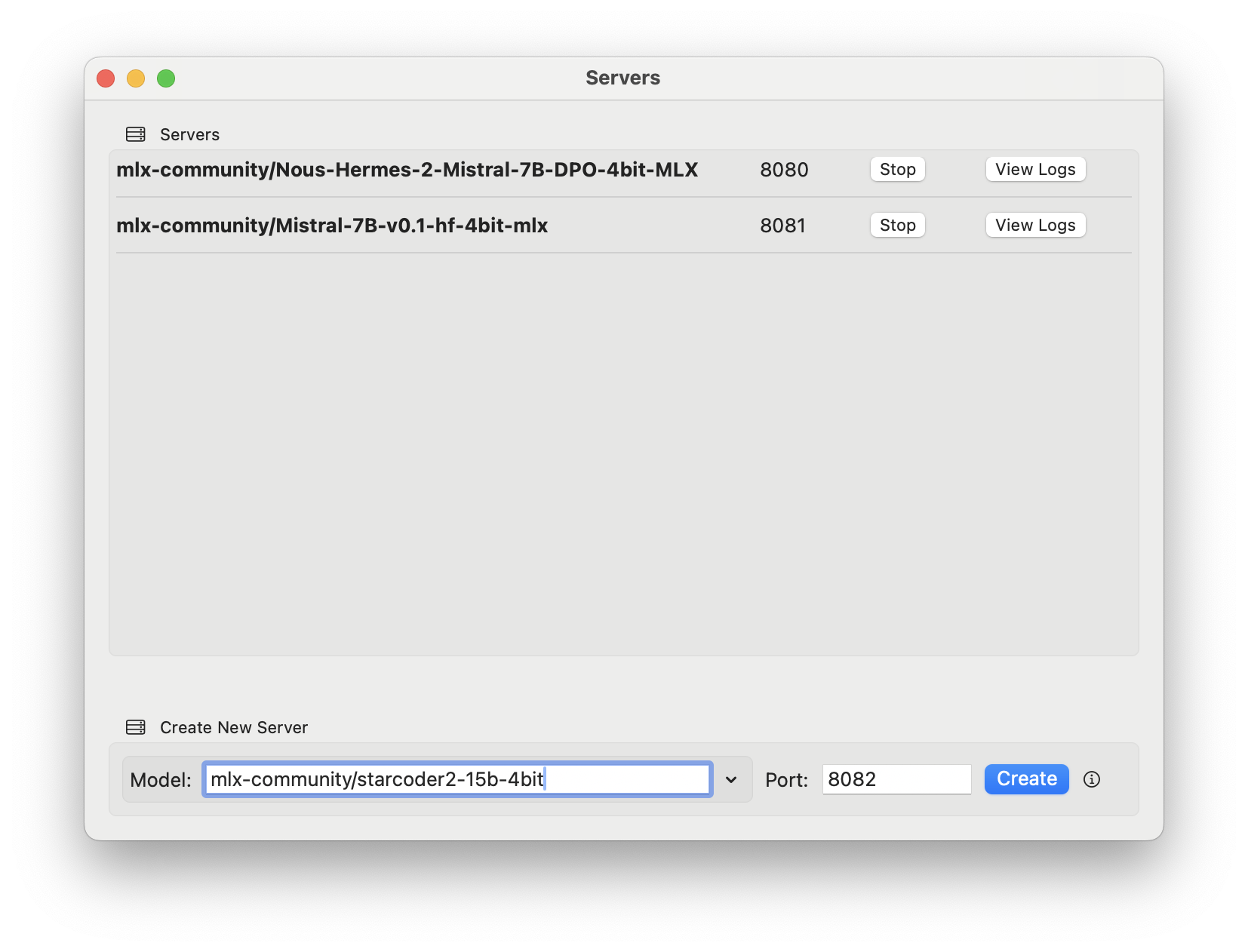

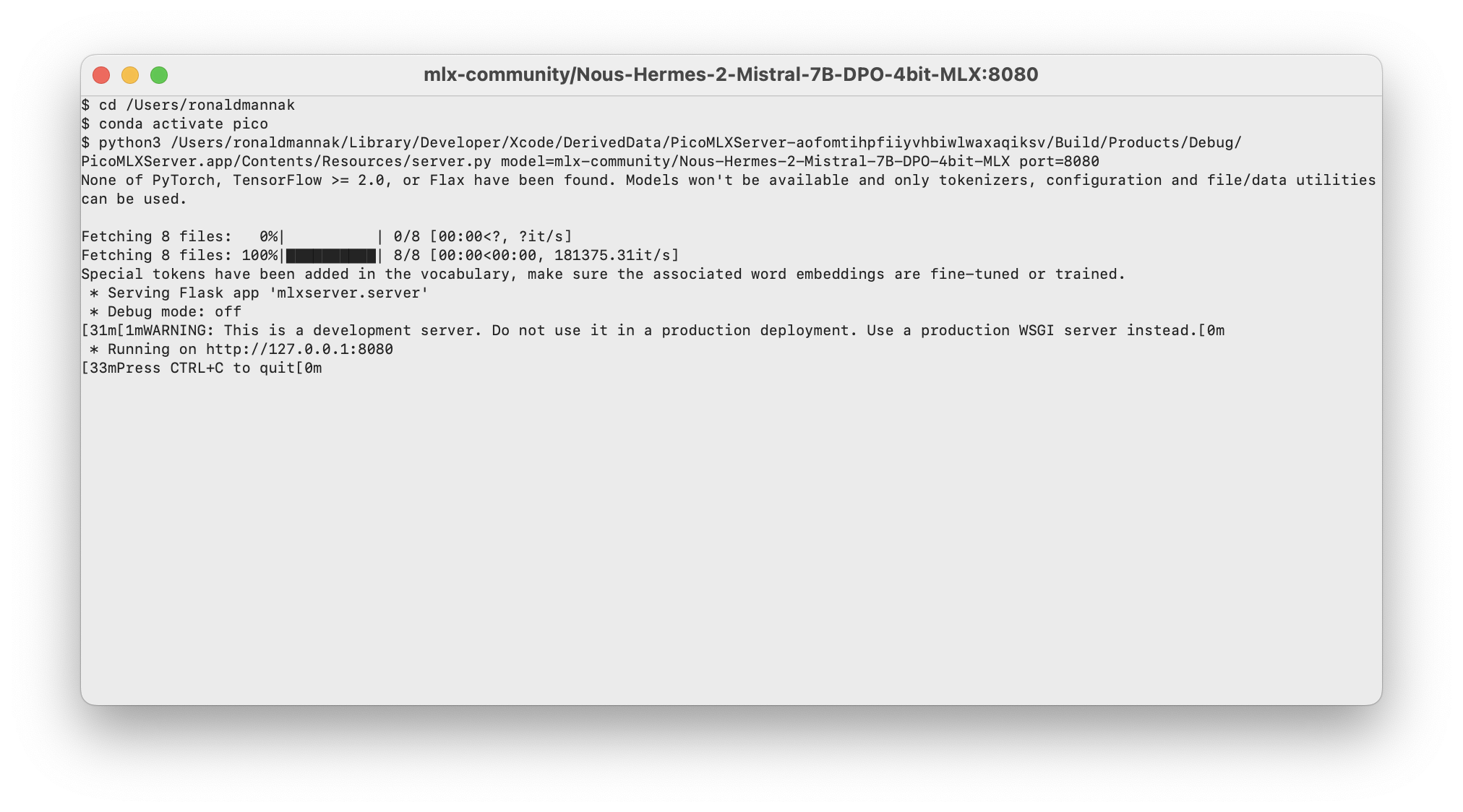

MLX -> Servers -> New Server...Create para crear el servidor predeterminado mlx-community/Nous-Hermes-2-Mistral-7B-DPO-4bit-MLX en el puerto 8080v o escriba un modelo manualmente desde la comunidad MLX en Huggingface (asegúrese de usar la mlx-community/ )View Logs para abrir una ventana con los registros en tiempo real del servidor

Punte cualquier asistente de IA compatible con API de OpenAI a http://127.0.0.1:8080 (o cualquier otro puerto que haya utilizado en el servidor PICO MLX). (Instrucciones para el Asistente de AI Pico Próximamente)

Rizo:

curl -X GET 'http://127.0.0.1:8080/generate?prompt=write%20me%20a%20poem%20about%the%20ocean&stream=true'

POST /v1/completions Openai. Consulte para obtener más información https://platform.openai.com/docs/api-reference/completions/create. lsof -i:8080 en el terminal para encontrar el PID del servidor en ejecución)New Server y el menú Servers donde no se actualiza el estado de los servidores Pico MLX Server es parte de un paquete de herramientas rápidas de código abierto para ingenieros de IA. ¿Busca un proxy OpenAI Swift OpenAI del lado del servidor para proteger sus claves Operai? Echa un vistazo a Swift Operai Proxy.

Pico MLX Server, Swift OpenAi Proxy y Pico AI Assistant fueron creados por Ronald Mannak con la ayuda de Ray Fernando

El servidor MLX fue creado por Mustafa Aljadery y Siddharth Sharma

Código utilizado de MLX Swift Chat y Swift Chat