Recientemente, la agitación de los proyectos OpenAI y sora ha hecho que el mundo exterior se preocupe por la bulliciosa industria del vídeo de IA.

A finales de septiembre, Mira Murati, directora de tecnología de OpenAI, y Barrett Zoff, vicepresidente de investigación, quienes desempeñaron un papel importante en el desarrollo del modelo o1, los modelos GPT-4o y GPT-4v, y el jefe Barret Zoph. El oficial de investigación Bob McGrew también anunció sus salidas.

El 4 de octubre, el líder del proyecto Sora, Tim Brooks, anunció oficialmente su renuncia en la plataforma social X y se unió a Google DeepMind.

Si lo comes junto con el hecho de que no hay un calendario definido para la versión oficial de Sora, será como un drama familiar en el que la burbuja de un proyecto estrella explota y todos en el juego tienen sus propios planes.

Recientemente, la competencia de videos con IA ha comenzado a volverse más intensa.

Según las estadísticas de SimilarWeb, el número total de visitas al sitio web Luma AI de la empresa líder mundial en generación de vídeos de IA en septiembre fue de sólo 11,81 millones de veces, una disminución intermensual del 38,49%. El exitoso pika también experimentó una caída en el total de visitas en septiembre. Aunque volvió a ser popular con un lote de nuevos efectos de plantilla en la nueva versión de octubre, poco a poco ha ido surgiendo la cuestión de cómo el producto puede seguir atrayendo el interés de los usuarios.

Algunos que inicialmente desconfiaban de Sora ahora están siendo reevaluados, como el cineasta Patrick Cederberg que dijo en abril que tenía que hacer que el modelo generara cientos de clips cortos antes de poder encontrar uno disponible. En otras palabras, Sora es muy difícil de utilizar.

Afortunadamente, Tim Brooks no se ha despedido del vídeo con IA. Lo más probable es que se una a la herramienta de generación de vídeo con IA de DeepMind, Veo. El ascenso y la caída de Sora pueden no ser el único punto de referencia para la industria del vídeo con IA. Al menos en términos de capacidades, rivales como Meta Movie Gen están empezando a afirmar que han matado a Sora. El ecosistema nacional de productos de vídeo de IA también ha experimentado nuevos cambios.

En otras palabras, el enfriamiento de la pista de video de IA es también el período de gestación antes de que se repita el siguiente lote de mejores productos. Recientemente, parece que un producto suficientemente sorprendente ha aparecido en la atención del público.

01

PixVerse V3 realmente rompe la pared dimensional

Dado que los productos de vídeo con IA en el mercado se han vuelto tan abundantes que la gente está empezando a experimentar "fatiga visual", ¿es PixVerse V3 realmente lo suficientemente especial?

Si tienes dudas similares, la apariencia de este Pikachu es suficiente para disipar la mayoría de ellas.

A excepción de las demostraciones de conferencias de prensa que no se pueden reproducir, esta es probablemente la primera vez que las imágenes bidimensionales y el mundo real pueden interactuar de manera tan armoniosa en la generación de video con IA.

En la imagen, la imagen de este Pikachu es exactamente la misma que recordamos de la caricatura, pero apareció en una calle muy transitada y luego saltó a los brazos de un hermano pequeño.

Este es el mensaje requerido para este video:

Cámara frontal central: Pikachu se encuentra en una bulliciosa calle de la ciudad, junto a un mochilero. El mochilero pasa junto a la cámara y Pikachu corre por detrás. Saltó a los brazos del mochilero. Pikachu felizmente abrazó su cuello y estuvo muy cerca. Los peatones se apresuraron y los mochileros llevaron a Pikachu hacia adelante, cuyas mejillas brillaban de emoción, iluminando el momento. Encantador y sin esfuerzo.

En 1934, en "Hollywood Party" producida por MGM, la acción de Jimmy Durant de sostener a "Mickey Mouse" con los dedos se convirtió en la primera escena clásica en la historia del cine mundial que combina dibujos animados e imágenes reales, 90 años después, estos efectos están llenos. Un proceso ingenioso pero extremadamente engorroso de implementar finalmente puede ser realizado por la IA.

Lo que es escandaloso es que Pikachu fue creado por IA, y el mundo real donde vive Pikachu también fue creado por IA. A juzgar por los efectos, Pixverse V3 tiene una comprensión muy fluida de la animación que ingresa al mundo real.

No solo Pikachu, también puedes usar el siguiente mensaje, que parece tener demasiados elementos, para generar un video del tío Mario entrando a la estación de tren:

El vídeo muestra una bulliciosa estación de tren llena de una multitud diversa de pasajeros esperando ansiosamente sus trenes. La cámara recorre la escena, capturando la animada atmósfera de Super Mario, un corpulento personaje italiano con cara redonda, con su icónico sombrero rojo. mono azul La cámara sigue de cerca a Mario mientras sube con confianza a la plataforma, con el rostro radiante de emoción. El video tiene un estilo realista.

En el vídeo, la estación de tren está repleta de pasajeros de todo tipo esperando ansiosamente el tren. La cámara recorre la escena, capturando la atmósfera animada. A medida que el tren se acerca lentamente al andén, la cámara sigue al alto personaje italiano de cara redonda, Super Mario. Con su icónico sombrero rojo y un mono azul, camina con confianza hacia el andén con una sonrisa emocionada. El estilo del vídeo es muy realista.

Hay un protagonista distinto, Mario, en la imagen. Cada una de las bulliciosas multitudes detrás de él tiene diferentes detalles de sus movimientos. A medida que Mario avanza junto a la cámara, los bordes donde los personajes animados se cruzan con el entorno real también se manejan con mucha claridad. Y limpiamente, al mismo tiempo, el tren también entró en la estación.

Si los personajes de dibujos animados no pueden satisfacer su apetito, echemos un vistazo a cómo se desempeña PixVerse V3 en escenas grandes.

——Palabras clave: El dragón se duerme.

El mensaje completo es así:

Toma de seguimiento con Steadycam de un dragón sumergiéndose en el agua, el monje levanta los brazos en señal de agradecimiento.

Seguimiento con Steadicam: un dragón se sumerge en el agua y un monje levanta los brazos en señal de agradecimiento.

Aunque al video todavía le faltan algunos de los detalles mencionados en Prompt, en general, ya sea la consistencia del movimiento de la cámara, la capacidad de usar tonos sombríos para expresar sutilmente la tensión de la imagen y el uso de monstruos en la distancia y abandonados. automóviles en primer plano Las capacidades de generación de video de PixVerse V3 han comenzado a acercarse a la calidad de imagen de una película.

Además de los vídeos de Vincent, esta vez PixVerse V3 también demostró excelentes capacidades de vídeo basadas en imágenes.

El video de Tusheng es muy imaginativo. Puedes intentar encontrar un hermoso cartel de una película del oeste estadounidense, agregarle un mensaje y dejarlo hacer algunas cosas "escandalosas", como encontrar un revólver de mala calidad:

El mensaje es así:

El mensaje completo es así:

La pistola falla y desprende humo negro, lo que ensucia la cara del hombre.

La pistola falló y salió humo negro que manchó el rostro del hombre.

La sensación más distintiva de PixVerse V3 en términos de sus capacidades de video Wensheng y Tusheng es que está extremadamente cerca de los puntos de interés en la vida diaria de la gente común. De hecho, a excepción de los profesionales relacionados con la creación de vídeos, no muchas personas necesitan utilizar software de vídeo de IA para crear una obra cinematográfica y televisiva perfecta. Por el contrario, más personas que acaban de usar la capacidad de generación de video sienten curiosidad por saber si esta capacidad se puede jugar con el mundo real o incluso con ellos mismos. Por ejemplo, puedes introducir a tus personajes de dibujos animados favoritos en los lugares donde sales todos los días, o incluso convertirte en personajes de dibujos animados como Iron Man.

Muchas de las dificultades que enfrentan actualmente los productos de video de IA se deben al hecho de que están estancados en la autopromoción de capacidades técnicas y los usuarios han desaparecido. En esta etapa, cuando la tecnología de video Vincent acaba de surgir, lo que a la mayoría de la gente común le puede gustar es un producto de video de IA que sea lo suficientemente cercano y amigable para ellos.

Desde esta perspectiva, el actual PixVerse V3 puede ser el producto que adivina con mayor precisión la mente del usuario.

Lo sorprendente de PixVerse V3 no se debe solo a las capacidades iterativas del gran modelo de video de IA detrás de PixVerse V3, sino también a su optimización de las capacidades de comprensión rápida de palabras. Creo que las personas cuidadosas habrán notado esto después de ver los ejemplos anteriores.

"Asunto + Descripción del sujeto + Movimiento + Entorno" es una fórmula rápida que maximiza la efectividad de la generación de videos con IA. En comparación con V2.5, ahora puede agregar una dimensión de "descripción de la toma" a PixVerse V3.

Por supuesto, además de seguir esta fórmula, Prompt debe describir las acciones del personaje con el mayor detalle posible y evitar descripciones demasiado simplificadas.

Al mismo tiempo, PixVerse V3 también tiene una selección más rica de vídeos de salida. En términos de formatos de vídeo de salida, PixVerse V3 admite una variedad de proporciones de vídeo que incluyen 16:9, 9:16, 3:4, 4:3 y 1. :1., la función de estilización también se actualizó después de la actualización de esta versión. Ahora los dos modos de Vincent Video y Tusheng Video admiten cuatro opciones de estilo: animación, realidad, arcilla y 3D.

En una palabra, PixVerse V3 no sólo es más fuerte esta vez, sino que incluso quiere poner en tus manos descripciones de productos línea por línea.

En la plataforma social X, muchos seguidores de productos de IA han comenzado a utilizar PixVerse V3, como Pierrick Chevallier, que tiene muchos seguidores. Incluso preparó una publicación dedicada para mostrar los videos que generó usando PixVerse V3. Además de su poderosa capacidad de generación, lo que llama la atención es que muestra muchos videos con mucho "sabor a Halloween".

02

Este Halloween, deja que PixVerse V3 haga los “efectos”

Para romper el círculo de un producto de video de IA lo suficientemente interesante, además de tener suficiente soporte técnico, también necesita una buena oportunidad. Hablando de eso, el lanzamiento de PixVerse V3 llega en el momento adecuado.

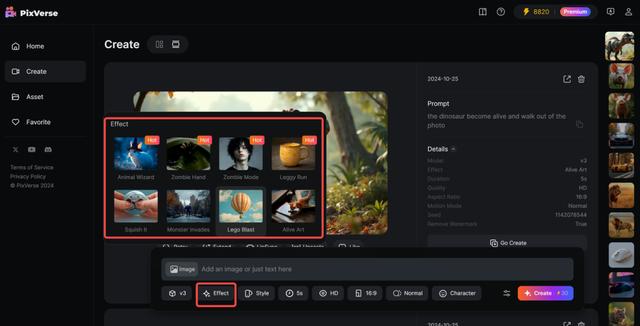

El 1 de noviembre es Halloween y este momento de finales de octubre es el pico anual de imaginación de los jóvenes. Junto con el tema de Halloween, PixVerse V3 ha lanzado una serie de plantillas con temas de Halloween, que te permiten usar IA para "lanzar hechizos" sobre todo lo que te rodea.

Esta vez hay un total de 8 plantillas con temas de Halloween lanzadas en PixVerse V3, una de las cuales se centra en la "Transformación en una persona viva".

Por ejemplo, un monstruo aparece de la nada en la ciudad.

Además de escenas tan grandes, PixVerse V3 puede hacer que los elementos de una foto estén "vivos" directamente, como hacer que el cachorro en "Te estoy esperando bajo la lluvia" realmente salga de la foto:

El cachorro incluso tiene un movimiento natural de levantar la cabeza antes de levantarse. Después de salir de la foto, la foto original solo dejaba un césped tranquilo y todo el efecto fue bastante impresionante.

Esta plantilla también tiene una jugabilidad más imaginativa. Por ejemplo, ¿se puede permitir que el Hombre de Vitruvio de las obras de Leonardo da Vinci salga del círculo que lo enmarca?

Algo como esto:

Poder montar un espectáculo así en Halloween es suficiente para sorprender al público.

Esta vez, el segundo tipo de plantilla preparada por PixVerse V3 para Halloween toma la ruta abstracta.

Por ejemplo, dejemos que una caja de hierro se levante y se escape:

O destroza un Porsche y conviértelo en un montón de bloques:

Por supuesto, esta vez las plantillas de PixVerse V3 también tienen muchos más efectos similares a los de Halloween que se pueden reproducir, como poner un sombrero de mago en la foto de un personaje y luego moverlo, así:

Estas plantillas de Halloween están incluidas en la nueva función Efectos de PixVerse V3. Es muy sencillo de usar. Después de cargar la imagen, seleccione el efecto que desee y haga clic para generarlo. No hay necesidad de preocuparse por ingresar mensajes en el medio. Es muy amigable para las personas que solo piensan en Halloween.

Esta vez, PixVerse V3 muestra capacidades de generación multimodal más sólidas. Basado en su propio video Wensheng y video Tusheng, PixVerse V3 ahora puede hacer que el video generado contenga el contenido de sonido que el usuario desea y, si el video original no es lo suficientemente largo, PixVerse V3 ahora. tiene la capacidad de crear más continuaciones del vídeo original.

Estas capacidades de generación multimodal también se han convertido en dos nuevas características que debutan en PixVerse V3 junto con Effect. La primera función es Lipsync, una función de sincronización de labios que puede generar voces sincronizadas de personajes multilingües para videos.

La función Lipsync permite a los usuarios ingresar su propia redacción o cargar archivos de audio según el video generado, y luego PixVerse adaptará automáticamente la forma de la boca de los personajes en el video según la redacción o el contenido del archivo de audio. Actualmente, Lipsync puede admitir una duración de video de 30 segundos y los idiomas que pueden sincronizar los labios incluyen inglés, chino, francés y japonés.

Otra función es ampliar el vídeo, o puede entenderse como una continuación de la historia.

En respuesta al problema de que la duración del video generado actualmente es demasiado corta, en PixVerse V3, los usuarios pueden seleccionar el video generado, hacer clic en el botón "Extender", ingresar palabras relacionadas con cómo desarrollar aún más el video, hacer clic en "crear". ", y el video original será La dirección propuesta logra la progresión de la trama manteniendo un alto grado de coherencia entre los personajes y las acciones.

Con la incorporación de capacidades de generación de video multimodal, PixVerse V3 ahora puede generar videos de IA con narrativas más amplias y mejores efectos audiovisuales, y los límites de la creación de videos de IA se han ampliado aún más.

Cree un producto de vídeo con IA que sea realmente reproducible

"El momento de ChatGPT será cuando los usuarios comunes puedan usarlo", dijo Wang Changhu, fundador y director ejecutivo de Aishi Technology, en una entrevista en abril de este año.

En los últimos dos años, cada nuevo destello de tecnología de modelos a gran escala se ha transformado en nuevas grandes narrativas sobre los métodos de producción, como si la vida humana fuera a ser completamente subvertida en un corto período de tiempo. Pero hasta ahora esto no ha sucedido.

Al mismo tiempo, el entusiasmo provocado por Sora y la imaginación técnica demasiado ambiciosa han provocado gradualmente que todo el campo de los productos de vídeo de IA pierda el foco y no encuentre conexión con la vida pública. Por lo tanto, por un lado, los productos de vídeo de IA como Runway, que se posicionan como herramientas profesionales, son difíciles de salir del círculo debido al alto umbral de uso. Por otro lado, los productos que se posicionan más hacia lo general. Después de haber sido probado por todos, el público ha caído en el dilema de "quemarse después de leer". Una vez que la novedad desaparece, es difícil retener el producto. El producto carece de ideas de desarrollo claras y específicas, por lo que no tiene más remedio que hundirse. la simple lógica de la "filtración" y los "efectos especiales".

En otras palabras, la enorme apertura de las capacidades de generación de IA hace que casi todos los productos actuales en el campo del video de IA parezcan una especie de producto semiacabado. La aleatoriedad y la incontrolabilidad del contenido generado se empaquetan en una experiencia novedosa, lo que también significa. que es difícil de utilizar en el campo utilizado en un escenario específico y persistente.

Al igual que cuando el mundo exterior quedó asombrado por las capacidades de generación de globos de Sora, Patrick Cederberg estaba preocupado por la falta de coherencia en la generación de contenido de Sora. Se quejó de que el color de los globos cambiaría con cada generación, y estas imperfecciones significan mucho. del trabajo de postproducción sigue siendo inevitable. Hay muchos problemas similares, por lo que, aunque hace un año Hollywood empezó a denunciar la posible perturbación de la industria cinematográfica por parte de las grandes modelos, un año después Sora todavía no puede entrar en el flujo de trabajo del cine y la televisión.

En la actualidad, los productos de video con IA están más o menos atrapados en una situación similar: aunque las capacidades de generación de video con IA han entusiasmado a todos durante mucho tiempo, los productos de generación de video con IA siguen siendo un hermoso "espectáculo para vendedores".

Ante el nuevo torrente tecnológico, es difícil que un producto permanezca "concreto". Sin embargo, lo que Aishi Technology ha entregado desde la versión web original de PixVerse al actual PixVerse V3 es un camino de iteración poco común, claro y ordenado.

En enero de este año, Aishi Technology lanzó oficialmente la versión web de PixVerse, un producto de vídeo de PixVerse. Pero en ese momento, incluido PixVerse, el problema que enfrentaban casi todos los productos de video de Wensheng era que las imágenes generadas eran incontrolables, lo que significaba que los usuarios no podían generar continuamente contenido de video en torno a un personaje unificado. Tres meses después, la versión web de PixVerse estaba equipada con la función C2V (Character to Video) desarrollada en base al modelo de video grande de desarrollo propio, que inicialmente resolvió el problema de coherencia en la creación de videos con IA al extraer con precisión las características del personaje para bloquearlo.

Después de corregir el "rol" en el vídeo, PixVerse centró las iteraciones posteriores en la "controlabilidad" del comportamiento en el contenido generado. En junio de este año, Aishi Technology lanzó el pincel de movimiento Magic Brush. Los usuarios pueden controlar con precisión el movimiento y la dirección de cada elemento simplemente untándolos en la pantalla de video. PixVerse V2 se lanzó a finales de julio. Además de mostrar suficiente control sobre el contenido generado, la dificultad de las indicaciones también se ha reducido significativamente. Al mismo tiempo, los medios para ajustar los efectos generados se han vuelto más abundantes.

Esta es otra iteración con intenciones muy claras: "Es necesario probar la forma específica del producto, pero al final todavía esperamos servir a la mayoría de los usuarios comunes", como dijo Wang Changhu en una entrevista anterior.

Cuando las capacidades de generación de video no pueden satisfacer directamente las necesidades de los usuarios comunes, servir a los creadores profesionales y desarrollar herramientas de próxima generación basadas en nuevos paradigmas de generación de contenido es una mayor prioridad. "Cuando los factores de producción se incluyen en la tecnología (por ejemplo, la IA reemplaza a los actores, las escenas y las cámaras durante la filmación), entonces el público puede comenzar a utilizar las capacidades de generación de video de la IA y el círculo de usuarios se expandirá gradualmente, creando enormes oportunidades. "

Esta vez, PixVerse 3V comenzó a intentar introducir más juegos relacionados con la vida de la gente común y trató de usar Prompt para configurar la lente. Esto último puede verse como un intento de reemplazar parcialmente la cámara. Desde este punto de vista, Aishi Technology ha seguido un camino muy decidido para pulir la dirección de su producto.

En la ola tecnológica de generación de videos de IA, donde la divergencia es la belleza, la elección de Aishi Technology es ir en contra de la tendencia general, mantenerse alejado de las grandes narrativas y proporcionar el plan más específico sobre cómo se pueden reproducir los productos de video de IA.

Sólo cuando las personas puedan sostenerlo en sus manos y jugar con él tanto como sea posible, la aplicación de video de IA podrá pasar de un "espectáculo de vendedores" dirigido por Sora a un vibrante "espectáculo de compradores".

El sorprendente debut de PixVerse V3 puede ser el comienzo de otro cambio positivo detrás de este "enfriamiento" de los vídeos de IA.