El editor de Downcodes se enteró de que Hugging Face lanzó hoy SmolLM2, una serie de modelos de lenguaje compactos que son impresionantes en términos de rendimiento y requieren muchos menos recursos informáticos que los modelos grandes. Sin duda, esta es una buena noticia para los desarrolladores que desean implementar aplicaciones de inteligencia artificial en dispositivos con recursos limitados. SmolLM2 se lanza bajo la licencia Apache 2.0 y proporciona tres modelos con diferentes tamaños de parámetros, que se pueden adaptar de manera flexible a diversos escenarios de aplicación.

Hugging Face lanzó hoy SmolLM2, un nuevo conjunto de modelos de lenguaje compactos que logran un rendimiento impresionante y al mismo tiempo requieren muchos menos recursos computacionales que los modelos más grandes. El nuevo modelo se lanza bajo la licencia Apache 2.0 y viene en tres tamaños (parámetros 135M, 360M y 1.7B) adecuados para su implementación en teléfonos inteligentes y otros dispositivos periféricos con potencia de procesamiento y memoria limitadas.

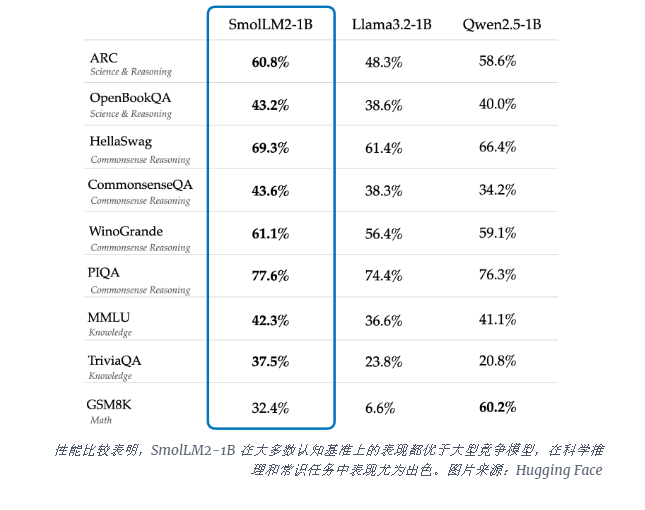

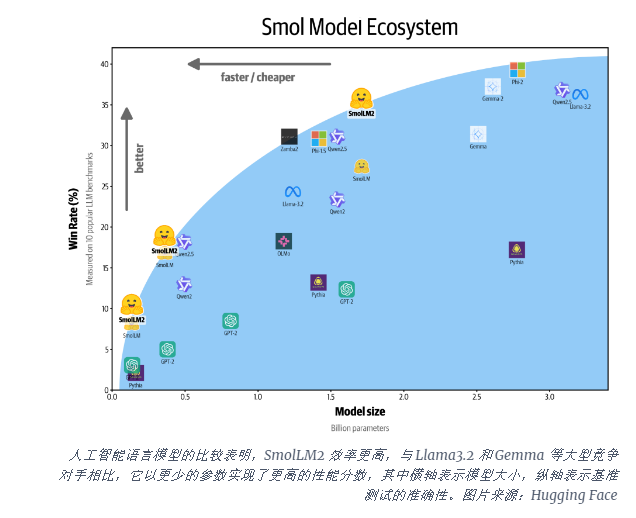

El modelo SmolLM2-1B supera al modelo Llama1B de Meta en varios puntos de referencia clave, particularmente en razonamiento científico y tareas de sentido común. El modelo supera a los grandes modelos competidores en la mayoría de los puntos de referencia cognitivos, utilizando una combinación diversa de conjuntos de datos que incluyen FineWeb-Edu y conjuntos de datos especializados en matemáticas y codificación.

El lanzamiento de SmolLM2 llega en un momento crítico en el que la industria de la IA se enfrenta a las demandas computacionales de ejecutar grandes modelos de lenguaje (LLM). Si bien empresas como OpenAI y Anthropic continúan superando los límites de la escala de modelo, existe un reconocimiento cada vez mayor de la necesidad de una IA eficiente y liviana que pueda ejecutarse de forma nativa en el dispositivo.

SmolLM2 ofrece un enfoque diferente para llevar potentes capacidades de IA directamente a los dispositivos personales, lo que apunta a un futuro en el que las herramientas avanzadas de IA estarán disponibles para más usuarios y empresas, no sólo para gigantes tecnológicos con enormes centros de datos. Estos modelos admiten una variedad de aplicaciones, incluida la reescritura de texto, el resumen y la llamada de funciones, y son adecuados para su implementación en escenarios donde las limitaciones de privacidad, latencia o conectividad hacen que las soluciones de inteligencia artificial basadas en la nube no sean prácticas.

Si bien estos modelos más pequeños todavía tienen limitaciones, representan parte de una tendencia más amplia hacia modelos de IA más eficientes. El lanzamiento de SmolLM2 muestra que el futuro de la inteligencia artificial puede no pertenecer sólo a modelos cada vez más grandes, sino a arquitecturas más eficientes que puedan proporcionar un rendimiento potente con menos recursos.

La aparición de SmolLM2 ofrece nuevas posibilidades para el desarrollo de aplicaciones de IA ligeras y también indica que la tecnología de IA se volverá más popular y beneficiará a más usuarios. El editor de Downcodes cree que en el futuro aparecerán modelos de IA más eficientes y de bajo consumo de recursos para promover el desarrollo de la tecnología de inteligencia artificial.