¡El editor de Downcodes le explicará los últimos resultados de las investigaciones de la Universidad de Princeton y la Universidad de Yale! Esta investigación explora en profundidad las capacidades de razonamiento de la "Cadena de Pensamiento (CoT)" de los grandes modelos de lenguaje (LLM), revelando que el razonamiento CoT no es una simple aplicación de reglas lógicas, sino una fusión compleja de múltiples factores como la memoria, la probabilidad y razonamiento del ruido. Los investigadores seleccionaron la tarea de descifrado de cifrado por desplazamiento y realizaron un análisis en profundidad de tres LLM: GPT-4, Claude3 y Llama3.1. Finalmente, descubrieron tres factores clave que afectan el efecto de inferencia de CoT y propusieron el mecanismo de inferencia de LLM. nuevos conocimientos.

Investigadores de la Universidad de Princeton y la Universidad de Yale publicaron recientemente un informe sobre las capacidades de razonamiento de la "Cadena de Pensamiento (CoT)" de los modelos de lenguaje grandes (LLM), que revela el secreto del razonamiento CoT: no es un razonamiento puramente simbólico basado en reglas lógicas, sino Combina múltiples factores como la memoria, la probabilidad y el razonamiento de ruido.

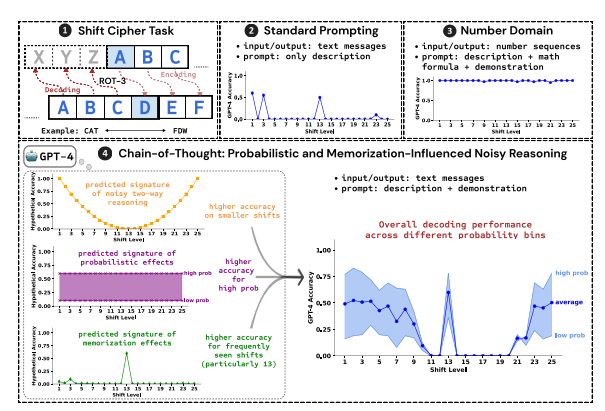

Los investigadores utilizaron descifrar el cifrado de desplazamiento como tarea de prueba y analizaron el rendimiento de tres LLM: GPT-4, Claude3 y Llama3.1. Un cifrado por desplazamiento es una codificación simple en la que cada letra se reemplaza por una letra desplazada hacia adelante un número fijo de lugares en el alfabeto. Por ejemplo, si avanza el alfabeto 3 lugares, CAT se convierte en FDW.

Los resultados de la investigación muestran que los tres factores clave que afectan el efecto de razonamiento CoT son:

Probabilístico: LLM prefiere generar resultados de mayor probabilidad, incluso si los pasos de inferencia conducen a respuestas de menor probabilidad. Por ejemplo, si el paso de inferencia apunta a STAZ, pero STAY es una palabra más común, LLM puede "autocorregirse" y generar STAY.

Memoria: LLM recuerda una gran cantidad de datos de texto durante el entrenamiento previo, lo que afecta la precisión de su inferencia CoT. Por ejemplo, rot-13 es el cifrado por desplazamiento más común y la precisión de LLM en rot-13 es significativamente mayor que la de otros tipos de cifrado por desplazamiento.

Inferencia de ruido: el proceso de inferencia de LLM no es del todo exacto, pero existe un cierto grado de ruido. A medida que aumenta la cantidad de desplazamiento del cifrado de desplazamiento, los pasos intermedios necesarios para la decodificación también aumentan y el impacto de la inferencia de ruido se vuelve más obvio, lo que hace que disminuya la precisión de LLM.

Los investigadores también descubrieron que el razonamiento CoT de LLM se basa en el autocondicionamiento, es decir, LLM necesita generar texto explícitamente como contexto para los pasos de razonamiento posteriores. Si se le indica al LLM que "piense en silencio" sin generar ningún texto, su capacidad de razonamiento se reduce significativamente. Además, la eficacia de los pasos de demostración tiene poco impacto en el razonamiento de CoT. Incluso si hay errores en los pasos de demostración, el efecto de razonamiento de CoT de LLM aún puede permanecer estable.

Este estudio muestra que el razonamiento CoT de LLM no es un razonamiento simbólico perfecto, sino que incorpora múltiples factores como la memoria, la probabilidad y el razonamiento de ruido. LLM muestra las características tanto de un maestro de memoria como de un maestro de probabilidad durante el proceso de razonamiento de CoT. Esta investigación nos ayuda a obtener una comprensión más profunda de las capacidades de razonamiento de LLM y proporciona información valiosa para desarrollar sistemas de inteligencia artificial más potentes en el futuro.

Dirección del artículo: https://arxiv.org/pdf/2407.01687

Este informe de investigación proporciona una referencia valiosa para que comprendamos el mecanismo de razonamiento de la "cadena de pensamiento" de los modelos de lenguaje grandes y también proporciona una nueva dirección para el diseño y la optimización de futuros sistemas de IA. ¡El editor de Downcodes continuará prestando atención a los desarrollos de vanguardia en el campo de la inteligencia artificial y brindándole contenido más interesante!