El editor de Downcodes se enteró de que el equipo de Tongyi Qianwen recientemente abrió su última serie completa de modelos Qwen2.5-Coder, lo que marca otro hito en el campo de los modelos grandes de código abierto. Los modelos de la serie Qwen2.5-Coder han atraído mucha atención debido a sus poderosas capacidades de codificación, diversas funciones y practicidad conveniente. Han demostrado un excelente rendimiento en la generación, reparación y razonamiento de código, proporcionando a los desarrolladores herramientas poderosas que promueven el desarrollo posterior del código abierto. LLM. El código abierto de esta serie de modelos promoverá en gran medida la aplicación e innovación de la tecnología de inteligencia artificial en el campo de la programación.

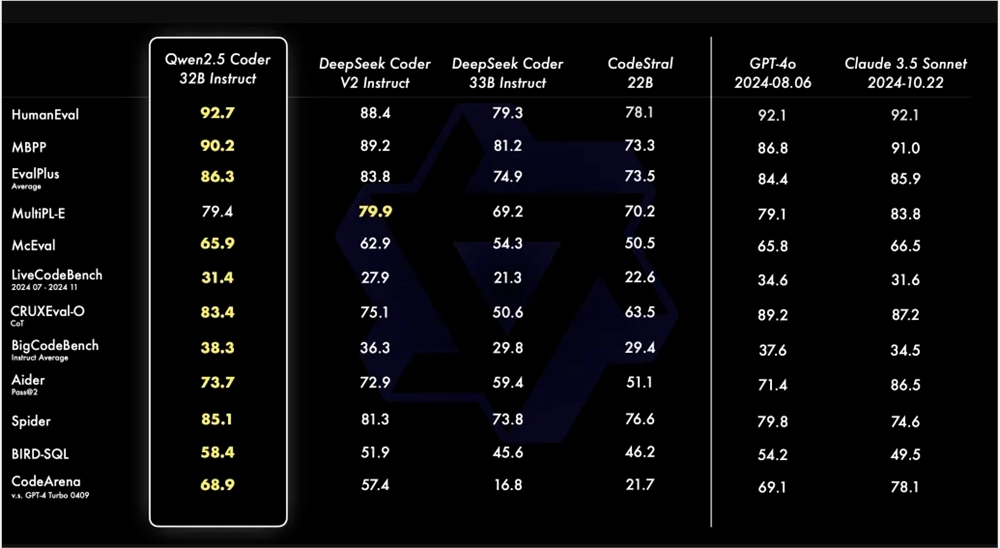

El equipo de Tongyi Qianwen anunció recientemente que abrirá el código fuente de su última serie Qwen2.5-Coder. Este movimiento tiene como objetivo promover el desarrollo de LLM de código abierto. Qwen2.5-Coder ha llamado la atención por su potencia, diversidad y practicidad. El modelo Qwen2.5-Coder-32B-Instruct ha alcanzado el nivel SOTA en términos de capacidades de código, que es equivalente a GPT-4o, y muestra capacidades integrales, que incluyen generación de código, reparación de código y razonamiento de código. Alcanza el máximo rendimiento en múltiples pruebas de generación de código y logra una puntuación de 73,7 en la prueba de Aider, que es comparable a GPT-4o.

Qwen2.5-Coder admite más de 40 lenguajes de programación y obtuvo 65,9 puntos en McEval, con lenguajes como Haskell y Racket funcionando particularmente bien. Esto se debe a su limpieza y comparación de datos únicas en la etapa previa al entrenamiento. Además, Qwen2.5-Coder-32B-Instruct también funciona bien en capacidades de reparación de código en múltiples lenguajes de programación, con una puntuación de 75,2 en el punto de referencia MdEval, ocupando el primer lugar.

Para probar el rendimiento de alineación de Qwen2.5-Coder-32B-Instruct en las preferencias humanas, se construyó un punto de referencia de evaluación de preferencias de código anotado internamente, Code Arena. Los resultados muestran que Qwen2.5-Coder-32B-Instruct tiene ventajas en la alineación preferida.

Esta vez, la serie Qwen2.5-Coder tiene modelos de código abierto en cuatro tamaños, incluidos 0.5B/3B/14B/32B, que cubren los seis tamaños de modelos principales para satisfacer las necesidades de diferentes desarrolladores. El funcionario proporciona dos modelos: Base e Instruct. El primero sirve como base para que los desarrolladores ajusten el modelo y el segundo sirve como modelo de chat alineado oficialmente. Existe una correlación positiva entre el tamaño del modelo y el rendimiento, y Qwen2.5-Coder logra el rendimiento SOTA en todos los tamaños.

El modelo 0.5B/1.5B/7B/14B/32B de Qwen2.5-Coder adopta la licencia Apache2.0, mientras que el modelo 3B tiene licencia solo para investigación. El equipo verificó la eficacia de los LLM de Scaling on Code evaluando el rendimiento de Qwen2.5-Coder de diferentes tamaños en todos los conjuntos de datos.

El código abierto de Qwen2.5-Coder proporciona a los desarrolladores una opción de modelo de programación potente, diversa y práctica, lo que ayuda a promover el desarrollo y la aplicación de modelos de lenguajes de programación.

Enlace del modelo Qwen2.5-Coder:

https://modelscope.cn/collections/Qwen25-Coder-9d375446e8f5814a

En resumen, el código abierto de Qwen2.5-Coder brinda una poderosa herramienta a los desarrolladores, y su excelente rendimiento y amplia aplicabilidad promoverán en gran medida el desarrollo del campo de la generación y programación de código. Esperamos que Qwen2.5-Coder pueda desempeñar un papel en más escenarios de aplicaciones en el futuro.