Un nuevo estudio del MIT ha revelado sorprendentes similitudes entre la estructura interna de los grandes modelos de lenguaje (LLM) y el cerebro humano, lo que ha provocado un acalorado debate en el campo de la inteligencia artificial. El editor de Downcodes explicará en detalle los importantes hallazgos de esta investigación y su importancia para el desarrollo futuro de la IA. A través de un análisis en profundidad del espacio de activación de LLM, los investigadores descubrieron características estructurales de tres niveles. El descubrimiento de estas características nos ayudará a comprender mejor el mecanismo de funcionamiento de LLM y proporcionará nuevas direcciones para el desarrollo de la futura tecnología de IA.

¿La IA realmente ha comenzado a "hacer crecer un cerebro"? ¡Las últimas investigaciones del MIT muestran que la estructura interna de un modelo de lenguaje grande (LLM) es sorprendentemente similar al cerebro humano!

Este estudio utilizó tecnología dispersa de codificador automático para realizar un análisis en profundidad del espacio de activación de LLM y descubrió tres niveles de características estructurales, que son sorprendentes:

En primer lugar, a nivel microscópico, los investigadores descubrieron la existencia de estructuras similares a "cristalinas". Las caras de estos "cristales" están formadas por paralelogramos o trapecios, similares a analogías de palabras familiares, como "hombre:mujer::rey:reina".

Lo que es aún más sorprendente es que estas estructuras "cristalinas" se vuelven más claras después de eliminar algunos factores de interferencia irrelevantes (como la longitud de las palabras) mediante técnicas de análisis discriminante lineal.

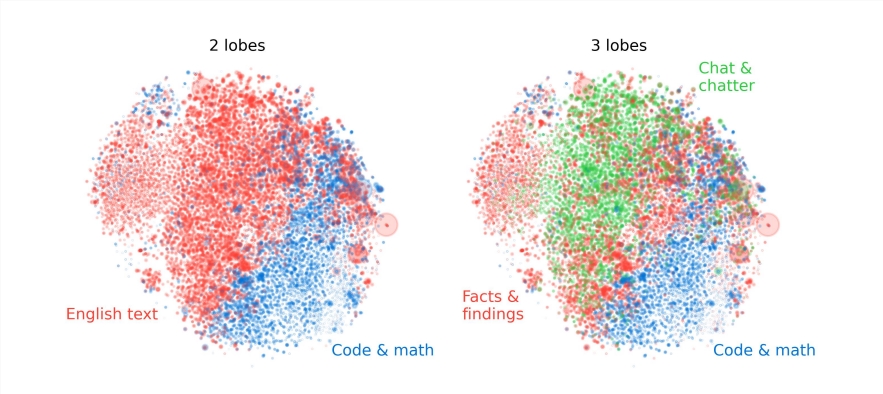

En segundo lugar, a nivel meso, los investigadores descubrieron que el espacio de activación de LLM tiene una estructura modular similar a las divisiones funcionales del cerebro humano.

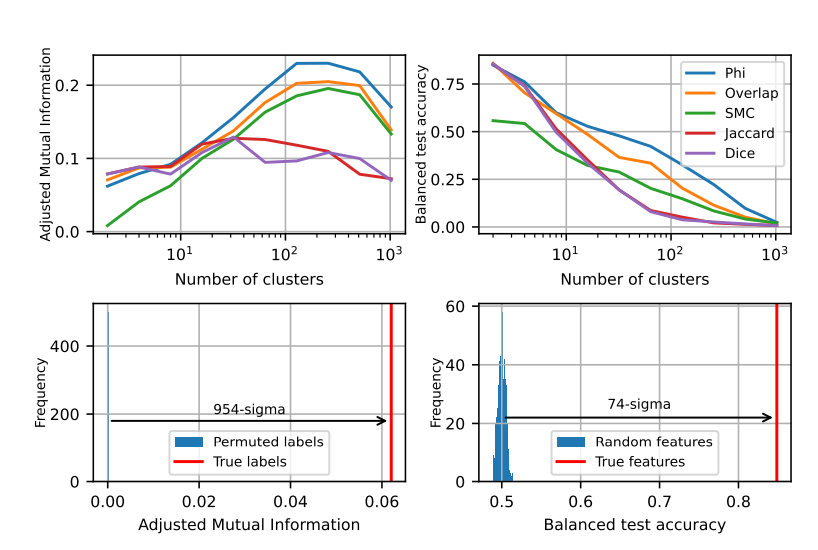

Por ejemplo, las características relacionadas con las matemáticas y la codificación se agrupan para formar un "lóbulo" similar a los lóbulos funcionales del cerebro humano. A través del análisis cuantitativo de múltiples indicadores, los investigadores confirmaron la localidad espacial de estos "lóbulos", mostrando que las características concurrentes también están más agrupadas espacialmente, mucho más allá de lo que se esperaría de una distribución aleatoria.

A nivel macro, los investigadores encontraron que la estructura general de la nube de puntos de características LLM no es isotrópica, sino que presenta una distribución de valores propios de ley potencial, y esta distribución es más obvia en la capa intermedia.

Los investigadores también analizaron cuantitativamente la entropía de agrupamiento de diferentes niveles y encontraron que la entropía de agrupamiento de la capa intermedia era menor, lo que indica que la representación de características estaba más concentrada, mientras que la entropía de agrupamiento de las capas temprana y tardía era mayor, lo que indica que la característica La representación estaba más dispersa.

Esta investigación nos proporciona una nueva perspectiva sobre la comprensión de los mecanismos internos de grandes modelos lingüísticos y también sienta las bases para el desarrollo de sistemas de IA más potentes e inteligentes en el futuro.

El resultado de esta investigación es apasionante, no sólo profundiza nuestra comprensión de los modelos lingüísticos a gran escala, sino que también señala una nueva dirección para el desarrollo futuro de la inteligencia artificial. El editor de Downcodes cree que con el avance continuo de la tecnología, la inteligencia artificial mostrará su gran potencial en más campos y traerá un futuro mejor a la sociedad humana.