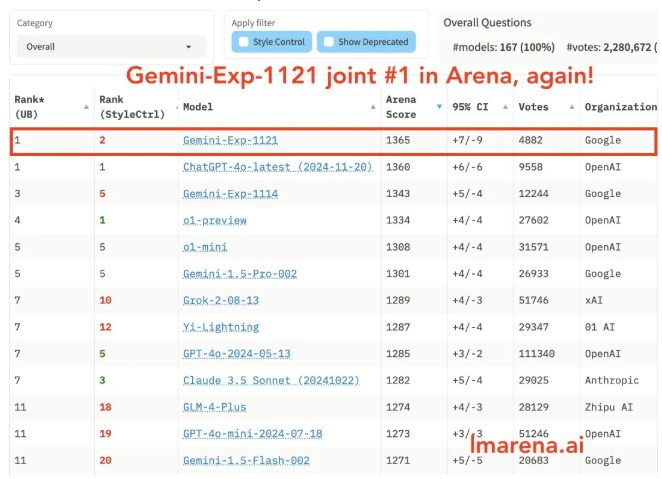

Recientemente, la competencia entre los gigantes de la inteligencia artificial, Google y OpenAI, se ha intensificado. Las dos partes compiten ferozmente en el desarrollo y la velocidad de iteración de modelos de lenguaje a gran escala. El modelo Gemini-Exp-1121 recientemente lanzado por Google ha superado al GPT-4o de OpenAI en muchos indicadores clave, ocupando una vez más el primer puesto en la competencia de IA. El editor de Downcodes le brindará un conocimiento profundo de este "blitz" en el campo de la IA, así como de los últimos avances en tecnología y funcionalidad entre ambas partes.

Recientemente, la competencia entre Google y OpenAI se ha vuelto a calentar. Apenas un día después de que la nueva versión de GPT-4o encabezara la lista de competencia de IA, Google lanzó el último modelo experimental Gemini-Exp-1121, recuperando rápidamente el campeonato. Hace apenas una semana, Google lanzó Gemini-Exp-1114, lo que parece indicar que Google respondió muy rápidamente a la dinámica de OpenAI.

Jack Rae, científico jefe de Google DeepMind, dijo que se trataba de un "bombardeo", lo que implica que la velocidad de iteración del post-entrenamiento es más rápida que la del pre-entrenamiento.

Según información oficial, Gemini-Exp-1121 se ha mejorado significativamente en muchos aspectos, lo que se refleja principalmente en la mejora de las capacidades de codificación, razonamiento y comprensión visual. Además, este modelo ha alcanzado un nivel comparable al actual top o1-preview y New Sonnet3.5 en el control de estilo de palabras complejas.

En pruebas reales, Gemini-Exp-1121 también obtuvo mejores resultados que la nueva versión de GPT-4o en el manejo de la comprensión de los cómics. Sus respuestas fueron más completas y podía utilizar claramente subtítulos y énfasis en negrita para presentar la información. En la clásica pregunta de razonamiento lógico de Animal Crossing River, la respuesta de Gemini-Exp-1121 fue completamente correcta, mostrando una mayor capacidad de razonamiento lógico. Por otro lado, la nueva versión de GPT-4o cometió algunos errores.

Al mismo tiempo, OpenAI también está desarrollando activamente nuevas funciones. Recientemente, se descubrió el código para la función de video "Live Camera" en la última versión de ChatGPT, lo que marca su progreso en el reconocimiento visual y de voz. Los usuarios de OpenAI también experimentarán esta capacidad por primera vez cuando utilicen el modo de voz avanzado, lo que muestra su intención de ampliar el uso de esta función en el futuro.

Es previsible que el próximo año el principal método de comunicación con Chatbot pase gradualmente del tradicional diálogo de texto a voz y servicios de agentes más inteligentes. Este cambio puede estar liderado por el lanzamiento de la función "cámara en vivo".

Esta competencia de IA aún continúa, con Google y OpenAI persiguiéndose, lo que indica que la tecnología de IA continuará logrando avances e innovaciones en el futuro, brindando servicios más convenientes e inteligentes a los usuarios. ¡Esperemos y veamos quién ganará al final!