El rápido desarrollo de la IA generativa ha aportado comodidad, pero también ha provocado el problema de la proliferación de información falsa. Para abordar este problema, Microsoft ha lanzado una nueva herramienta llamada Corrección, que está diseñada para corregir la información errónea en el contenido generado por IA. El editor de Downcodes te llevará a comprender en profundidad los principios, aplicaciones y desafíos de esta herramienta.

Hoy en día, con el rápido desarrollo de la inteligencia artificial, aunque la IA generativa ha aportado muchas ventajas, la información falsa que genera también se ha convertido en un problema que no se puede ignorar. En respuesta a este desafío, el gigante tecnológico Microsoft lanzó recientemente una nueva herramienta llamada Corrección, que está diseñada para corregir información falsa en contenido generado por IA.

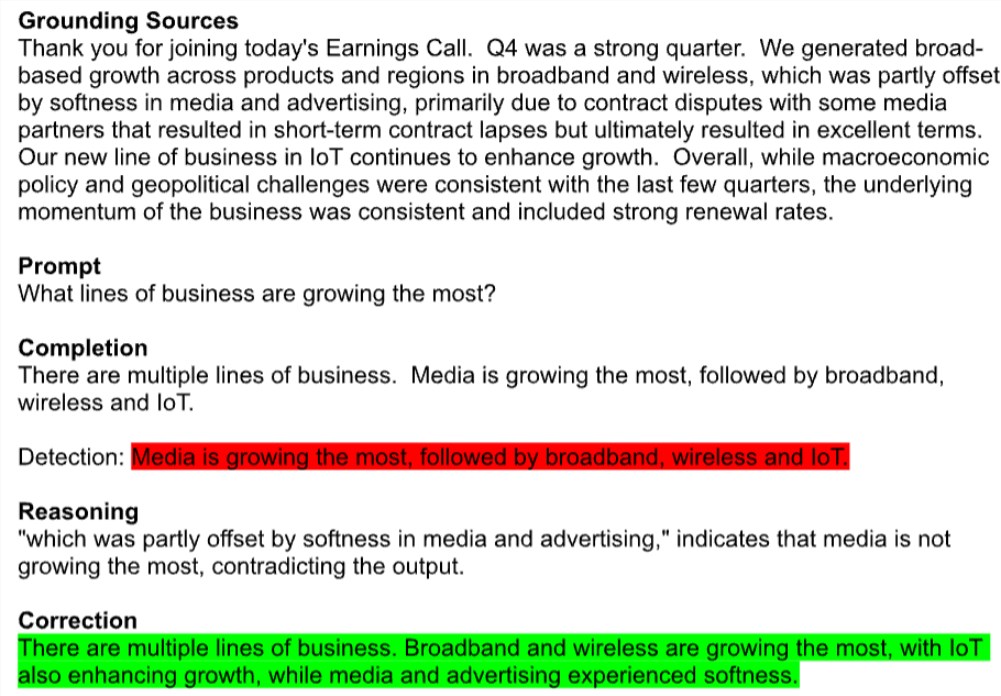

La corrección se encuentra actualmente en versión preliminar como parte de la API Azure AI Content Security de Microsoft. La herramienta detecta automáticamente textos potencialmente erróneos, como resúmenes de ganancias trimestrales de empresas mal citados, y los compara con fuentes creíbles para corregir esos errores. En particular, esta tecnología funciona en todos los modelos de IA de generación de texto, incluidos Meta's Llama y OpenAI's GPT-4.

Un portavoz de Microsoft dijo que la corrección garantiza que el contenido generado sea consistente con documentos reales al combinar modelos de lenguaje pequeños con modelos de lenguaje grandes. Esperan que esta nueva característica ayude a los desarrolladores en campos como el médico a mejorar la precisión de la respuesta.

Sin embargo, los expertos se muestran cautelosos. Os Keyes, estudiante de doctorado de la Universidad de Washington, cree que intentar eliminar la ilusión de la IA generada es como intentar eliminar el hidrógeno del agua, que es una parte fundamental del funcionamiento de la tecnología. De hecho, los modelos de generación de texto producen información falsa porque en realidad no saben nada y simplemente hacen conjeturas basadas en el conjunto de entrenamiento. Un estudio encontró que ChatGPT de OpenAI tenía una tasa de error de hasta el 50% al responder preguntas médicas.

La solución de Microsoft es identificar y corregir esta información falsa a través de un par de metamodelos de edición con referencias cruzadas. Un modelo de clasificación busca posibles errores, fragmentos de texto ficticios o irrelevantes, y si se detectan, se introduce un modelo de segundo lenguaje para intentar corregirlo en función del documento subyacente específico.

Aunque Microsoft afirma que la corrección puede mejorar significativamente la confiabilidad y la confiabilidad del contenido generado por IA, los expertos todavía tienen dudas. Mike Cook, investigador de la Universidad Queen Mary, señaló que incluso si Correction funciona como se anuncia, puede exacerbar los problemas de confianza y explicabilidad en la IA. El servicio puede adormecer a los usuarios con una falsa sensación de seguridad, haciéndoles creer que el modelo es más preciso de lo que realmente es.

Cabe mencionar que Microsoft también tenía cálculos comerciales ocultos al lanzar Corrección. Si bien la función en sí es gratuita, existe un límite de uso mensual para las capacidades básicas de detección de documentos necesarias para detectar información errónea, y cualquier uso adicional se cobrará.

Microsoft está claramente bajo presión para demostrar el valor de sus inversiones en IA. La compañía gastó casi 19 mil millones de dólares en gastos de capital y equipos relacionados con la IA en el segundo trimestre de este año, pero hasta ahora ha generado ingresos modestos gracias a la IA. Recientemente, algunos analistas de Wall Street bajaron la calificación de las acciones de Microsoft, cuestionando la viabilidad de su estrategia de IA a largo plazo.

El riesgo potencial de precisión y desinformación se ha convertido en una de las mayores preocupaciones de las empresas a la hora de poner a prueba herramientas de IA. Cook concluyó que si este fuera el ciclo de vida normal de un producto, la IA generativa aún debería estar en la fase de investigación y desarrollo académico para continuar mejorando y comprendiendo sus fortalezas y debilidades. Sin embargo, lo hemos puesto en uso en múltiples industrias.

La herramienta de corrección de Microsoft es sin duda un intento de resolver el problema de la desinformación de la IA, pero aún está por verse si realmente puede romper la crisis de confianza en la IA generativa. Si bien la tecnología de IA se está desarrollando rápidamente, cómo equilibrar la innovación y el riesgo se convertirá en un tema importante que enfrentará toda la industria.

Con todo, la aparición de la herramienta de corrección de Microsoft marca la creciente atención de la industria al problema de la información falsa de la IA, pero también desencadena una reflexión profunda sobre la credibilidad y el modelo de negocio de la IA. En el futuro, cómo utilizar mejor la tecnología de IA y al mismo tiempo controlar eficazmente sus riesgos será un gran desafío al que nos enfrentaremos todos.