El editor de Downcodes se enteró de que la última investigación de DeepMind utiliza el modelo Transformer de gran escala para lograr avances revolucionarios en el campo del ajedrez. Los investigadores construyeron un conjunto de datos de ChessBench que contenía decenas de millones de registros de juegos humanos y entrenaron un modelo Transformer con hasta 270 millones de parámetros, con el objetivo de explorar sus capacidades en problemas de planificación complejos. El resultado de esta investigación atrajo una amplia atención por parte de la comunidad de IA y proporcionó una nueva dirección y punto de referencia para la investigación sobre las capacidades de planificación de la IA.

Recientemente, un artículo de DeepMind sobre la aplicación de Transformer a gran escala en el campo del ajedrez ha provocado extensos debates en la comunidad de IA. Los investigadores utilizaron un nuevo conjunto de datos llamado ChessBench para entrenar un modelo Transformer con hasta 270 millones de parámetros para explorar sus capacidades en problemas de planificación complejos como el ajedrez.

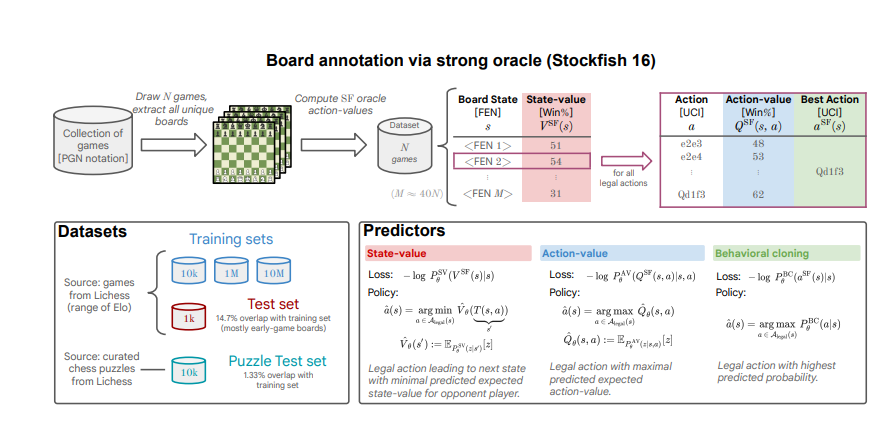

El conjunto de datos de ChessBench contiene 10 millones de registros de juegos humanos recopilados desde la plataforma Lichess, y los juegos de ajedrez se anotan utilizando el principal motor de ajedrez Stockfish16, lo que proporciona hasta 15 mil millones de puntos de datos, incluida la tasa de victorias y el mejor movimiento de cada estado del juego de ajedrez. y la valoración de todos los movimientos legales.

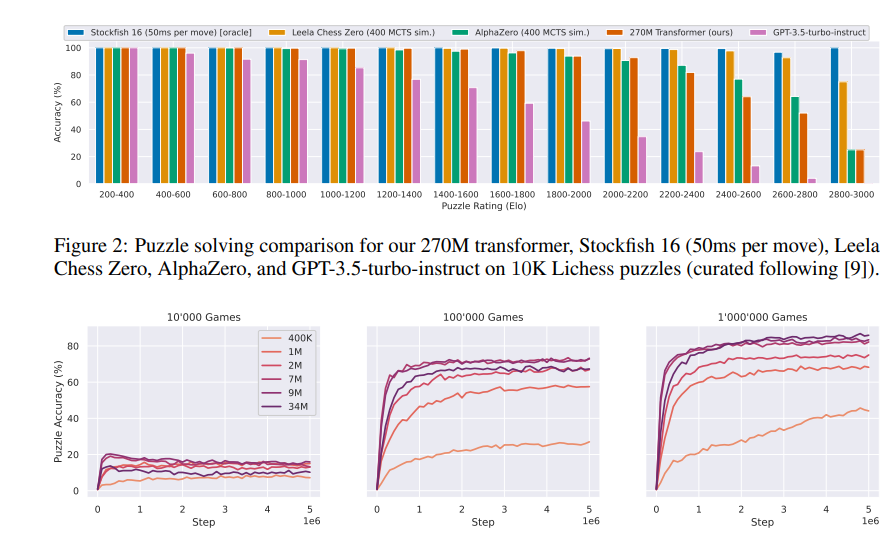

Los investigadores utilizaron métodos de aprendizaje supervisado para entrenar el modelo Transformer para predecir el valor de cada movimiento legal en un estado de juego determinado. Los resultados experimentales muestran que incluso sin utilizar ningún algoritmo de búsqueda explícito, el modelo más grande puede hacer predicciones bastante precisas en nuevos estados del juego de ajedrez, lo que demuestra una fuerte capacidad de generalización.

Sorprendentemente, cuando el modelo jugó ajedrez rápido contra jugadores humanos en la plataforma Lichess, alcanzó una calificación Elo de 2895, alcanzando el nivel de maestro de ajedrez.

Los investigadores también compararon el modelo con motores de ajedrez entrenados en aprendizaje por refuerzo y juego autónomo, como Leela Chess Zero y AlphaZero. Los resultados muestran que, aunque se puede refinar una versión aproximada del algoritmo de búsqueda de Stockfish en el modelo Transformer mediante aprendizaje supervisado, todavía existen desafíos para lograr un refinamiento perfecto.

Esta investigación muestra que el modelo Transformer a escala ultragrande tiene un gran potencial para resolver problemas de planificación complejos y también proporciona nuevas ideas para el desarrollo de futuros algoritmos de IA. El lanzamiento del conjunto de datos de ChessBench también proporcionará una nueva plataforma de referencia para que los investigadores exploren las capacidades de planificación de la IA.

Los resultados de la investigación de DeepMind no solo demuestran el poder del modelo Transformer en el campo del ajedrez, sino que también proporcionan un importante valor de referencia para futuras aplicaciones de IA en campos más complejos. Esto marca otro gran paso adelante para la IA en el campo de los juegos de estrategia complejos y merece una atención continua.